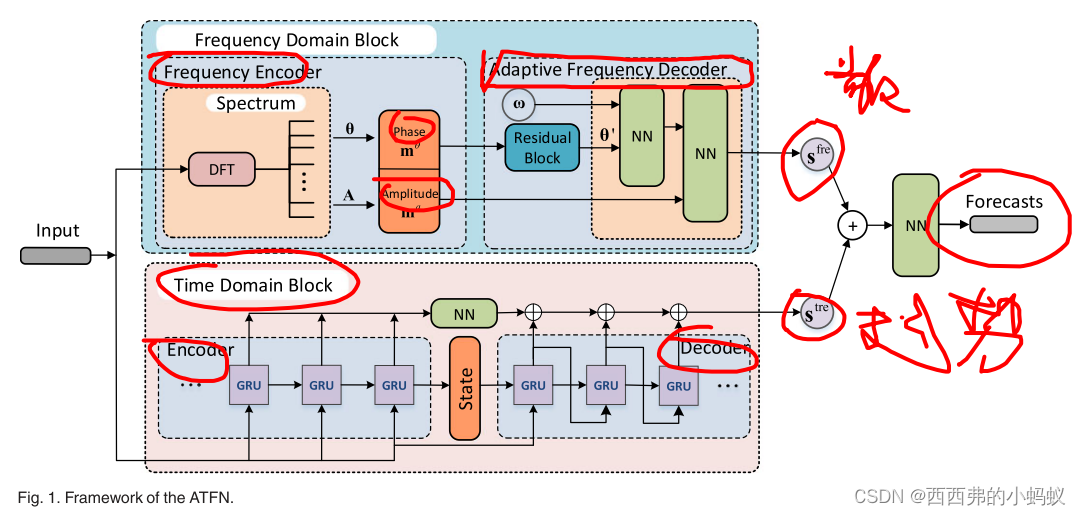

Adaptive Temporal-Frequency Network for Time-Series Forecasting

提出了一种新的自适应时频网络(ATFN),它是一种结合深度学习网络和频率模式的端到端混合模型,用于中长期时间序列预测。在ATFN框架内,利用增广序列到序列模型学习复杂非平稳时间序列的趋势特征,利用频域块捕获时间序列数据的动态和复杂周期模式,并利用全连接神经网络将趋势和周期特征结合起来进行最终预测。设计了相位自适应、频率自适应、幅度自适应的自适应频率机制,将当前滑动窗口的频谱映射到预测区间的频谱。多层神经网络进行类似于离散傅里叶反变换的变换来生成周期特征预测。利用合成数据和具有不同周期特征的实际数据来评估所提出模型的有效性。实验结果表明,该方法对长时间序列预测具有良好的性能和较强的适应性。

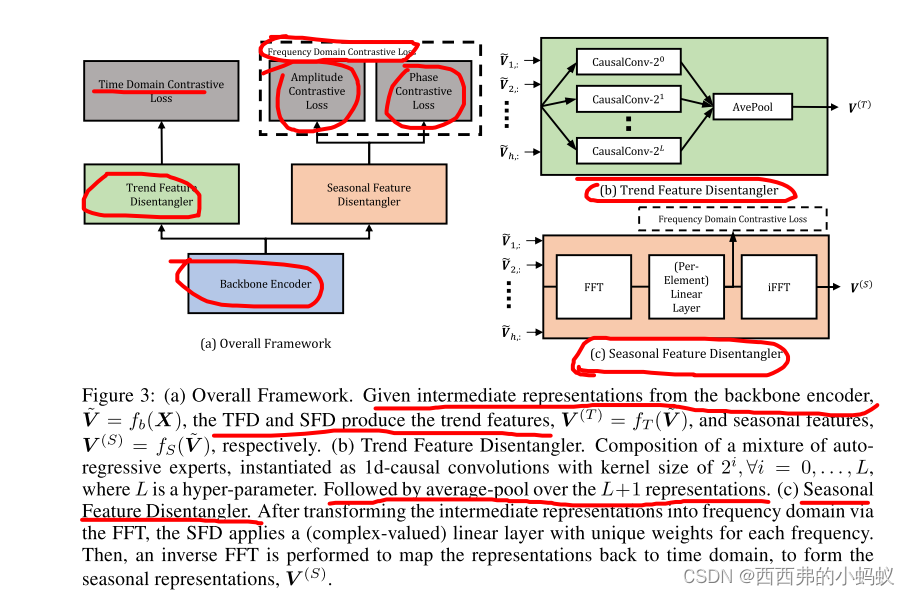

Cost: Contrastive learning of disentangled seasonal-trend representations for time series forecasting

深度学习已经被积极研究用于时间序列预测,主流范式是基于神经网络架构的端到端训练,范围从经典的LSTM/ rnn到最近的tcn和transformer。由于最近在计算机视觉和自然语言处理中表示学习的成功,我们认为时间序列预测更有前途的范式是首先学习解纠缠的特征表示,然后是简单的回归微调步骤-我们从因果角度证明了这种范式。根据这一原则,我们提出了一种新的时间序列表示学习框架CoST,该框架采用对比学习方法来学习解纠缠的季节趋势表示。包括时域和频域对比损失,分别用于学习判别趋势和季节表征。在真实数据集上进行的大量实验表明,成本方法的性能始终优于最先进的方法,在多变量基准测试中,其MSE提高了21.3%。它对各种骨干编码器的选择以及下游回归器也具有鲁棒性。

注意:这里也使用了解耦表征的思想

注意:这里也使用了解耦表征的思想

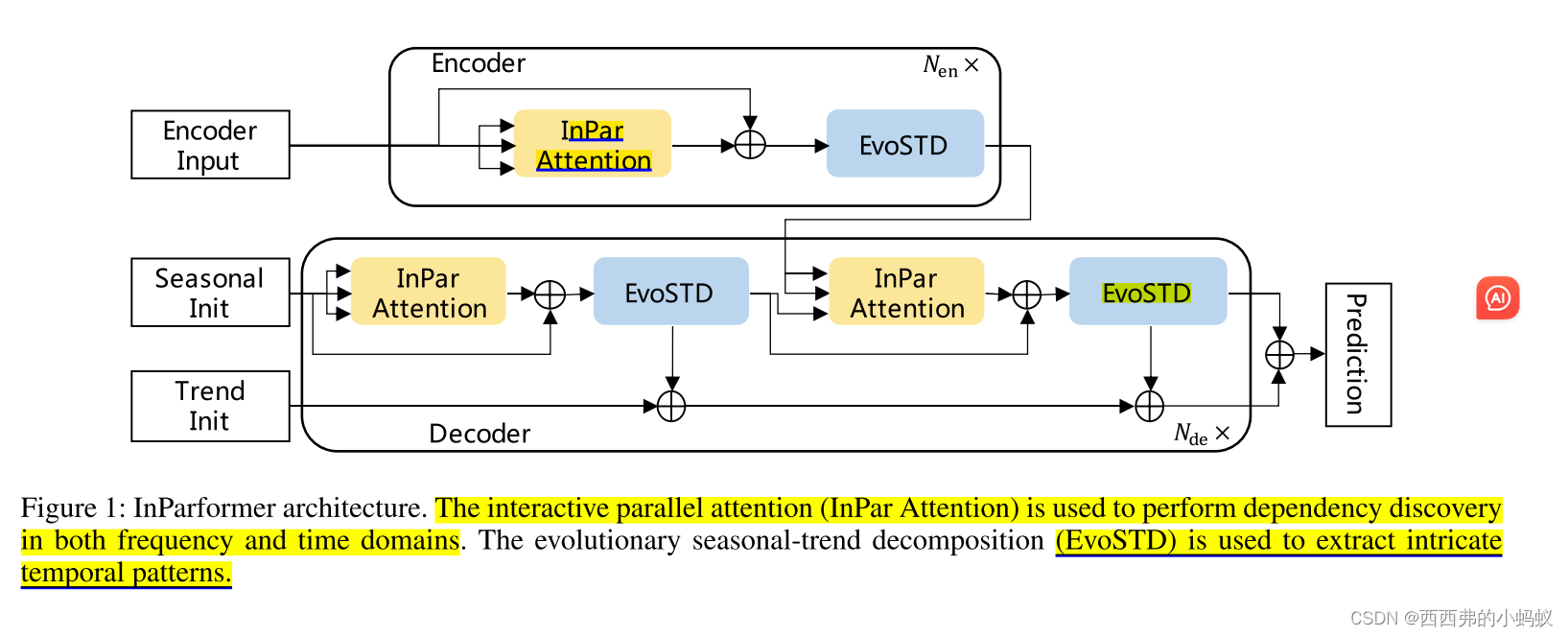

InParformer: Evolutionary Decomposition Transformers with Interactive Parallel Attention for Long-Term Time Series Forecasting

长期时间序列预测(LTSF)为许多实际应用程序提供了实质性的好处,同时对模型捕获长期依赖关系的能力提出了基本要求。最近基于transformer的模型显著提高了LTSF的性能。值得注意的是,具有自关注机制的Transformer最初被提出用于对语言序列建模,这些语言序列的标记(例如,单词)是离散的且高度语义化的。然而,与语言序列不同,大多数时间序列是连续的和连续的数字点。具有时间冗余的时间步是弱语义的,仅利用时域标记很难描述时间序列的整体属性(例如,总体趋势和周期变化)。为了解决这些问题,我们提出了一种新的基于transformer的预测模型InParformer,该模型具有交互式并行注意(InPar Attention)机制。提出了InPar注意力,在频域和时域上全面学习远程依赖关系。为了提高其学习能力和效率,我们进一步设计了几种机制,包括查询选择、键值对压缩和重组。此外,InParformer构建了季节趋势演化分解模块,增强了复杂时间模式的提取能力。在六个现实世界基准上的广泛实验表明,InParformer优于最先进的预测变压器。

Multilevel Wavelet Decomposition Network for Interpretable Time Series Analysis

Multilevel Wavelet Decomposition Network for Interpretable Time Series Analysis

近年来,时间序列在几乎所有学术

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

876

876

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?