1. 文章信息

文章题为《Learning Multiple Tasks with Multilinear Relationship Networks》,该文章于2017年发表至Advances in neural information processing systems期刊,是一篇关于多任务学习的文章。

2. 摘要

在大规模数据上训练的深层网络能够学习可转移的特征,以促进学习多个任务。由于深层特征最终会沿着深层网络从一般特征过渡到特定特征,因此,多任务学习的一个基本问题是如何利用参数张量下的任务相关性,提高特征在多个任务特定层中的可转移性。文章提出了一种基于深度卷积网络中多任务特定层参数张量上新的张量正规先验的多线性关系网络(MRN),用于发现任务关系。通过联合学习可转移特征和任务与特征的多线性关系,MRN能够缓解特征层负迁移和分类器层欠迁移的困境。实验表明,MRN在三个多任务学习数据集上都能得到最新的结果。

3. 模型细节

张量正态分布:

1.概率密度函数:

张量正态分布是多元正态分布和矩阵变量正态分布到张量变量分布的自然延伸。多元正态分布为一阶张量正态分布,矩阵变量正态分布为二阶张量正态分布。在定义张量正态分布之前,首先介绍K阶张量的符号和运算。K阶张量是K向量空间张量积的一个元素,每个向量空间都有自己的坐标系。向量 是一阶张量其维度为d1,矩阵

是一阶张量其维度为d1,矩阵 是二阶张量。K阶张量

是二阶张量。K阶张量 ,维度为(d1,…,dk),组成元素为

,维度为(d1,…,dk),组成元素为 。X的矢量化是将张量展开为向量,用vec(X)表示。X的矩阵化是矢量化的推广,将X的元素重新排序为矩阵。本中为简化符号和描述张量关系,使用mode-k矩阵化,并用

。X的矢量化是将张量展开为向量,用vec(X)表示。X的矩阵化是矢量化的推广,将X的元素重新排序为矩阵。本中为简化符号和描述张量关系,使用mode-k矩阵化,并用 表示张量X的mode-k矩阵化,其中

表示张量X的mode-k矩阵化,其中 的第i行包含X中第k个维度上的索引等于i的所有元素。

的第i行包含X中第k个维度上的索引等于i的所有元素。

考虑一个K阶张量 ,由于可以将该张量进行向量化,即展平为一维张量,因此,该张量上的正态分布可以视为是向量vec(X)上的多元正态分布。然而,这种普通的多元正态分布忽略了X作为K阶张量的特殊结构。为了利用X的结构,张量正态分布假设

,由于可以将该张量进行向量化,即展平为一维张量,因此,该张量上的正态分布可以视为是向量vec(X)上的多元正态分布。然而,这种普通的多元正态分布忽略了X作为K阶张量的特殊结构。为了利用X的结构,张量正态分布假设 的协方差矩阵能够可分解为Kronecker乘积

的协方差矩阵能够可分解为Kronecker乘积 。因此vec(x)服从如下正态分布:

。因此vec(x)服从如下正态分布:

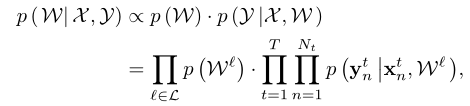

其中,vec(M)表示期望向量,由于协方差分解为Kronecker积,K阶张量X的张量正态分布由平均张量M和协方差矩阵参数化,因此可将概率密度函数定义为:

张量正态分布对应于具有Kronecker可分解协方差结构的多元正态分布。X遵循张量正态分布,即vec(X)遵循Kronecker可分解协方差的正态分布,表示为:

最大似然估计:

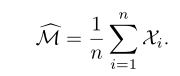

考虑一组具有n个样本的数据 ,其中Xi是一个三阶张量由上述中的张量正态分布生成。其对于均值张量的最大似然估计如下:

,其中Xi是一个三阶张量由上述中的张量正态分布生成。其对于均值张量的最大似然估计如下:

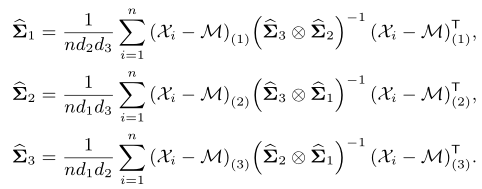

其协方差矩阵通过迭代更新这些方程来计算:

多元线性关系网络(Multilinear relationship networks,MRN):

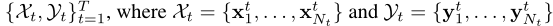

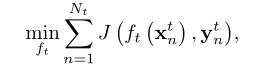

该网络通过联合学习可转移特征和任务关系从而构建多任务学习。给定T个任务 ,Nt表示对应任务的样本总数。目标是构建一个多任务学习的深度网络,该网络学习可转移的特征和自适应任务关系,以有效且稳健地连接不同的任务。

,Nt表示对应任务的样本总数。目标是构建一个多任务学习的深度网络,该网络学习可转移的特征和自适应任务关系,以有效且稳健地连接不同的任务。

1. 模型:

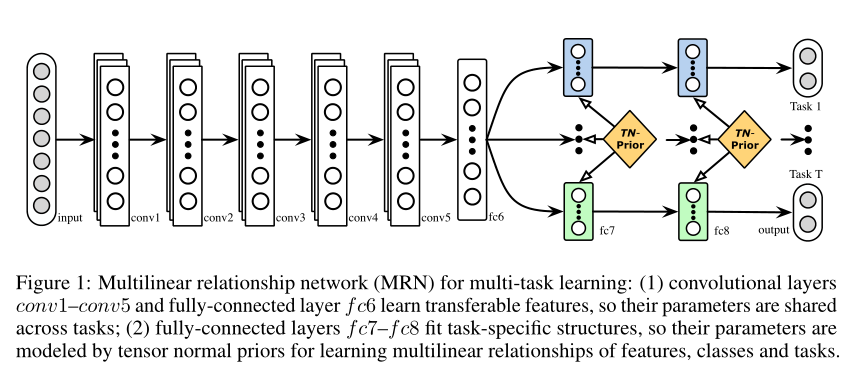

文章以卷积神经网络(CNN)和全连接神经层为基础,构建了MRN模型,如下图所示。

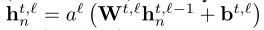

其中,对第t项任务而言,第l层全连接层的输入输出为: 。令

。令 表示第t项任务的CNN分类器,CNN的经验误差为:

表示第t项任务的CNN分类器,CNN的经验误差为:

其中,J是交叉熵损失函数, 是条件概率。

是条件概率。

依据现有的研究,文章指出,标准CNN中的深层特征最终必须沿着网络从一般过渡到特定,并且特征的可转移性随着任务差异的增加而降低,使得更高层的全连接层中的特征在不同任务之间不安全地转移。换言之,全连接层根据其原始任务进行定制,而目标任务的性能降低,可能会恶化基于深度神经网络的多任务学习。大多数以往的方法通常假设,鉴于深度网络的特征层能够学习到的共享表示,多个任务可以很好地关联。然而,如果不同的任务在深层特征下没有很好的相关性,这种关联式脆弱的,因为高层的特征提取层不能有效地转移所学知识,此外任务可能不同。再者,现有的多任务学习方法都是针对二分类任务而设计的,由于深度网络主要采用多类softmax回归,因此这些方法不是很好的选择。探索多任务学习中多类分类的任务关系仍然是一个悬而未决的问题。

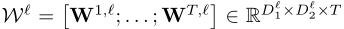

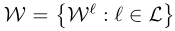

文章在贝叶斯框架下协同学习了多个特定任务层L的可转移特征和特征与任务的多线性关系。基于前面讨论的深度网络的可转移性,将特定任务层L设为fc7、fc8(如前文图所示)。为了获取所有T项任务的网络参数中的任务关系,文章构造第l层参数张量为 。令

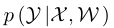

。令 表示所有特定任务层的参数张量的集合,给定训练集,网络参数的最大后验估计(MAP)如下:

表示所有特定任务层的参数张量的集合,给定训练集,网络参数的最大后验估计(MAP)如下:

其中,文章假设对于先验p (W),每一层的参数张量与其他层的参数张量无关。此外,文章假设当网络参数从先验采样时,所有任务都是独立的。这些独立假设使得最终的深度网络MAP估计很容易求解。此外,上式中最大似然估计部分 采用深层CNN建模,可以学习下层中的可转移特征从而进行多任务学习,同时,文章选择共享图中Conv1-fc6这些网络层中的参数,而对于特定任务层(fc6、fc7)不进行参数共享。

采用深层CNN建模,可以学习下层中的可转移特征从而进行多任务学习,同时,文章选择共享图中Conv1-fc6这些网络层中的参数,而对于特定任务层(fc6、fc7)不进行参数共享。

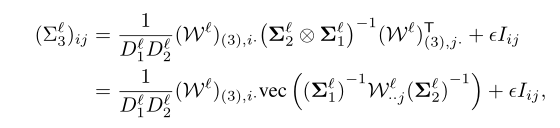

上式中的先验部分p (W)是实现多任务深度学习的关键,因为这一先验部分应该能够建模跨参数张量的多线性关系。文章首次用张量正态分布定义了第二层参数张量的先验值:

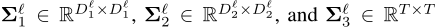

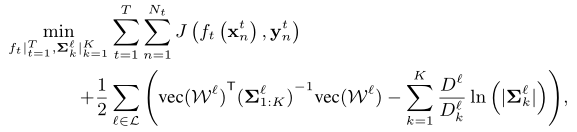

其中, 分别表示mode-1、mode-2和mode-3矩阵。具体而言,在张量正态先验中,行协方差矩阵刻画特征之间的关系,列协方差矩阵刻画了不同类之间的矩阵,mode-3刻画了l层网络参数中任务之间的关系。文章将CNN误差函数和张量正态先验集成到MAP估计中,取负对数,从而得到网络参数W的MAP估计,这是一个多线性关系网络(MRN)的正则化优化问题,形式化为:

分别表示mode-1、mode-2和mode-3矩阵。具体而言,在张量正态先验中,行协方差矩阵刻画特征之间的关系,列协方差矩阵刻画了不同类之间的矩阵,mode-3刻画了l层网络参数中任务之间的关系。文章将CNN误差函数和张量正态先验集成到MAP估计中,取负对数,从而得到网络参数W的MAP估计,这是一个多线性关系网络(MRN)的正则化优化问题,形式化为:

其中,K=3是参数张量W的模态数,对于卷积层而言K=4。

2. 算法:

由于上述问题是联合非凸的优化问题(jointly non-convex),文章对变量进行逐个更新,在更新一个变量时,其余变量保持不变。

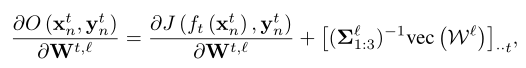

对于参数张量W,在训练CNN时,只需要目标函数的梯度,计算如下:

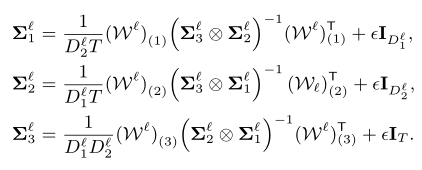

由于训练一个深度CNN网络需要大量的标签,文章对模型预先进行了一次训练,在每次训练中,更新W之后,可以更新协方差据矩阵,具体如下:

其中,最后一项为惩罚项,用于确保稳定性。

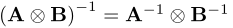

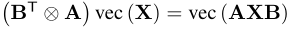

然而,由于Kronecker积的维数爆炸的问题,上述更新方程在计算上是不可行的,为此,文章使用Kronecker乘积规则: 和

和 。以mode-3对应的协方差矩阵为例。

。以mode-3对应的协方差矩阵为例。

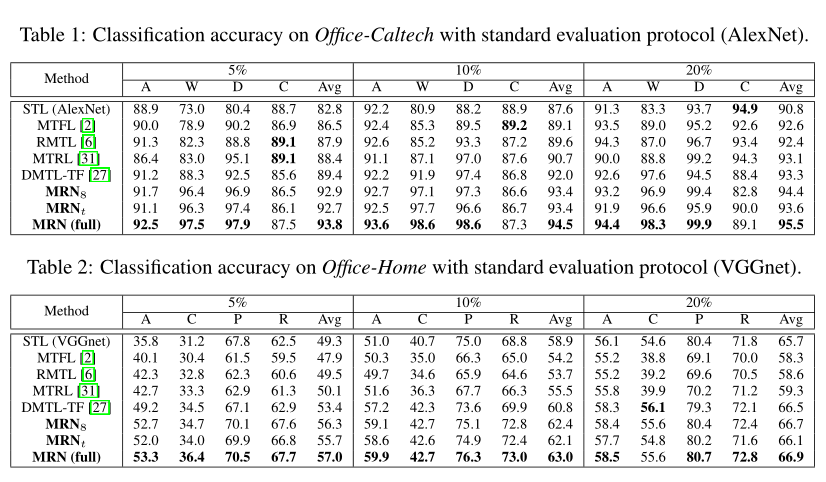

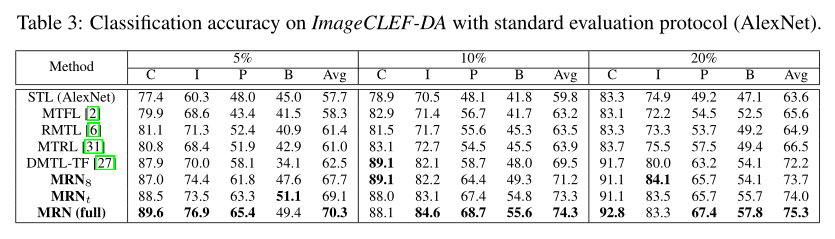

5. 实验

文章通过三组数据集(Office-Caltech、Office-Home、ImageCLEF-DA)进行实验,将MRN与最先进的多任务和深度学习方法(单任务学习(STL)、多任务特征学习(MTFL)、多任务关系学习(MTRL)、鲁棒多任务学习(RMTL)和带张量因子分解的深度多任务学习(DMTL-TF))进行比较,以验证学习可转移特征和多线性任务关系的有效性。实验结果如下:

6. 总结

文章提出了多线性关系网络(MRN),该网络将深度神经网络和张量法先验集成在所有任务特定层的网络参数上,通过任务、类和特征上的协方差结构来建模任务相关性,实现了相关任务之间的传递。设计了一种有效的学习算法来联合学习可转移特征和多线性关系。实验证明,在标准的数据集上,MRN可以产生更好的结果。

Attention

欢迎关注微信公众号《当交通遇上机器学习》!如果你和我一样是轨道交通、道路交通、城市规划相关领域的,也可以加微信:Dr_JinleiZhang,备注“进群”,加入交通大数据交流群!希望我们共同进步!

4036

4036

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?