3 损失函数和优化

最新推荐文章于 2024-07-22 20:08:30 发布

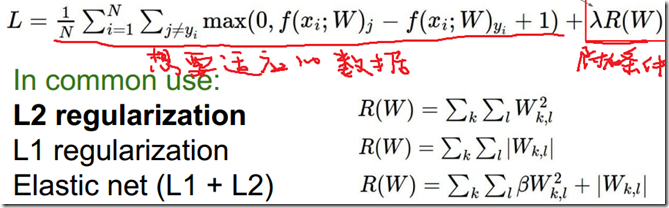

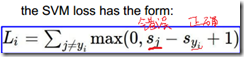

本文介绍了损失函数在评估分类器性能中的作用,通过实例展示了SVM损失函数的计算,并探讨了L1和L2正则化对权重的影响。同时,解释了为何使用梯度下降优化参数,以及mini batch梯度下降在减少计算量和提升效果上的优势。

本文介绍了损失函数在评估分类器性能中的作用,通过实例展示了SVM损失函数的计算,并探讨了L1和L2正则化对权重的影响。同时,解释了为何使用梯度下降优化参数,以及mini batch梯度下降在减少计算量和提升效果上的优势。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1755

1755

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?