统计文本建模的问题就是:追问这些观察到的语料库中的词序列是如何生成的。

1)LDA文本建模(1-2)里应该明白的结论

- beta分布是二项式分布的共轭先验概率分布:

- “对于非负实数

和

,我们有如下关系

- “对于非负实数

------------------(1)

其中

对应的是二项分布

的计数。针对于这种观测到的数据符合二项分布,参数的先验分布和后验分布都是Beta分布的情况,就是Beta-Binomial 共轭。”

- 狄利克雷分布(Dirichlet分布)是多项式分布的共轭先验概率分布:

- “ 把

从整数集合延拓到实数集合,从而得到更一般的表达式如下:

- “ 把

------------------(2)

针对于这种观测到的数据符合多项分布,参数的先验分布和后验分布都是Dirichlet 分布的情况,就是 Dirichlet-Multinomial 共轭。 ”

- 频率派和贝叶斯派思考问题的模式:

虽然是未知的,但最起码是确定的一个值。同时,样本X

是随机的,所以频率派重点研究样本空间,大部分的概率计算都是针对样本X 的分布;

虽然是未知的,但最起码是确定的一个值。同时,样本X

是随机的,所以频率派重点研究样本空间,大部分的概率计算都是针对样本X 的分布;贝叶斯派的观点则截然相反,他们认为待估计的参数

是随机变量,服从一定的分布,而样本X

是固定的,由于样本是固定的,所以他们重点研究的是参数

是随机变量,服从一定的分布,而样本X

是固定的,由于样本是固定的,所以他们重点研究的是参数 的分布。他们的思维模式是:先验分布

的分布。他们的思维模式是:先验分布 +

样本信息

+

样本信息

后验分布

后验分布 。上述思考模式意味着,新观察到的样本信息将修正人们以前对事物的认知。

。上述思考模式意味着,新观察到的样本信息将修正人们以前对事物的认知。

2)LDA模型的基础模型:Unigram model、mixture of unigrams model,以及跟LDA最为接近的pLSA模型

统计文本建模的问题就是:追问这些观察到的语料库中的词序列是如何生成的。

2.1)Unigram Model:

假设:

则:

形象的理解是:

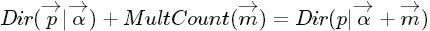

上图中的

- p是词服从的Multinomial分布的参数

- α是Dirichlet分布(即Multinomial分布的先验分布)的参数。

一般α由经验事先给定,p由观察到的文本中出现的词学习得到,表示文本中出现每个词的概率。

辛运的是,我们已知公式(2):

另外,公式(23)中的Delta表示:

2.2)Mixture of unigrams model

,再根据该主题生成文档,该文档中的所有词都来自一个主题。

,再根据该主题生成文档,该文档中的所有词都来自一个主题。 ,生成文档

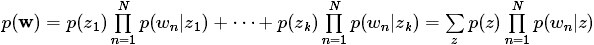

,生成文档 的概率为:

的概率为:

2.3)pLSA(Probabilistic Latent Semantic Analysis)模型

在上面的Mixture of unigrams model中,我们假定一篇文档只由一个主题生成,可实际中,一篇文章往往有多个主题,只是这多个主题各自在文档中出现的概率大小不一样。比如介绍一个国家的文档中,往往会分别从教育、经济、交通等多个主题进行介绍。那么在pLSA中,文档是怎样被生成的呢?

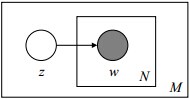

图形化表示为:

蛋疼:这边的p(z)是由上帝投骰子选择的,而Mixture of unigrams model中的p(z)居然没介绍是怎么来的。。。

3)LDA(Latent Dirichlet Allocation)模型

3.1)LDA简介

上面概率图可以分解为以下两个物理过程:

对于第一个物理过程:

对于第二个物理过程:

3.2)LDA参数估计

3.3)LDA模型的训练和推理

本文介绍了LDA文本建模的基础,包括Unigram Model、Mixture of unigrams model和重点讲解的pLSA模型。pLSA模型中,文档由多个主题生成,每个主题在文档中出现的概率不同。LDA模型进一步改进,通过Dirichlet分布处理主题的不确定性。

本文介绍了LDA文本建模的基础,包括Unigram Model、Mixture of unigrams model和重点讲解的pLSA模型。pLSA模型中,文档由多个主题生成,每个主题在文档中出现的概率不同。LDA模型进一步改进,通过Dirichlet分布处理主题的不确定性。

5158

5158

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?