一、实验介绍

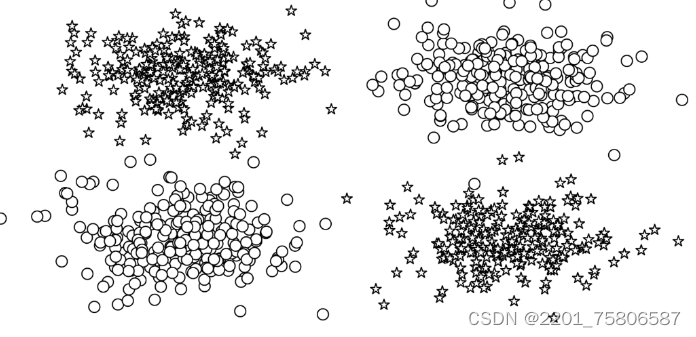

在实验中,我们通过分析感知器来引入神经网络的基本概念,感知器是已知最基础的神经网络形式。然而,感知器的一个历史性局限是它无法学习数据中某些至关重要的模式。例如,观察图中的数据点。这些数据点代表了异或(XOR)问题,在这种情况下,无法通过一条直线(即线性边界)来分隔不同的类别。在这种情境下,感知器无法完成任务。

为了克服感知器的这些限制,我们将探索传统上称为前馈网络的神经网络模型,以及两种前馈神经网络:多层感知器和卷积神经网络。多层感知器在结构上扩展了我们在实验3中研究的简单感知器,将多个感知器分组在一个单层,并将多个层叠加在一起。我们稍后将介绍多层感知器,并在“示例:带有多层感知器的姓氏分类”中展示它们在多层分类中的应用。

本实验研究的第二种前馈神经网络,卷积神经网络,在处理数字信号时深受窗口滤波器的启发。通过这种窗口特性,卷积神经网络能够在输入中学习局部化模式,这不仅使其成为计算机视觉的主轴,而且是检测单词和句子等序列数据中的子结构的理想候选。我们在“卷积神经网络”中概述了卷积神经网络,并在“示例:使用CNN对姓氏进行分类”中演示了它们的使用。

在这个实验中,多层感知器和卷积神经网络被归为一类,因为它们都属于前馈神经网络,这与递归神经网络(RNNs)不同,递归神经网络允许信息在前向传播过程中的循环反馈,使得每个时间点的计算都能够利用之前时间点的信息。

二、多层感知器(MLP)进行姓氏分类

多层感知器(MLP)由输入层、一个或多个隐藏层以及输出层组成。我们将使用MLP来对姓氏进行分类。

首先,我们需要导入必要的库:

from argparse import Namespace

from collections import Counter

import json

import os

import string

接下来,我们将加载和预处理姓氏数据集,以便将其输入到MLP模型中。

三、卷积神经网络(CNN)进行姓氏分类

除了MLP,我们还可以使用卷积神经网络(CNN)进行姓氏分类。CNN特别适合处理具有空间层次结构的数据,如图像和文本。

为了实现CNN,我们需要导入相关的库:

import torch

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

我们将使用CNN模型来提取姓氏数据中的特征,并对其进行分类。

四、数据预处理

在训练模型之前,我们需要对姓氏数据集进行预处理。我们将使用以下库来处理数据集:

import collections

import numpy as np

import pandas as pd

import re

数据预处理包括清除和标准化文本、分词、编码等步骤。我们将详细介绍每个步骤。

数据加载

首先,我们需要加载数据集。通常,数据集可能是一个CSV文件或JSON文件。我们可以使用pandas库来加载数据。

import pandas as pd

# 假设数据集是一个CSV文件

data = pd.read_csv('surnames.csv')

数据清洗

数据清洗包括去除无效或错误的样本、处理缺失值等。例如,我们可以去除含有空值的行或对缺失值进行填充。

# 去除含有空值的行

data = data.dropna()

文本标准化

文本标准化包括将所有文本转换为小写、去除标点符号和数字等。这有助于减少数据中的噪音,并确保所有文本都以相同的方式处理。

import string

def normalize_text(text):

text = text.lower() # 转换为小写

text = ''.join([char for char in text if char not in string.punctuation]) # 去除标点符号

return text

data['name'] = data['name'].apply(normalize_text)

分词

分词是将文本拆分为单词或词汇的过程。在英文中,我们可以使用空格和标点符号来分词。在中文等没有明确分隔符的语言中,可能需要使用专门的分词工具。

def tokenize(text):

return text.split()

data['name'] = data['name'].apply(tokenize)

编码

编码是将文本转换为数字的过程。这可以通过词袋模型、TF-IDF、词嵌入等方法实现。在词袋模型中,每个单词映射到一个整数。

from sklearn.feature_extraction.text import CountVectorizer

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(data['name'])

数据分割

将数据集分为训练集、验证集和测试集。这有助于我们在训练过程中评估模型的性能,并确保模型能够在未见过的数据上泛化。

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, data['label'], test_size=0.2, random_state=42)

以上是数据预处理的详细步骤,包括数据加载、数据清洗、文本标准化、分词、编码和数据分割。这些步骤对于确保数据质量、提高模型性能至关重要。在处理实际数据时,可能还需要根据具体情况进行调整和优化。

五、模型实现

在本部分,我们将实现用于姓氏分类的MLP和CNN模型。

多层感知器(MLP)模型

多层感知器(MLP)模型主要由输入层、隐藏层和输出层组成。我们将使用PyTorch框架来实现MLP模型。

首先,我们需要定义模型的架构。以下是一个简单的MLP模型示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class MLP(nn.Module):

def __init__(self, input_dim, hidden_dim, output_dim):

super(MLP, self).__init__()

self.fc1 = nn.Linear(input_dim, hidden_dim)

self.fc2 = nn.Linear(hidden_dim, output_dim)

def forward(self, x):

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

接下来,我们将初始化模型参数,并定义损失函数和优化器:

input_dim = 100 # 假设输入维度为100

hidden_dim = 64 # 隐藏层维度为64

output_dim = 10 # 输出维度为10(假设有10个类别)

model = MLP(input_dim, hidden_dim, output_dim)

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

卷积神经网络(CNN)模型

卷积神经网络(CNN)特别适合处理具有空间层次结构的数据,如图像和文本。对于文本数据,我们可以使用一维卷积来提取特征。

以下是一个简单的CNN模型示例:

class CNN(nn.Module):

def __init__(self, vocab_size, embedding_dim, num_filters, filter_sizes, output_dim):

super(CNN, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.conv_layers = nn.ModuleList([

nn.Conv1d(in_channels=embedding_dim, out_channels=num_filters, kernel_size=size)

for size in filter_sizes

])

self.fc = nn.Linear(num_filters * len(filter_sizes), output_dim)

def forward(self, x):

embedded = self.embedding(x).permute(0, 2, 1)

conved = [F.relu(conv(embedded)) for conv in self.conv_layers]

pooled = [F.max_pool1d(conv, conv.shape[2]).squeeze(2) for conv in conved]

cat = torch.cat(pooled, dim=1)

return self.fc(cat)

同样地,我们需要初始化模型参数,并定义损失函数和优化器:

vocab_size = 10000 # 假设词汇量为10000

embedding_dim = 64 # 嵌入层维度为64

num_filters = 128 # 卷积核数量为128

filter_sizes = [3, 4, 5] # 卷积核尺寸为3, 4, 5

output_dim = 10 # 输出维度为10(假设有10个类别)

model = CNN(vocab_size, embedding_dim, num_filters, filter_sizes, output_dim)

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)六、训练和验证

在定义模型、损失函数和优化器之后,我们将使用训练数据集对模型进行训练,并使用验证数据集对其进行验证。以下是训练过程中的一些关键代码:

num_epochs = 10

for epoch in range(num_epochs):

model.train()

for batch in train_dataloader:

inputs, targets = batch

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

model.eval()

with torch.no_grad():

for batch in valid_dataloader:

inputs, targets = batch

outputs = model(inputs)

loss = criterion(outputs, targets)

# 计算准确率等指标

七、结果分析

多层感知器(MLP)模型结果

在训练和验证多层感知器(MLP)模型后,我们可以使用测试数据集对其进行评估。以下是一些关键指标的计算方法:

- 准确率:模型正确预测的样本数与总样本数之比。

- 召回率:针对每个类别,模型正确预测的正样本数与实际正样本数之比。

- F1分数:准确率和召回率的调和平均数。

以下是计算这些指标的代码示例:

from sklearn.metrics import accuracy_score, recall_score, f1_score

model.eval()

with torch.no_grad():

predictions = []

targets = []

for batch in test_dataloader:

inputs, target = batch

outputs = model(inputs)

_, predicted = torch.max(outputs, 1)

predictions.extend(predicted.tolist())

targets.extend(target.tolist())

accuracy = accuracy_score(targets, predictions)

recall = recall_score(targets, predictions, average='macro')

f1 = f1_score(targets, predictions, average='macro')

卷积神经网络(CNN)模型结果

同样地,我们可以使用测试数据集对卷积神经网络(CNN)模型进行评估,并计算准确率、召回率和F1分数等指标。

模型比较

在比较MLP和CNN模型的性能时,我们需要考虑以下因素:

- 准确率和召回率:哪个模型在测试数据上表现更好?

- 计算效率:哪个模型训练和预测的速度更快?

- 模型复杂度:哪个模型的参数更少,更容易训练?

模型优缺点

-

MLP模型:

- 优点:结构简单,易于实现和理解。

- 缺点:对于文本数据,可能无法很好地捕捉局部特征和序列信息。

-

CNN模型:

- 优点:能够捕捉文本数据中的局部特征和序列信息,适合处理文本数据。

- 缺点:模型参数较多,训练时间可能较长。

改进方向

- 数据增强:增加更多的训练样本,以提高模型的泛化能力。

- 模型调优:调整模型参数和超参数,以优化模型性能。

- 特征工程:使用更高级的特征提取方法,如词嵌入或TF-IDF,以提高模型性能。

八、总结

在本实验中,我们展示了如何运用多层感知器(MLP)和卷积神经网络(CNN)来进行姓氏识别的任务。我们详细探讨了数据准备、模型构建、训练过程以及结果评估等关键环节。通过本实验的学习,我们期望参与者能够深入掌握神经网络在文本分类领域的应用,并为将来的学术研究或工程项目打下坚实的基础。

1995

1995

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?