什么是大型语言模型 (LLMs)?

大型语言模型 (LLMs) 是先进的人工智能系统,旨在理解和生成自然语言。它们以非常自然流畅的方式进行这一操作。它们是超级智能的计算机程序,阅读了数十亿页的文本,因此学会了模仿人类的写作和言语。一个典型的例子是 OpenAI 的 GPT-3,拥有 1750 亿个参数。GPT-3 拥有许多参数,使其能够生成可以回答问题、撰写论文甚至创作诗歌的文本。它的输出令人惊讶地连贯且具备上下文意识。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

LLMs为何重要?

LLMs在多个领域中被使用,使语言任务变得更加轻松和快速。想象一下拥有一个属于自己的虚拟助手。它能够理解复杂的问题,并即时给出详细的答案。在客户服务中,LLMs为快速处理查询提供了支持的聊天机器人。 这使得人类工作人员能够专注于更复杂的任务。在医疗领域,像谷歌的Med-PaLM这样的模型帮助医生。它们分析医疗记录和研究论文。这有助于诊断和治疗方案的制定。LLMs帮助金融机构分析数据以防止欺诈和确保合规性。这些LLMs还改变了内容创作。 它们使作家和营销人员能够快速且准确地生成高质量的内容。

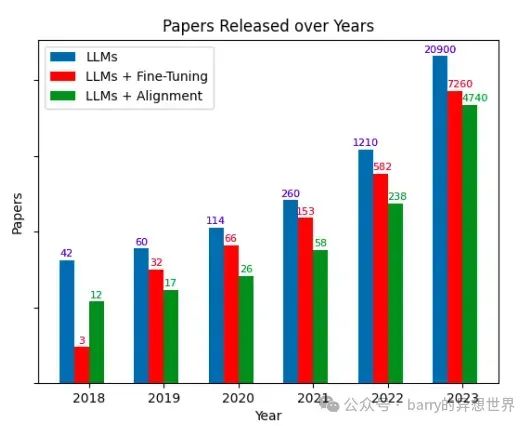

LLM领域的爆炸性增长

LLM的增长可谓爆炸性。2018年引入了包括谷歌的BERT和OpenAI的GPT在内的变换器模型,这一切就此开始。这些模型在理解和生成自然语言方面展现出了前所未有的性能水平。从那时起,每一个新模型都进一步推动了界限。

@https://arxiv.org/pdf/2307.06435

仅在2023年,发布了超过20,000篇论文,其中包含关键词LLM,与2018年的寥寥几篇相比,显著增加。这一快速增长显示了对LLM日益增长的兴趣,包括针对特定任务的微调。同时,这也反映了将这些模型与人类价值观对齐的需求。

另一个引人注目的发展是微软在2024年推出的Phi-2模型。它只有27亿个参数,因此更小。但它的表现超越了许多更大的模型。它通过使用高质量的训练数据和创新的扩展技术实现了这一点。这表明,规模更大并不总是更好;聪明的设计即使在资源更少的情况下也能产生令人印象深刻的结果。

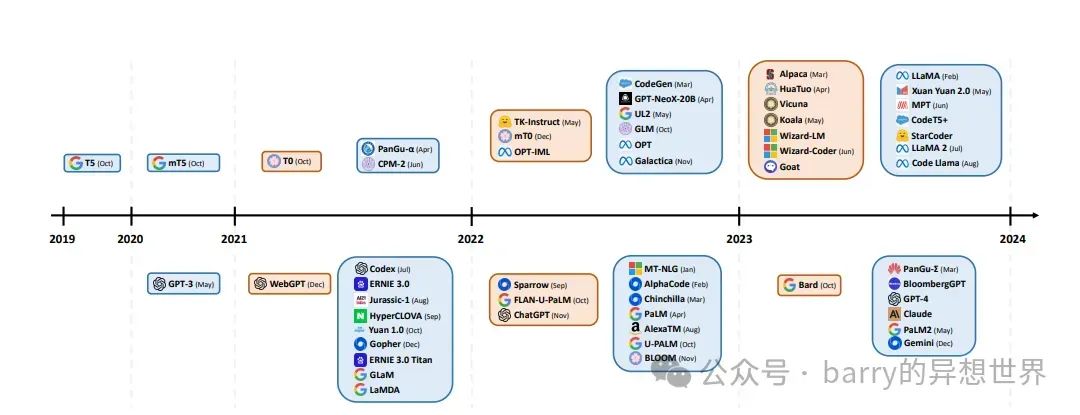

从2019年开始,LLM发布的显著增长标志着“LLM爆炸”的开始。上面的时间线显示了一个趋势:从预训练模型(蓝色)到指令调优模型(橙色)的转变。这一转变显示了对创建能够更好理解和响应人类指令的模型日益关注。我们希望它们能更好地与我们的需求和期望对齐。此外,图表的上半部分显示开源模型占主导地位。这表明LLM技术现在已实现民主化。更多的研究人员和开发者可以访问这些强大的工具。这促进了创新并加速了该领域的进展。本文将进一步探讨排名前120的LLM。它们根据能力和用途分为不同层级。这将为您提供AI语言模型最新动态的完整视图。

2024年顶级120个LLM

“领先巨头”处于AI语言革命的最前沿。它们是前10个LLM。它们在性能、能力和实际应用方面设定了新的基准。这些模型得到了科技巨头和渴望创新的初创公司的支持,是AI研究和开发的佼佼者。

1. GPT-4o (OpenAI): 这是OpenAI GPT系列的最新版本。于2024年5月发布。 与其前身不同,GPT-4是一个多模态模型,能够处理文本和图像。它在各种基准测试中表现出色,在某些领域超越了人类。GPT-4能够生成创意文本、回答复杂问题和编写代码。这使其成为开发者、研究人员和企业的最爱。但访问仍然限制在拥有付费ChatGPT Plus订阅或API候补名单的人。

2. PaLM 2 (Google): 于2023年Google I/O大会上发布,PaLM 2是Google对GPT-4的回应。PaLM 2是在一个庞大的文本和代码数据集上训练的。它在多语言、推理和编码技能方面表现更佳。它在许多测试中超越了前身PaLM。它为一系列Google产品提供支持,包括Bard和Workspace中的Duet AI。PaLM 2能够理解和生成100多种语言的细致文本。这使其成为翻译、内容创作和客户服务的强大工具。

3. Claude 2 (Anthropic): 于2023年7月发布,Claude 2是Anthropic的最新模型。该公司专注于构建安全和有用的AI系统。 Claude 2拥有比前身更大的上下文窗口,使其能够处理和保留更多信息。它在多样化的数据上进行了微调,包括许可和公共内容。其目标是提高推理、编码和聊天技能。Claude 2的可访问性不如GPT-4或PaLM 2。但因其强大的性能和在研究与开发中的潜力而引起关注。

4. Llama 2 (Meta): 于2023年7月发布,Llama 2是Meta最新的开源LLM。Llama 2可用于研究和商业用途,且免费。它是在一个庞大的文本和代码数据集上训练的,提升了其性能。它有多种规模,从70亿到700亿参数不等。这让用户可以根据自身需求和资源选择最佳模型。Llama 2的开源特性和强大性能使其备受欢迎。开发者和研究人员希望构建应用程序并探索LLM的潜力。

5. Gemini (Google): 于2023年5月宣布,Gemini是Google的一种新多模态模型。它仍在开发中。 Gemini结合了PaLM 2和其他模型(如MUM)的优势。它还处理图像和音频。它是一个多功能工具,适用于多种用途。它可以创建内容并帮助完成复杂任务。人们对Gemini寄予厚望,因为它有可能重新定义多模态AI的格局。

6. GPT-NeoX-20B (EleutherAI): 这是一个拥有200亿参数的自回归语言模型,由开源团队EleutherAI开发。它旨在成为比GPT-3等封闭模型更易获取和透明的替代品。GPT-NeoX-20B是在一个多样化的文本和代码数据集“Pile”上训练的。它在文本生成、翻译和问答等任务中表现出色。其开源特性允许更大的灵活性和定制性,是研究人员和开发者的宝贵资源。

7. OPT (Meta AI): 开放预训练变换器(OPT)是Meta AI的一系列仅解码器语言模型,参数范围从1.25亿到1750亿。OPT旨在与GPT-3的成功相匹配。它完全开源,允许更大的透明度和研究。OPT模型在类似于GPT-3的数据集上训练,在许多任务中表现出相似的性能,包括语言建模、摘要和问答。OPT的多种模型规模使其更易于被更多用户访问,适合小型研究人员和大规模部署。

8. BLOOM (BigScience): 由超过1000名AI研究人员创建。它是一个1760亿参数的开源多语言模型。 BLOOM在一个包含46种自然语言和13种编程语言的庞大数据集上进行训练。它是执行多种任务(如文本生成、翻译和代码生成)的强大工具。其多语言能力使其在跨语言应用和研究中尤为有价值。BLOOM的开源特性和包容性使其成为LLM技术民主化的关键参与者。

9. GLaM (Google AI): 通用语言模型(GLaM)是Google AI开发的一个万亿参数模型。它使用混合专家(MoE)模型,不同部分专注于不同的任务或数据类型。这使得GLaM表现良好。它比同等规模的密集模型更高效。GLaM在许多基准测试中表现出色,能够处理广泛的语言任务。然而,由于其规模和复杂性,GLaM主要用于研究和大规模应用。

10. MT-NLG (Microsoft和NVIDIA): 这是一个5300亿参数的语言模型,由Microsoft和NVIDIA共同开发。它是迄今为止最大和最强大的语言模型之一,训练于一个庞大的文本和代码数据集。MT-NLG在许多任务中表现出色,包括语言建模、阅读理解和常识推理。MT-NLG并未公开提供,但它标志着大型语言模型开发中的一个关键里程碑,可能实现类人理解和语言生成。

11–40: 强有力的竞争者

一组“强有力的竞争者”紧随巨头之后。这些 LLM 并不像前 10 名那样知名,但它们正在取得重大进展并开辟自己的市场。这些模型通常由研究机构或小型公司开发,具有独特的特点,满足特定的使用案例。

11. 一个竞争者是 GPT-J (EleutherAI)。它是 一个 60 亿参数的自回归语言模型。因其出色的文本生成能力而受到欢迎。尽管比一些巨头小,但 GPT-J 已被用于代码生成、创意写作和游戏开发。其开源特性和较低的计算需求使其对资源有限的研究人员和开发者更具可及性。

12. 另一个值得注意的竞争者是 Jurassic-1 (AI21 Labs), 一个 1780 亿参数的自回归模型,拥有比 GPT-3 更大的词汇量和更平衡的架构。这使得 Jurassic-1 在少量示例的情况下能够在少样本学习任务中表现出色。AI21 Labs 通过付费 API 提供 Jurassic-1。对于希望使用 LLM 满足需求的企业来说,这是一个不错的选择。

13. CodeGen (Salesforce) 是另一个强有力的竞争者,专为代码生成而设计。CodeGen 在大量代码和自然语言的数据集上进行了训练。它可以生成代码片段、完整的函数,并在编程语言之间进行翻译。其多轮程序合成方法允许更互动的代码生成,这使其成为开发者和程序员的宝贵工具。

14. GLM-130B (ICLR 2023) 是一个双语(英语和中文)模型。它具有独特的训练目标,结合了自回归的空白填充和少量的多任务指令预训练数据。这种方法提高了模型的性能和泛化能力。GLM-130B 是一个有前途的跨语言工作模型,能够很好地处理英语和中文文本。

15. U-PaLM (Google): PaLM 的一个变体,U-PaLM 采用独特的“去噪声混合”目标进行训练。在训练过程中,它结合了不同的文本破坏和重构方法。 这种方法提高了模型在多种任务上的表现,包括开放式文本生成和填充。U-PaLM 在超越传统扩展法则方面表现突出,只有轻微增加计算资源的情况下就能取得更好的效果。

16. UL2 (Google): UL2,或称统一语言学习范式,是一个编码器-解码器模型。它使用多种去噪声目标进行训练。 这种方法使 UL2 能够从各种文本破坏和重构中学习,提高了其在下游任务上的表现。UL2 在需要理解文本关系的任务中表现出色,包括问答和摘要。

17. GLM-130B (多个组织): 由多个组织创建。它是一个双语(英语和中文)模型,具有独特的自回归空白填充预训练目标。 这使得模型具有双向性,在生成文本时可以同时利用过去和未来的上下文。GLM-130B 在许多基准测试中表现优异,擅长需要理解文本中长距离依赖关系的任务。

15. PanGu-Σ (华为): 它是华为开发的万亿参数语言模型,具有稀疏的异构计算架构。 这使得 PanGu-Σ 在性能上优于同等规模的密集模型,且更高效。它在大量中文文本和代码数据集上进行了训练,使其成为许多中文语言任务的强大工具。

16. BloombergGPT (彭博社): 它是一个 500 亿参数的金融模型,在金融和一般数据集上进行了训练。 这使得它能够理解和生成既与金融相关又语言上合理的文本。BloombergGPT 在金融 NLP 任务中表现良好,包括情感分析、命名实体识别和新闻分类。

17. CodeT5+ (Salesforce): 它是 CodeT5 的改进版本,是一个用于代码理解和生成的编码器-解码器模型。 它经过多个阶段的训练,从单模态代码数据开始,然后结合双模态的文本-代码对。这使得 CodeT5+ 能够同时使用代码和自然语言,是代码补全、摘要和翻译的强大工具。

18. StarCoder (Hugging Face 和 ServiceNow): StarCoder 是一个 155 亿参数的仅解码器模型。它在来自 GitHub 的大量许可代码数据集上进行了训练。 它是一个强大的代码生成和补全工具,在多个编码基准测试中表现优于其他模型。StarCoder 的训练数据包含多种编程语言,因此它是开发者的多功能工具。

19. LLaMA-2 (Meta): 它是原始 LLaMA 的继任者,是一个开源语言模型,参数规模从 70 亿到 700 亿不等。 它的数据集更大,训练迭代次数比其前身更多,这提高了其在各种任务上的表现。LLaMA-2 可供研究和商业使用,是 AI 社区的宝贵资源。

20. Flan-T5 (Google): Flan-T5 是 T5 模型的一个版本。它经过指令调优,并在多种任务上进行微调。 这提高了其遵循指令和适应新任务的能力。在许多基准测试中表现优异,如 SuperGLUE 和 MMLU,这显示了其多样性和适应性。

20. mT0 (Hugging Face): mT0 是一个多语言 T0 模型。它在多种语言的各种任务上进行了微调。 研究表明,它在未见任务上,尤其是在非英语语言中,改善了零样本性能。mT0 的多语言能力使其成为跨语言应用和研究的宝贵工具。

21. GPT-Neo (EleutherAI): 一系列开源语言模型,参数规模从 1.25 亿到 200 亿不等。 在 Pile 数据集上训练的 GPT-Neo 模型在文本生成方面表现出色,并且对研究人员和开发者开放。

22. GopherCite (DeepMind): GopherCite 是一个检索增强的语言模型。它将大型语言模型与庞大的知识数据库相结合。 它可以用知识库中的证据回答问题,因此是事实核查和研究的宝贵工具。

23. AlexaTM 20B (亚马逊): 亚马逊开发的 AlexaTM 20B 是一个多语言、少样本学习模型。 它在大量文本和代码数据集上进行了训练,在机器翻译和摘要等任务中表现出色。

24. U-PaLM (Google): PaLM 的一个变体,U-PaLM 采用独特的“去噪声混合”目标进行训练。在训练过程中,它结合了不同的文本破坏和重构方法。 这种方法提高了模型在多种任务上的表现,包括开放式文本生成和填充。U-PaLM 的表现值得注意,它能够超越传统扩展法则,只需小幅增加资源即可取得更好的效果。

25. UL2 (Google): UL2,或称统一语言学习范式,是一个编码器-解码器模型。它使用多种去噪声任务进行训练。 这种方法使 UL2 能够从各种文本破坏和重构中学习,提高了其在下游任务上的表现。UL2 擅长需要理解文本关系的任务,包括问答和摘要。

26. LaMDA (Google): LaMDA 是谷歌开发的对话 AI 模型,代表“对话应用的语言模型”。 它生成自然、引人入胜的对话,已被用于驱动聊天机器人和其他对话代理。LaMDA 能够理解和回应复杂的查询,这使它成为客户服务、教育和娱乐的有前途的工具。

27. Chinchilla (DeepMind): Chinchilla 是一个 700 亿参数的语言模型,挑战了关于扩展语言模型的常规信念。 它强调了平衡模型大小和训练数据的必要性。Chinchilla 在各种测试中表现优于更大的模型,如 Gopher,这表明仅靠大小并不能决定模型的性能。

28. Flan-PaLM (Google): Flan-PaLM 是 PaLM 模型的一个指令调优版本,经过多种任务的微调。 旨在提高其遵循指令和泛化到新任务的能力。在许多基准测试中表现优异,如 SuperGLUE 和 MMLU,这显示了其多样性和适应性。

29. mT0 (Hugging Face): mT0 是一个多语言 T0 模型,经过多种语言的多样化任务微调。 它在未见任务上改善了零样本性能,尤其是在非英语语言中。mT0 的多语言能力使其成为跨语言应用和研究的宝贵工具。

30. Sparrow (DeepMind): Sparrow 是 DeepMind 开发的聊天机器人。它旨在使聊天机器人更加安全和有帮助。 它通过人类反馈的强化学习 (RLHF) 进行训练。它使用基于规则的奖励模型来确保安全且符合人类意图的响应。

31. Evol-Instruct (百度) 是一种为语言模型自动生成复杂、多样化指令的方法。 它对 WizardLM 和 WizardCoder 等模型进行了微调。这提高了它们在各种任务上的表现。

32. Alpaca (斯坦福): Alpaca 是 LLaMA 模型的微调版本。它在来自 OpenAI 的 text-davinci-003 模型的 52k 指令跟随示例上进行训练。 它旨在成为 GPT-3 的更便宜、更易获取的替代品。

33. Vicuna (大型模型系统组织 (LMSYS)): Vicuna 是 LLaMA 的微调版本。它在 ShareGPT 用户的对话数据集上进行训练。 它已被证明在质量上达到了 ChatGPT 的 90%,同时显著更小且更高效。

34. LIMA (Meta): LIMA,或称为“少即是多以实现对齐”,是一个模型。它挑战了微调需要大量数据的观点。 仅用 1,000 个精心挑选的示例,它的表现与 GPT-4 相匹配。这展示了样本高效微调的潜力。

35. Anthropic-HH-RLHF (Anthropic): 该模型使用 RLHF。它旨在提供有帮助且无害的服务。 它被设计为一种更安全、更可靠的语言模型,适用于各种应用。

36. GPT-3 (OpenAI): 虽然不如其他一些模型新,但 GPT-3 仍然是 LLM 领域的重要参与者。其 1750 亿个参数和强大的文本生成能力使其广受欢迎。它被用于聊天机器人和内容创作。GPT-3 能够进行零-shot 学习。它可以理解并响应任务,而无需明确的训练。这一能力是该领域的一项重大突破。

37. Gopher (DeepMind): DeepMind 开发了 Gopher,一个拥有 2800 亿参数的语言模型。它在一个庞大的文本和代码数据集上进行训练。 Gopher 在语言建模、问答和推理等任务上表现良好。其规模和训练数据使其成为多种用途的强大工具。

38. Macaw-LLM (Salesforce): Macaw-LLM 是一个多模态语言模型,能够处理和生成文本、图像、音频和视频。它在一个大型多样化的多模态数据集上进行训练,并在各种任务上显示出良好的结果,包括图像字幕生成、视频问答和文本转语音合成。

39. LaMDA (Google): LaMDA,或称为对话应用的语言模型,是 Google 的一款对话 AI。 它生成自然、引人入胜的对话。它为聊天机器人和其他代理提供支持。LaMDA 能够理解并响应复杂的提示。因此,它是客户服务、教育和娱乐的有前景的工具。

40. Codex (OpenAI): Codex 是一个语言模型。它在公共 GitHub 代码上进行了微调。 它能够根据自然语言描述生成代码。因此,它是开发人员和程序员的宝贵工具。Codex 驱动 GitHub Copilot,一个代码补全工具。它根据正在编写的代码的上下文建议代码片段。

41–70: 新兴参与者

LLM 领域不仅仅是关于已建立的巨头。它还充满了“新兴参与者”——这些模型正逐渐获得关注并展现出巨大潜力。这些模型通常来自研究机构或小型公司,正在推动 LLM 的极限。它们正在探索 AI 研究的新前沿。

41. 一颗冉冉升起的新星是 Cerebras-GPT, 这是一个包含 1.11 亿到 130 亿参数的开源模型家族。这些模型由 Cerebras Systems 开发,针对其 CS-2 系统进行了优化。这个大规模并行系统允许高效的训练和推理。Cerebras-GPT 模型在许多基准测试中表现出色。这显示了它们在研究和实际应用中的潜力。

42. GPT-NeoX-20B (EleutherAI) 是一个拥有 200 亿参数的自回归语言模型。它是一种新兴参与者,以其强大的性能和开源特性而闻名。GPT-NeoX-20B 在 Pile 数据集上训练,该数据集是一个多样化的文本和代码集合,成功应用于文本生成、翻译和问答等任务。它的可访问性和灵活性使其成为研究人员和开发者探索大规模语言模型能力的宝贵资源。

43. MPT (MosaicML): MPT 是 MosaicML 提供的一系列开源语言模型。它在商业上可行、高效且可扩展,适用于多种应用。MPT 模型在多样化的文本和代码数据集上进行了训练,在语言建模和代码生成等多个基准测试中表现出色。

44. RWKV (BlinkDL): RWKV 是一个基于 RNN 的语言模型,提供了一种替代变换器架构的选择。它比变换器更高效,并在多种任务上表现良好。RWKV 的独特设计和效率使其成为 LLM 研究人员和开发者探索该领域新方向的绝佳选择。

45. OpenChatKit (Together Computer): OpenChatKit 是一个开源项目,旨在创建可定制、可部署的聊天机器人。它包括一系列模型、数据集和工具,用于构建和微调聊天机器人。OpenChatKit 对可访问性和定制化的关注使其成为开发者和组织的宝贵资源,他们希望创建自己的 AI 聊天代理。

46. Dolly (Databricks): Dolly 是一个拥有 120 亿参数的语言模型。它在一小组人类生成的指令上进行了指令调优。尽管体量较小,Dolly 在许多任务上表现出色,包括问答和摘要。其遵循指令的能力使其成为一个有前景的工具,可以帮助构建需要理解和响应人类语言的对话 AI 和应用。

47. GPT-NeoX (EleutherAI): 这是一个开源语言模型家族,版本参数范围从 1.25 亿到 200 亿。GPT-NeoX 模型在 Pile 数据集上训练,在文本生成方面表现出色,且对研究人员和开发者均可访问。

48. OPT-175B (Meta AI): 最大的 OPT 模型 OPT-175B 拥有 1750 亿参数。它是一个仅解码的语言模型。其目标是成为一个更可访问、透明的替代品,以取代像 GPT-3 这样的封闭模型。OPT-175B 在许多任务上表现出色,包括语言建模、摘要和问答。

49. Galactica (Meta AI): Galactica 是一个在大量科学知识语料库上训练的语言模型。它帮助进行文献回顾和回答科学问题。Galactica 能够理解和生成科学文本,因此是研究人员和科学家的宝贵工具。

50. Jurassic-1 Jumbo (AI21 Labs): 一个拥有 1780 亿参数的模型,它比 Jurassic-1 Large 更大。它适用于少量学习,擅长需要广泛上下文和细腻文本的任务。

51. HyperCLOVA (Naver): 由 Naver 开发,HyperCLOVA 是一个与 GPT-3 结构相似的韩文语言模型。它在大量韩文文本和代码数据集上进行了训练,使其成为多种韩文处理任务的强大工具。

52. Yuan 1.0 (Inspur): Yuan 1.0 是一个拥有 2450 亿参数的语言模型,训练于大型中文语料库。它旨在在零样本和少样本学习中表现出色,并在各种 中文 NLP 任务中表现良好。

53. ERNIE 3.0 Titan (Baidu): ERNIE 3.0 的扩展版本,是一个拥有 2600 亿参数的模型,采用知识增强技术。它在中文 NLP 任务上创造了新纪录,同时生成可信、可控的文本。

54. CodeGen-16B (Salesforce): 一个拥有 160 亿参数的模型,是 CodeGen 的一个变体,专注于代码生成。它在大量代码和自然语言的数据集上进行了训练,表现出色,适用于各种代码任务,包括补全和翻译。

55. LLaMA 65B (Meta): 这是一个拥有 650 亿参数的模型。LLaMA 65B 是 LLaMA 家族开源、高效基础语言模型的一部分。它在大量文本和代码数据集上进行了训练,表现良好,适用于许多任务,包括语言建模和问答。

56. PanGu-α (Huawei): 这是华为推出的一个拥有 2000 亿参数的自回归中文模型。 它在大量中文文本和代码数据集上进行了训练,擅长各种中文 NLP 任务,包括文本生成和理解。

57. XuanYuan 2.0 (DuXiaoman Financial): XuanYuan 2.0 是一个拥有 1760 亿参数的中文金融聊天模型,旨在回答金融查询。它在通用和金融数据集上进行了训练。

58. CodeGeeX (THUNLP): 这是一个拥有 130 亿参数的多语言代码生成模型。它在大量多种语言的代码数据集上进行了训练,在代码生成和翻译任务中表现出色。

59. Baichuan-13B (Baichuan Intelligent Technology): Baichuan-13B 是一个拥有 130 亿参数的开源大型语言模型。它在大量多样化的中文文本和代码数据集上进行了训练,在各种中文 NLP 任务中表现出色。

60. ChatGLM-6B (Zhipu.AI): 这是一个拥有 60 亿参数的双语(中英)模型,专注于生成对话。 它在大量对话数据集上进行了训练,能够生成连贯、引人入胜的对话,表现令人印象深刻。

61. InternLM (Shanghai AI Laboratory): 这是一个拥有 1040 亿参数的语言模型。它在大量文本和代码数据集上进行了训练。在许多任务上表现良好,包括语言建模、问答和推理。InternLM 是一个有前景的模型,具有多种用途,如聊天机器人、内容创作和研究。

62. GPT-2 (OpenAI): 它的规模小于其后继者,但在变换器基础语言模型的发展中标志着一个关键点。它的 15 亿参数使其能够生成连贯、相关的文本,为更大、更强大的模型(如 GPT-3 和 GPT-4)铺平了道路。

63. BERT (Google AI): BERT,即来自变换器的双向编码器表示, 是一个变换器模型,彻底改变了自然语言理解任务。其双向训练使其在处理单词时能够利用左右上下文,这提高了在问答和情感分析等任务上的表现。

64. RoBERTa (Facebook AI): RoBERTa,即经过强优化的 BERT 预训练方法,是一个更好的 BERT。它在更大的数据集上进行了更长时间的训练,从而提高了在各种 NLP 任务上的表现。RoBERTa 在研究和应用中非常受欢迎,性能优异且开源。

65. XLNet (Google AI 和 Carnegie Mellon): 这是一个语言模型,结合了自回归和自编码模型的优点。它使用置换语言建模目标,这使其能够在训练期间考虑所有输入序列的置换。XLNet 在语言建模和阅读理解等多个任务中表现出色。

66. ELECTRA (Google AI): ELECTRA 代表高效学习一个能够准确分类令牌替换的编码器。它是一个语言模型,训练一个鉴别器来区分文本中的原始和替换令牌。这种方法比传统的掩蔽语言建模更高效,导致训练速度更快以及在下游任务上的表现更好。

67. T0 (BigScience): T0 是一个在大量不同任务上使用文本到文本格式训练的模型。这种多任务训练使 T0 能够很好地泛化到新任务,并在各种基准测试中表现出色。

68. StableLM (Stability AI): StableLM 是由 Stability AI 开发的一套语言模型。这些模型旨在实现稳定、高效和可扩展,适用于广泛的应用场景。StableLM 模型在多样化的文本和代码数据集上进行了训练,并在各种基准测试中显示出良好的结果。

69. Cerebras-GPT (Cerebras Systems): Cerebras-GPT 是一系列为 Cerebras CS-2 系统优化的开源语言模型,该系统是一个大规模并行的 AI 加速器。这些模型在各种基准测试中表现出竞争力,并旨在实现高效的训练和推理。

70. MOSS (Fudan University): 复旦大学开发了 MOSS,这是一个拥有 160 亿参数的语言模型,旨在成为一个更易于获取和负担得起的替代品,以替代像 GPT-3 这样的专有模型。MOSS 在语言建模和对话生成等多种任务中显示出良好的结果。

71–120: 细分和专业化的 LLM

除了通用模型之外,一波新的“细分和专业化 LLM”正在出现。它们旨在满足特定行业和应用的独特需求。这些模型通常在特定数据上进行微调,极具价值。它们是专业人士和研究人员的工具。它们寻求能够理解其领域细微差别的 AI。

71. 在医疗保健领域,例如,Med-PaLM 2 (Google) 正在引起关注。该模型在一组医学专家演示上进行了微调,擅长回答医学问题。它在医学考试问题上甚至优于 PaLM 和 Flan-PaLM 等通用模型。这表明 LLM 可能会彻底改变医疗保健。它们能够为专业人士和患者提供准确、可靠的信息。

72. 在法律领域,Harvey (OpenAI) 被誉为游戏规则改变者。我们与律师事务所 Allen & Overy 合作开发了 Harvey。它帮助进行合同分析和尽职调查等任务。它还协助合规管理。通过大规模处理法律文档,它可以大大提高效率。这将简化法律工作流程。

73. 对于科学研究,BioMedLM (Microsoft Research) 是一个有前途的工具。

BioMedLM 在大量生物医学文献上进行训练,可以:

-

回答复杂的生物医学问题。

-

总结研究论文。

-

协助药物发现。

它可以大大加快科学发现的速度。它还可以使生物医学知识变得更加可获取。

74. 在金融领域,FinBERT (Prosus AI) 是一个 BERT 模型。它在金融文本数据上进行了微调。它在金融新闻的情感分析、风险评估和欺诈检测等任务上表现出色。FinBERT 理解金融语言。因此,它是公司和投资者的重要工具。

75. 对于开发人员和程序员,Codex (OpenAI) 和 CodeT5+ (Salesforce) 是不可或缺的工具。Codex 驱动着 GitHub Copilot,能够生成代码。它可以完成函数并在语言之间进行翻译。CodeT5+ 擅长理解和生成代码。它对代码审查、调试和文档编写非常有用。

76. SciBERT (Allen Institute for AI): SciBERT 是一个专门针对科学文本训练的语言模型。它在许多科学 NLP 任务上优于通用模型。这些任务包括命名实体识别、关系提取和问答。SciBERT 理解科学术语和概念的能力使其成为研究人员和科学家的重要工具。

77. Legal-BERT (Hugging Face): Legal-BERT 是一个在法律文本上进行微调的语言模型。它在许多法律 NLP 任务上优于通用模型。这些任务包括法律问答和文本分类。Legal-BERT 理解法律术语和概念的能力使其成为律师和法律专业人士的重要工具。

78. BioBERT (Korea University): BioBERT 是一个专门针对生物医学文本训练的语言模型。它在许多生物医学 NLP 任务上优于通用模型。这些任务包括生物医学命名实体识别、关系提取和问答。BioBERT 能够理解生物医学术语和概念。因此,它是研究人员和医疗专业人士的重要工具。

79. ClinicalBERT (Google AI): ClinicalBERT 是一个在临床笔记上进行微调的语言模型。它在各种临床 NLP 任务上优于通用模型。这些任务包括医学概念提取和去标识化。ClinicalBERT 理解临床语言的能力使其成为医疗专业人士和研究人员的重要工具。

80. ChemBERTa (AstraZeneca): ChemBERTa 是一个专门针对化学文本训练的语言模型。它在各种化学 NLP 任务上优于通用模型,例如化学命名实体识别和关系提取。ChemBERTa 理解化学术语和概念。它是化学家和研究人员的有用工具。

81. SciFive (Allen Institute for AI): SciFive 是一个在大量科学论文上训练的语言模型。它可以总结科学论文、回答问题并提出新假设。SciFive 能够理解和创建科学文本。因此,它是研究人员和科学家的重要工具。

82. FinGPT (Various Institutions): FinGPT 是一个开源金融大语言模型。它在大量金融文本和代码上进行训练。它在各种金融 NLP 任务上表现出色。这些任务包括金融情感分析、风险评估和欺诈检测。

83. ChatDoctor (Various Institutions): ChatDoctor 是一个旨在生成医疗对话的语言模型。它在大量医生与患者聊天的数据集上进行训练。它能够生成既信息丰富又富有同情心的回复。ChatDoctor 有潜力改善患者获取医疗信息和支持的途径。

84. LawGPT (Various Institutions): 它是一个法律语言模型。它可以回答法律问题、分析合同和生成法律文件。它在大量法律文本和代码上进行训练,并在自动化各种法律任务方面显示出良好效果。

85. ChemGPT (Various Institutions): ChemGPT 是一个用于化学任务的语言模型。这些任务包括合成规划、反应预测和性质预测。它在大量化学文本上进行训练。它在加速化学研究和开发方面显示出良好前景。

86. BioGPT (Microsoft Research): BioGPT 是一个语言模型。它在大量生物医学文本语料库上进行预训练。它是领域特定的。它在各种生物医学 NLP 任务上相较于通用模型有了改进。

87. GeneGPT (Various Institutions): 它是一个用于基因组任务的语言模型。这些任务包括预测基因功能、解释变异和分析疾病关联。它在一个庞大的基因组数据集上进行训练。它在推动基因组研究方面显示出良好前景。

88. SciSpace Copilot (Typeset): SciSpace Copilot 是一个专为研究人员设计的 AI 写作工具。它可以帮助进行文献综述、草拟和编辑等任务。它使科学写作更加高效。

89. Elicit (Ought): Elicit 是一个 AI 研究助手。它使用语言模型来帮助研究人员。它查找相关论文,总结关键发现,并集思广益新研究想法。它是加速研究过程的重要工具。

90. Semantic Scholar (Allen Institute for AI): 它是一个用于论文的 AI 搜索引擎。它使用语言模型来理解研究论文。它提供更相关的搜索结果。

91. Scite (Scite.ai): Scite 是一个使用语言模型的平台。它分析科学论文中引用的上下文。它帮助研究人员评估研究结果的可信度和可靠性。

92. Iris.AI (Iris AI): 它是一个 AI 研究助手。它帮助研究人员查找相关论文、提取关键信息并生成摘要。它是加速研究过程的重要工具。

93. Scholarcy (Scholarcy): Scholarcy 是一个 AI 驱动的工具,帮助研究人员阅读和总结研究论文。它可以提取关键发现、生成摘要,甚至为学习创建闪卡。

94. Consensus: 一个使用语言模型回答科学研究问题的搜索引擎。它为用户提供与其查询相关的研究结果的简明摘要。

95. Paperpal (Cactus Communications): Paperpal 是一个专为研究人员设计的 AI 写作助手。它可以帮助进行语法和风格检查,确保科学写作清晰简洁。

96. BloombergGPT (Bloomberg): 它是一个用于金融的 500 亿参数语言模型。它在大量金融数据和通用文本上进行训练,擅长金融新闻的情感分析、风险评估和新闻分类等任务。BloombergGPT 具有独特的优势。其专有数据集庞大,有助于理解金融语言和概念的复杂性。

97. FinBERT (Prosus AI): FinBERT 是一个在金融文本数据上进行微调的 BERT 模型。它在金融新闻情感分析方面非常有效。因此,它是投资者和分析师的重要工具。他们使用它来评估市场情绪并做出明智的决策。

98. MarketBERT (各机构): MarketBERT是一个BERT模型。它在金融数据上进行了微调,重点关注市场分析。 它可以预测股价,分析市场趋势,并寻找投资机会。

99. GPT-E (各机构): GPT-E是一个为经济分析设计的语言模型。它可以预测经济,分析数据,并寻找趋势。

100. LawBERT (各机构): LawBERT是一个在法律文本数据上微调的语言模型。它在回答法律问题、合同分析和文档生成等任务中表现出色。它可能会自动化法律实践的各个方面。

101. BioMedLM (微软研究院): BioMedLM是一个在大量生物医学文献上训练的语言模型。它可以回答复杂的生物医学问题,总结论文,并协助药物发现。它是医学研究人员和医疗专业人员的宝贵工具。

102. GeneGPT (各机构): GeneGPT是一个为基因组学任务设计的语言模型。它可以预测基因功能并分析疾病关联。它还可以解释遗传变异。这可能会加速基因组学研究和开发。

103. ProtGPT2 (各机构): ProtGPT2是一个为蛋白质工程设计的语言模型。它可以预测蛋白质结构,设计新蛋白质,并优化现有蛋白质。这可能会彻底改变药物开发和其他与蛋白质相关的领域。

104. ChemBERT (各机构): ChemBERT是一个在化学文本数据上微调的语言模型。它在化学命名实体识别、关系提取和属性预测等任务中表现出色。它现在是化学家和化学研究人员的宝贵工具。

105. Elicit (Ought): Elicit是一个AI研究助手。它使用语言模型来帮助研究人员。它查找论文,总结发现,并进行头脑风暴新想法。 它是加速研究过程的宝贵工具。

106. Semantic Scholar (艾伦人工智能研究所): 它是一个用于科学论文的AI搜索引擎。 它使用语言模型理解研究论文的含义,并提供更相关的搜索结果。

107. Scite (Scite.ai): Scite是一个平台,利用语言模型分析科学论文中引用的上下文。它帮助研究人员评估研究发现的可信度和可靠性。

108. Iris.AI: 它是一个AI研究助手。它帮助研究人员找到相关论文,提取关键信息,并生成摘要。 它是加速研究过程的宝贵工具。

109. Scholarcy (Scholarcy): Scholarcy是一个AI驱动的工具,帮助研究人员阅读和总结研究论文。它可以提取关键发现,生成摘要,甚至创建学习用的抽认卡。

110. Paperpal (Cactus Communications): Paperpal是一个为研究人员设计的AI写作助手。它可以帮助完成语法和风格检查等任务,确保科学写作清晰简洁。

111. Writefull (Digital Science): Writefull是一个为研究人员设计的AI写作助手。它帮助他们改善写作。 它提供语法、风格和用词选择的建议,甚至可以帮助论文的结构和组织。

112. Grammarly (Grammarly, Inc.): 它是一个流行的写作工具。它并不是为科学写作设计的。但研究人员可以用它来改善语法和风格。 它提供实时反馈和建议。它是任何希望提高写作水平的人的宝贵工具。

113. ProWritingAid (ProWritingAid Ltd.) 是一个为研究人员设计的写作助手。 它提供语法检查、风格检查、抄袭检测和可读性分析等功能。

114. DialoGPT (微软): DialoGPT是一个大规模预训练的对话响应生成模型。它在大量Reddit聊天数据集上进行训练。它可以生成相关且引人入胜的响应。

115. Meena (谷歌AI): Meena是一个谷歌AI聊天机器人。它旨在提供更合理和具体的响应。 它在大量社交媒体对话数据集上进行训练,可以就广泛主题进行开放领域的对话。

116. Kuki (Pandorabots): Kuki是一个获奖的AI聊天机器人。它具有出色的聊天技能。 它旨在引人入胜和娱乐,能够就广泛主题进行对话。

117. Replika (Luka, Inc.): Replika是一个AI伴侣,旨在提供情感支持和陪伴。它可以从对话中学习,并适应用户的个性和兴趣。

118. Woebot (Woebot Health): Woebot是一个旨在帮助人们管理心理健康的AI聊天机器人。它使用认知行为疗法帮助用户改变消极思维。

119. Wysa (Wysa): Wysa是一个旨在帮助人们管理压力和焦虑的AI聊天机器人。它提供工具和技巧,帮助用户应对困难情绪,包括正念和呼吸练习。

120. YouChat (You.com): YouChat是一个AI搜索助手。它可以以聊天格式回答问题并提供信息。 它在大量文本和代码数据集上进行训练。它可以访问和处理网络信息,以提供准确、最新的回答。

如何选择适合您需求的 LLM

选择合适的 LLM 至关重要。 它可以极大地影响您项目的成功。没有一刀切的答案,因为最适合您的 LLM 将取决于您的具体需求、资源和目标。然而,在做出选择时,有几个关键因素需要考虑。

首先,您需要 确定您的具体需求和使用案例。您希望 LLM 执行哪些任务?您是在寻找一个在文本生成、翻译、问答或其他方面表现出色的模型吗?不同的 LLM 具有不同的优势和劣势。因此,选择一个符合您需求的模型。对于代码生成,可以考虑 CodeGen 或 CodeT5+。对于金融,尝试 BloombergGPT。

接下来,您需要 评估 LLM 的能力。这涉及查看其在相关基准和数据集上的表现。对于问答,检查其在 SQuAD 或 Natural Questions 数据集上的表现。此外,考虑模型的大小和架构。这些会影响其性能和计算需求。像 GPT-4 和 PaLM 2 这样的大型模型通常提供更好的性能,但需要更多的资源来运行。

可访问性是另一个关键因素。一些 LLM,如 Llama 2,是开源且免费的。其他如 GPT-4 是专有的,需要付费订阅才能访问 API。考虑您的预算。您是否需要根据您的需求修改模型?

成本和许可也是重要的考虑因素,尤其是对于企业和组织。一些 LLM 提供有限使用的免费层。其他则需要支付使用费或订阅费。确保将使用 LLM 的成本纳入您的预算。

最后,不要忘记 伦理考虑。LLM 可能会延续其训练数据中的偏见。因此,选择一个在多样化、具有代表性的数据上训练的模型。此外,考虑 LLM 滥用的风险。确保您有防范措施,以防其被用于有害目的。

让我们来看几个实际案例,以说明这些因素的作用。一个气候变化研究团队可能选择一个开源模型,如 BLOOM 或 GPT-J。它们灵活且便宜。希望自动化客户服务的银行可能选择 BloombergGPT 或 FinBERT。它们理解金融语言和概念。希望制作诊断工具的医疗服务提供者可能会选择 Med-PaLM 2,因为它在回答医学问题方面具有专业知识。

结论

随着我们推动这些模型的极限,我们必须应对它们面临的挑战。这些挑战包括高成本、伦理问题和透明度的需求。如果我们能够应对这些挑战,就能释放LLMs的全部潜力。我们可以创造一个AI与人类语言无缝互动的未来。这将激发新的创新和进步。

研究人员、开发人员和商业领袖必须采用LLMs。现在,保持在技术前沿已成为必然。本指南中的120个LLMs是该领域的佼佼者。它们展示了AI语言模型的强大能力。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

2908

2908

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?