写在前面

大语言模型(LLMs)是在海量文本语料库上训练的人工智能模型,具备卓越的语言理解和生成能力,正在改变自动驾驶(AD)领域。随着自动驾驶系统从基于规则和优化的方法向基于学习的技术(如深度强化学习)发展,它们正蓄势待发,准备接纳第三个也是更高级的类别:由LLMs赋能的基于知识的自动驾驶。这一转变有望使自动驾驶更接近人类驾驶水平。然而,将LLMs集成到自动驾驶系统中在实时推理、安全保障和部署成本方面带来了挑战。本综述全面而批判性地回顾了近期在利用LLMs进行自动驾驶方面取得的进展,重点关注其在模块化自动驾驶流程和端到端自动驾驶系统中的应用。主要突出了关键进展,识别了紧迫的挑战,并提出了有前景的研究方向,以弥合LLMs与自动驾驶之间的鸿沟,从而促进开发更贴近人类驾驶水平的自动驾驶系统。本综述首先介绍了LLMs的关键特性和常见训练方案,然后分别深入探讨了它们在模块化自动驾驶流程和端到端自动驾驶中的应用,最后讨论了面临的开放挑战和未来方向。通过这一深入分析,我们旨在为人工智能与自动驾驶交叉领域的研究人员和实践者提供见解和灵感,最终推动更安全、更智能、更以人为本的自动驾驶技术的发展。

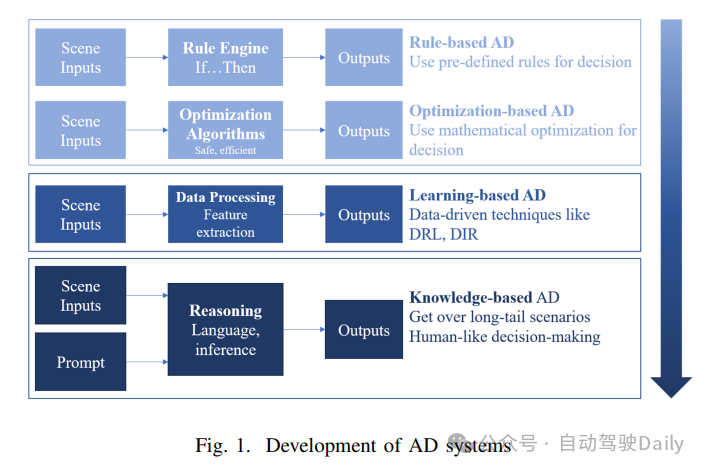

自动驾驶(AD)已成为一项具有变革性的技术,具有彻底改变智能交通系统、提高道路安全性和增强出行能力的潜力。自动驾驶技术的核心在于决策过程,这一过程包括分析数据、理解环境以及就导航和安全性做出明智决策。如图1所示,根据所采用的技术,自动驾驶系统的发展可以分为三类。

第一类自动驾驶主要依赖于确定性方法,如基于规则和优化的方法。虽然这些方法提供了可靠性和可解释性,但它们往往缺乏应对复杂和新颖场景的能力。第二类自动驾驶则由深度学习的快速发展所推动,在自动驾驶系统中利用深度强化学习(DRL)等技术。尽管这些基于学习的方法在处理复杂场景方面取得了成功,但它们仍面临长尾场景的挑战,并且由于它们从有限的训练集中学习模式,因此在训练集之外的环境中缺乏泛化能力。

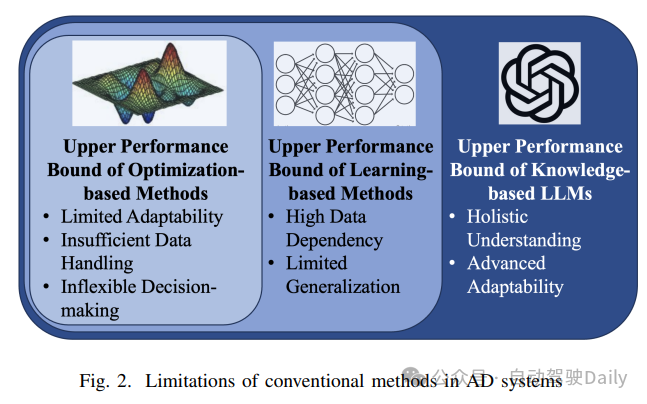

自动驾驶(AD)面临的关键挑战之一是解决长尾问题,即处理现实世界交通中罕见但复杂的场景的能力。尽管人们已经努力使用模拟器来模拟自动驾驶环境,但现实世界场景的复杂性,包括交通规则、天气条件、行人行为和各种紧急情况等因素,给现有方法带来了巨大困难。此外,自动驾驶系统中缺乏可解释性阻碍了人类的信任,并阻碍了其广泛应用。图2直观地展示了传统自动驾驶方法的局限性,进一步强调了引入大型语言模型(LLMs)的必要性。

最近,大型语言模型(LLMs)的发展为自动驾驶(AD)领域带来了革命性的变化。对于自动驾驶汽车来说,做出类似人类的决策至关重要,因为它们需要在人类社会中以安全且符合社会规范的方式运行。凭借强大的语言理解和推理能力,这些模型为自动驾驶汽车开启了一个新时代或第三类方法。一方面,LLMs可以作为知识库,为自动驾驶提供丰富的常识知识,弥补纯数据驱动方法的不足。另一方面,LLMs擅长处理自然语言指令,使车辆能够理解人类意图并表现出更类人的驾驶行为。此外,LLMs还展示了出色的少样本学习和迁移学习能力,有望解决自动驾驶中少数极端情况和大量长尾问题。以GPT-4为代表的LLMs在路况风险感知、决策规划、人机交互等关键任务上取得了初步突破,大大提高了自动驾驶的性能。尽管将强大的语言模型引入复杂的物理世界仍面临诸多挑战,但LLMs有望成为未来自动驾驶的关键赋能技术。自动驾驶研究有时将LLMs视为“黑盒”,忽视了其科学基础和通用性,而面向人工智能的研究则可能依赖自动驾驶数据集,而不考虑模拟器或现实世界测试的重要性。本文旨在通过提供LLMs应用的全面概述来弥合这些差距。

本文的主要贡献:

1)系统回顾了LLMs在自动驾驶领域的最新进展,并提出了一个涵盖感知、决策、规划和控制的分类分析框架;

2)聚焦于模块化决策和端到端学习两种范式,深入分析了不同技术路线的优缺点,并细化了接下来需要解决的关键科学问题;

3)展望了LLMs驱动的自动驾驶的未来发展方向和实际应用需求,为学术界和工业界提供了参考。

大语言模型和多模态大语言模型

LLMs(大语言模型)和MLLMs(多模态大语言模型)已经彻底改变了自然语言处理领域及其以外的领域,使机器能够以前所未有的水平理解、生成和处理自然语言。LLMs通过训练大量的文本数据,能够捕捉复杂的语言模式、上下文依赖关系和语义关系。LLM的输入通常表示为一系列标记,其中i表示第i个句子,j表示句子中的第j个标记。LLM的输出,表示为,通常是下一个标记的概率分布。因此,LLM可以表示为一个函数f,该函数将输入映射到输出:

在大语言模型(LLMs)的基础上,提出了多模态大语言模型(MLLMs)来处理多模态输入,如图像、视频、文本、音频、点云,甚至是深度或热信息。从数学角度看,一个MLLM可以被定义为函数f’,该函数将一系列多模态输入映射到输出上:

其中,表示第 个示例中来自第 k 个模态(例如图像 I、文本 T、点云 P)的输入,而 是模型针对同一示例的输出(例如,自动驾驶汽车(AVs)的控制命令)。

一个多模态大语言模型(MLLM)的关键组件包括模态编码器 E(k)、一个多模态融合模块 F、一个语言模型 f,以及一个输出投影器 P。形式上,MLLM的输出可以表示为:

几个有影响力的多模态大语言模型(MLLM),如BLIP-2、LLaVA和Flamingo,已经为该领域的发展奠定了基础。这些模型在视觉问答(VQA)、图像描述和多模态推理等任务中表现出了令人印象深刻的性能。通过整合视觉、文本以及可能的其他感官输入,MLLM可以为复杂驾驶场景中的决策过程提供更丰富的上下文信息。

几个有影响力的多模态大语言模型(MLLM),如BLIP-2、LLaVA和Flamingo,已经为该领域的发展奠定了基础。这些模型在视觉问答(VQA)、图像描述和多模态推理等任务中表现出了令人印象深刻的性能。通过整合视觉、文本以及可能的其他感官输入,MLLM可以为复杂驾驶场景中的决策过程提供更丰富的上下文信息。

1)大语言模型和多模态大语言模型的预训练和微调

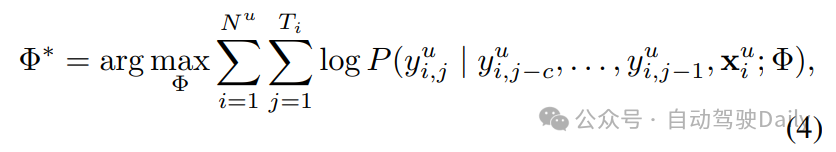

预训练:预训练在大语言模型(LLMs)和多模态大语言模型(MLLMs)的发展中起着关键作用,使它们能够获得对自然语言和多模态数据的广泛而细致的理解。预训练的数学目标描述如下:

其中,Φ∗ 表示预训练后的最优参数, 表示训练序列的数量, 表示第 i 个目标序列的长度。索引 i 和 j 分别代表当前标记在训练数据中的位置,其中 i 遍历训练序列,j 遍历每个序列中的标记。上下文窗口大小 c 决定了在预测下一个标记时作为上下文考虑的先前标记的数量,这会影响模型捕获长距离依赖关系的能力。

微调:微调是在特定任务或领域上进一步训练预训练的大语言模型(LLM)或多模态大语言模型(MLLM)的过程,旨在提高其性能。主要的微调技术包括参数高效微调(PEFT)、prompt tuning、instruction tuning以及基于人类反馈的强化学习(RLHF)。

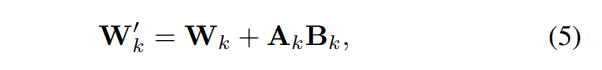

参数高效微调(PEFT)方法,如低秩适应(LoRA),旨在使预训练模型适应特定任务,同时最大限度地减少所需的额外参数和计算资源。LoRA会冻结预训练模型的权重,并在Transformer架构的每个层 k 中注入可训练的秩分解矩阵 和 ,其中 r_≪_d。调整后的权重 计算如下:

其中 是冻结的预训练权重。

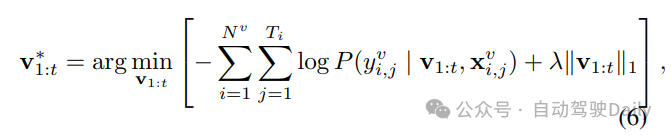

Prompt tuning采用可学习的连续向量,称为“软提示”(soft prompts),以提高大语言模型(LLMs)在下游任务中的性能。Prompt tuning的目标是最小化以下损失函数:

其中, 表示在给定输入 和软提示的情况下生成输出 的概率, 指的是微调序列的数量,而 λ 是一个 _L_1 正则化项,用于鼓励学习到的提示中的稀疏性。

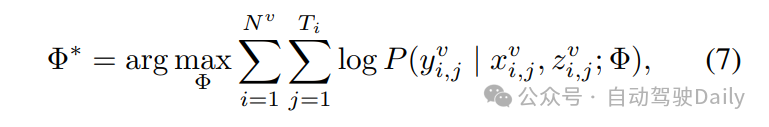

Instruction tuning通过在一系列以指令形式表述的数据集上对大语言模型(LLMs)进行微调,使它们与人类意图保持一致。指令调整的目标函数可以表示为:

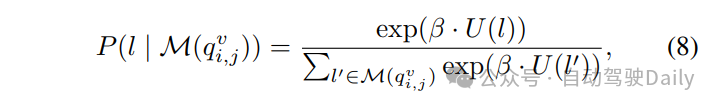

其中, 表示在给定输入 和指令 的情况下,以参数 Φ 生成正确输出 的 概率。RLHF(Reinforcement Learning from Human Feedback)使用人类反馈作为奖励信号,通过强化学习对大型语言模型(LLMs)进行微调,从而生成更安全、更一致的输出。在RLHF框架中,玻尔兹曼分布(Boltzmann distribution)在模拟人类选择方面发挥着基础性作用:

像PEFT和RLHF这样的微调技术对于自动驾驶(AD)应用尤其有益。PEFT方法允许大型模型有效地适应特定的驾驶任务,如行人行为预测或交通标志识别,而无需对模型进行完全重新训练。另一方面,RLHF可用于使自动驾驶系统与人类驾驶偏好和安全标准保持一致,从而可能产生更自然、更可接受的驾驶行为。

2)In-context Learning and Theoretical Analysis

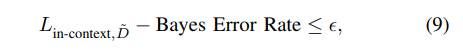

In-context Learning是大语言模型(LLMs)中出现的一种令人惊讶的现象,其中模型只需通过提供由几个输入输出示例组成的提示,就可以专门执行特定任务,而无需对模型参数进行任何梯度更新。Wies等人提出了一个可能近似正确(PAC)学习框架来形式化上下文学习,表明在大概率下,上下文学习者可以PAC学习下游任务D̃,即:

其中,贝叶斯错误率表示在给定任务上任何分类器的理论上可能的最低错误率。Xie等人提出了另一个理论框架,其中通过隐式贝叶斯推断来概念化大语言模型(LLMs)的上下文学习能力。他们建立了几个基础结果,以描述上下文学习行为,包括渐近最优性、随着示例长度的增加而单调减少的错误率,以及处理不同长度测试示例的能力。上下文学习使自动驾驶系统能够适应新场景而无需进行大量重新训练,这对于处理多样化和动态的驾驶环境至关重要。例如,一个由LLM增强的自动驾驶系统可以根据少量新交通模式或道路条件的示例快速调整其行为。

模块化决策制定

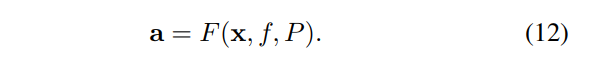

在本节中,我们将深入探讨利用大语言模型(LLMs)进行自动驾驶(AD)决策制定的过程,并探索将LLMs与传统自动驾驶技术相结合的各种方法。目标是全面概述当前最先进的方法,并强调在提升车辆性能、安全性和类人决策能力方面,利用LLMs的潜在优势。自动驾驶决策制定可以表述为一个函数F,该函数将输入数据x映射到输出动作a上,同时考虑以f表示的大语言模型(LLMs)的影响:

其中, 表示来自各种来源的输入数据,如图像、传感器数据、交通规则和人类查询,而f代表大语言模型(LLMs),它处理输入数据并生成输出动作,包括车辆控制、决策制定和推理解释。大型语言模型f可以进一步分解为预训练模型和针对特定自动驾驶任务进行微调的模型:

其中,D表示用于对预训练的大语言模型进行微调的特定领域数据。此外,通过融入提示调整技术(表示为P),可以增强决策制定过程,该技术引导大型语言模型生成更相关、更准确的输出:

考虑一个时间跨度为T的交通场景,其中包含N个智能体(车辆),决策制定过程可以表述为:

其中,表示智能体i在时间t的动作,而表示相应的输入数据。

将大语言模型(LLMs)与自动驾驶(AD)相结合的一种有前景的方法是使用这些模型在动态环境中进行精确的车辆控制和决策制定。Azarafza等人研究了LLMs在分析图像、传感器数据、交通规则和天气条件组合方面的潜力,以提供准确的刹车abrake和油门athrottle控制指令。类似地,Sha等人引入了LanguageMPC,它将LLMs与模型预测控制(MPC)相结合,以处理复杂的驾驶场景。通过将交通场景信息xscene和车辆状态xvehicle提供给LLMs,LanguageMPC生成驾驶意图aintent和MPC参数θ,以实现类人性能。Wang等人设计了一个框架,将LLMs嵌入为车辆的“副驾驶”,以解释人类意图xintent和记忆xmemory,并为特定的驾驶任务选择合适的控制器acontroller。这些发现表明,LLMs可以为复杂场景(如低能见度或长尾交通场景)中的决策提供有价值的见解。

另一种方法侧重于将大语言模型(LLMs)与强化学习(RL)技术相结合,以实现安全且准确的多任务决策制定。Liu等人提出了多任务决策制定生成式预训练Transformer(MTD-GPT)模型,该模型结合了RL和GPT的优势,以同时处理多个驾驶任务。通过在状态-动作-奖励元组{s, a, r}上进行训练并生成决策制定数据序列{s, a},MTD-GPT与单任务决策制定模型相比展示了卓越的性能。此外,LLMs还与数字孪生技术相结合,以增强在模拟环境中的决策制定。Cui等人提出了一个框架,该框架利用LLMs的自然语言能力和上下文理解能力,基于环境信息xenv和个性化提示xprompt为自动驾驶车辆生成动作a。该框架旨在提供个性化辅助和透明的决策制定。

在计算机视觉和自然语言处理领域,Mao等人提出了Agent-Driver,它引入了一个多功能的工具库和认知记忆,以将类似人类的智能集成到自动驾驶系统中。通过处理传感数据xsensory,Agent-Driver为自动驾驶车辆生成动作a,展示了出色的可解释性和少样本学习能力。Mao等人还提出了GPT-Driver,它将运动规划重新表述为语言建模问题。通过将场景描述xscenario表示为语言标记,GPT-Driver通过提示-推理微调策略生成轨迹,识别显著对象,并预测潜在影响。

其他值得注意的贡献包括Zhang等人提出的TrafficGPT,它赋予了LLMs分析交通信息xtraffic并提供驾驶建议和工具选择的能力;Cui等人提出的DriveLLM,它将LLMs与现有的自动驾驶堆栈相结合,用于决策制定中的常识推理;Rajvanshi等人提出的SayNav,它利用3D场景图提示来引导LLMs生成高级导航计划;以及Tanahashi等人的工作,该工作评估了LLMs在自动驾驶场景中的空间推理和遵守规则的能力。

这些研究强调了将大语言模型(LLMs)集成到自动驾驶决策制定中的多种方法和潜在益处。从精确的车辆控制和多任务决策制定到个性化辅助和高效的导航规划,LLMs已经展示了其增强自动驾驶车辆能力的能力。随着该领域研究的不断发展,LLMs与传统自动驾驶技术的融合有望带来更安全、更高效、更人性化的决策制定过程。

端到端自动驾驶

将大型语言模型(LLMs)融入自动驾驶领域,为端到端的决策与控制开辟了新的可能性。包含LLMs的端到端自动驾驶过程可以形式化表述如下:。其中,Dt代表时间步t时的驾驶决策,是输入数据(包括传感器数据、导航信息等),M是记忆组件,P是提示工程,Θ是可学习参数。函数F涵盖了从感知到决策与控制的整个端到端流程。

进一步阐述LLMs组件L,它可以表示为:。其中,是预训练的大语言模型,是针对自动驾驶领域进行微调后的模型,而fprompt则代表用于引导LLMs行为的提示调整技术。

研究人员已经探索了多种将大语言模型(LLMs)集成到自动驾驶系统中的方法,重点关注闭环评估、知识驱动的决策制定以及可解释性等不同方面。

在闭环评估领域,Fu等人介绍了LimSim++,这是一个用于评估由多模态大型语言模型((M)LLM)驱动的自动驾驶的平台。LimSim++将场景描述xDs、任务描述xTd、导航信息xNi、视觉内容xVc、道路网络xRn和车辆信息xVi作为输入,并生成驾驶决策aDd、轨迹aT和控制信号aCs。类似地,Jin等人提出了SurrealDriver,它将LLMs与CARLA模拟器相结合,以自车状态xSego和周围状态xSsur为输入,并为CARLA程序生成JSON格式的命令aCCARLA。Tian等人介绍了VistaGPT,这是一个使用LLMs构建模块化端到端自动驾驶系统的框架,它以提示xP和自动驾驶模块xMAD为输入,并生成原子自动驾驶模型aMatom。Wang等人提出了DriveMLM,这是一个基于LLM的框架,它在实际模拟器中执行闭环自动驾驶,以图形(xF)、系统消息xSm和用户指令xUi为输入,并生成低级决策aDl和解释aE。Shao等人提出了LMDrive,这是一个由语言引导、端到端、闭环的自动驾驶框架,它以相机-激光雷达传感器数据xDCL和驾驶指令xId为输入,并生成车辆控制信号aCs。

几项研究已经聚焦于将大语言模型(LLMs)与基于视觉的自动驾驶框架相结合。Pan等人提出了VLP(Vision-Language-Planning),该模型利用语言模型来弥合语言理解与自动驾驶之间的鸿沟。VLP以鸟瞰图(BEV)特征为输入,包括标签xL、边界框xB、自我车辆轨迹xTego以及其他agent的轨迹xTagents,并生成增强的BEV特征表示aFBEV,以改善推理和规划。Tian等人介绍了DriveVLM,它利用视觉-语言模型(VLMs)和思维链(CoT)进行分层规划,以图像序列xIs为输入,并生成元动作aAm、决策aD和路径点aW。

知识驱动的决策制定是另一个研究兴趣点。Wen等人提出了DiLu框架,该框架利用大语言模型(LLMs)为自动驾驶注入知识驱动的能力。DiLu以场景描述向量xVsd为输入,并输出加速aAacc、怠速aAid和减速aAdec动作。Fu等人探索了LLMs在类人自动驾驶中的应用,以环境观测xOe为输入,并生成离散的元动作aAm。

研究人员还解决了可解释性和透明度的问题。Wang等人介绍了DriveMLM,这是一个基于LLM的自动驾驶框架,它将LLM的决策与行为规划模块对齐。DriveMLM接受多模态输入,如图像xI、点云xP、交通规则xTr、系统消息xSm和用户指令xUi,并生成决策状态aDs和解释aE。

Han等人提出了DME-Driver系统,该系统使用强大的视觉-语言模型来模拟可解释的决策和控制,以当前和之前的场景图像xIc、xIp、提示xP和车辆状态xSv为输入,并生成类人逻辑aLh、关注区域aFa、场景描述aDs、推理aR、决策aD和控制信号aCs。

结论和讨论

本综述全面回顾了将大语言模型(LLMs)集成到基于知识的自动驾驶(AD)系统中的最新进展。首先追溯了自动驾驶系统的发展历程,从基于规则和优化的方法到基于学习的技术。然后,介绍了LLMs的关键特性和训练方案,这些特性和方案使它们能够作为自动驾驶系统的知识库和推理引擎。通过将现有工作分为模块化自动驾驶流程和端到端自动驾驶系统,我们详细分析了LLMs如何增强场景理解、动作规划和人机交互,从而填补数据驱动的人工智能与类人自动驾驶之间的差距。与传统自动驾驶方法相比,基于LLMs的方法在复杂场景中的适应性更强,对新环境的泛化能力也更强,在安全性和效率方面有可能超越人类驾驶员。

然而,LLMs在自动驾驶中的应用并非没有挑战。首先,LLMs的推理速度和计算成本需要得到显著优化,以满足自动驾驶系统的实时性要求。其次,在将基于LLMs的决策部署到安全关键的自动驾驶任务之前,必须对其安全性、鲁棒性和可解释性进行严格验证。此外,由于LLMs是在大规模在线语料库上训练的,它们可能会继承社会偏见并产生与人类价值观不符的输出,从而引发需要解决的伦理问题。

零基础如何学习大模型 AI

领取方式在文末

为什么要学习大模型?

学习大模型课程的重要性在于它能够极大地促进个人在人工智能领域的专业发展。大模型技术,如自然语言处理和图像识别,正在推动着人工智能的新发展阶段。通过学习大模型课程,可以掌握设计和实现基于大模型的应用系统所需的基本原理和技术,从而提升自己在数据处理、分析和决策制定方面的能力。此外,大模型技术在多个行业中的应用日益增加,掌握这一技术将有助于提高就业竞争力,并为未来的创新创业提供坚实的基础。

大模型实际应用案例分享

①智能客服:某科技公司员工在学习了大模型课程后,成功开发了一套基于自然语言处理的大模型智能客服系统。该系统不仅提高了客户服务效率,还显著降低了人工成本。

②医疗影像分析:一位医学研究人员通过学习大模型课程,掌握了深度学习技术在医疗影像分析中的应用。他开发的算法能够准确识别肿瘤等病变,为医生提供了有力的诊断辅助。

③金融风险管理:一位金融分析师利用大模型课程中学到的知识,开发了一套信用评分模型。该模型帮助银行更准确地评估贷款申请者的信用风险,降低了不良贷款率。

④智能推荐系统:一位电商平台的工程师在学习大模型课程后,优化了平台的商品推荐算法。新算法提高了用户满意度和购买转化率,为公司带来了显著的增长。

…

这些案例表明,学习大模型课程不仅能够提升个人技能,还能为企业带来实际效益,推动行业创新发展。

学习资料领取

如果你对大模型感兴趣,可以看看我整合并且整理成了一份AI大模型资料包,需要的小伙伴文末免费领取哦,无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

部分资料展示

一、 AI大模型学习路线图

整个学习分为7个阶段

二、AI大模型实战案例

涵盖AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,皆可用。

三、视频和书籍PDF合集

从入门到进阶这里都有,跟着老师学习事半功倍。

如果二维码失效,可以点击下方链接,一样的哦

【CSDN大礼包】最新AI大模型资源包,这里全都有!无偿分享!!!

😝朋友们如果有需要的话,可以V扫描下方二维码联系领取~

1760

1760

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?