点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【目标检测】技术交流群

后台回复【3D检测综述】获取最新基于点云/BEV/图像的3D检测综述!

摘要

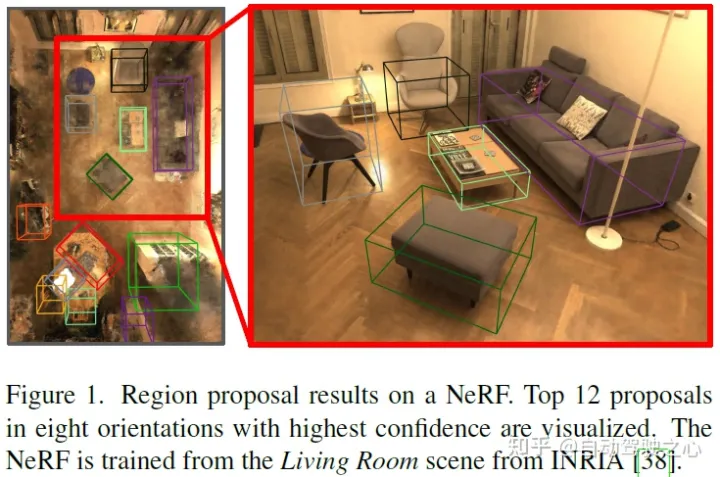

本文介绍了首个基于NeRF的通用目标检测框架NeRF-RPN。给定预先训练的NeRF模型,NeRF-RPN旨在检测场景中目标的所有边界框。通过利用结合多尺度3D神经体积特征的新颖体素表示,论文证明了可以直接回归NeRF中目标的3D边界框,而无需在任何视点渲染NeRF。NeRF-RPN是一个通用框架,可用于检测没有类标签的目标。论文使用各种主干架构、RPN头设计和损失函数对NeRF-RPN进行了实验。所有这些都可以以端到端的方式进行训练,以估计高质量的3D边界框。为了促进NeRF目标检测的未来研究,论文构建了一个新的基准数据集,该数据集由合成数据和真实数据组成,并进行了仔细的标记和清理。

总结来说,本文的主要贡献如下:

首次将RPN引入NeRF用于3D目标检测和相关任务;

基于现有合成室内数据集Hypersim[46]和3D-FRONT[11]以及真实室内数据集ScanNet[5]和SceneNN[19],为NeRF训练精心策划的用于3D目标检测的大型公共室内NeRF数据集;

NeRF-RPN在各种主干网络、检测头和损失函数上的实现和比较。论文的模型可以在4小时内使用2个NVIDIA RTX3090 GPU进行训练。在运行时,它可以在115ms内处理给定的NeRF场景(不包括后处理),同时在3D-FRONT NeRF数据集上实现99%的召回率;

演示基于NeRF-RPN的NeRF和相关应用的3D目标检测。

方法

与最初的RPN类似,论文的方法有两个主要组件,见图2。第一个由特征提取器组成,该提取器将从NeRF模型采样的原始辐射亮度和密度体素网格作为输入,并生成特征金字塔作为输出。第二个是RPN本身,它在特征金字塔上运行并生成目标proposal。随后可以提取特征金字塔上对应于proposal的体积,并针对任何下游任务进行进一步处理。论文的方法在NeRF输入特征的形式以及特征提取器和RPN模块的网络架构方面是灵活的,可以适用于多个下游任务。

NeRF的输入采样

论文的方法假设提供了具有合理质量模型的完全训练的NeRF模型。第一步是对其辐射亮度和密度信息进行均匀采样,以构建特征体积。尽管自原始NeRF以来存在大量变体,这些变体采用不同的辐射场表示或结构,但它们具有相同的特性,即可以通过视图方向和空间位置查询重建的辐射和密度。由于在类似的体积渲染过程中基本上使用了辐射亮度和密度,论文的方法使用从NeRF查询的辐射亮度场和密度作为输入,因此NeRF-RPN与现有的NeRF表示变体无关。

论文在覆盖NeRF模型的全部可追踪体积的网格上均匀地采样辐射亮度和密度。可追踪范围是通过略微放大包围场景中所有摄影机和目标的边界框来确定的。每个维度中栅格的分辨率与该维度中可追踪体积的长度成比例,从而保持目标的纵横比。对于使用普通RGB表示辐射度的NeRF模型,论文从相机姿态中使用的相同观察方向进行采样,以训练NeRF并对结果进行平均。如果这样的相机姿势未知,论文将从球体均匀采样方向。通常,每个体素处的样本呈 的形式,其中 是平均辐射亮度,并根据密度 进行转换:

特征提取

给定原始数据网格,特征提取器将生成特征金字塔。论文在实验中采用了三个主干网:VGG[54]、ResNet[18]和Swin Transformer[30],但其他主干网也可能适用。考虑到室内NeRF场景的目标大小的巨大变化以及不同NeRF场景之间的尺度差异,论文结合了FPN[24]结构来生成多尺度特征,并增强高分辨率特征量中的高级语义信息。对于VGG、ResNet和FPN层,将所有2D卷积、池和归一化层替换为其3D对应层。对于Swin Transformer,论文相应地采用了3D位置嵌入和移动窗口。

3D RPN

论文的3DRPN将特征提取器的特征金字塔作为输入,并输出一组定向边界框(OBB)及其相应的目标分数。与大多数3D目标检测工作一样,论文仅将边界框的旋转约束到世界空间z轴,该轴与世界空间重力向量对齐并垂直于地面。论文为RPN试验了两种类型的region proposal方法:基于锚的方法和无锚的方法,见图3。

整体损失函数如下:

其他损失函数

Objectness Classification:

2D Projection Loss:

用于3D目标检测的NeRF数据集

尚未为3D目标检测构建具有代表性的NeRF数据集。因此,论文利用Hypersim[46]和3D-FRONT[11]数据集构建了第一个用于3D目标检测的NeRF数据集。除了这些合成数据集,论文还结合了SceneNN[19]和ScanNet[5]的真实世界数据集的子集,以证明本文的方法对真实世界数据具有鲁棒性。图5显示了一些选定示例。表1总结了数据集。

实验

可视化结果:

结论

论文为NeRF提出了第一个重要的3D目标检测框架,即NeRF-RPN,它对从NeRF提取的体素表示进行操作。通过对不同的主干网络(即VGG、ResNet、Swin Transformer以及基于锚的、无锚的RPN头和多个损失函数)进行综合实验,论文验证了NeRF-RPN可以直接从NeRF回归高质量的框,而无需在任何视图中渲染NeRF的图像。为了促进NeRF中3D目标检测的未来工作,论文构建了一个新的基准数据集,该数据集由合成数据和真实数据组成,具有高NeRF重建质量和仔细的边界框标记和清理。我们希望NeRF-RPN将成为一个很好的基线,可以启发和支持未来在NeRF中进行3D物体检测的工作。

参考

[1] NeRF-RPN: A general framework for object detection in NeRFs

【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、硬件配置、AI求职交流等方向;

添加汽车人助理微信邀请入群

备注:学校/公司+方向+昵称

NeRF-RPN是首个将区域提议网络(RPN)引入NeRF(神经辐射场)的通用3D目标检测框架。该框架直接从NeRF的3D体积特征中回归目标边界框,无需额外的图像渲染。通过实验,论文展示了NeRF-RPN在不同主干网络、RPN头和损失函数上的有效性,并构建了一个新的室内NeRF数据集用于3D目标检测。这种方法能在115ms内处理NeRF场景,同时保持高召回率。

NeRF-RPN是首个将区域提议网络(RPN)引入NeRF(神经辐射场)的通用3D目标检测框架。该框架直接从NeRF的3D体积特征中回归目标边界框,无需额外的图像渲染。通过实验,论文展示了NeRF-RPN在不同主干网络、RPN头和损失函数上的有效性,并构建了一个新的室内NeRF数据集用于3D目标检测。这种方法能在115ms内处理NeRF场景,同时保持高召回率。

446

446

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?