Relation-Shape Convolutional Neural Network for Point Cloud Analysis

Authors

Abstract

- 点云分析非常具有挑战性,因为很难捕获隐含在不规则点中的形状。

- 在本文中,提出了RS-CNN,即关系形状卷积神经网络,它将规则网格CNN扩展到不规则配置,以进行点云分析。

- RS-CNN的关键是从关系中学习,即点之间的几何拓扑约束。

- 具体地,局部点集的卷积权重从该点集的采样点与其他点之间的预定义几何先验中学习高级关系表达式。以此方式,可以获得具有明确的关于点的空间布局的推理的归纳局部表示,这导致了很多形状感知和鲁棒性。使用这种卷积作为RS-CNN的基本运算符,可以开发出层次结构来实现上下文形状感知学习,以进行点云分析。

- 通过在三个任务上进行具有挑战性的基准测试的广泛实验,证明RS-CNN达到了最新水平。

(一)Introduction

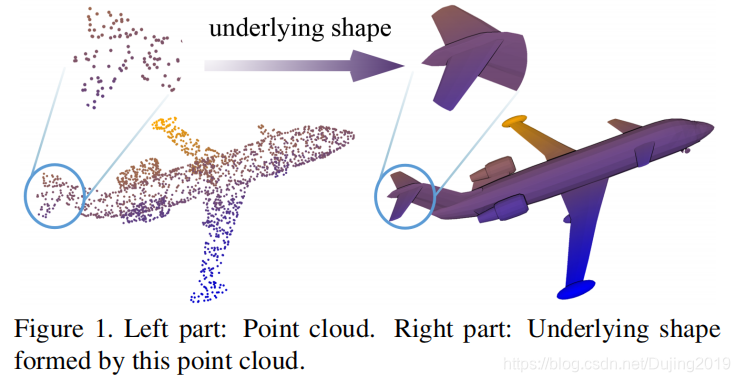

对3D点云的分析非常具有挑战性,因为很难推断出由这些不规则点形成的基本形状(图1)。

通常,从点集 P ⊂ R 3 P\subset R^{3} P⊂R3进行学习主要面临三个挑战:

- P P P是无序的,因此要求学习的表示是置换不变的;

- P P P分布在3D几何空间中,因此要求学习的表示形式对刚性变换(例如旋转和平移)具有鲁棒性;

- P P P构成一个基本形状,因此,学习到的表示应具有判别性形状意识。

问题(1)已通过对称函数得到了很好的解决,而(2)和(3)仍然要求全面探索。这项工作的目标是将常规网格CNN扩展到不规则配置,以便一起处理这些问题。

为此,我们提出了一种关系形状卷积神经网络(别名为RS-CNN)。 RS-CNN的关键是从关系中学习,即点之间的几何拓扑约束,我们认为这可以在3D点云中编码有意义的形状信息。

- 每个局部卷积邻域都是通过将采样点x作为质心来构造,周围的点作为其邻居 N ( x ) N\left ( x\right ) N(x)。

- 卷积权重从预定义的几何先验中学习高级关系表达式,即 x x x和 N ( x ) N\left ( x\right ) N(x)之间的直观低级关系。通过以这种方式进行卷积,可以获得具有关于点的空间布局的明确推理的归纳表示。它可辨别地反映不规则点形成的潜在形状,因此可以识别形状。此外,它可以受益于几何先验,包括对点置换的不变性和对刚性变换(例如,平移和旋转)的鲁棒性。

- 通过将卷积作为基本运算符,可以开发类似于CNN的分层体系结构,即RSCNN,以实现上下文形状感知学习以进行点云分析。

主要的贡献如下:

- 提出了一种新的从关系中学习卷积算子,称为关系形卷积。它可以显式地编码点的几何关系,从而获得更多的形状意识和鲁棒性;

- 提出了一种具有关系形状卷积的深层次结构,即RS-CNN。它可以将规则的网格CNN扩展到不规则的配置,以实现点云的上下文形状感知学习;

- 跨三个任务在具有挑战性的基准上进行了广泛的实验,以及详尽的经验和理论分析,证明RS-CNN达到了最先进的水平。

(二)Related Work

View-based and volumetric methods. 基于视图的方法将3D形状表示为来自不同角度的一组2D视图。

- 通常会微调经过预先训练的基于图像的体系结构以进行准确识别。

- 但是,2D投影可能会由于自遮挡而导致形状信息丢失,并且通常需要大量视图才能获得良好的性能。

- 体素方法将输入的3D形状转换为常规3D网格,可以在其上使用经典的CNN 。

- 主要限制是由于3D网格强制执行的低分辨率而导致形状的量化损失。最近的空间划分方法,例如K-d树或八叉树挽救了一些分辨率问题,但仍然依赖于边界体积的细分而不是局部几何形状。

- 与这些方法相比,我们的工作旨在直接处理3D点云。

Deep learning on point cloud.

- PointNet [26]通过在每个点上独立学习并通过最大池收集最终特征来开创了这条路线。然而,这种设计忽略了本地结构,事实证明,局部结构对于CNN的成功至关重要。

- PointNet ++ [28]建议将PointNet分层应用到点云。

- Superpoint [20]提出将点云划分为几何元素。

- 图卷积网络应用于由相邻点创建的局部图。

小结: 这些方法没有显式地建模点的局部空间布局,因此获得的形状感知较少。相比之下,这篇论文通过学习点之间的高级关系表达式来捕获点的空间布局。

一些论文将点云映射到高维空间,以促进经典CNN的应用。

- SPLA TNet 将输入点映射到稀疏网格上,然后使用双边卷积进行处理。

- PCNN将点云上的函数扩展为环境空间上的连续体积函数。

小结: 这些方法可能会导致几何信息丢失,而我们的方法直接在点云上运行而不会引起这种丢失。

另一个关键问题是点云的不规则性。

- 一些论文着重于分析与点集学习等价的对称函数。

- 一些论文开发了对齐网络,以增强3D空间中刚性转换的鲁棒性。但是,对齐学习是此问题的次佳解决方案

- 一些传统的描述符(例如快速点特征直方图)对于平移和旋转可能是不变的,但是对于高层形状理解而言,它们通常效率较低。

小结: 这篇论文学习点之间的几何关系的方法因此对刚性变换很鲁棒。

Relation learning.

- DGCNN通过学习高维特征空间中的点关系来捕获相似的局部形状。

小结: DGCNN这种关系在某些情况下可能不可靠。 这篇论文从3D空间中的几何先验学习高级关系表达式,并执行上下文局部到全局形状学习。

(三)Shape-Aware Representation Learning

点云分析的核心是判别性地表示底层形状,并具有鲁棒性。这篇论文通过使用新颖的关系形状卷积(RS-Conv)将规则网格CNN扩展到不规则配置,来学习针对此目标的上下文形状感知表示。

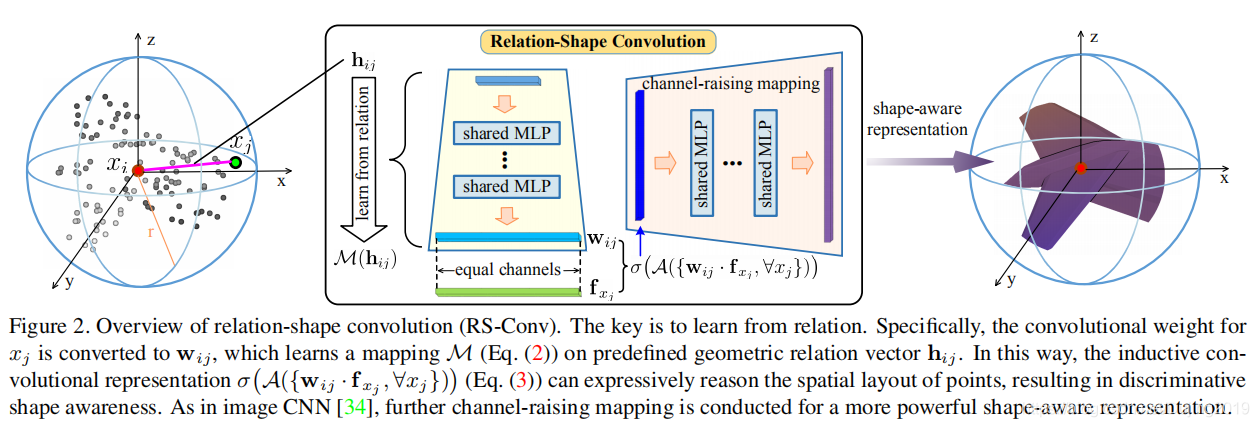

3.1. Relation-Shape Convolution

局部到全局学习在图像CNN中获得了巨大的成功,但是,它非常依赖于从不规则点子集中进行形状感知的归纳学习,这仍然是一个非常棘手的问题。

Modeling. 为了克服这个问题,这篇论文将局部点子集 P s u b ⊂ R 3 P_{sub}\subset R^{3} Psub⊂R3建模为球面邻域,其中采样点 x i x_i xi为质心,周围的点为邻居 x j ∈ N ( x i ) x_{j}\in N\left ( x_{i}\right ) xj∈N(xi)。

图2的最左侧部分说明了此建模。目标是学习该邻域的归纳表示 f P s u b f_{P_{sub}} fPsub,其应有区别地编码基础形状信息。

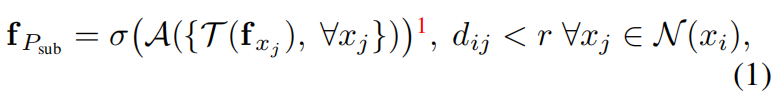

为此,将一般的卷积运算表述为

- x x x是3D点, f f f是特征向量。

- d i j d_{ij} dij是 x i x_i xi和 x j x_j xj之间的欧几里得距离, r r r是球体半径。

- f P s u b f_{P_{sub}} fPsub是通过首先使用函数 τ \tau τ转换 N ( x i ) N\left ( x_{i}\right ) N(x

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1041

1041

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?