✅****我是一粟,专注于智能驾驶大模型,持续分享LLM面试干货。

✅****大模型1v1辅导,已帮助多名同学成功上岸

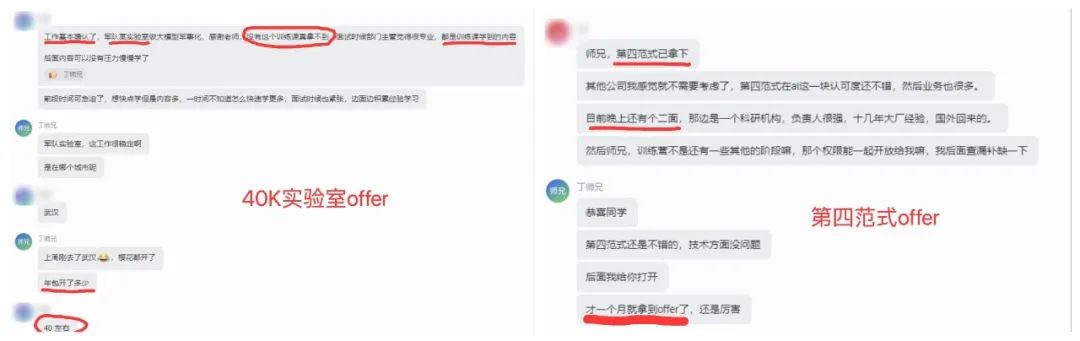

offer捷报

金三银四春招季,又有两位训练营同学斩获大模型offer!一个是40k某军实验室offer,另一个是第四范式~恭喜两位同学成功上岸!

随着DeepSeek爆火,面试中也越来越高频出现,因此训练营也更新了DeepSeek系列技术的深入拆解。包括MLA、MTP、专家负载均衡、FP8混合精度训练,Dual-Pipe等关键技术,力求做到全网最硬核的解析~

在进行实践 GRPO 的时候,发现现存占用过大,deepseed 一键 VLLM 安装常常与 cuda 不适配,因此尝试一直采样 lora 小参数微调,环境要求更低的方式进行 GRPO 实践。

GRPO + LoRA 代码实践:一套高效训练大模型的最小实现。

本文将分享如何使用 LoRA 对大语言模型进行高效参数微调,并结合 GRPO 奖励优化方法,实现一个完整的“奖励微调”训练流程。

本文以 Qwen2.5-3B-Instruct 为例,附完整可运行代码。

01

背后思路

在训练大语言模型时,我们通常面临两个问题:

- 模型太大,无法全参数微调;

- 传统监督微调不足以优化输出质量。

本实践结合两种轻量且高效的技术路线:

- 使用 LoRA 对少量注意力层参数进行低秩更新,节省显存;

- 使用 GRPO 奖励优化训练(RLHF),鼓励输出结构正确、答案准确。

02

环境准备

import sys, types, importlib.machinerybnb_name = "bitsandbytes"spec = importlib.machinery.ModuleSpec(name=bnb_name, loader=None, is_package=True)bnb = types.ModuleType(bnb_name)bnb.__spec__ = specbnb.__path__ = []bnb.__version__ = "0.0.0"nn_name = bnb_name + ".nn"nn_spec = importlib.machinery.ModuleSpec(name=nn_name, loader=None, is_package=True)bnb_nn = types.ModuleType(nn_name)bnb_nn.__spec__ = nn_specbnb_nn.__path__ = []class Linear4bit: passclass Linear8bitLt: passbnb_nn.Linear4bit = Linear4bitbnb_nn.Linear8bitLt = Linear8bitLtbnb.nn = bnb_nnsys.modules[bnb_name] = bnbsys.modules[nn_name] = bnb_nn

****说明:****定义 bitsandbytes 中的 mock 类,用于绕过安装依赖。

03

数据加载与预处理

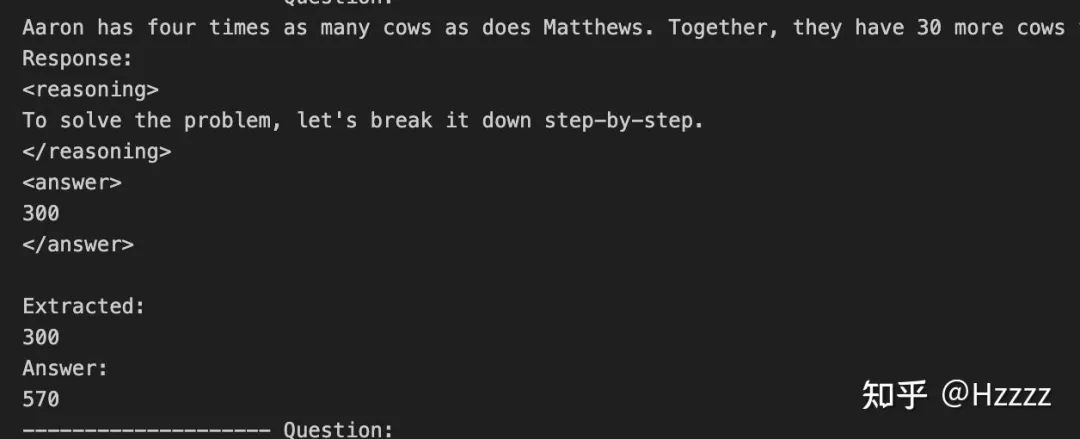

from datasets import load_datasetimport reSYSTEM_PROMPT = "你是一个擅长用 XML 格式输出链式思考和答案的数学助理,使用这种格式进行回答<reasoning>...</reasoning>\n<answer>...</answer>"def extract_final_answer(text: str) -> str: match = re.search(r'####\s*(\d+)', text) if match: return match.group(1).strip() match = re.search(r'\\boxed\{(.*?)\}', text) if match: return match.group(1).strip() return ""def preprocess(example): return { "prompt": [ {"role": "system", "content": SYSTEM_PROMPT}, {"role": "user", "content": example["question"]}, ], "answer": extract_final_answer(example["answer"]), }raw = load_dataset("gsm8k", "main", split="train")dataset = raw.map(preprocess, remove_columns=raw.column_names)

**说明:**加载 HuggingFace 上的 gsm8k 数学问答数据集,用于训练微调。

使用正则表达式提取答案中 #### 后面的数字,作为最终答案。加载 HuggingFace 上的 gsm8k 数学问答数据集,用于训练微调。

04

模型加载与 LoRA 挂载

from transformers import AutoTokenizer, AutoModelForCausalLMfrom peft import LoraConfig, get_peft_modelfrom modelscope import snapshot_downloadimport torchMODEL_ID = "Qwen/Qwen2.5-3B-Instruct"OUTPUT_DIR = "outputs/qwen3b-grpo-lora-fp16"DEVICE_ID = 0torch.cuda.set_device(DEVICE_ID)local_path = snapshot_download(MODEL_ID)tokenizer = AutoTokenizer.from_pretrained(local_path, trust_remote_code=True)tokenizer.pad_token = tokenizer.eos_tokenbase_model = AutoModelForCausalLM.from_pretrained( local_path, torch_dtype=torch.float16, device_map="auto", trust_remote_code=True,)base_model.gradient_checkpointing_enable()lora_cfg = LoraConfig( r=16, lora_alpha=32, lora_dropout=0.05, bias="none", task_type="CAUSAL_LM", target_modules=[ "q_proj", "k_proj", "v_proj", "o_proj", "gate_proj", "up_proj", "down_proj", ],)model = get_peft_model(base_model, lora_cfg)model.print_trainable_parameters()

****说明:****定义 LoRA 的配置,包括秩 r、dropout、目标模块等。通过 modelscope 下载 Qwen2.5 模型文件至本地。

通过 modelscope 下载 Qwen2.5 模型文件至本地。定义 LoRA 的配置,包括秩 r、dropout、目标模块等。

05

奖励函数设计(GRPO 核心)

import redef extract_xml_answer(text: str) -> str: match = re.search('<answer>(.*)</answer>', text, re.DOTALL) return match.group(1).strip() if match else ""def correctness_reward_func(prompts, completions, answer, **kwargs) -> list[float]: responses = [completion[0]['content'] for completion in completions] extracted = [extract_xml_answer(r) for r in responses] return [1.0 if a in r else 0.0 for r, a in zip(extracted, answer)]def soft_format_reward_func(completions, **kwargs) -> list[float]: pattern = r"<reasoning>.*?</reasoning>\s*<answer>.*?</answer>" responses = [c[0]["content"] for c in completions] return [2.0 if re.search(pattern, r, re.DOTALL) else 0.0 for r in responses]def strict_format_reward_func(completions, **kwargs) -> list[float]: pattern = r"^\s*<reasoning>.*?</reasoning>\s*<answer>.*?</answer>\s*$" responses = [c[0]["content"] for c in completions] return [4.0 if re.search(pattern, r, re.DOTALL) else 0.0 for r in responses]

06

启动 GRPO 训练

from trl import GRPOConfig, GRPOTrainertrain_args = GRPOConfig( fp16=True, per_device_train_batch_size=16, gradient_accumulation_steps=8, learning_rate=2e-4, num_train_epochs=1, lr_scheduler_type="cosine", warmup_ratio=0.05, max_grad_norm=0.3, logging_steps=1, save_steps=100, output_dir=OUTPUT_DIR, report_to="tensorboard", max_prompt_length=512, max_completion_length=64, num_generations=8, use_vllm=False,)trainer = GRPOTrainer( model=model, processing_class=tokenizer, reward_funcs=[ soft_format_reward_func, strict_format_reward_func, correctness_reward_func ], args=train_args, train_dataset=dataset,)trainer.train()

**说明:**定义 GRPO 训练参数,例如 batch size、学习率、日志步数等。定义 GRPO 训练参数,例如 batch size、学习率、日志步数等。

构建 GRPOTrainer 实例,接收模型、tokenizer、奖励函数和训练集。启动 GRPO 微调训练过程。

07

模型保存

model.save_pretrained(OUTPUT_DIR)tokenizer.save_pretrained(OUTPUT_DIR)print(f"✔ LoRA Adapter + Tokenizer 已保存到 {OUTPUT_DIR}")

**说明:**保存训练后的 LoRA 模型和 tokenizer。

08

总结

通过这次实战,我们构建了一个完整的 Qwen2.5 + LoRA + GRPO 套件:

- 高效加载与处理数据

- 轻量 LoRA 微调

- 多奖励 GRPO 策略优化输出

- 可复用、可部署的训练脚本

09

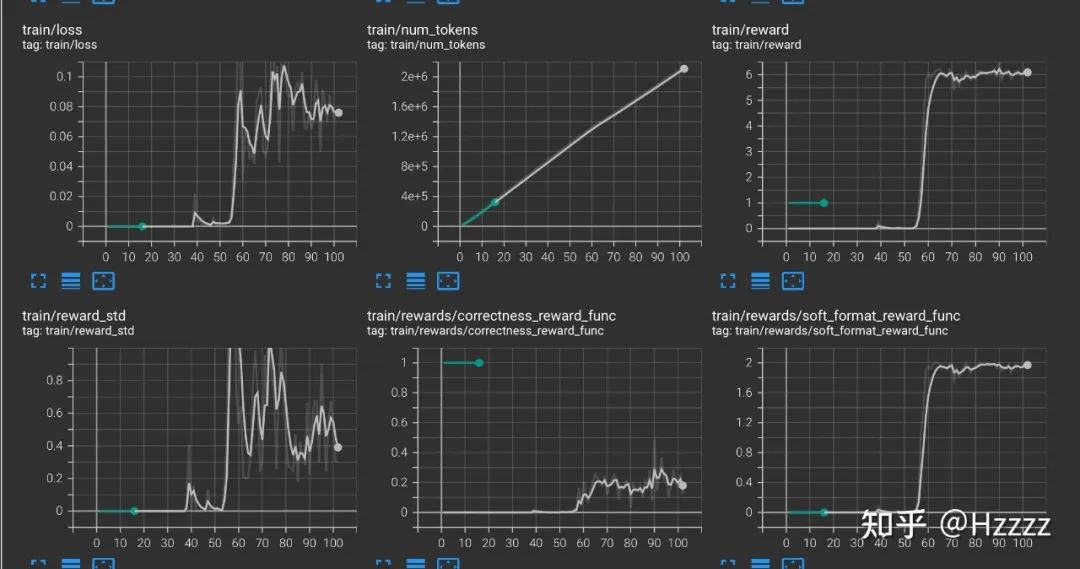

运行效果

运行效果如下图:

``

**说明:**保存训练后的 LoRA 模型和 tokenizer。

08

总结

通过这次实战,我们构建了一个完整的 Qwen2.5 + LoRA + GRPO 套件:

- 高效加载与处理数据

- 轻量 LoRA 微调

- 多奖励 GRPO 策略优化输出

- 可复用、可部署的训练脚本

09

运行效果

运行效果如下图:

[外链图片转存中…(img-5wRbBwa7-1746267614692)]

如何学习AI大模型?

大模型的发展是当前人工智能时代科技进步的必然趋势,我们只有主动拥抱这种变化,紧跟数字化、智能化潮流,才能确保我们在激烈的竞争中立于不败之地。

那么,我们应该如何学习AI大模型?

对于零基础或者是自学者来说,学习AI大模型确实可能会感到无从下手,这时候一份完整的、系统的大模型学习路线图显得尤为重要。

它可以极大地帮助你规划学习过程、明确学习目标和步骤,从而更高效地掌握所需的知识和技能。

这里就给大家免费分享一份 2025最新版全套大模型学习路线图,路线图包括了四个等级,带大家快速高效的从基础到高级!

如果大家想领取完整的学习路线及大模型学习资料包,可以扫下方二维码获取

👉2.大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。(篇幅有限,仅展示部分)

大模型教程

👉3.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(篇幅有限,仅展示部分,公众号内领取)

电子书

👉4.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(篇幅有限,仅展示部分,公众号内领取)

大模型面试

**因篇幅有限,仅展示部分资料,需要的扫描下方二维码领取 **

283

283

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?