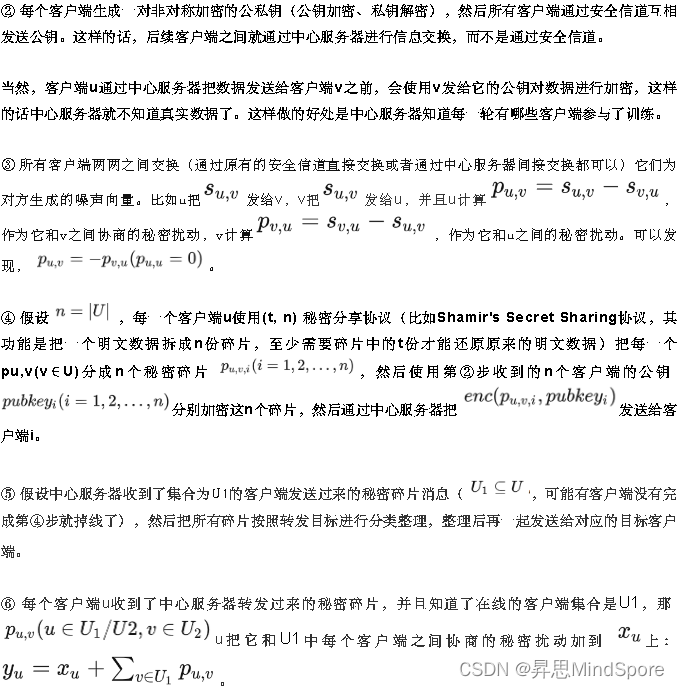

在上一节《联邦学习 | 基于加噪的隐私保护算法》我们讲到了可以使用差分隐私训练算法来保护数据隐私,并且其主要的原理是对敏感数据(模型的权重或更新的梯度)进行加噪来隐藏真实的值。确定加噪的多少也是一个技术活,如果加噪太多,隐私保护效果会很好,但是模型训练可能不收敛;如果加噪太少,隐私保护效果可能不太好。那么有没有办法使得模型训练精度不受影响的同时,数据隐私也不泄露呢?

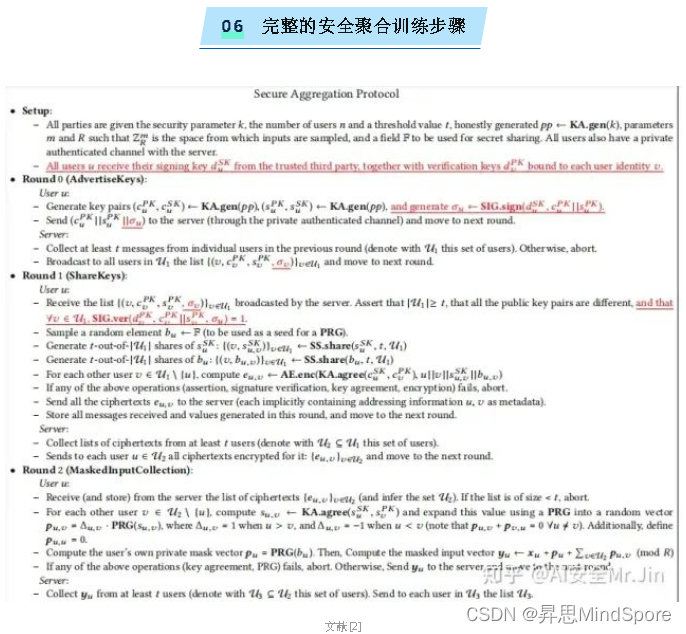

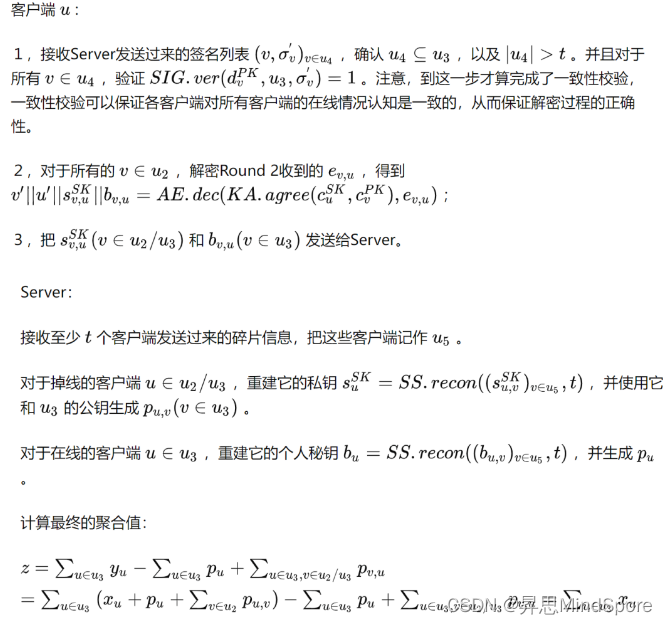

还真有,那就是这次讲的基于密码学的“安全聚合训练”[1][2]。安全聚合训练的总流程比较复杂,我们接下来从最简单的场景逐步分析。(想直接看完整流程的同学可以跳到第6小节哦!)

参考

-

Practical Secure Aggregation for Federated Learning on User-Held Data

https://arxiv.org/pdf/1611.04482.pdf

-

Practical Secure Aggregation for Privacy-Preserving Machine Learning

https://dl.acm.org/doi/pdf/10.1145/3133956.3133982

2088

2088

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?