| 论文标题 | GhostNetV2: Enhance Cheap Operation with Long-Range Attention |

|---|---|

| 论文作者 | Yehui Tang, Kai Han, Jianyuan Guo, Chang Xu, Chao Xu, Yunhe Wang |

| 发表日期 | 2022年11月01日 |

| GB引用 | > Yehui Tang, Kai Han, Jianyuan Guo, et al. GhostNetV2: Enhance Cheap Operation with Long-Range Attention[J].Advances in Neural Information Processing Systems (NIPS), 2022, 35: 9969-9982. |

| DOI | 10.48550/arXiv.2211.12905 |

论文地址:https://arxiv.org/pdf/2211.12905

摘要

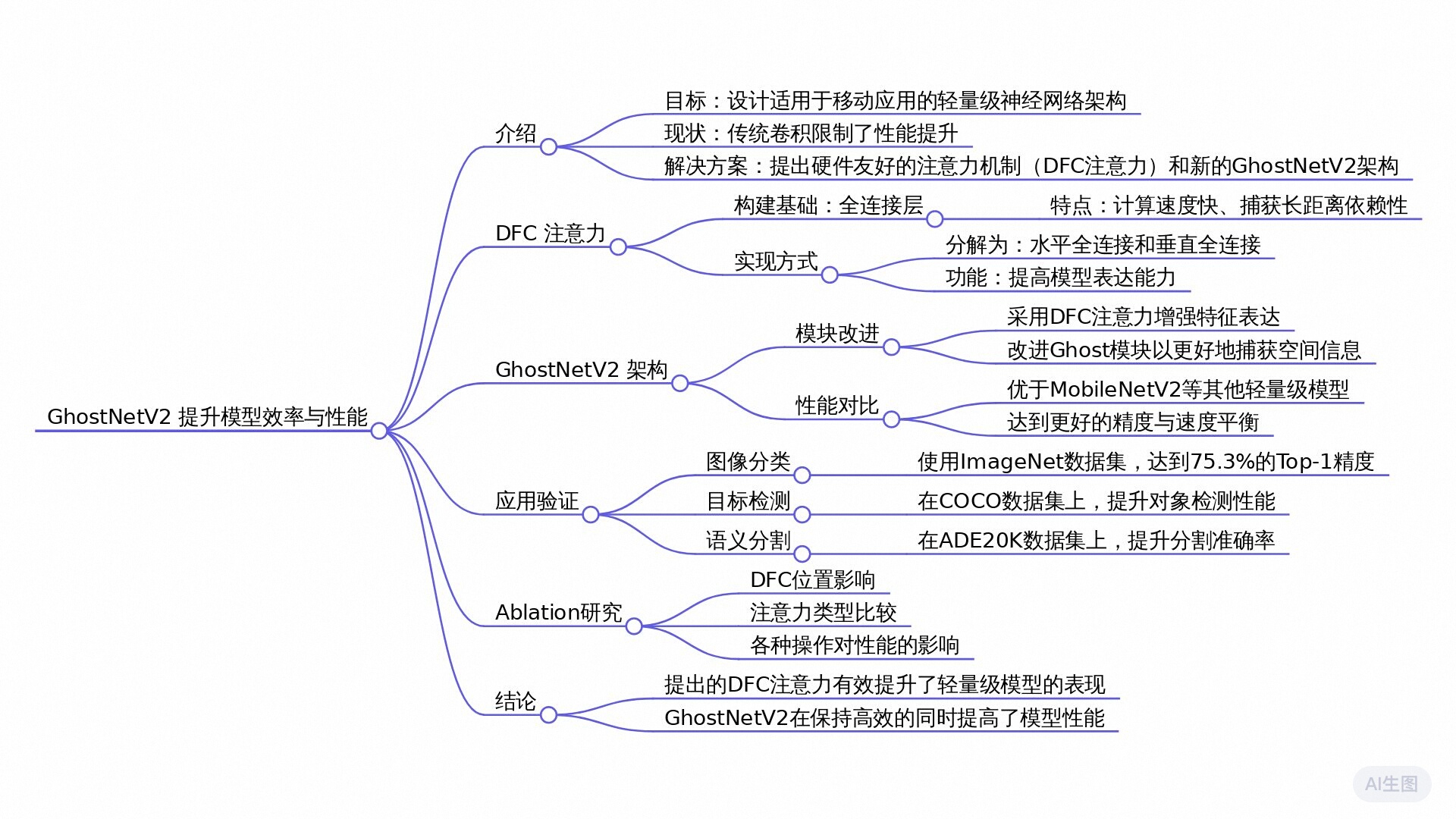

本文提出了一种硬件友好的注意力机制(称为DFC注意力),用于轻量级卷积神经网络(CNN),以捕捉长距离空间信息,同时保持高效的实现。该机制通过分解全连接层为水平和垂直方向,简化了计算过程,降低了复杂度。基于此,作者提出了GhostNetV2架构,增强了模型的表达能力。实验结果显示,GhostNetV2在ImageNet数据集上实现了75.3%的Top-1准确率,显著优于GhostNetV1(74.5%),并且在保持较高准确率的同时,具有更快的推理速度。

全文摘要

这篇论文介绍了一种新的轻量级神经网络架构——GhostNetV2及其独特的注意力机制——DFC注意力。随着移动设备对深度学习模型效率需求的增加,如何在保持高准确率的同时降低计算量和延迟成为了一个重要课题。

论文的核心主题是通过引入DFC注意力机制来增强传统卷积神经网络模型的长距离信息捕捉能力。传统的卷积操作仅能捕获局部信息,而自注意力机制虽然能够获取全局信息,但会显著增加计算复杂度,尤其在移动设备上表现不佳。DFC注意力机制使用了一种简化的方法,它通过完全连接层的分解处理,以更低的计算成本同时捕获长距离像素间的依赖关系,兼顾了性能和效率。

GhostNetV2在GhostNet的基础上进行增强,以DFC注意力模块替代原有的部分卷积操作,从而提高模型表达能力。实验结果显示,GhostNetV2在ImageNet数据集上以167M的FLOPs达到了75.3%的Top-1准确率,超越了之前的GhostNet V1(74.5%)在相似计算成本下的表现。

总的来说,这项研究通过设计一个高效的长距离注意力机制为轻量级卷积神经网络提供了新的思路,显著推动了移动设备上深度学习模型的应用和发展的可能性。GhostNetV2在准确率与计算效率之间取得了有效的平衡,为资源受限设备上的视觉任务提供了更为强大的解决方案。

研究问题

如何设计一种既能在轻量级卷积神经网络中有效捕捉长程依赖关系,又能保持高效硬件实现的注意力机制?

研究方法

实验研究:

在本研究中,作者提出了硬件友好的DFC注意力机制,并通过实验验证了其在提高轻量级卷积神经网络表达能力方面的有效性。实验包括对比GhostNetV2与其他现有架构的性能,如在ImageNet数据集上的表现(表2、图1和图2)。此外,还进行了消融实验,探讨了DFC注意力在不同位置、不同大小核以及不同缩放函数下的影响(表7、表6、表9)。

研究思路

论文标题为《GhostNetV2: Enhance Cheap Operation with Long-Range Attention》,其研究思路主要集中在提升轻量级卷积神经网络(CNN)在移动设备上的表现,尤其是在长距离依赖的建模方面。以下是对研究思路的详细描述,包括理论框架、研究方法和创新点。

理论基础

- 传统的卷积神经网络在局部特征捕获方面表现优秀,但在处理长距离依赖时存在局限,因为卷积操作主要关注局部区域的信息。

- 引入自注意力机制(self-attention)能够有效捕获全局信息,但其计算开销大,不适用于移动设备等资源受限的环境。

- GhostNet作为轻量级模型,通过引入“Ghost模块”来减少特征冗余,从而降低计算成本。然而,GhostNet在捕获空间长距离依赖方面的能力仍显不足。

模型框架

- 本文提出了一种新的GhostNetV2架构,通过引入一种硬件友好的注意力机制(DFC注意力)来增强GhostNet的特征表达能力。

- DFC注意力通过将全连接层分解为水平和垂直两部分,采集二维特征图中的长距离依赖关系,进而实现对特征图的增强。

研究方法——模型构建

- 在GhostNet基础上,设计GhostNetV2模型,该模型的核心是DFC注意力模块。DFC注意力通过分开处理特征图中的每一行和每一列来捕获长距离依赖性,具体做法如下:

- 使用水平和垂直的全连接层(FC层)来分别计算特征图的注意力得分,这样可以在保持计算效率的同时扩大感受野。

- 通过组合水平和垂直注意力的输出,生成编码了长距离依赖信息的注意力图。

研究方法——实验设置

- 使用ImageNet数据集进行图像分类任务,通过对比GhostNet和GhostNetV2在不同计算量下的表现,评估其在移动设备上的实际推理速度和准确性。

- 进行了一系列消融实验,以检验DFC注意力模块对GhostNetV2性能提升的贡献。

预备知识

GhostNet [8] 是专为移动设备高效推断而设计的最先进的轻量级模型。其主要组件是 Ghost 模块,它可以通过廉价操作生成更多的特征图来替换原始卷积。给定输入特征 X ∈ R H × W × C X\in\mathbb{R}^{H\times W\times C} X∈RH×W×C,其中 H H H是高度、 W W W是宽度, C C C是通道数,典型的 Ghost 模块可以分两步替代标准卷积。首先使用 1×1 卷积生成内在特征,即

Y ′ = X ∗ F 1 × 1 , ( 1 ) Y^{\prime}=X*F_{1\times1},\ \ \ \ \ \ \ \quad(1) Y′=X∗F1×1, (1)

其中 ∗ ∗ ∗表示卷积操作。 F 1 × 1 F_{1\times1} F1×1是逐点卷积, Y ′ ∈ R H × W × C o u t ′ Y^{\prime}\in \mathbb{R}^{H\times W\times C_{out}^{\prime}} Y′∈RH×W×Cout′是内在特征,其大小通常小于原始输出特征,即 C o u t ′ < C o u t C_{out}^{\prime}<C_{out} Cout′<Cout。然后使用廉价的操作(例如深度卷积)根据固有特征生成更多特征。沿着通道维度将这两部分特征连接起来,即

Y = C o n c a t ( [ Y ′ , Y ′ ∗ F d p ] ) , ( 2 ) Y=\mathrm{Concat}([Y^{\prime},Y^{\prime}*F_{dp}]),\ \ \ \ \ \ \ \quad(2) Y=Concat([Y′,Y′∗Fdp]), <

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

396

396

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?