作者:小张Tt | 来源:3D视觉工坊

在公众号「3D视觉工坊」后台,回复「原论文」即可获取论文pdf和代码。

添加微信:dddvisiona,备注:自动驾驶,拉你入群。文末附行业细分群。

本研究关注跨场景通用的 NeRF 模型,其能够合成未见过场景的新视图。现有尝试采用端到端的“神经化”架构,用性能卓越的神经网络替换场景表示和渲染模块,以实现前向推理合成新视图。然而,这些架构仍然不能很好地适应不同类型的场景。作者提出了借鉴大型语言模型中的强大专家混合(MoE)思想,通过平衡整体模型容量和个例专业化,来增强这些架构的通用性。作者在通用 NeRF 架构 GNT 的基础上引入了 MoE,并进一步定制了共享的永久专家和几何感知一致性损失。这些定制化措施有助于提高跨场景一致性和空间平滑度,这对于通用视图合成至关重要。作者的模型命名为 GNT-MOVE,在未见过的场景中表现出卓越的泛化能力,无论是在零样本还是少样本情况下,都取得了最先进的结果。

1 引言

本文引入了Mixture-of-Experts (MoE)思想并将其定制为通用的神经辐射场 (NeRF)框架,形成了GNT-MOVE模型。该模型通过MoE transformers显著提高了复杂场景上的可泛化新视角合成能力。为了适应可泛化的NeRF,作者引入了共享的永久Expert以实现跨场景渲染的一致性,并通过几何感知的空间一致性目标来提高视图间的空间平滑性。实验证明了GNT-MOVE在跨场景泛化上的有效性,包括零样本和少样本的设置。该模型在多场景训练时实现了最先进的性能,具有更好的零样本泛化和一致的强大的少样本泛化能力。这里也推荐「3D视觉工坊」新课程《深度剖析面向机器人领域的3D激光SLAM技术原理、代码与实战》。

GNT-MOVE主要贡献可以总结如下:

-

提出了一种受LLM启发的NeRF框架,称为GNT-MOVE,通过引入Experts混合(MoE) transformers,显著推动了复杂场景上可泛化新视角合成的前沿。

-

为了将MoE量身定制为可泛化的NeRF,引入了一个共享的永久Expert来实现跨场景渲染的一致性,并引入了一个几何感知的空间一致性目标来实现视图间的空间平滑性。

-

在复杂场景基准测试中进行的实验证明了GNT-MOVE在跨场景泛化上的有效性,包括零样本和少样本的设置。

2 相关工作

NeRF是一种基于神经辐射场的模型,可以通过体素渲染在新视图合成方面取得出色的性能。然而,原始的NeRF需要在每个新场景中重新训练,而且对于跨场景泛化的应用有限。为了解决这个问题,有一些工作通过引入卷积编码器和共享的MLP来模拟不同对象,而另一类工作则采用Transformer结构并结合极线约束实现了实时的新视图合成。作者的方法也基于Transformer,并定制了MoE思想,以在跨场景泛化和场景特定化之间取得平衡,并可以模拟多样复杂的场景和呈现更加逼真的结果。Mixture-of-Experts(MoE)是一种根据学习或临时路由策略,通过组合子模型进行输入相关计算的方法。MoE在多个领域有广泛的成功应用,并且最近的进展提出了稀疏门控的MoE方法,以在不牺牲推理成本的情况下扩大语言模型的容量,并促进具有不同功能的不同模块的组合泛化。这有助于发挥非常潜在的组合式未见泛化能力,并实现出色的准确性和效率的平衡。

3 Preliminary

GNT是一种纯统一的基于Transformer的架构,通过两个阶段的转换器来实时重构NeRFs。视图转换器根据相邻视图的对极线信息预测每个点的特征,射线转换器在射线上组合特征来计算颜色。MoE层包含多个专家和一个路由器,通过路由器的选择将特定数量的专家的输出加权求和。该方法具有很好的性能,适用于其他基于Transformer的NeRFs。

4 方法

在本节中,作者使用MoE层来扩展GNT模型。主要流程如图1所示。作者的设计原则是对原始的GNT模型进行必要且最小程度的修改,以保留其标准化的架构和易用性。

4.1 视觉领域的View专家混合:基本流程

在视觉领域,作者提出了一种混合视图专家的方法,在基本流程中应用了MoE模块。通过利用UNet从2D图像中提取几何、外观和局部光传输信息,并结合视图变换器,作者能够估计出点级渲染参数。为了根据渲染属性特定定制不同的组件,作者在视图变换器中使用了稀疏激活的MoE层。在训练过程中,作者通过稀疏路由的变异系数对专家选择进行了正则化,以平衡和多样化地使用专家。这种方法的优势在于能够更好地捕捉不同视图间的细微差别,并避免表示崩溃。这个方法对于NeRF的应用尤为适用。

4.2 将跨场景一致性和空间平滑性融合到MoE中

本文针对在MoE和NeRF中缺乏跨场景一致性和空间平滑性的问题进行了研究。为了解决这个问题,作者引入了两个层次的定制化,即共享的永久专家和几何感知的空间一致性。在架构层面,作者通过引入一个共享的永久专家来提升跨场景一致性。这个专家负责在不同场景之间融合共同知识。在目标层面,作者提出了一个空间一致性目标,通过鼓励接近空间的点选择相似的专家,并使用几何距离对专家选择进行重新加权。通过这两个定制化,作者提高了MoE和NeRF之间的平衡,从而使NeRF能够更好地跨场景泛化和特化。

5 实验

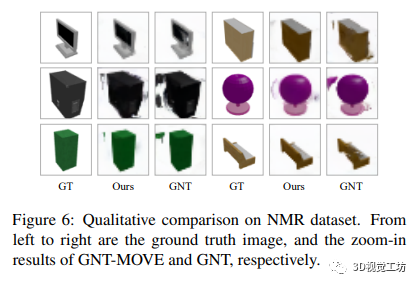

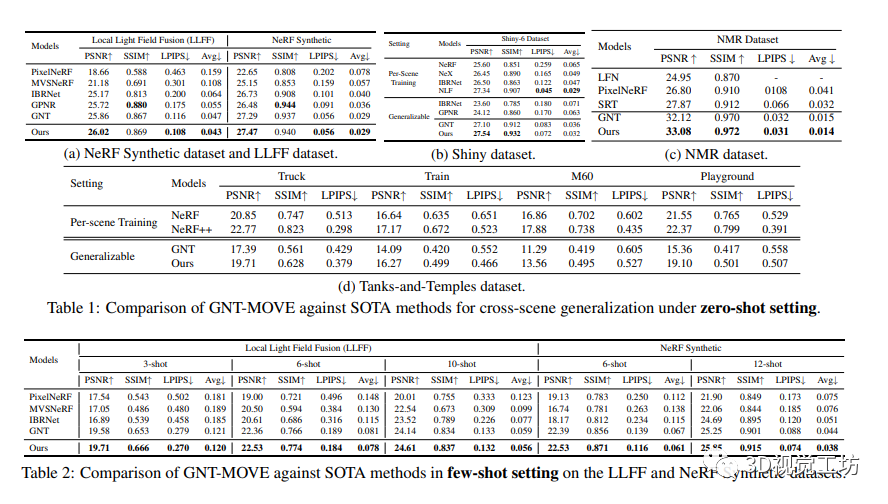

在本研究中,作者通过引入Mixture-of-Experts(MoE)和其他定制设计,改进了GNT-MOVE方法,使其在跨场景泛化方面取得了显著的进展。作者的方法在零样本和少样本设置下都表现出色,不仅在标准数据集上,而且在具有复杂材料和光效果的挑战性数据集上都表现出色。实验结果显示,GNT-MOVE比标准GNT具有更好的性能,尤其在挑战性的场景和光照条件下。作者还通过可视化专家选择和深度图等方式展示了他们的方法的有效性。总的来说,该研究为通用新视图合成任务提供了一种强大且有效的方法,具有潜力应用于各种复杂的视觉场景。这里也推荐「3D视觉工坊」新课程《深度剖析面向机器人领域的3D激光SLAM技术原理、代码与实战》。

6 总结

本研究引入了一个大规模的基于部件的跨类别物体操作基准PartManip,包括六项真实环境中的任务。为了解决可泛化的基于视觉的策略学习问题,作者首先介绍了一种经过精心设计的基于状态的部件感知专家学习方法,然后是一个合理的从状态到视觉的蒸馏过程,以及一种域泛化技术,以提高跨类别泛化能力。通过广泛的仿真实验,作者证明了我们的方法在先前工作中的卓越性能。作者还在实际世界中展示了其性能。

—END—

—END—

高效学习3D视觉三部曲

第一步 加入行业交流群,保持技术的先进性

目前工坊已经建立了3D视觉方向多个社群,包括SLAM、工业3D视觉、自动驾驶方向,细分群包括:[工业方向]三维点云、结构光、机械臂、缺陷检测、三维测量、TOF、相机标定、综合群;[SLAM方向]多传感器融合、ORB-SLAM、激光SLAM、机器人导航、RTK|GPS|UWB等传感器交流群、SLAM综合讨论群;[自动驾驶方向]深度估计、Transformer、毫米波|激光雷达|视觉摄像头传感器讨论群、多传感器标定、自动驾驶综合群等。[三维重建方向]NeRF、colmap、OpenMVS等。除了这些,还有求职、硬件选型、视觉产品落地等交流群。大家可以添加小助理微信: dddvisiona,备注:加群+方向+学校|公司, 小助理会拉你入群。

第二步 加入知识星球,问题及时得到解答

针对3D视觉领域的视频课程(三维重建、三维点云、结构光、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、源码分享、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答等进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业、项目对接为一体的铁杆粉丝聚集区,6000+星球成员为创造更好的AI世界共同进步,知识星球入口:「3D视觉从入门到精通」

学习3D视觉核心技术,扫描查看,3天内无条件退款

第三步 系统学习3D视觉,对模块知识体系,深刻理解并运行

如果大家对3D视觉某一个细分方向想系统学习[从理论、代码到实战],推荐3D视觉精品课程学习网址:www.3dcver.com

科研论文写作:

基础课程:

[1]面向三维视觉算法的C++重要模块精讲:从零基础入门到进阶

[2]面向三维视觉的Linux嵌入式系统教程[理论+代码+实战]

工业3D视觉方向课程:

[1](第二期)从零搭建一套结构光3D重建系统[理论+源码+实践]

SLAM方向课程:

[1]深度剖析面向机器人领域的3D激光SLAM技术原理、代码与实战

[1]彻底剖析激光-视觉-IMU-GPS融合SLAM算法:理论推导、代码讲解和实战

[2](第二期)彻底搞懂基于LOAM框架的3D激光SLAM:源码剖析到算法优化

[3]彻底搞懂视觉-惯性SLAM:VINS-Fusion原理精讲与源码剖析

[4]彻底剖析室内、室外激光SLAM关键算法和实战(cartographer+LOAM+LIO-SAM)

视觉三维重建

[1]彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进)

自动驾驶方向课程:

[1] 深度剖析面向自动驾驶领域的车载传感器空间同步(标定)

[2] 国内首个面向自动驾驶目标检测领域的Transformer原理与实战课程

[4]面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

[5]如何将深度学习模型部署到实际工程中?(分类+检测+分割)

2167

2167

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?