5.4 PID算法优化

在实际应用中,通过使用优化技术可以提高PID算法的效率,如遗传算法、粒子群算法等。这样的算法能够在参数空间中搜索性能最佳的PID参数,提高系统的控制效果。

5.4.1 遗传算法优化

遗传算法 (Genetic Algorithm, 简称GA)模拟生物进化的过程,通过基因编码、交叉、变异等操作,在解空间中搜索最优解。遗传算法是一种模拟生物进化过程的优化算法,用于在解空间中搜索最优解。

1. 基本概念

- 个体(Individual):在遗传算法中,解决问题的每个潜在解称为一个个体。在PID优化中,每个个体对应一个PID参数集。

- 染色体(Chromosome):每个个体的解被编码成染色体,通常是由二进制编码,也可以是其他编码方式。染色体包含了问题的解决方案。

- 基因(Gene):染色体中的一个小部分称为基因,它对应于问题的一个特定方面。在PID优化中,基因对应于PID参数中的一个。

- 种群(Population):由多个个体组成的集合称为种群。种群中的每个个体都代表了问题空间中的一个潜在解。

- 适应度函数(Fitness Function):用于评估个体的好坏程度的函数,通常根据问题的性能指标来定义。在PID优化中,适应度函数可以是系统性能的评估指标,如超调量、稳定时间等。

- 选择(Selection):选择操作用于根据适应度函数从当前种群中选择个体,以构建下一代种群。适应度较高的个体被选择的概率较大。

- 交叉(Crossover):交叉操作模拟基因的交换,产生新的个体。两个父代个体的染色体交换部分基因,形成两个新的后代个体。

- 变异(Mutation):变异操作模拟基因的突变,引入新的遗传信息。在PID优化中,变异可能是对某个基因进行微小的改变。

2. 实现步骤

(1)初始化种群:随机生成初始的个体集合,每个个体对应一个PID参数集。

(2)计算适应度:使用适应度函数计算每个个体的适应度,评估其在解空间中的优劣。

(3)选择:根据适应度选择个体,通常使用轮盘赌选择或竞争选择等策略。

(4)交叉:对选定的个体进行交叉操作,生成新的后代个体。

(5)变异:对后代个体进行变异操作,引入新的遗传信息。

(6)更新种群:将新生成的后代个体与原种群合并,形成新一代种群。

(7)重复:重复进行选择、交叉、变异等步骤,直到满足停止条件(例如达到最大迭代次数)。

(8)输出结果:返回具有最高适应度的个体,对应于问题的最优解。

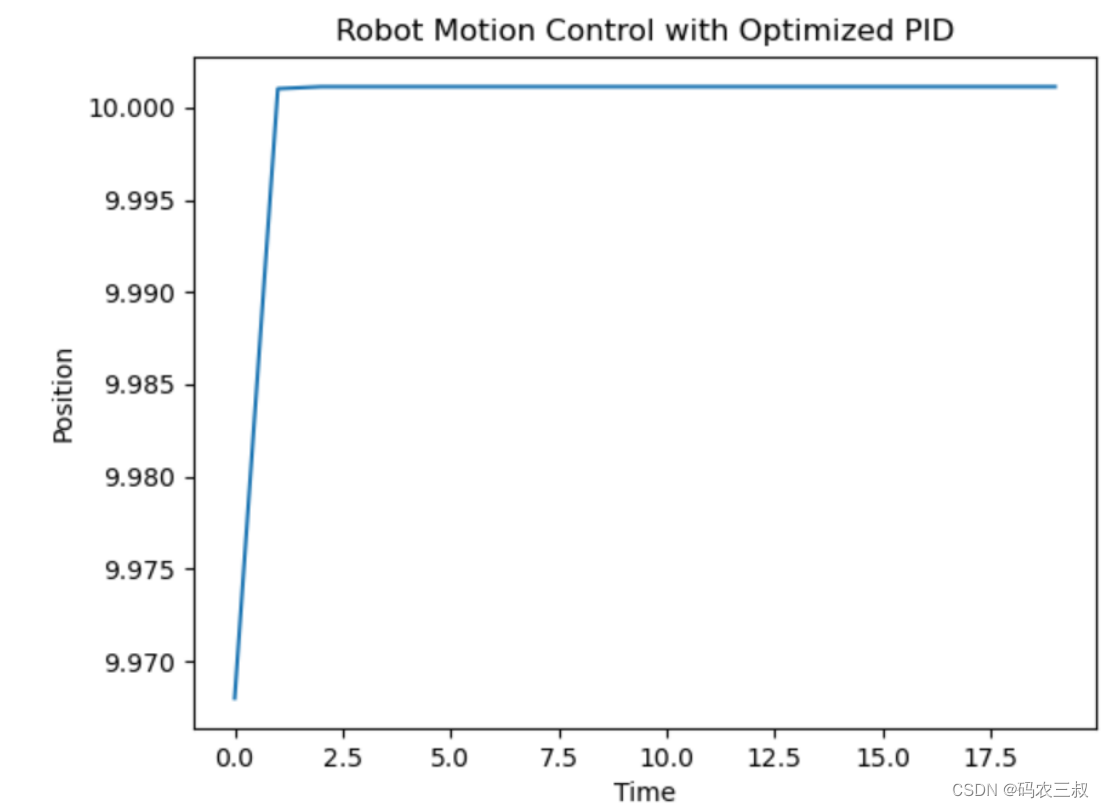

遗传算法的优势在于其并行搜索的特性,使其能够有效地处理高维、非线性和复杂的优化问题。例如在下面的这个例子中,模拟了机器人在目标位置上下摆动的情况,本实例的目标是通过调整PID参数来使机器人尽可能快地稳定在目标位置。

实例5-7:使用遗传算法优化PID控制器(源码路径:codes\5\pid\yi.py)

实例文件yi.py的具体实现代码如下所示。

import numpy as np

import matplotlib.pyplot as plt

from deap import base, creator, tools, algorithms

# 模拟机器人运动的简化模型

class RobotSimulation:

def __init__(self, target_position):

self.target_position = target_position

self.position = 0

self.Kp = 0.5

self.Ki = 0.2

self.Kd = 0.1

def update_position(self, control_output):

error = self.target_position - self.position

proportional = self.Kp * error

integral = self.Ki * error

derivative = self.Kd * (error - self.position)

self.position += proportional + integral + derivative + control_output

# 适应度评估函数

def evaluate_pid(ind):

robot = RobotSimulation(target_position=10)

fitness = 0

control_output = 0

for _ in range(100):

control_output = ind[0] * (robot.target_position - robot.position) + \

ind[1] * robot.target_position + \

ind[2] * (robot.target_position - 2 * robot.position)

robot.update_position(control_output)

fitness += abs(robot.target_position - robot.position)

return fitness,

# 遗传算法设置

creator.create("FitnessMin", base.Fitness, weights=(-1.0,))

creator.create("Individual", list, fitness=creator.FitnessMin)

toolbox = base.Toolbox()

toolbox.register("attr_float", np.random.uniform, -1, 1)

toolbox.register("individual", tools.initRepeat, creator.Individual, toolbox.attr_float, 3)

toolbox.register("population", tools.initRepeat, list, toolbox.individual)

toolbox.register("evaluate", evaluate_pid)

toolbox.register("mate", tools.cxBlend, alpha=0.5)

toolbox.register("mutate", tools.mutGaussian, mu=0, sigma=0.2, indpb=0.2)

toolbox.register("select", tools.selTournament, tournsize=3)

# 主程序

if __name__ == "__main__":

population_size = 50

generations = 20

pop = toolbox.population(n=population_size)

hof = tools.HallOfFame(1)

algorithms.eaMuPlusLambda(pop, toolbox, mu=population_size, lambda_=population_size * 2,

cxpb=0.7, mutpb=0.2, ngen=generations, stats=None, halloffame=hof)

best_individual = hof[0]

print("Best PID Parameters:", best_individual)

# 可视化结果

robot = RobotSimulation(target_position=10)

position_data = []

for gen in range(generations):

control_output = best_individual[0] * (robot.target_position - robot.position) + \

best_individual[1] * robot.target_position + \

best_individual[2] * (robot.target_position - 2 * robot.position)

robot.update_position(control_output)

position_data.append(robot.position)

plt.plot(position_data)

plt.xlabel('Time')

plt.ylabel('Position')

plt.title('Robot Motion Control with Optimized PID')

plt.show()在上述代码中,使用 DEAP 库来实现遗传算法。最终,我们使用遗传算法来优化PID参数,并可视化最佳参数对机器人位置的影响。上述代码的实现流程如下:

- 首先,定义了一个简单的机器人类(Robot),该类包含了机器人的位置、目标位置以及PID控制器的比例增益、积分时间和微分时间等参数。

- 接着,在机器人类中实现了两个主要功能的SimPy协程。首先是update_position函数,该函数模拟机器人的位置更新过程,并应用PID控制器来调整机器人的位置。这个协程以每个时间单位更新一次机器人的位置。

- 接下定义self_tune_pid函数,该函数模拟了一个简化版的PID参数调整过程。这个协程定期地(每隔一段时间)调整PID参数,以使机器人在运动中更好地适应目标。

- 然后,创建了仿真环境和机器人对象。在仿真环境中,我们启动了两个协程,分别用于机器人位置的更新和PID参数的实时调整。

- 最后,运行了仿真环境,模拟了一定时间内的机器人运动。在整个仿真过程中,机器人的位置数据被记录下来。

- 最终,使用Matplotlib绘制了机器人位置随时间变化的曲线,以及PID参数的自调整过程,效果如图5-3所示。这可以观察机器人是如何通过PID控制器适应目标位置的,并且PID参数是如何在运动中实时调整的。

图5-3 机器人的位置变化曲线图

5.4.2 粒子群算法优化

粒子群算法 (Particle Swarm Optimization, 简称PSO)模拟鸟群或鱼群等群体行为,通过个体间信息共享和学习,使整个群体向最优解收敛。也就是说,PSO试图通过模拟群体中个体之间的协作和信息共享来寻找最优解。

1. 基本概念

- 粒子(Particle):粒子是PSO算法中的基本单元,代表了潜在解空间中的一个候选解。每个粒子都有一个位置和速度,位置表示候选解,速度表示粒子在解空间中的移动方向和速度。

- 群体(Swarm):粒子群由一组粒子组成,它们在解空间中协同搜索最优解。群体的状态由每个粒子的位置和速度决定。

- 适应度函数(Fitness Function):适应度函数用于评估每个粒子的解的质量。PSO的目标是通过优化这个适应度函数找到使其最小或最大化的最优解。

2. 实现步骤

(1)初始化粒子群:随机生成一群粒子,每个粒子有随机的初始位置和速度。同时,为每个粒子随机生成个体最优解(pbest)。

(2)更新粒子位置和速度:对于每个粒子,根据其当前位置和速度,以及距离当前最优解和全局最优解的信息,更新其速度和位置。

- 速度更新公式:vi(t+1)=w⋅vi(t)+c1⋅r1⋅(pbesti−xi(t))+c2⋅r2⋅(gbest−xi(t))

- 位置更新公式:xi(t+1)=xi(t)+vi(t+1)

其中,w是惯性权重,c1和c2是学习因子,r1和r2是[0, 1]范围内的随机数,pbesti是粒子个体最优解,gbest是全局最优解。

(3)评估适应度:对每个粒子,通过适应度函数评估其当前位置的适应度。

(4)更新个体最优解和全局最优解:如果当前位置的适应度优于个体最优解,则更新个体最优解;如果当前位置的适应度优于全局最优解,则更新全局最优解。

(5)迭代:重复执行上面的步骤(2)到(4),直到满足停止条件(例如达到最大迭代次数或适应度足够高)。

PSO的特点在于其简单而有效的全局搜索机制,通过粒子之间的合作和信息共享,可以有效地搜索复杂的解空间。例如在下面的实例中,将使用粒子群算法(PSO)来优化一个简单的PID控制器的参数。我们将考虑一个控制机器人运动的场景,目标是通过调整PID参数来使机器人尽快到达目标位置。

实例5-1:使用PID控制器实现系统位置调节模拟(源码路径:codes\5\pid\zao.py)

实例文件zao.py的具体实现代码如下所示。

import numpy as np

import matplotlib.pyplot as plt

class Particle:

def __init__(self, position_dim):

self.position = np.random.rand(position_dim)

self.velocity = np.random.rand(position_dim)

self.pbest_position = self.position.copy()

self.pbest_value = float('inf')

def objective_function(pid_params):

return np.sum(pid_params)

def update_velocity(particle, gbest_position, inertia_weight=0.5, c1=1.5, c2=1.5):

inertia_term = inertia_weight * particle.velocity

cognitive_term = c1 * np.random.rand() * (particle.pbest_position - particle.position)

social_term = c2 * np.random.rand() * (gbest_position - particle.position)

particle.velocity = inertia_term + cognitive_term + social_term

def optimize_pid_using_pso(num_particles, num_iterations, position_dim):

particles = [Particle(position_dim) for _ in range(num_particles)]

gbest_position = np.zeros(position_dim)

gbest_value = float('inf')

fitness_history = [] # 记录适应度值的变化

for iteration in range(num_iterations):

for particle in particles:

current_value = objective_function(particle.position)

if current_value < particle.pbest_value:

particle.pbest_value = current_value

particle.pbest_position = particle.position.copy()

if current_value < gbest_value:

gbest_value = current_value

gbest_position = particle.position.copy()

fitness_history.append(gbest_value) # 记录全局最优值

for particle in particles:

update_velocity(particle, gbest_position)

particle.position += particle.velocity

# 绘制适应度值随迭代次数的变化曲线

plt.plot(range(num_iterations), fitness_history, label='PSO')

plt.xlabel('Iteration')

plt.ylabel('Fitness Value')

plt.title('PSO Optimization of PID Parameters')

plt.legend()

plt.show()

return gbest_position

if __name__ == "__main__":

num_particles = 20

num_iterations = 50

position_dim = 3

best_pid_params = optimize_pid_using_pso(num_particles, num_iterations, position_dim)

print("Optimal PID Parameters:", best_pid_params)在这个例子中定义了一个简单的目标函数,即PID参数的和。然后,通过PSO算法来寻找使这个目标函数最小化的PID参数。最终,程序输出了优化得到的PID参数。上述代码的实现流程如下所示:

- 首先,定义了一个粒子类 Particle,其中包括位置、速度、个体最优位置(pbest)和个体最优值的属性。每个粒子的初始位置和速度被随机初始化。

- 然后,定义了目标函数 objective_function,它接受一个表示PID参数的数组,并返回一个适应度值,这里简单地将PID参数数组的元素求和作为适应度值。

- 接着,编写了更新粒子速度的函数 update_velocity,该函数考虑了惯性项、认知项和社会项。这些项分别代表粒子自身的历史速度、个体最优位置和全局最优位置对速度的影响。

- 在 optimize_pid_using_pso 函数中创建了一群粒子,并初始化全局最优位置和适应度值。然后,通过迭代的方式更新粒子的位置和速度,同时更新个体最优位置和全局最优位置。

- 最后,为了增加可视化对比功能,在PSO优化的过程中记录每个粒子的适应度值。记录了每次迭代后的全局最优适应度值,并绘制了适应度值随迭代次数的变化曲线,这样可以更直观地了解优化过程中目标函数的变化情况。效果如图5-4所示。

图5-4 适应度值随迭代次数的变化曲线图

6541

6541

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?