短短两周,DeepSeek成为全球增速最快的AI应用。凭借卓越的性能和广泛的应用场景,这匹大模型黑马已然成为行业标杆,为千行百业提供了AI解决方案新选择。蛇年开工当天,昆仑芯新一代产品P800万卡集群点亮的消息引发关注,三万卡集群也将于近日点亮,为国产AI算力注入强大势能。

昆仑芯在大模型时代爆发出卓越的竞争力,而这正是基于十余年真实业务场景历练以及独特的自研优势。作为国产AI芯片引领者,昆仑芯已完成DeepSeek训练推理全版本适配,且性能卓越、成本效率极致,一键部署,为广大开发者提供更快、更强、更省的训推体验。

全版本:率先完成训练推理DeepSeek全版本适配

在模型适配方面,昆仑芯领先业界。在DeepSeek-V3/R1上线不久,昆仑芯便率先完成全版本模型适配,这其中包括DeepSeek MoE 模型及其蒸馏的Llama/Qwen等小规模dense模型(详见下方海报)。

同时,昆仑芯也已全面适配文心系列、Llama、Qwen、ChatGLM、Baichuan等各类大模型的推理和训练任务,性能优势明显。在各个行业客户、合作伙伴的业务场景中,昆仑芯已实际上线运行各类大模型任务;通过千卡和万卡集群为客户提供了稳定的服务和优秀的性能表现。

性能卓越:前瞻产品定义、极致成本效率

得益于昆仑芯前瞻的产品定义,昆仑芯产品性能表现卓越,成本优势领先。

昆仑芯P800可以较好的支撑DeepSeek系列MoE模型大规模训练任务,全面支持MLA、多专家并行等特性,仅需32台即可支持模型全参训练,高效完成模型持续训练和微调。

P800显存规格优于同类主流GPU20%-50%,对MoE架构更加友好,且率先支持8bit推理,单机8卡即可运行 671B 模型。正因如此,昆仑芯相较同类产品更加易于部署,同时可显著降低运行成本,轻松完成DeepSeek-V3/R1全版本推理任务。

开发者友好:一键部署、即刻上线

P800生态完备,易用性强,可以实现对训练和推理任务的快速适配。P800快速适配支持了DeepSeek-V3/R1的持续全参数训练,LoRA等PEFT能力,提供给用户开箱即用的训练体验。基于昆仑芯完整的软件栈生态,两个步骤即可轻松实现在昆仑芯P800上进行DeepSeek-V3/R1推理部署,对广大开发者十分友好。

欢迎体验:两步完成DeepSeek-V3/R1模型推理部署

1 .资源准备

主要是镜像和模型,镜像提供完整的依赖环境开箱即用。

模型准备

昆仑芯P800支持8bit推理,下载官方权重后使用如下命令进行量化(后文附有下载方式);其他不同尺寸蒸馏模型则通过huggingface下载即可。

镜像准备(后文附有下载方式)

2 .启动服务&请求示例

server和client使用方式和vllm社区基本一致,零成本上手,如下:

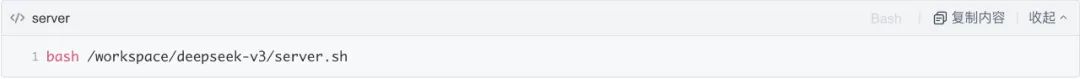

启动服务

镜像中一键启动,采样和推理参数可根据实际业务场景在脚本中配置。

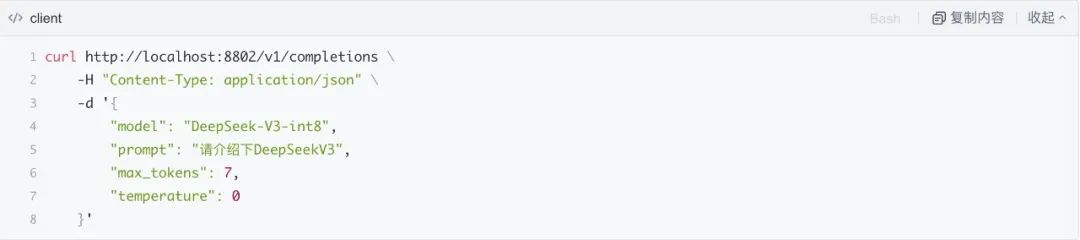

请求示例

下图为一个简单的请求示例:

以下两种方式均可快速获取文档:

扫码获取

发送邮件至:kunlunxin01@baidu.com

1780

1780

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?