前言

23年3月来自Ohio State U的论文“LLM-Planner: Few-Shot Grounded Planning for Embodied Agents with Large Language Models”。

本研究的重点是使用大语言模型 (LLM) 作为具身智体的规划器,这些智体可以遵循自然语言指令在视觉感知的环境中完成复杂任务。现有方法的高数据成本和低样本效率,阻碍了执行多任务并能快速学习新任务多功能智体的开发。这项工作提出一种 LLM-Planner,利用大语言模型的强大功能为具身智体进行少样本规划。进一步提出了一种简单但有效的方法来增强物理落地的 LLM,生成和更新基于当前环境的规划。在 ALFRED 数据集上(”ALFRED: A Benchmark for Interpreting Grounded Instructions for Everyday Tasks“)的实验表明,该方法可以实现非常有竞争力的少样本性能:尽管使用不到 0.5% 的配对训练数据,LLM-Planner 仍实现了与完整数据训练的基线可媲美的性能。现有的方法几乎无法在相同的少样本设置下成功完成任何任务。

人们一直希望构建多功能的具身智体,例如,能够遵循自然语言命令执行不同任务以及快速学习执行新任务的机器人。然而,当代语言驱动的智体仍然需要大量标记示例(成对的语言指令和黄金轨迹)来学习每项任务,这非常昂贵,并且阻碍了真正多功能智体的开发 [34, 29, 25, 8, 37, 17, 40, 27, 11, 2, 16]。最近,一系列开创性的工作表明,大语言模型 (LLM)(例如 GPT-3 [4])作为具身 AI 智体的少样本规划器具有巨大的潜力 [1, 13, 21, 35]。配备基于 LLM 规划器的智体已经开始展示通过一些训练示例学习新任务的能力。

尽管现有工作在概念验证方面前景光明,但它们仍然存在重大限制,可能会阻碍其在有限的评估设置之外的大规模应用。例如,SayCan [1] 是使用 LLM 进行具身指令遵循的先驱工作之一,它在只有 15 种目标类型的两个环境中进行了评估。假设智体能够预先枚举所有可接受的技能(即 [动作,目标] 对),因此它可以使用 LLM 对技能进行排名。在将智体部署到新环境时,这一假设在部分可观察的环境中很容易被打破。在有更多目标更复杂的环境中,成本也可能迅速增加,因为智体需要调用 LLM 来评估每一步中每个可接受的技能;效率同时下降。最后,大多数现有工作 [1, 35, 13, 24] 使用 LLM 从语言指令生成单个静态规划,然后执行整个规划。但对于同一种语言指令,最优的规划是依赖于环境的,不同的环境可能需要不同的规划,目前还缺乏一种基于环境感知的动态调整LLM规划的方法。

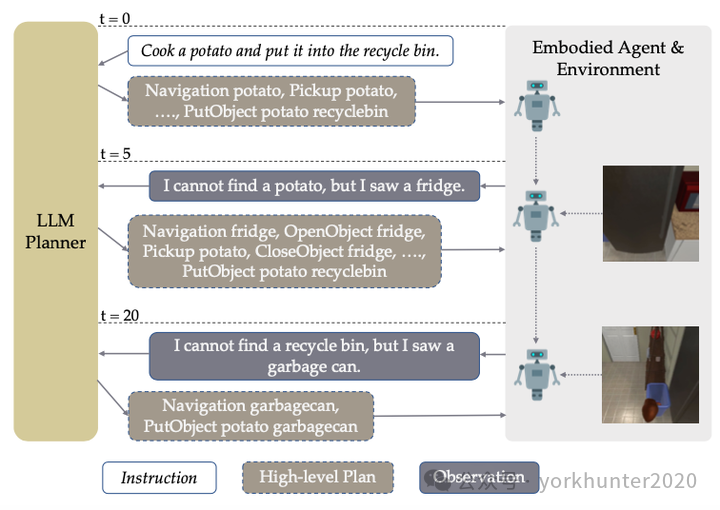

如图所示LLM-Planner 用于高级规划:在收到自然语言指令(t = 0)后,LLM-Planner 首先提示大语言模型(例如 GPT-3)来生成高级规划。当具身智体在执行当前规划遇到困难时(t = 5 和 t = 20),LLM-Planner 会根据环境的观测重规划,生成更合理的规划,这可能有助于智体摆脱困境。LLM 中的常识知识(例如,食物通常存放在冰箱中)使其能够制定合理的高级规划并根据新环境感知进行重规划。

具身指令跟随,通常也被称为视觉和语言导航 (VLN),尽管它还涉及交互动作,并且通常比典型的 VLN 任务(例如 Room2Room [2])具有更长的时间范围。主要关注基于 AI2-Thor [15] 模拟器构建的标准 ALFRED [34] 数据集,但该方法可以轻松泛化到其他数据集和环境。选择 ALFRED 主要考虑到其任务类型的多样性(7 种不同的任务类型)和长范围任务(平均每个任务 50 个动作)。

VLN 任务定义如下:给定一个语言指令 I,智体需要预测环境 E 中的一系列原始动作并执行以完成任务。在 ALFRED这样 [34] 数据集中,指令 I 由高级目标 IH 和(可选)分步指令列表 IL 组成。因此,VLN 任务可以用元组 (I, E, G) 表示,其中 G 是目标测试。

本文考虑 VLN 的分层规划模型 [38],最近的几项研究 [26、3、33、36] 对此进行了不同程度的探索,但这些研究都没有考虑少样本设置或 LLM 规划。在这个公式中,规划以分层方式建模。高级规划器将指令 I 映射到高级规划 (HLP) Lh = [g0, g1, · · · , gT ],其中每个子目标 gi 指定为 (高级动作,目标)。

高级动作空间由 1 个导航动作(Navigation)和 7 个交互动作(PickupObject、PutObject、OpenObject、CloseObject、ToggleOnObject、ToggleOffObject、SliceObject)组成。类似的动作在其他相关工作中也很常见,例如 SayCan [1] 和 LM zero-shot planner [13]。

低级规划器将每个子目标映射到一系列原始动作 Ll = [a0 , a1 , · · · , aTi ]。最先进的 VLN 方法 [26, 3] 使用基于地图的低级规划器和简单的路径查找算法从地图中找到当前子目标中的目标对象。值得注意的是,一旦指定了高级规划 Lh,低级规划就变得独立于指令 I。更正式地说,P(Ll|I, Lh, E) = P(Ll|Lh, E)。低级规划器中涉及的所有组件要么是确定性的,要么使用来自模拟器的合成数据进行训练。不需要涉及语言指令的配对数据。

最近,随着 LLM 的兴起,上下文学习(也称为提示)[4] 引起了广泛关注。通过设计不同的提示,LLM 可以适应不同的下游任务,只需几个示例作为演示,而无需更新任何参数。

虽然只使用少量的训练示例,但许多的少样本研究使用大型验证集进行提示设计和模型选择 [4]。最近的研究 [28] 表明,如此大的验证集会导致高估语言模型的功效,因为它们会对模型选择产生强烈的偏见,并违反了预期的少样本设置。为了避免这种偏见,坚持真正的少样本设置 [28],其中提示设计和模型选择是通过在同一个小训练集上进行交叉验证来进行的,而不是使用单独的验证集。

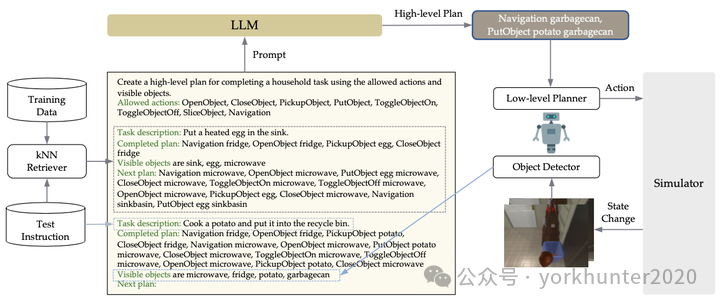

GPT-3 等 LLM 经过预训练可以生成自然语言。为了使它们适应高级规划器,第一步是设计一个适当的提示来指导它们生成高级规划。上下文示例的选择对于 LLM 的性能至关重要,最近的研究 [28, 9] 表明,对每个测试示例动态检索的其相似示例是有益的。采用 k-最近邻 (k-NN) 检索器来选择上下文示例。还使用logit biases [10] 将 LLM 的输出空间进一步限制在允许的动作和目标集内。通过上述所有设计,获得 LLM-Planner 的静态版本,它已经可以生成合理的 HLP。又提出一种落地重规划算法,增强 LLM 能够在当前环境落地的能力,从而进一步提高 HLP 质量。最后,将 LLM-Planner 集成到现有的具身智体中,赋予它们少样本规划能力。如图显示 LLM-Planner 的概览:

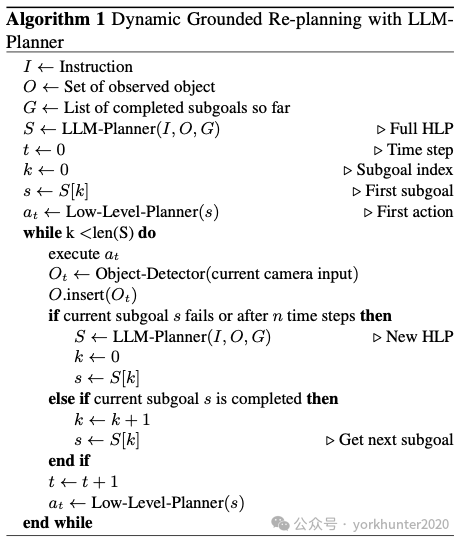

基于 LLM-Planer 的重规划算法如下所示。在算法中,重规划将在以下两种情况下触发:1)智体无法执行操作,或 2)在固定数量的时间步骤之后。根据观测的目标,LLM-Planner 将生成已完成 partial HLP 的新延续,并且智体将继续执行新规划,这可能有助于它摆脱困境。

从 21,023 个 ALFRED 训练示例中为 LLM-Planner 选择 100 个示例。采用随机分层抽样,确保在 100 个示例集中公平地表示所有 7 种任务类型。对于 k-NN 检索器,用来自 Huggingface Transformers 库 [39] 的预训练 BERT-base-uncased 模型。对于 LLM,用公共 GPT-3 [4] API ,用 k-NN 检索器从 100 个训练示例中选择 9 个上下文示例。将温度设置为 0,并对所有允许的输出tokens应用 0.1 的logit biases。从目标检测器中检索用于接地重规划的目标列表。具体而言,用来自 HLSM 感知模型的预训练目标检测器。只包括标签置信度超过 80% 的目标以降低噪音。值得注意的是,可以使用任何目标检测器来获取目标列表,并且只使用 HLSM 感知模型来节省计算成本和时间。为了避免违反小样本假设,用来自 HLSM 的预训练导航、感知和深度模型,这些模型仅使用来自模拟器的合成轨迹进行训练,没有任何涉及自然语言指令或人工注释的配对训练数据。

与两个主要基线模型 HLSM [3] 和 FILM [26] 进行比较。它们也是分层规划模型,在 ALFRED 排行榜上表现强劲。直接用LLM-Planner 替换这两个模型的训练高级规划器,没有修改任何其他部分。此外,重训练这些模型,在相同的小样本设置下与 LLM-Planner 进行比较。还与其他几个使用完整数据训练的已发布基线模型进行比较。此外,还将 SayCan 实现到 ALFRED,并在与 LLM-Planner 相同的少样本设置下进行比较。

SayCan [1] 是一个基于排名的高级规划器,它需要一个可接受动作列表并使用 LLM 对它们进行排名。为了使 SayCan 能够在 ALFRED 中复杂、部分可观测的环境中工作,赋予它不公平的竞争优势——它事先知道当前环境中的所有目标和affordance,编译这个技能列表。还为 SayCan 配备来自 LLM-Planner 的相同 k-NN 检索器。

其他基线,直接从相应论文的已发布版本中检索结果。如果 ALFRED 排行榜条目比原始论文中的数字更好,报告更高的数字。

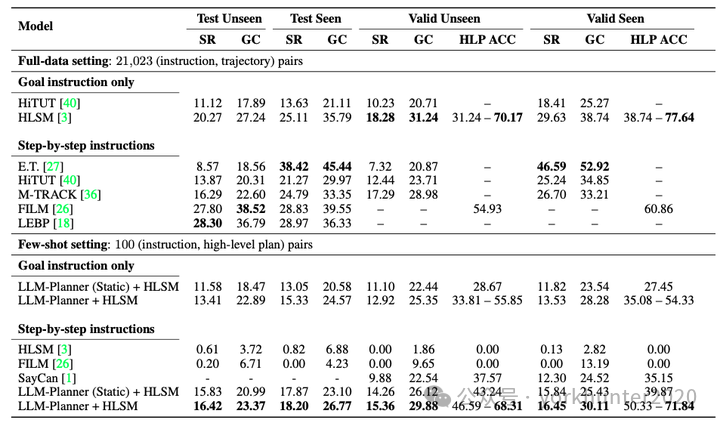

LLM-PLanner和其他基线的结果比较如下表所示:

其中基线的细节如下:

HLSM [3] 由三个组件组成:语义体素图、高级规划器和低级规划器。首先,通过对视觉输入应用语义分割和深度估计构建 3D 语义体素图,该图存储智体和目标的实时位置。接下来,高级规划器采用语言指令、语义图编码和之前的子目标历史记录来预测下一个子目标。最后,低级规划器是确定性算法和学习组件的混合体(例如,学习偏航角和俯仰角以面向目标)。HLSM 首先处理感官图像输入以创建/更新地图,该地图与语言指令一起用作高级规划器的输入,以预测下一个子目标。最后,低级规划器将子目标映射到一系列原始动作中。

FILM [26] 由四个部分组成:语义图、语义搜索策略、基于模板的高级规划器和低级规划器。在每个任务开始时,使用五个独立的基于 BERT 分类器 [7] 来预测五个参数(任务类型、目标对象、容器、父目标以及是否需要切片),每个分类器都将目标和可选的分步说明作为输入来预测相应的参数。然后,FILM 通过根据预测的任务类型选择预定义模板并将其他参数填充到模板中来生成高级规划。此外,语义图在每个时间步骤都会使用传感图像输入进行更新。每 25 步,语义搜索策略都会预测语义图上目标对象的坐标,然后确定性低级规划器会使用这些坐标来决定从当前位置导航到目标对象位置的低级规划。

SayCan [1] 由 3 个组件组成:LLM 排序器、技能集和价值函数。用改编自 SayCan 代码库 的 LLM 排序器,使用相同的设置(例如温度和对数概率),并使用 GPT-3(text-davinci-003)作为 LLM 的选择。首先,SayCan 使用预训练的价值函数生成技能列表及其在当前环境中的affordance分数。然后,它向 LLM 提示每个技能的自然语言描述,并生成一个表示该技能与任务成功有多相关的概率。最后,SayCan 结合技能的 LLM 概率和affordance分数来选择要执行的技能。

(SL)3 [33] 是一种分层规划模型,也在 ALFRED 基准上进行评估。它随机抽取 10% 的 ALFRED 训练数据进行训练。高级规划器基于预训练的 T5-small [30] 模型,该模型经过微调,可根据目标指令生成高级规划。低级规划器是另一个经过微调的 T5-small 模型,其任务是为高级规划中的每个子目标生成一个低级规划。训练时需要目标指令和分步指令,但推理时只需要目标指令。

最后的最后

感谢你们的阅读和喜欢,我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你。

因为这个行业不同于其他行业,知识体系实在是过于庞大,知识更新也非常快。作为一个普通人,无法全部学完,所以我们在提升技术的时候,首先需要明确一个目标,然后制定好完整的计划,同时找到好的学习方法,这样才能更快的提升自己。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1092

1092

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?