如何几行代码替换常规卷积层并涨点?可变形卷积、动态卷积等新型卷积,真如论文中说的那么好用吗?

PP-YOLO:

The effectiveness of Deformable Convolutional Networks (DCN) has been verifified in many detection models. DCN itself will not signifificantly increase the number of parameters and FLOPs in the model,

but in practical application, too many DCN layers will greatly increase infer time.

Therefore, in order to balance the effificiency and effectiveness, we only replace 3 × 3 convolution layers in the last stage with DCNs.

CenterNet也也是类似做法。

似乎大部分网络,都可以把最后几层conv换成可变形卷积?除了轻微增加推断速度,有的硬件不支持,有没有其他缺点(诸如对某些场景泛化性差)?

什么前提条件都没说,通常情况下只能说maybe,why don’t you just try,这两年打比赛检测经常选cascade rcnn+FPN+DCN,作为baseline,你自己品

其他卷积:

Justin ho:变形卷积核、可分离卷积?卷积神经网络中十大拍案叫绝的操作。

微软亚洲研究院:CVPR 2020丨动态卷积:自适应调整卷积参数,显著提升模型表达能力

《动态卷积神经网络》精彩回顾

极市平台:动态卷积超进化!通道融合替换注意力,减少75%参数量且性能显著提升|ICLR 2021

看来 可以开始排列组合替换常规卷积了。

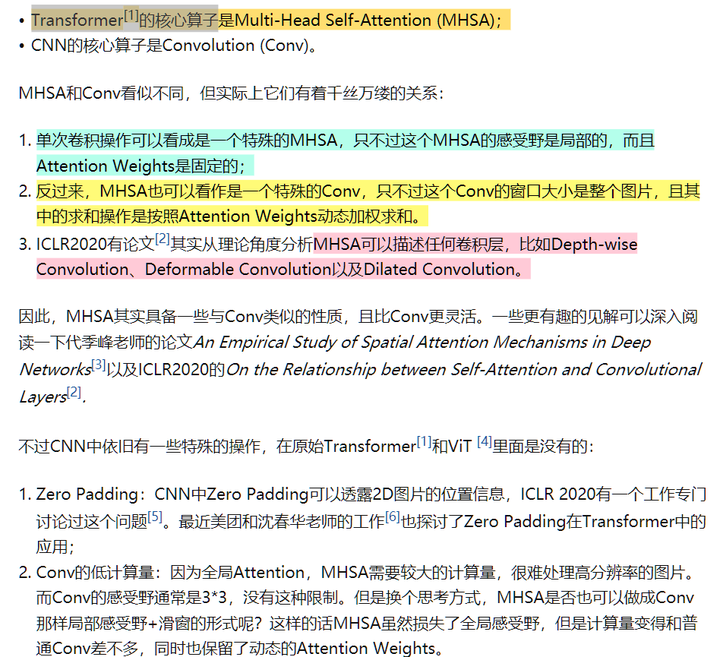

理论上,多头自注意力算子,可以描述任何卷积层(后面又说CNN可以有padding,MHSA不行…)

理论上,3层MLP可以打遍天下?但实际不太行?

所谓的“MLP is all you need" 里面,MLP其实是用Conv实现

input不是vector的FC:可视为巨大的Conv

Conv:可视为FC的特例(但写代码时,应该不能用FC实现Conv)

1*1的卷积核和全连接层有什么异同? - 胆大路野的回答 - 知乎 https://www.zhihu.com/question/274256206/answer/1885054034

华来知识:Transformer 是 CNN 是 GNN 是 RNN ?59 赞同 · 3 评论文章

On the Relationship between Self-Attention and Convolutional Layers

一个多头自注意力机制层+ 1个相对位置编码 = 任意卷积层。

多头是为了能关注类似 CNN 感知域中的每个像素位置,所以 N 头自注意力可以模拟感知域为 ??的 CNN 卷积核。

Transformers are Graph Neural Networks | NTU Graph Deep Learning Lab

graphdeeplearning.github.io/post/transformers-are-gnns/

Transformers are RNNs: Fast Autoregressive Transformers with Linear Attention.

来源讨论

https://www.zhihu.com/question/409402852

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?