SimAM: A Simple, Parameter-Free Attention Module for Convolutional Neural Networks

Venue:ICML 2021

Paper address: http://proceedings.mlr.press/v139/yang21o/yang21o.pdf

Github address: https://github.com/ZjjConan/SimAM

Abstract

本文提出一种概念简单且非常有效的注意力模块。不同于现有的通道/空域注意力模块,该模块无需额外参数为特征图推导出3D注意力权值。具体来说,本文基于著名的神经科学理论提出优化能量函数以挖掘神经元的重要性。本文进一步针对该能量函数推导出一种快速解析解并表明:该解析解仅需不超过10行代码即可实现。该模块的另一个优势在于:大部分操作均基于所定义的能量函数选择,避免了过多的结构调整。最后,本文在不同的任务上对所提注意力模块的有效性、灵活性进行验证。

Motivation

- 现有的注意力模块。比如空间注意力、通道注意力、他们只能沿着通道或空间维度细化特征,要么平等地对待一个通道中的所有神经元,要么平等地对待一个空间位置上的所有神经元,这限制了他们学习跨通道和空间变化的注意力权重的灵活性。

- 注意力模块的另一个重要因素是权重生成方法。大多数现有的工作基于一些无基础的启发式算法来计算注意力权重。即现有注意力的结构设计需要大量的工程性实验

Contributions

- 受启发于人脑注意力机制,本文提出一种3D注意力模块并设计了一种能量函数用于计算注意力权值;

- 本文推导出了能量函数的解析解加速了注意力权值的计算并得到了一种轻量型注意力模块;

- 将所提注意力嵌入到现有ConvNet中在不同任务上进行了灵活性与有效性的验证。

Method

在正式介绍本文所提注意力模块之前,作者先对现有代表性注意力模块(比如SE、CBAM、GC)进行简要总结;然后,我们再引出本文所提完全不同架构的注意力模块。

Overview of Existing Attention Modules

上图a与b列出了现有两种类型的注意力模块:

- 通道注意力:1D注意力,它对不同通道区别对待,对所有位置同等对待;

- 空域注意力:2D注意力,它对不同位置区别对待,对所有通道同等对待。

一方面:

作者在论文里面举了一个例子:

以下图为例,SE注意力机制缺失了关于"grey_whale"的某些重要成分。我们认为3D注意力比1D和2D更佳,进而提出了上图c的3D注意力模块。

另一方面:

现有注意力模块的另一个重要影响因素:权值生成方法。现有注意力往往采用额外的子网络生成注意力权值,比如SE的GAP+FC+ReLU+FC+Sigmoid。更多注意力模块的操作、参数量可参考下表。总而言之,现有注意力的结构设计需要大量的工程性实验。我们认为:注意力机制的实现应当通过神经科学中的某些统一原则引导设计。

Our Attention Module

已有研究BAM、CBAM分别将空域注意力与通道注意力进行并行或串行组合。然而,人脑的两种注意力往往是协同工作,因此,我们提出了统一权值的注意力模块。

为更好的实现注意力,我们需要评估每个神经元的重要性。在神经科学中,信息丰富的神经元通常表现出与周围神经元不同的放电模式。而且,激活神经元通常会抑制周围神经元,即空域抑制。换句话说,具有空域抑制效应的神经元应当赋予更高的重要性。最简单的寻找重要神经元的方法:度量神经元之间的线性可分性。因此,我们定义了如下能量函数:

其中,

t

^

=

w

t

t

+

b

t

\hat{t}={w_t}t+b_t

t^=wtt+bt,

x

i

^

=

w

t

x

i

+

b

t

\hat{x_i}={w_t}{x_i}+b_t

xi^=wtxi+bt。最小化上述公式等价于训练同一通道内神经元t与其他神经元之间的线性可分性。为简单起见,我们采用二值标签,并添加正则项,最终的能量函数定义如下:

理论上,每个通道有

M

=

H

×

W

M={H}\times{W}

M=H×W个能量函数。幸运的是,上述公式具有如下解析解:

其中,

μ

t

=

1

M

−

1

∑

i

=

1

M

−

1

x

i

\mu_t=\frac {1} {M-1}\sum_{i=1}^{M-1} {x_i}

μt=M−11∑i=1M−1xi,

σ

t

2

=

1

M

−

1

∑

i

=

1

M

−

1

(

x

i

−

μ

t

)

2

\sigma_t^{2}=\frac {1} {M-1}{\sum_{i=1}^{M-1} (x_i-\mu_t)^2}

σt2=M−11∑i=1M−1(xi−μt)2。因此,最小能量可以通过如下公式得到:

上述公式意味着:能量越低,神经元t与周围神经元的区别越大,重要性越高。因此,神经元的重要性可以通过

1

e

t

∗

\frac {1} {e_t^{*}}

et∗1得到。

到目前为止,我们推导了能量函数并挖掘了神经元的重要性。按照注意力机制的定义,我们需要对特征进行增强处理:

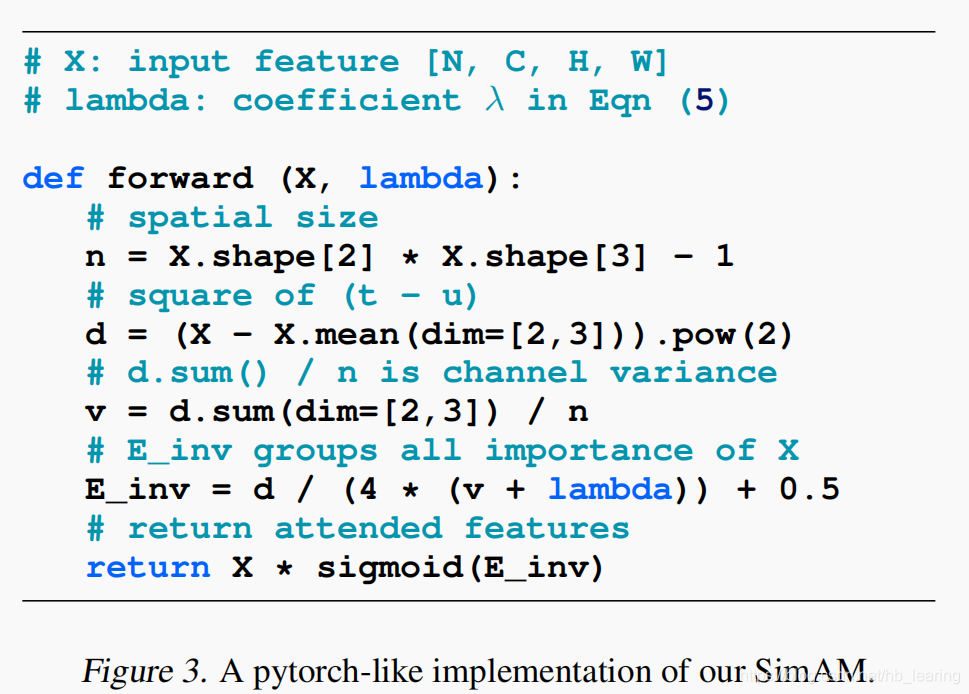

下图给出了SimAM的pytorch风格实现code。

Experiments

Experiments 1

上表给出了Cifar数据集上的性能对比,从中可以看到:

- 相比其他注意力机制,所提SimAM取得了最佳性能;

- 在小网络方面,PreResNet56在CIFAR10数据集上取得了最佳性能(92.47/69.13),显著优于其他注意力;

- 在大网络方面,所提SimAM同样优于SE与CBAM等注意力机制;

- 上述实验结果均表明:所提无参注意力SimAM是一种通用注意力机制,并不局限于特定网络。

Experiments 2

上表给出了ImageNet数据集上不同注意力机制的性能对比,从中可以看到:

-

所有注意力模块均可以提升基线模型的性能;

-

所提SimAM在ResNet18与ResNet101基线上取得了最佳性能提升;

-

对于ResNet34、ResNet50、ResNeXt50、MobileNetV2,所提SimAM仍可取得与其他注意力相当性能;

-

值得一提的是,所提SimAM并不会引入额外的参数; 在推理速度方面,所提SimAM与SE、ECA相当,优于CBAM、SRM。

Experiments 3

上图对比了不同$$的性能对比,从中可以看到:

- 所提注意力机制对于超参非常鲁棒;

- λ = 0.0001 \lambda=0.0001 λ=0.0001得了最佳的性能均衡。

Experiments 4

上图采用Grad-CAM对所提SimAM进行了可视化,可以看到:经由SimAM提炼的特征可以更好的聚焦主体目标。

Experiments 5

上表对比了COCO检测、分割任务上的性能,可以看到:

-

SE与SimAM均可大幅提升基线模型的性能;

-

对于检测任务,两种注意力模块取得了非常相似的性能;

-

对于实例分割任务,所提SimAM取得了稍优性能。

-

值得一提,SimAM不会引入额外参数量,而SE则会引入额外的参数量。比如,SE-ResNet50引入了2.5M参数量,SE-ResNet101引入了4.7M参数量。

Highlights

-

现有注意力模块的另一个重要影响因素:权值生成方法。现有注意力往往采用额外的子网络生成注意力权值,比如SE的GAP+FC+ReLU+FC+Sigmoid.我们认为,注意力机制的实现应该由神经计算中的一些统一原则来指导。因此,我们基于一些成熟的神经科学理论提出了一种新的方法SimAM。

-

在神经科学中,信息丰富的神经元通常表现出与周围神经元不同的放电模式。而且,激活神经元通常会抑制周围神经元,即空域抑制。换句话说,具有空域抑制效应的神经元应当赋予更高的重要性。最简单的寻找重要神经元的方法:度量神经元之间的线性可分性。

523

523

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?