SCI一区级 | Matlab实现BO-Transformer-BiLSTM多变量时间序列预测

效果一览

基本介绍

1.【SCI一区级】Matlab实现BO-Transformer-BiLSTM多变量时间序列预测,贝叶斯优化Transformer结合BiLSTM双向长短期记忆神经网络多变量时间序列预测,BO-Transformer-BiLSTM/Bayes-Transformer-BiLSTM(程序可以作为SCI一区级论文代码支撑,目前尚未发表);

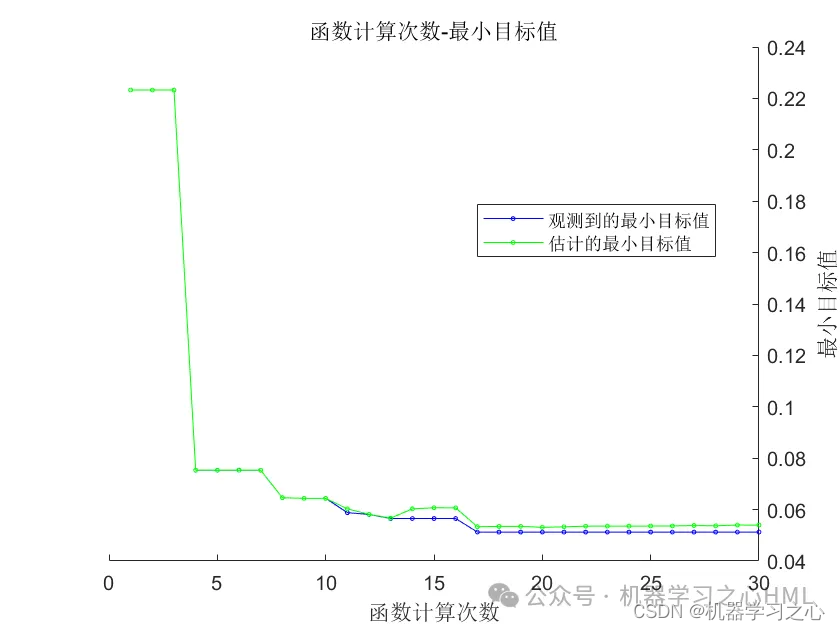

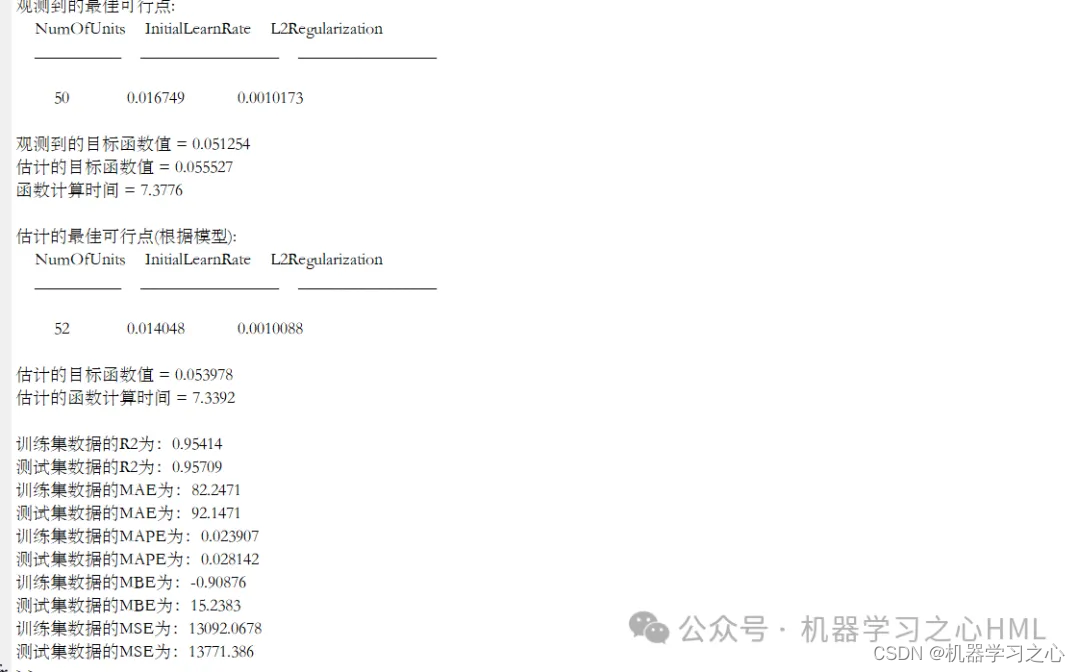

2.贝叶斯优化参数为:学习率,BiLSTM隐含层节点,正则化参数,运行环境为Matlab2023b及以上;

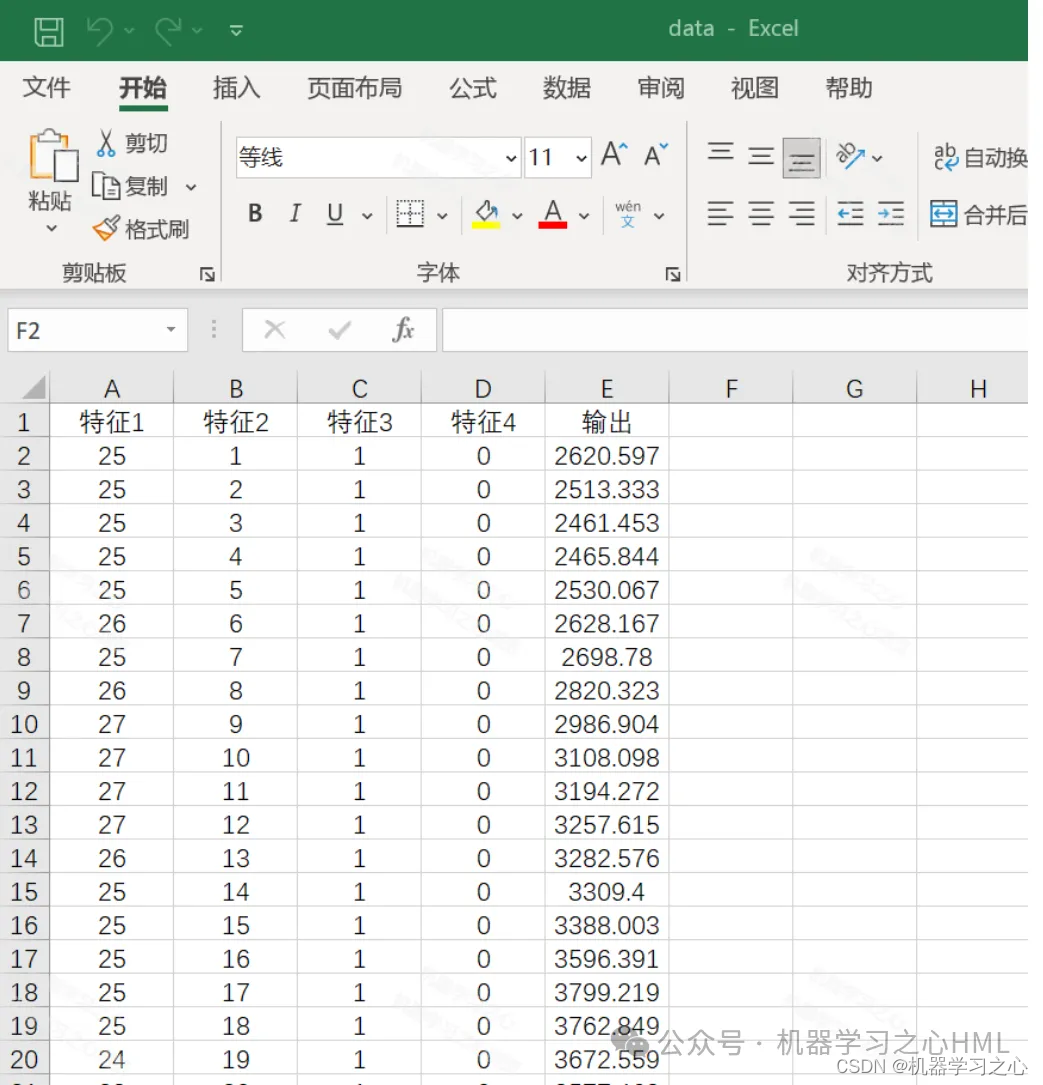

3.data为数据集,输入多个特征,输出单个变量,考虑历史特征的影响,多变量时间序列预测,main.m为主程序,运行即可,所有文件放在一个文件夹;

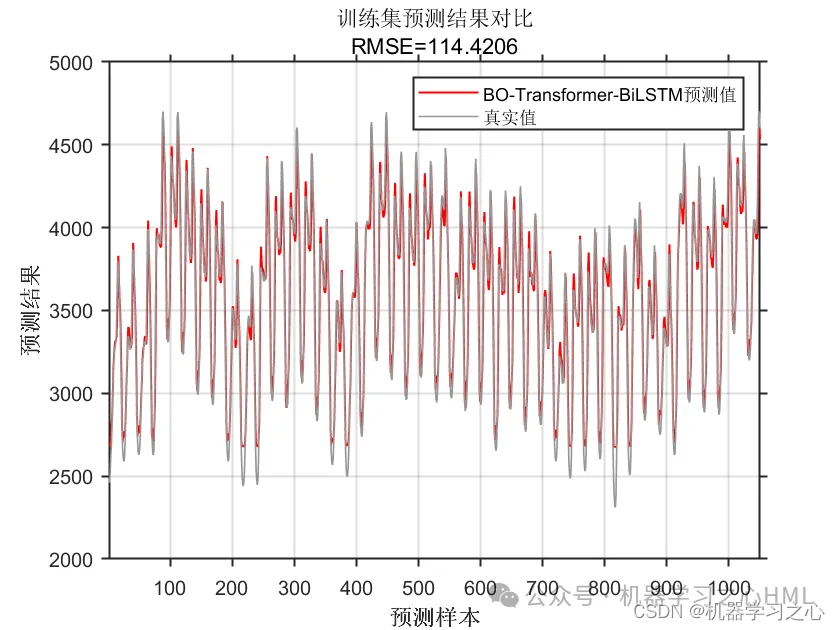

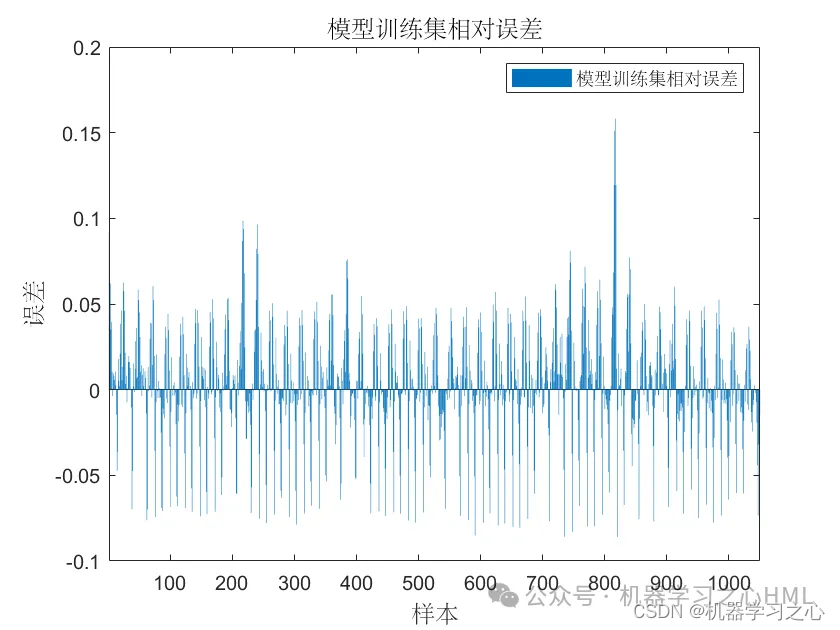

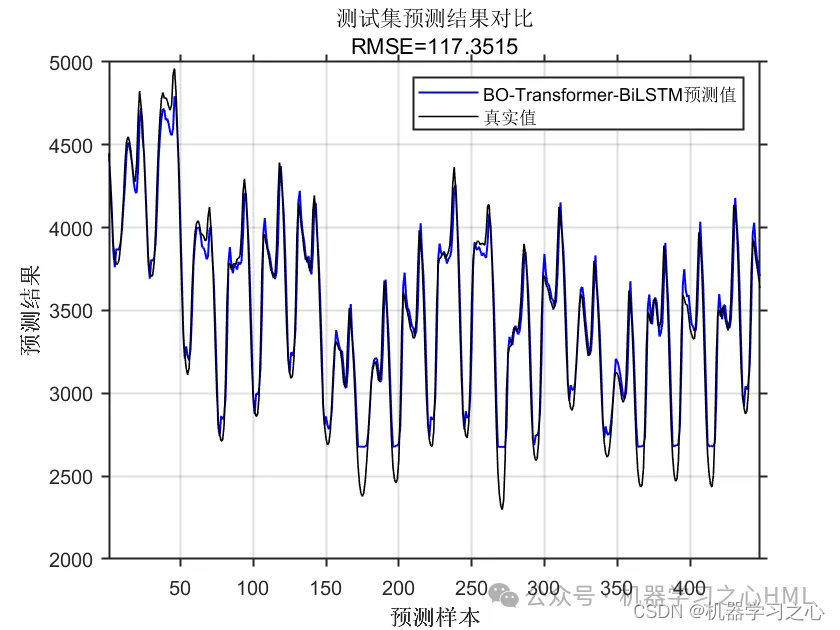

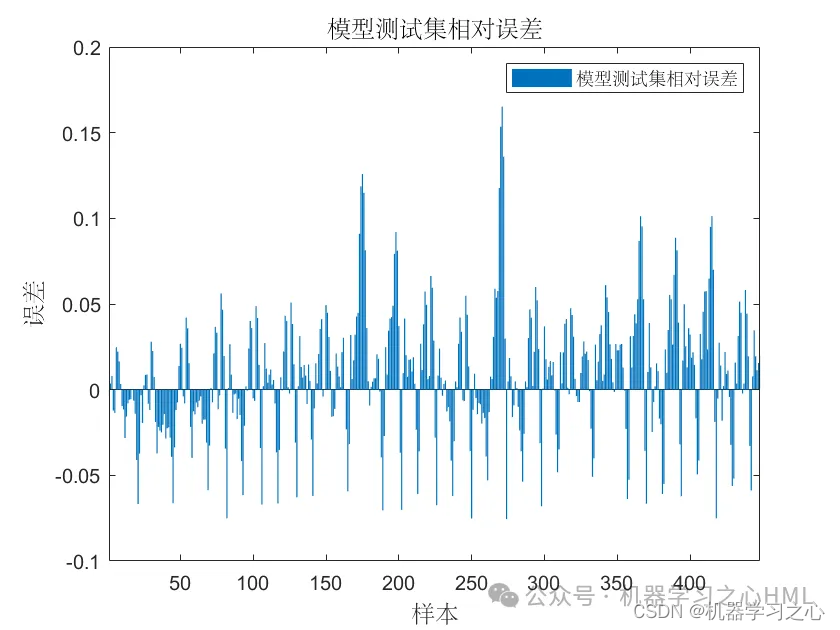

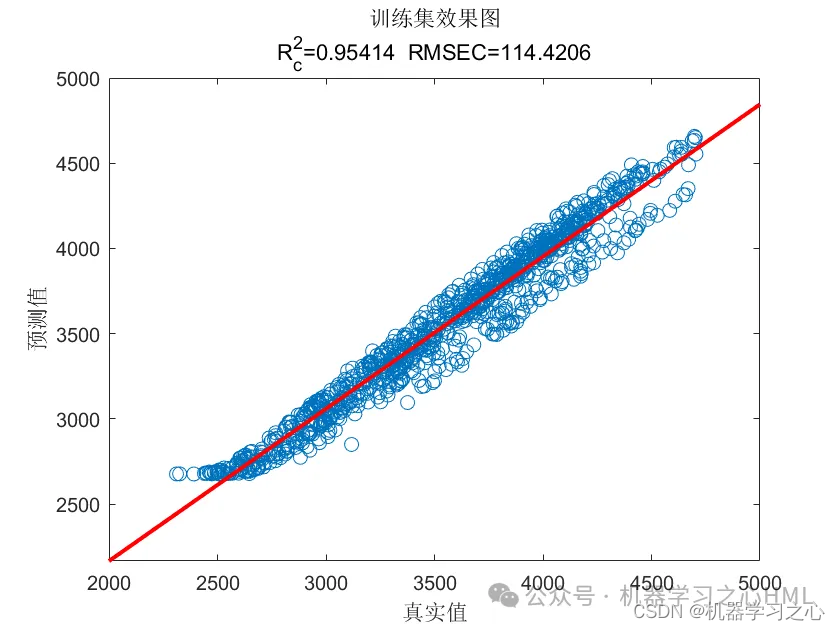

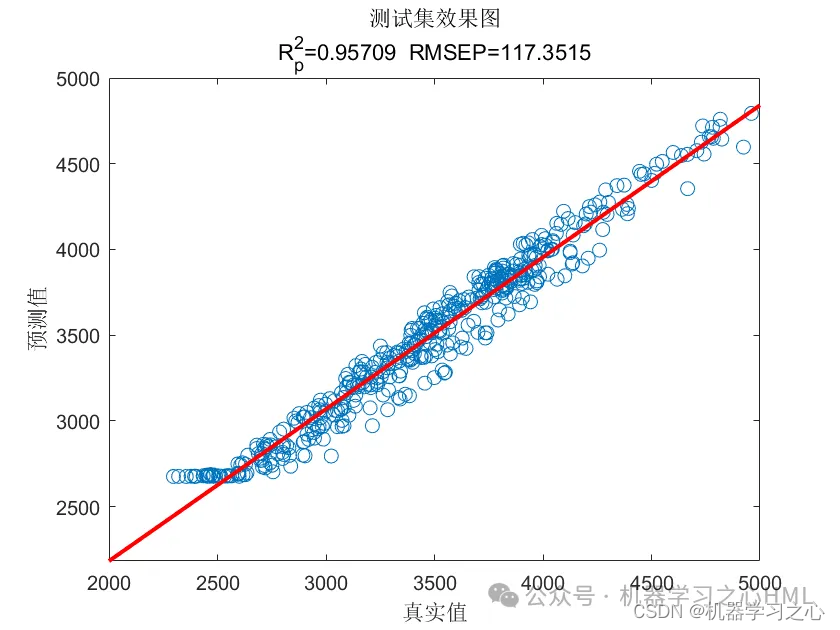

4.命令窗口输出R2、MSE、RMSE、MAE、MAPE、MBE等多指标评价;

程序设计

- 完整程序和数据下载私信博主回复Matlab实现BO-Transformer-BiLSTM多变量时间序列预测。

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

%% 导入数据

result = xlsread('data.xlsx');

%% 数据分析

num_samples = length(result); % 样本个数

or_dim = size(result, 2); % 原始特征+输出数目

kim = 2; % 延时步长(kim个历史数据作为自变量)

zim = 1; % 跨zim个时间点进行预测

%% 数据集分析

outdim = 1; % 最后一列为输出

num_size = 0.7; % 训练集占数据集比例

num_train_s = round(num_size * num_samples); % 训练集样本个数

f_ = size(res, 2) - outdim; % 输入特征维度

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

%% 数据归一化

[P_train, ps_input] = mapminmax(P_train, 0, 1);

P_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

%% 数据平铺

P_train = double(reshape(P_train, f_, 1, 1, M));

P_test = double(reshape(P_test , f_, 1, 1, N));

t_train = t_train';

t_test = t_test' ;

%% 数据格式转换

for i = 1 : M

p_train{i, 1} = P_train(:, :, 1, i);

end

for i = 1 : N

p_test{i, 1} = P_test( :, :, 1, i);

end

%% 创建待优化函数

ObjFcn = @BOFunction;

%% 贝叶斯优化参数范围

optimVars = [

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/128163536?spm=1001.2014.3001.5502

[2] https://blog.csdn.net/kjm13182345320/article/details/128151206?spm=1001.2014.3001.5502

704

704

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?