往期相关推送(持续更新中!):

[ICASSP 2024] CDNMF: 一个可信且高效的社区检测(社区发现,图聚类,Community Detection)方法-CSDN博客

[论文分享] DGI 图对比学习:局部-全局对比,最大化互信息-CSDN博客

[论文分享] GraphCL:图对比学习的增强方式,如何构造正样本?-CSDN博客

Understanding the Behaviour of Contrastive Loss 论文解析

Motivations

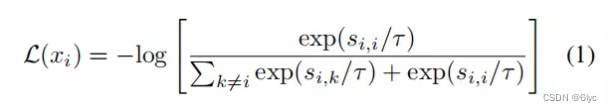

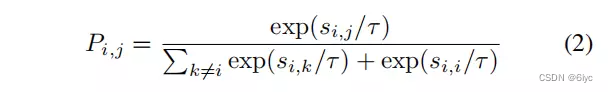

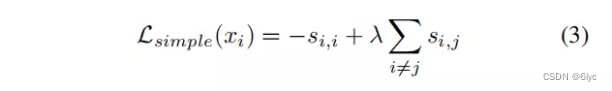

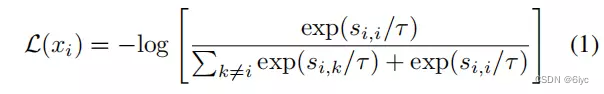

我们一般默认使用的对比学习Loss是NT-Xent:

但是并没有去分析该loss的运行机制以及温度系数的作用。

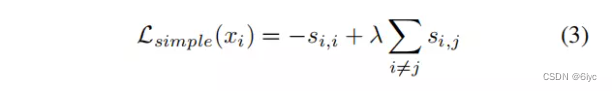

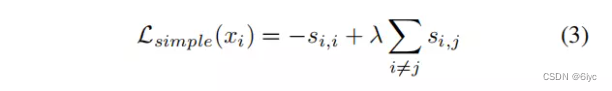

比如,为什么对比学习loss(1)效果优于对比学习loss(3)呢?

本文中,作者证明了对比损失是一个hardness-aware损失函数,而温度τ控制了对hard负样本的惩罚强度(关注程度)。先前的研究表明,表征空间的均匀性是对比学习的一个关键特性。作者建立了均匀性与温度τ之间的关系。

Hardness-aware 属性

梯度分析

(1)NT-Xent促进了表征空间的均匀性

![]()

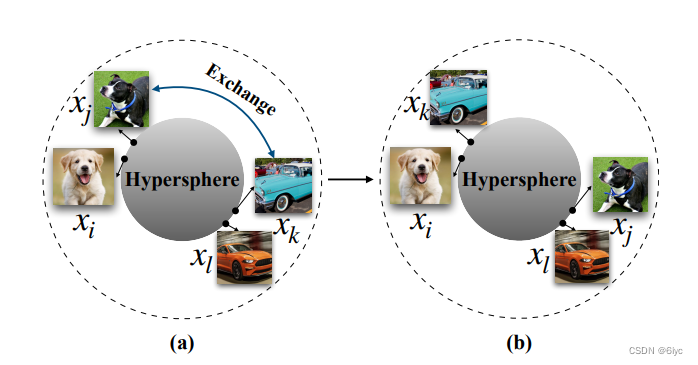

f(·)是一个特征提取器,它将图像从像素空间映射到超球面空间。

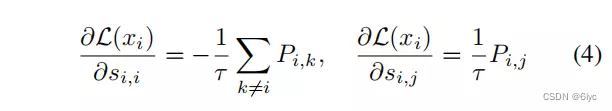

对于正负样本相似度的梯度:

Hardness-aware Property

相对于负样本的梯度与指数项exp(si,j/τ)成正比,也就是说si,j越大,即负样本与锚点更相似,那么给予负样本表征更大的更新梯度。对于那些已经远离的样本,不需要继续让其远离,而主要聚焦在让没有远离的那些的负样本远离,从而使得到的表示空间更均匀(uniformity)

温度系数的作用: 进一步控制Hardness-aware作用

温度系数的作用是调节对困难样本的关注程度:越小的温度系数越关注于将本样本和最相似的其他样本分开。(增强NT-Xent loss的功能)

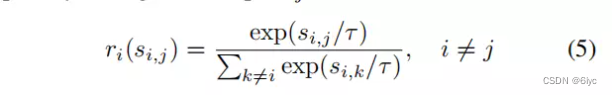

定义对第j个负样本的相对惩罚强度:

![]()

(我们有![]() )(r ~ Boltzman distribution)

)(r ~ Boltzman distribution)

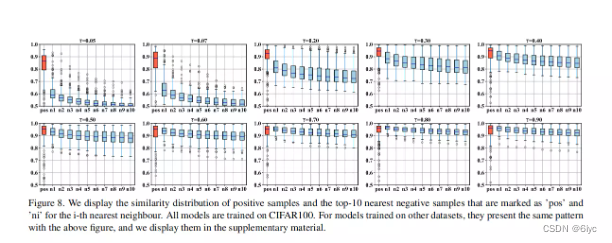

随着温度系数的降低,相对惩罚(对负样本的关注)更集中在高相似度区域,而随着温度系数的升高,相对惩罚分布趋于均匀,这往往使所有负样本具有相同的梯度更新幅度。此外,随着温度系数的降低,有效惩罚区间逐渐缩小。极小的温度系数会导致对比损只关注与锚点最近的一个或两个样本上,这将严重降低性能。

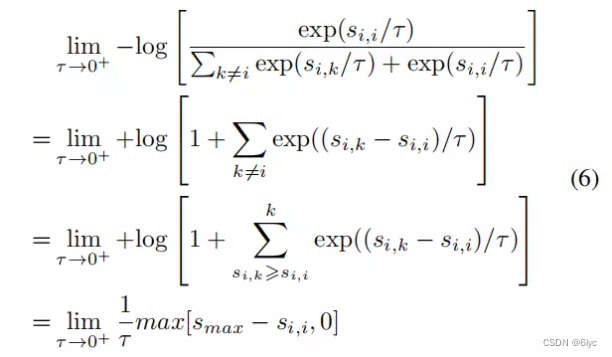

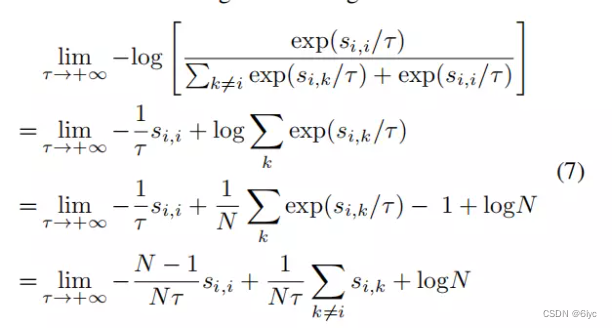

分析两种极端情况:

当τ→0+时,对比损失只关注于离锚点最近的负样本(相似性距离度量)。因为只与s_max中的负样本相关。

此时对比损失对所有负样本的权重(梯度)都相同,1/N*tau

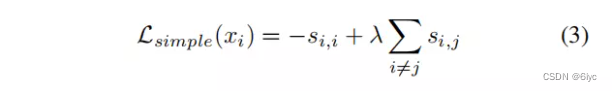

且等价于简单对比损失

所以说简单对比损失没有Hardness-aware能力,表征空间不均匀。

均匀性-容忍性困境(Uniformity-Tolerance Dilemma)

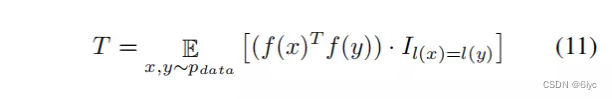

容忍性:指对比学习Loss对潜在正样本(语义相似样本)的容忍

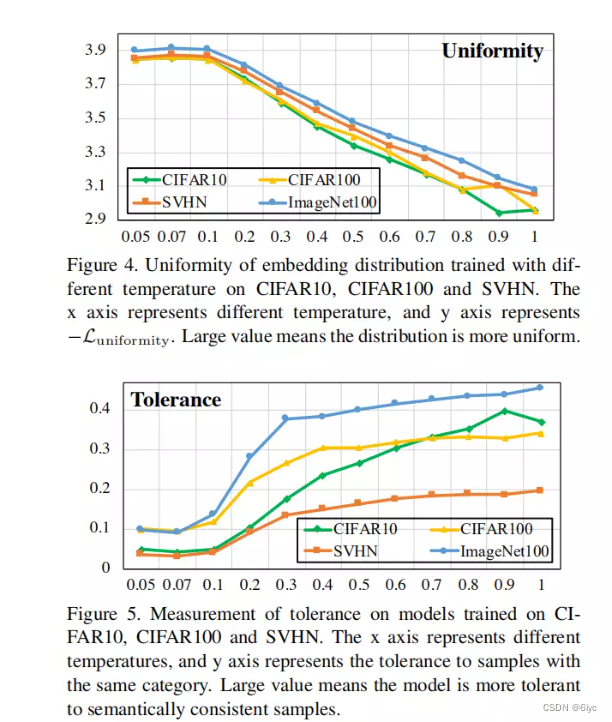

基于对温度系数作用的探索,作者进而指出了对比学习存在的潜在问题,即均匀性-容忍性的困境。

对于温度系数来说,更小的温度系数更加关注困难样本,因此更容易形成均匀的表示空间。但是另一方面,由于无监督学习中没有真正的类别标签,对比学习一般将除锚点以外的所有其他样本作为负样本。在这种情况下,与正样本相似度极高的负样本往往很可能是潜在的正样本。此时如果太注重hard负样本则会破坏网络经过一定训练后已经学到的语义信息,这种情况在训练后期尤其明显。随着训练的进行,网络获取到的信息越来越接近真实语义特性,那么此时的负样本更有可能是潜在的正样本。一个理想的特征空间应该是局部聚类和全局均匀的。

感觉可以做一个温度系数自适应变化,可学习(比如随着训练变大),类似自适应学习率的想法·。

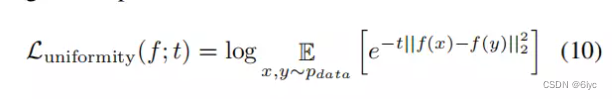

基于高斯势核的均匀性度量(应用别人的方法):

有将同类样本分离的趋势

使用属于同一类的样本的平均相似度来衡量对语义一致的样本的容忍度:

实验

contrastive:

simple:

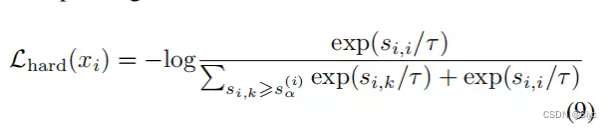

Hard contrastive:

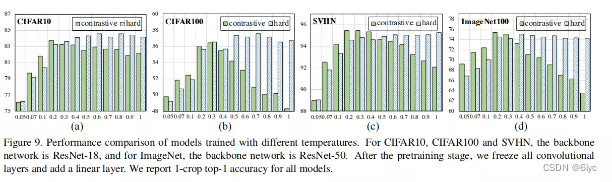

可以选择相对大一点的温度系数

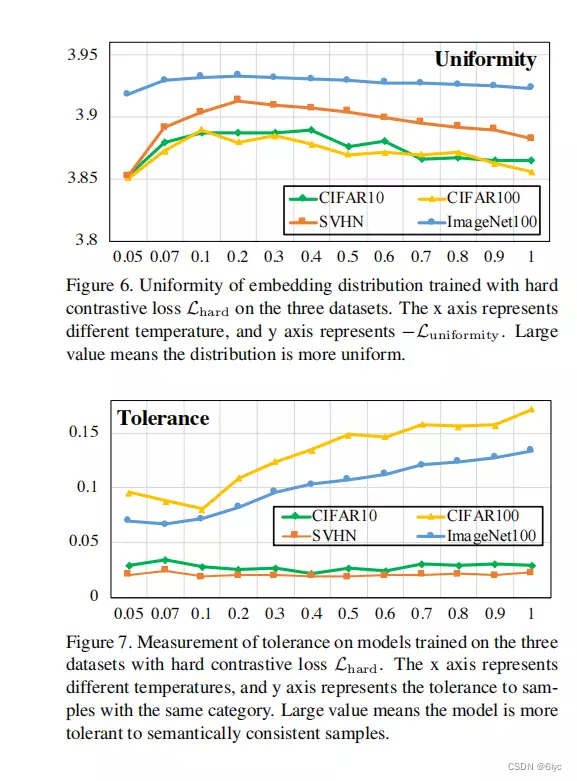

对于hard对比损失,情况如图6所示。以hard对比损失为目标时,其分布趋于更加均匀。此外,与普通的对比损失相比,均匀性随温度的变化而保持相对稳定。显式hard负采样减弱了温度系数对控制Hardness-aware特性的影响

与普通的对比损失相比,hard对比损失均匀性保持相对稳定。相对较大的温度系数有助于对比损失容忍潜在的正样本,而不会降低太多的均匀性。作者认为这是因为显式hard负采样策略对于生成均匀的嵌入分布非常有效。

HardSimple:

外加explicit hard negative sampling strategy,即直接采用hard 负样本。

体现温度系数的作用:

参数分析:

参考文献

[0] Wang F, Liu H. Understanding the behaviour of contrastive loss[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2021: 2495-2504.

[1] Li Y, Chen J, Chen C, et al. Contrastive Deep Nonnegative Matrix Factorization for Community Detection[J]. arXiv preprint arXiv:2311.02357, 2023.

[2] Li Y, Hu Y, Fu L, et al. Community-Aware Efficient Graph Contrastive Learning via Personalized Self-Training[J]. arXiv preprint arXiv:2311.11073, 2023.

642

642

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?