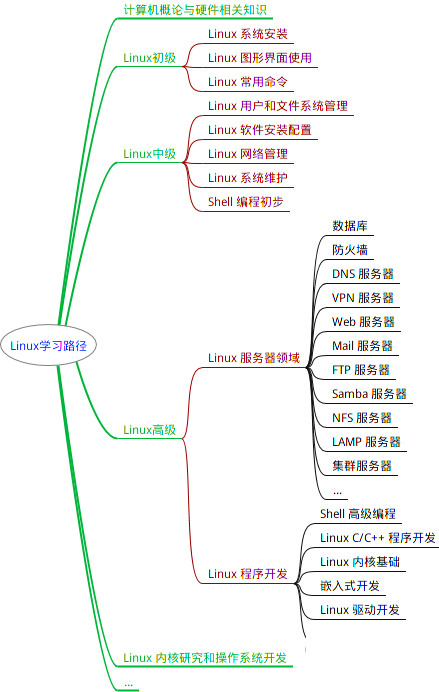

最全的Linux教程,Linux从入门到精通

======================

-

linux从入门到精通(第2版)

-

Linux系统移植

-

Linux驱动开发入门与实战

-

LINUX 系统移植 第2版

-

Linux开源网络全栈详解 从DPDK到OpenFlow

第一份《Linux从入门到精通》466页

====================

内容简介

====

本书是获得了很多读者好评的Linux经典畅销书**《Linux从入门到精通》的第2版**。本书第1版出版后曾经多次印刷,并被51CTO读书频道评为“最受读者喜爱的原创IT技术图书奖”。本书第﹖版以最新的Ubuntu 12.04为版本,循序渐进地向读者介绍了Linux 的基础应用、系统管理、网络应用、娱乐和办公、程序开发、服务器配置、系统安全等。本书附带1张光盘,内容为本书配套多媒体教学视频。另外,本书还为读者提供了大量的Linux学习资料和Ubuntu安装镜像文件,供读者免费下载。

本书适合广大Linux初中级用户、开源软件爱好者和大专院校的学生阅读,同时也非常适合准备从事Linux平台开发的各类人员。

需要《Linux入门到精通》、《linux系统移植》、《Linux驱动开发入门实战》、《Linux开源网络全栈》电子书籍及教程的工程师朋友们劳烦您转发+评论

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

3.2D到3D转换(FLoSP)

说实话我感觉这个和FastBEV一样,这个多尺度的图片投影到不同的尺度的3D体素中,然后再聚合不同尺度的3D特征。

4.3D CRP

因为语义分割场景高度依赖于上下文的一个关系,所以论文里在3Dunet底部加入了一个CRP的结构,从而为网络提供了一个全局的感受野。这里因为全局语义分割存在极度的不均衡,所以单纯的二分类其实是次要的,论文里提出了体素与体素之间的一个关系,从而增强模型的上下文之间的关联。这里怎么划分体素之间的关系我有点看不懂原文的描述,原文这里很乱。

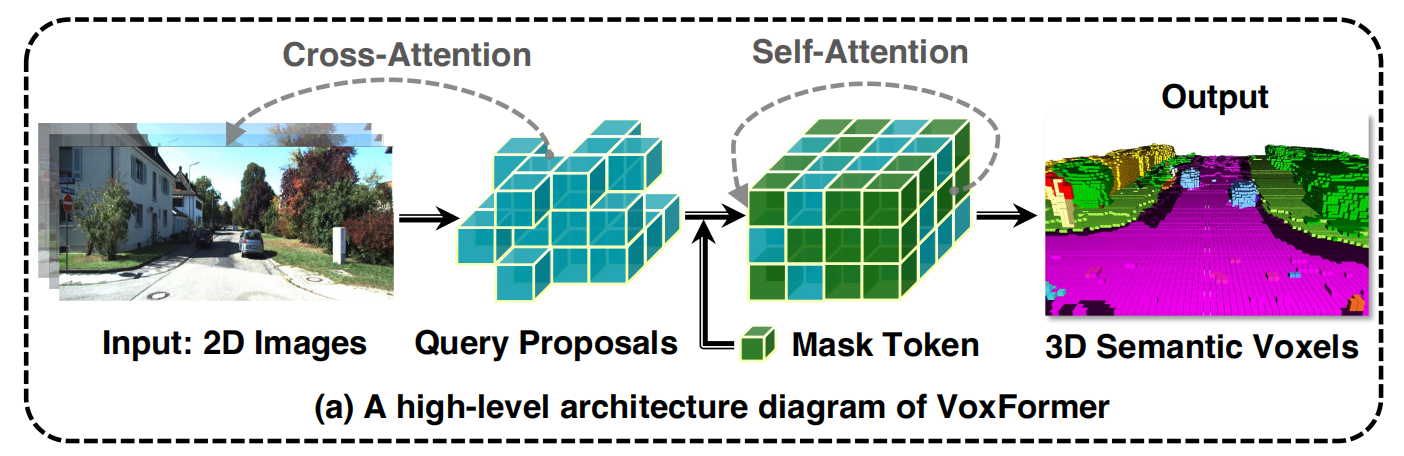

二、 VoxFormer

1.摘要

a.提出一种两阶段的框架,使用图像生成完整的3D体素化语义场景。

b.预测图像深度,再生成稀疏的体素,使用transformer进一步得到完整的体素语义场景 。

2.模型结构

先对图像的特征进行提取,同时对其深度也进行估计,根据相机内外参投影到体素里,得到一个稀疏的Q,这个Q与图像特征进行交叉注意力机制,加上mask token后再做一个自注意力的操作,相当于对语义场景进行补全,最后上采样做多类别语义分割。

3. 第一阶段的query

初始化定义的query是忽略类别的,h*w*z*d,这个尺度相较于最终的语义分割尺度进行了2倍降采样,主要是为了提高模型的一个鲁棒性,防止因为深度预测误差过大,像素点没有落到该有的体素内。

根据深度估计和相机内外参,我们可以得到许多3D空间的点云,但此时这个点云是非常不可靠的,特别是在远处,几个点云决定了一大片区域的深度。为了降低深度容错和提高模型的鲁棒性,使用了一个简化版的unet网络对Min(H*W*D)进行卷积占据预测,输出Mout(h*w*d)表示是否占据。

根据是否占据,我们在q里面选择占据的query出来,组成Qp。这里有个疑问Qp的个数会变化呀?不是固定数量的query也可以吗?这里的好处是跳过空白的区域,只对图像上看到的地方进行query。

4.第二阶段补全query后的语义分割

使用deformable交叉注意力机制,Qp有一个3D坐标,投到图像上有一个参考点,根据偏移和权重,在多个时序图上进行特征的提取。经过几层可变形交叉注意力之后,我们把Qp与mask token结合得到完整的体素特征。然后使用可变形自注意力机制,对完整的体素特征进行细化。然后再上采样到原始的分辨率,对其进行多类别语义分割。

这里的mask token是一个d维的可学习向量,主要用于填充第一阶段没有对应图像的一些体素,同时这些mask token也加入了位置编码,来让其对自己的位置有一定的了解。

三、TPVFormer

1.摘要

a.提出了一种新颖的三维空间表示方法,相较于体素,计算量大大下降,相较于BEV,其对空间的细粒度三维结构表示更加丰富。

b.使用可变形注意力机制生成空间三视图,可以完成任意分辨率的空间占据表示。

2.模型结构

图像先通过backbone和Neck提取相应的特征,然后TPV query向图像进行可变形注意力机制查询,再加上三个平面之间的特征交互,最终生成TPV的特征,我们根据这个图,可以插值得到最终3D空间的占据预测。这里的TPV query是最终三个视图里面的每个像素点,t∈T。

3.Image cross attention

在进入这个模块时,先对TPV query添加位置编码。 考虑到TPV query的个数以及图像像素的个数,所以我们不进行全局注意力机制,而使用可变形注意力机制。比如一个俯视图的TPV query,他有一个xy,那么我们对z进行间隔采样,会得到许多3D点,然后我们对这些3D点向一张图像做投影,可以得到一些有效投影点,对这些有效投影点做可变形注意力机制,最后对六张图像的可变形注意力机制结果求平均。

4.Cross-View Hybrid-Attention

因为上面每个视图单独查询图像特征,他们之间并没有充分的交互,所以提出交叉视图混合注意力机制,有利于上下文特征的提取。比如俯视图上一个点,我们直接在其周围生成一些参考点,然后沿着z生成几个3D点,投影到前视图和左视图,又能得到几个参考点,对这些参考点做可变形注意力机制,得到最终的特征。

四、SurroundOcc

1.摘要

a.使用由粗到细的思想策略,先生成小分辨率的体素特征,再逐步上采样,生成密集的体素特征。

b.针对占据网络稀疏的GT监督,论文提出了一种生成密集占据标签的方法。

2.模型结构

首先提取图像的多尺度特征信息,然后使用类似于bevformer的思想,使用可变形交叉注意力机制,完成2D到3D的特征转换,后续再加一些3D卷积。把低分辨率的3D体素特征逐层上采样合并,最后加head完成预测。我们对不同尺度的3D体素都施加监督,不过监督权重呈衰减形式,从上到下由大到小。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

5588

5588

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?