支持向量机基本型

线性分类器回顾

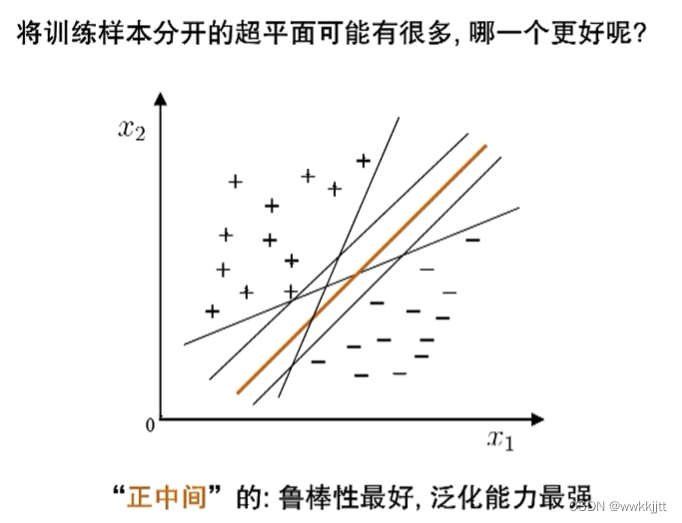

- 找一个超平面将正负类分开,那个最好呢?直觉上,正中间最好,即离正负类差不多的距离。正中间的是对轻微的扰动对最鲁棒的(最不敏感的),泛化能力最强。

- 那么我们如何将正中间的线找出来呢?

间隔与支持向量

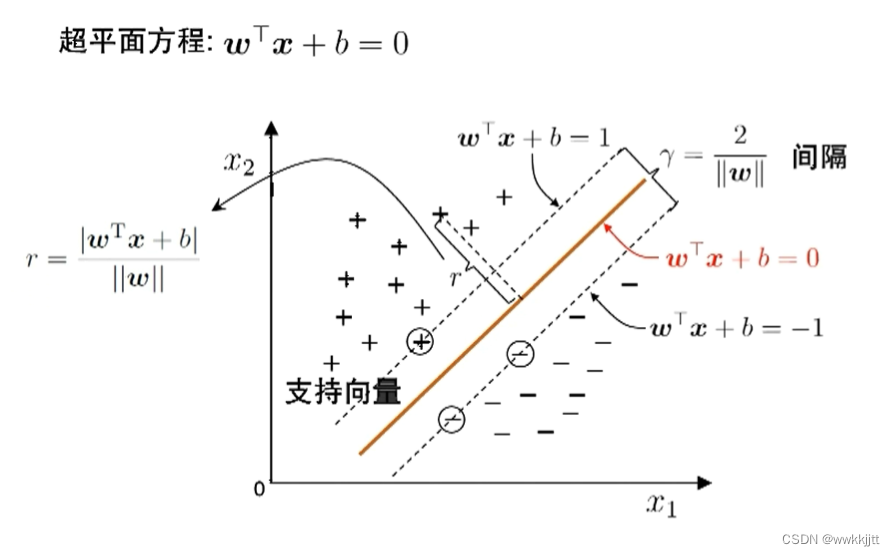

- 这几个标红的样本,是离超平面最近的样本,它们直接定义了中间这条线。我们把直接定义了这条线的红色点,称为支持向量。

- r表示点到直线的距离,我们现在假设支持向量(离该线最近的点)到直线的距离为1。

γ=2/||ω||,表示超平面相对于整个数据集的间隔。γ也可以称为该点到超平面的间隔。我们可以这样理解,当γ(间隔)越大,用超平面划分,越准确。

支持向量机基本型

-

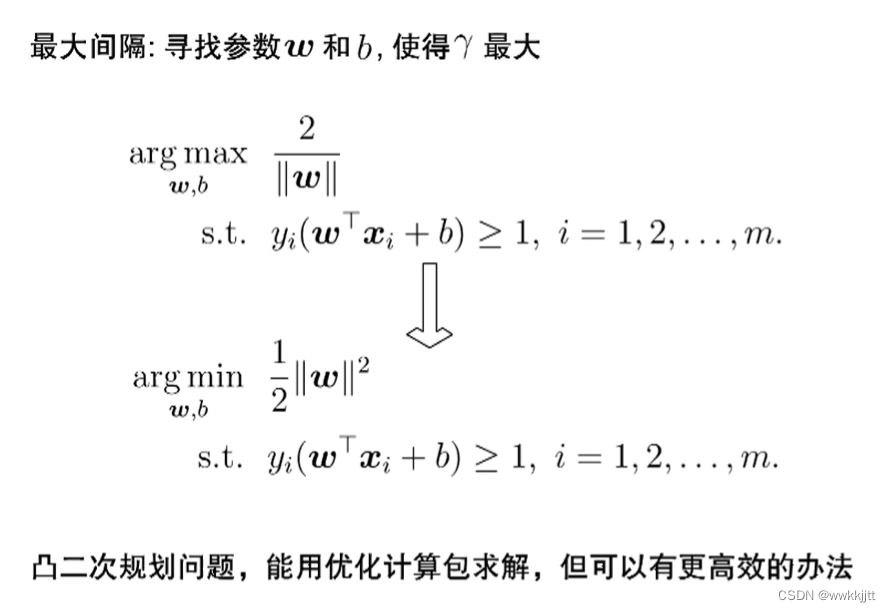

最大间隔,寻找参数ω和b,使间隔

γ最大 。 -

以上我们已经使样本离超平面的距离>=1。

(xi,yi)表示样本点,yi的取值在本例中只能是+或-。所以,yi*(ωT*xi+b)>=1。 -

我们习惯于做最小化,所以进行变换。接下来我们要对这个式子做优化。更高效的方法是拉格朗日乘子法。

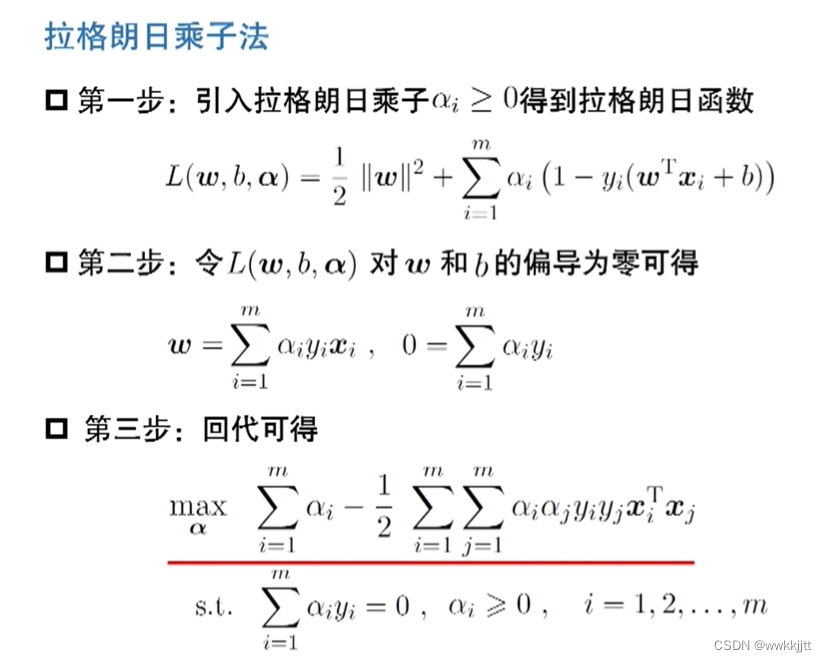

对偶问题

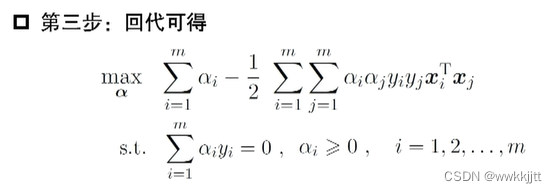

- 求解拉格朗日函数得到最小值。(这个问题是原来问题的对偶问题)对偶问题的最小值是原来目标函数的下界。希望原来函数尽可能好,要得到最好的下界,由此我们要对下界求极大。

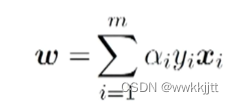

- 将第二步求得的式子,代入L(ω,b,a)中并求最大,得到第三步中划红线的式子。

提示:

- 解第三步的式子,得出α,α是指对每一个样本都有一个系数。例如:

有m个样本就有m个约束。

解的特性

-

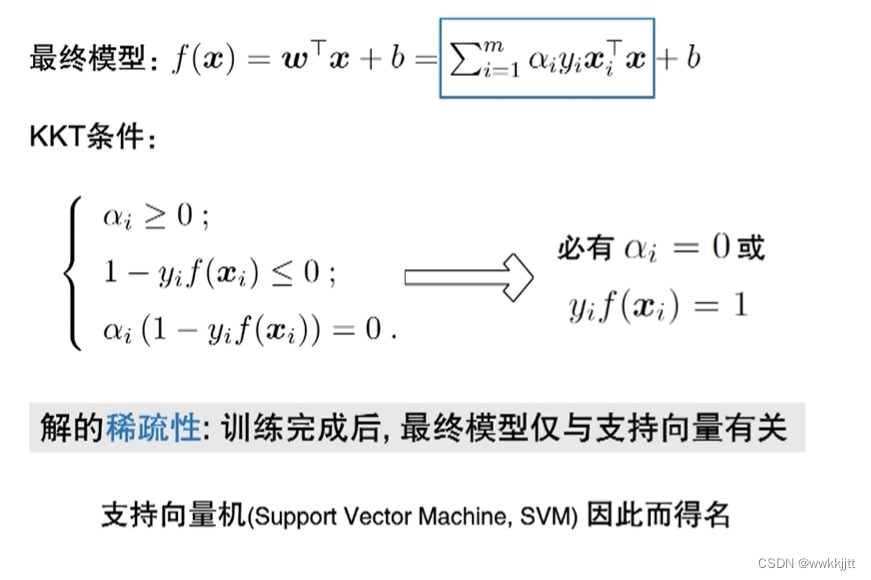

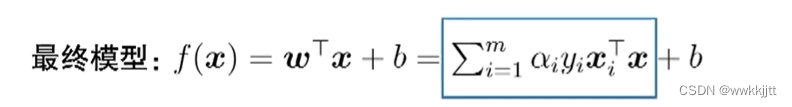

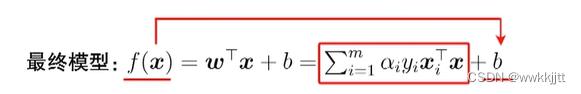

最终模型:

- 如果我们还是考虑

ωT+b,为线性方程的形式的话,得到最终模型。

提示:ω转置,只需要转置向量xi,无需转置标量αi,yi。

- 如果我们还是考虑

-

KKT条件:

- 如果αi=0,意味着以αi为系数的这个点,在最后预测的函数里面没有出现。

- 如果yi*f(xi)=1,

(yi的取值在本例中只能是+或-)则点恰好在间隔上。否则超过间隔则大于1。 - 存在于方程中用得到的点,一定是出现在

(离超平面最近的点,所在的平行于超平面的线上。即ωTx+b=1或ωTx+b=-1)上的点。假设我们有1000个点,大量的点都没有出现在间隔上。只有少量出现在间隔上的点,才出现在方程中。所以这就是,支持向量机解的稀疏性。

-

解的稀疏性:训练完成后,最终模型仅与支持向量有关。

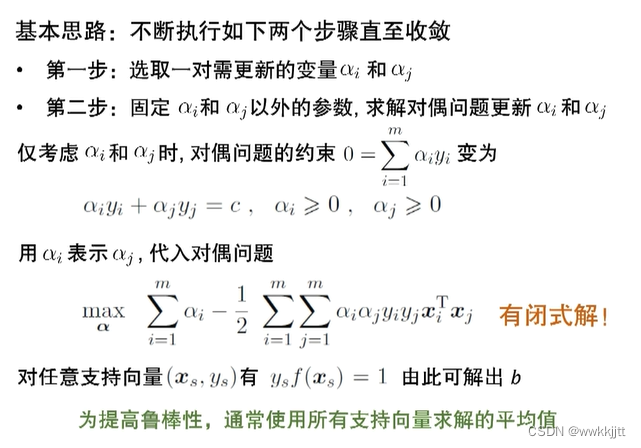

求解方法SMO

- 以上已经分析了解的特性,接下来介绍一种支持向量机最经典的解法—SMO

- 每次只考虑两个样本,

αi,αj,其他m-2个都是常数。

-

第二步:

- 根据约束条件,有:

αi*yi+αj*yj=c。可以用αi表示αj,代入对偶问题,那么该式仅有αi一个变量,则原式有闭式解。αi的数量与样本的总数有关,若想同时优化,问题会很复杂。- 所以使用SMO,取

α的两个,把第一个解出,得到第二个解…这样就可以迭代地解下去。

- 根据约束条件,有:

-

第一步(选取):

-

一对αi,αj如何取,最有效的取法:- 每一次更新之后,使得目标函数改变最多。

- 违反KKT条件最多,拿它来更新,目标函数就会提高的越大。

-

通过以上方法找出第一个点,第二点则找离第一个点间隔最远的点。

-

-

每次找违反条件最大的来更新,最后找不到,就收敛。

-

因为

ys*f(xs)=1,解出b。解出一个αi时,已经能够将b解出,但通常会使用所有的支持向量,求平均。

以上就是本文的全部内容,感谢各位的阅读与支持!

797

797

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?