概述

由于情绪在人机交互中扮演着重要角色,因此情绪识别备受研究人员关注。目前的情感识别研究主要集中在两个方面:一是识别刺激物引起的情感,并预测观众观看这些刺激物后的感受。另一个方面是分析图像和视频中的人类情绪。在本文中,这些任务统称为广义情感识别(GER)。

情绪可以通过文字、音频和视频等不同方式传达。其中,视觉信息(如色彩、亮度、面部表情、人类行为)包含丰富的情绪相关内容,在广义情绪识别任务中发挥着重要作用。为了提高视觉理解能力,研究人员提出了各种算法,并取得了显著进展。随着深度学习的发展,目前泛化情感识别的研究已从人工特征设计转向深度神经网络。

最近,GPT-4V 在各种任务中表现出了令人印象深刻的视觉理解能力。这就提出了一个问题:GPT-4V能在多大程度上解决泛化情绪识别问题?

2023 年 9 月,GPT-4V 被集成到 ChatGPT 中,并发布了调查其可视化功能的用户报告。然而,这些报告中每个任务的样本数量通常有限,只能提供有关 GPT-4V 的定性见解。openAI 于 2023 年 11 月发布了 API,最初仅限于每天 100 个请求。因此,GPT-4V 仍然难以与基准数据集的最先进系统进行对比评估。最近,OpenAI 增加了每日请求限制,以便进行更全面的评估。

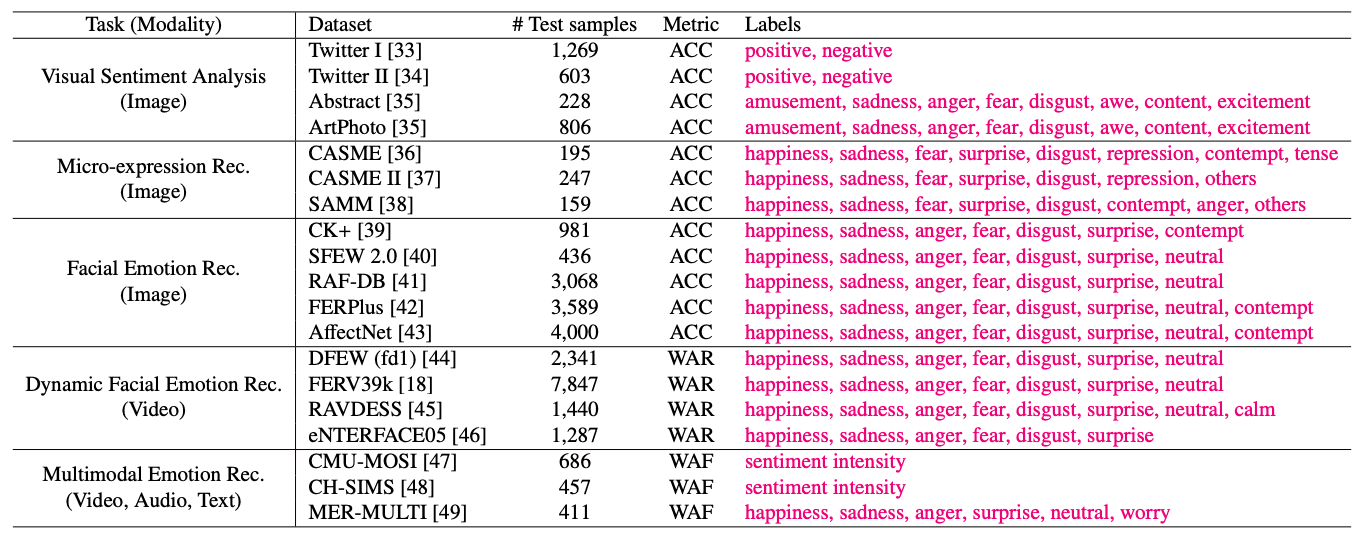

本文提供了 GPT-4V 在通用情感识别任务中的定量评估结果,包括视觉情感分析、微表情识别、面部情感识别、动态面部情感识别和多模态情感识别。

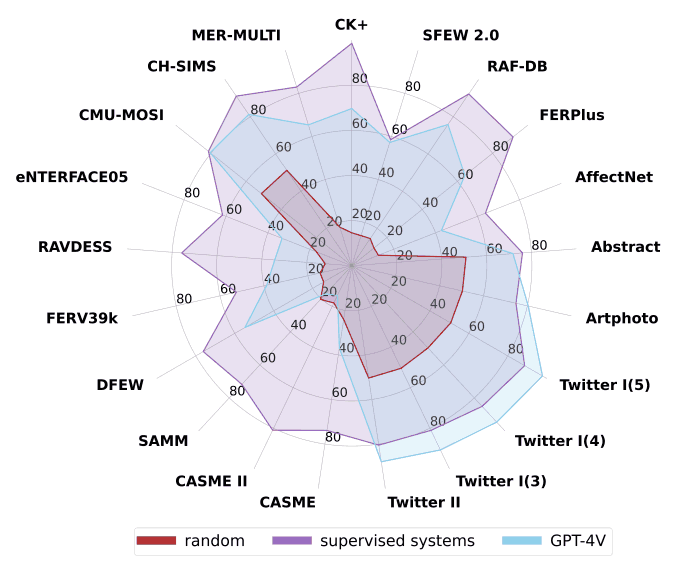

下图显示了 GPT-4V 的总体结果,其性能优于随机猜测,但与监督系统相比仍有差距。为了揭示其中的原因,我们对 GPT-4V 的多方面性能进行了综合分析,包括其多模态融合能力、时间建模能力、色彩空间鲁棒性和预测一致性。

本文旨在为后续研究人员提供建议,并就 GPT-4V 能够有效解决哪些任务以及哪些任务需要进一步探索提出问题。

实验概述

本文对 19 个数据集的五项任务进行了综合评估。下表提供了每个数据集的统计数据。

下图显示了每个数据集的样本。其中既有在自然环境中收集的数据集(如 AffectNet),也有在受控实验室环境中收集的数据集(如

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

78

78

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?