上周收到一位网友的私信,希望老牛同学写一篇有关使用 transformers 框架推理大模型的技术细节的文章。

老牛同学刚开始以为这类的文章网上应该会有很多,于是想着百度几篇质量稍高一点的回复这位网友。结果,老牛同学搜索后发现,类似文章确实不少,但是总觉得不太满意,要么细节深度不够,要么介绍不够全面,感觉达不到网友希望的技术细节要求。为了不辜负这位网友的期望,老牛同学决定自己动手,丰衣足食。

其实,我们使用 transformers 框架推理大模型的技术细节非常多,仅主链路就包括了模型加载、数据预处理、数据转换、模型推理、解码输出等。老牛同学本着宁缺毋滥尽善尽美的原则,期望能把这些技术细节完整全面介绍一遍,考虑到文章篇幅长度,计划共分为3 篇完成,希望能启动抛砖引玉之用:

- 第 1 篇:也就是本文,核心介绍transformers包 API 设计美学、如何初始化、LazyModule 模块、按需导入指定对象等

- 第 2 篇:基于 Qwen2.5 大模型,核心介绍AutoModel模型初始化

from_pretrained过程细节(PyTorch/TensorFlow/Flax 深度学习框架的其他模型也类似) - 第 3 篇:同样基于 Qwen2.5 大模型,核心介绍AutoTokenizer初始化

from_pretrained,和结合 Qwen2.5 大模型的完整推理过程技术细节

请原谅老牛同学水平有限,文中难免会出现遗漏和错误之处,恳请大家及时留言指出,以帮助老牛同学和其他阅读到本文的网友,让我们共同学习进步,在此万分感谢。

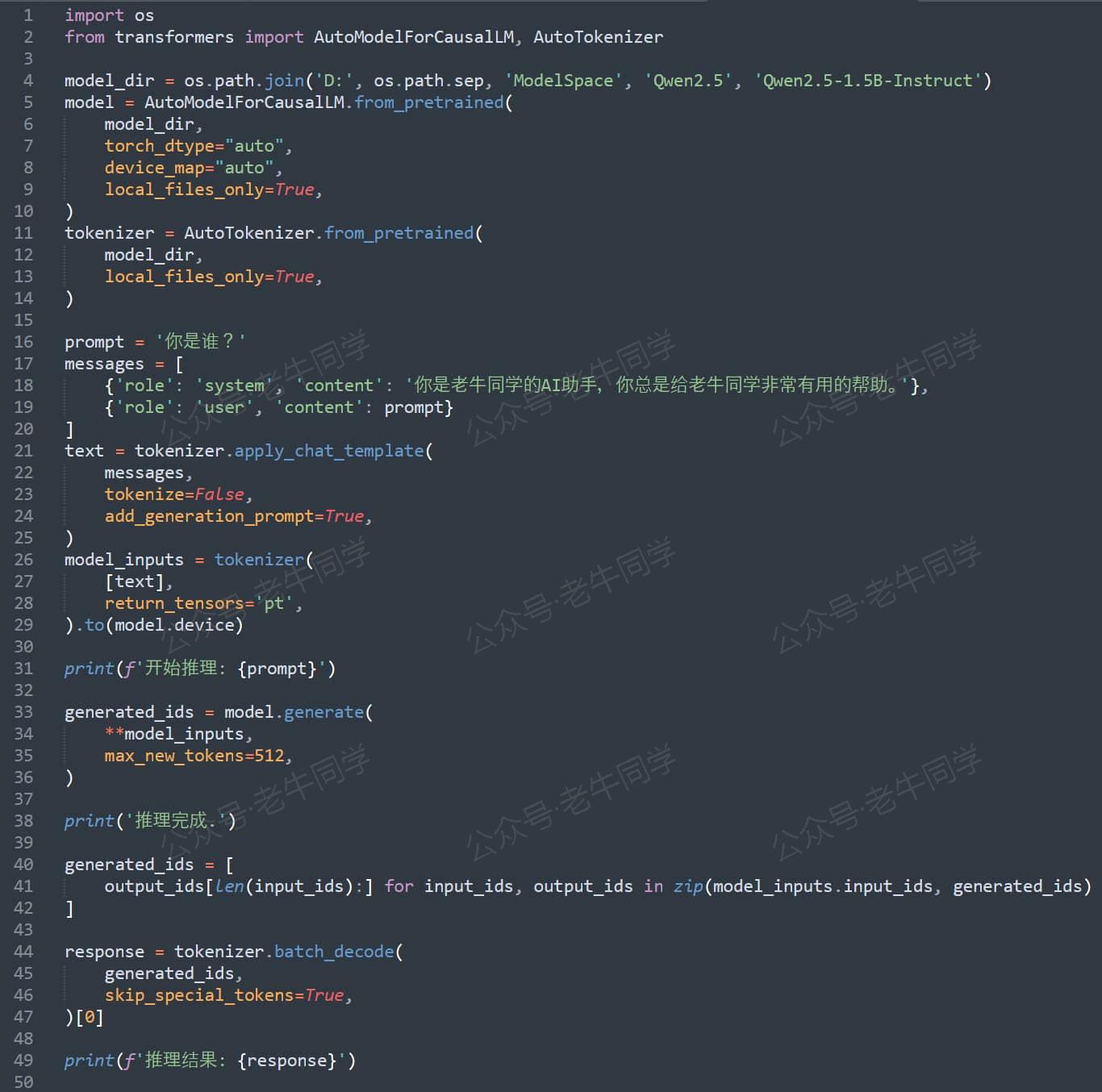

下面截图的寥寥几行代码,相信大家已经比较熟悉,因为它们经常出现在老牛同学的文章中。也就是这么几行代码,却涵盖了使用 transformers 框架进行大模型推理的核心代码框架。本系列的 3 篇文章,也将围绕这几行代码逐步展开:

要想详细介绍 Transformers 推理技术细节,我们就从 transformers 推理框架本身开始,老牛同学觉得这行代码就已足够:from transformers import XXX,代码中的XXX具体是哪个对象其实并不太重要,但为了后续介绍和演示方便,在本文中老牛同学就以AutoModelForCausalLM代替XXX。

是的,你没有看错,本文主要就只介绍这 1 行代码,这行在我们看来在简单熟悉不过的代码。想想看,对于 Transformers 这个大模型研究者和使用者们首选的框架来说,按理我们使用起来应该会很复杂,但从上面推理程序代码可以看到,我们使用这个框架时却似乎很简单,那么可能的解释是:Transformers 框架设计得特别的精妙!

老牛同学可以这么说:如果能把这行看似简单的代码真正读懂,在我们目前或将来设计像 transformers 这种超级 Python 包时,我们将会得心应手、游刃有余!

我们把本文分为以下几个主要章节部分,最终完成这行代码的介绍:

- 前期环境准备,主要是下载 transformers 包代码,包括环境配置和包安装

- transformers 包的初始化过程,即代码前半部分:

from transformers,我们可以看到transformers 包的设计和我们日常研发很不一样 - transformers 包导入类过程,即代码后半部分:

import AutoModelForCausalLM,让我们看看 transformers 包在设计上的精妙之处 - 在最后,老牛同学又来搞个小活动,免费包邮送几本新书给大家,期望大家踊跃参与

环境准备,下载 transformers 包代码

我们依然使用Miniconda来管理 Python 虚拟环境,Miniconda的安装和使用可以参考老牛同学之前的文章:大模型应用研发基础环境配置(Miniconda、Python、Jupyter Lab、Ollama 等)

首先,我们配置虚拟环境:

# Python虚拟环境名:Qwen2.5,版本号:3.10

conda create -n Qwen2.5 python=3.10 -y

# 激活虚拟环境

conda activate Qwen2.5

然后,在虚拟环境中下载依赖包:

pip install torch

pip install "transformers>=4.37.0"

pip install "accelerate>=0.26.0"

环境准备好了,我们接下来就来看前半部分代码了~

代码行:from transformers 代码详解

这行代码意思是引入 transformers 模块,它是 Python 从一个模块导入指定模块或对象的标准语法。

那么,Python 怎么知道去哪里找到transformers这个模块呢?

- 首先,Python 检查

sys.modules模块字典中是否存在名transformers的模块,这个字典存放着内置模块和已经导入过的模块,如果存在则直接返回,否则 - 进一步搜索模块,逐一遍历

sys.path目录列表,最后在site-packages目录下找到transformers包(文件夹)

我们可以通过以下代码,查看 Python 解释器启动时,默认的搜索模块目录列表,和获取site-packages目录位置的方式:

# 包或者模块搜索目录列表

impo

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

371

371

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?