前言

食品企业在管理标准、法规,特别是食品原料、特殊食品法规时,难以通过速查法规得到准确的结果。随着AI技术的发展,互联网上出现很多AI知识库的解决方案。

经过一轮测试,找到问题抓手、打通业务底层逻辑、对齐行业颗粒度、沉淀方法论、打通业务壁垒、形成业务闭环、提升用户感知度、赋能AI新赛道。

作者测试了钉钉内置AI、Defy.AI、fastGPT、FoodGPT、通义法睿、RAGflow+LM Studio、AnythingLLM,优缺点如下:

| AI | 优点 | 缺点 |

|---|---|---|

| 钉钉内置AI | 零代码部署、免费 | 一本正经地胡说八道、不保证数据安全。知识库占用云盘空间 |

| Defy.AI | 在线版零代码部署,本地版安全可控 | 在线版收费、不保证数据安全,本地部署难度高。一本正经地胡说八道 |

| AnythingLLM | 零代码本地部署 | 一本正经地胡说八道 |

| fastGPT | 在线版零代码部署,本地版安全可控。 | 在线版收费、不保证数据安全,本地部署难度高。本地、在线版都收费。 |

| FoodGPT | 回答精准,针对食品行业优化 | 收费,不能定制 |

| 通义法睿 | 回答精准、详实 | 不能定制 |

| RAGflow+LM Studio | 本地低代码部署,回答较为精准。自由选择模型。可定制。 | 性能不太好 |

收费模式:每个问题多少钱或按照embedding和提问小号的Token数收费。

硬件、环境要求

电脑至少需要4核CPU、16GB内存、50GB硬盘

需要魔法上网,或者自己配置Docker、Git、HuggingFace国内源

Windows 推荐使用企业版或服务器版

需要基础的读Windows和Linux代码能力,解决报错的能力

部署LM Studio

- 在lmstudio.ai 下载LM Studio,在ModelScope或Huggingface下载大语言模型文件(文件格式必须是.gguf)

- 将模型导入至LM Studio后创建LocalSever,记住端口号

部署RAGflow

按照GitHub infiniflow/ragflow的步骤部署即可,注意软件不要放在C盘!注意软件不要放在C盘!注意软件不要放在C盘!

浏览器输入网址http://localhost/login,先注册账号

配置好Model Providers,Base url填写http://host.docker.internal:[LM Studio端口号]/v1/models

切换到Knowledge Base,上传文件即可,支持word、excel、pdf、txt、图片等格式;可以选择文件类型,如图书、文献、法律等;模型不要改

上传后要在Action列中点绿色开始键,开始embedding,完成后才算完成知识库导入

切换到Chat标签页,点击Create an Assisstant

Knowledgebase选中导入的知识库,切换到Model Setting中Model选择模型,Freedom选择Precise

大功告成!可以提几个问题测试模型是否正常运行

运行

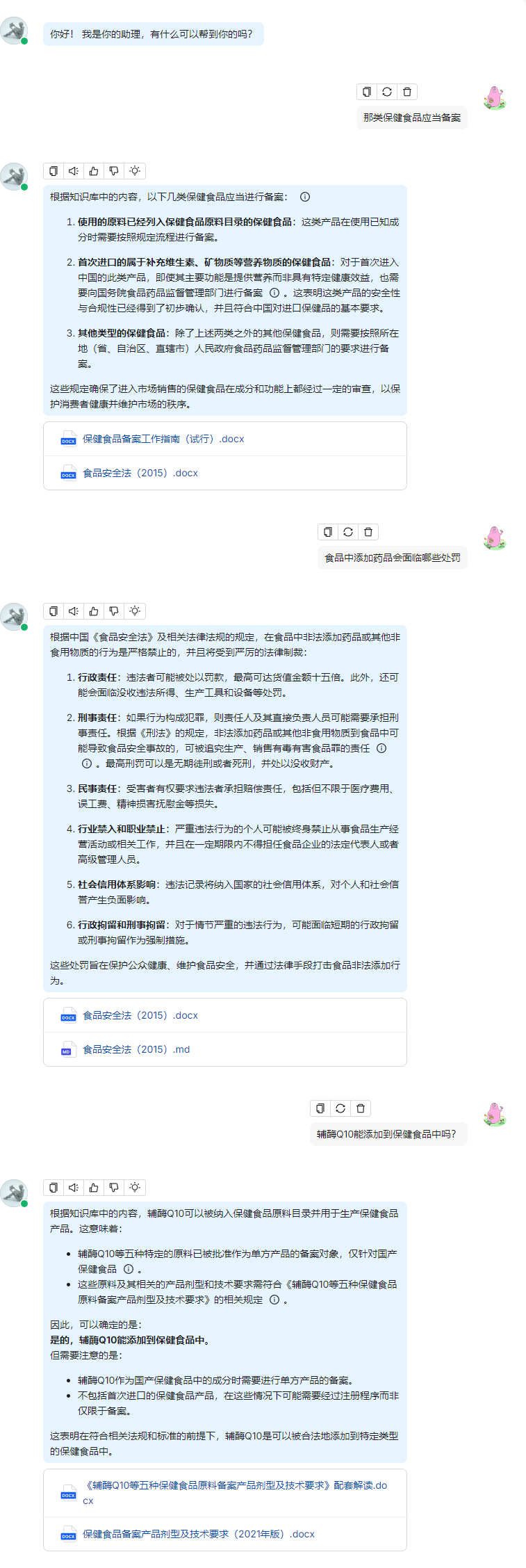

与ChatGPT一样,可以直接向AI提问,见下图

总体效果挺好,回答基本不会胡说八道,并给出了出处。

优缺点

优点:

-

配置简单。

-

- 众所周知,N卡普遍显存很小,但是A卡配置ROCm很麻烦。LM Studio可以一键部署CUDA或ROCm,免除复杂的环境配置。

- RAGflow运行在Docker,直接免除用户配置anaconda、python、pytorch等软件。

-

很好地减轻了AI一本正经的胡说八道的问题。

-

RAG Flow支持手动微调Embedding分块。

-

完全本地运行,数据安全可控。

缺点

- 既吃CPU+内存,又吃GPU+显存,需要配置很高的主机。

- 如果需要在企业部署还要配置域名解析,对RAGflow做二次开发,甚至要做显卡阵列。

- RAGflow不支持原生调用显卡加速,embedding非常耗时。

- RAGflow性能不太好,与在线托管的AI知识库相比响应速度有明显差距,对数据安全不敏感的,不建议使用RAGflow。

其他用法

除了做法规数据库,可以导入各类工作文件,比如公司规章制度、工作流程,沉淀的工作资料,收集的市场报告、文献、专利等。

使用数学模型甚至可能可以做数据处理和统计分析。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

2416

2416

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?