1. 引言

在大模型(LLMs)飞速发展的今天,如何自动、准确、可复现地评估模型性能成为了一个越来越重要的问题。特别是在指令微调(Instruction Tuning)后,我们迫切需要一个可靠的基准工具来对不同模型进行对比评估。

这时候,AlpacaEval 就登场了。它由 Tatsu Lab 开源,支持使用 GPT-4 系列模型作为“评审官”对模型输出进行自动化评估,并已广泛应用于各大模型榜单中(如 LMSYS Chatbot Arena)。

(这个2023年就出来了,但是只中了COLM 2024,虽然实用,但是思想太过简单。不过至今我居然没能找到一个可以实践的指南,也是奇怪了。)

1.1 🤖 什么是 LLM-as-a-Judge 评估范式?

LLM-as-a-Judge,顾名思义就是让大型语言模型作为“评审者”来打分其他模型的输出。这种范式背后的基本逻辑是:

“如果 GPT-4 是目前最强大的语言理解模型之一,那我们为何不让它来判断其他模型的表现呢?”

这一思路近年来在 NLP 评估中快速流行,尤其是在以下几个场景中表现出极强的实用性:

- 指令跟随任务(Instruction Following)

- 多轮对话生成

- 自由生成文本对比(Freeform Generation)

AlpacaEval 就是 LLM-as-a-Judge 范式的代表实现之一,使用 GPT-4 Turbo 对模型输出进行成对比较,并输出“哪一个更好”的判定。

2. 如何实战?

📦 第0步:安装 AlpacaEval

首先使用 pip 安装即可:

pip install alpaca-eval

推荐在一个独立的 conda 环境中进行,避免依赖冲突。

🛠️ 第1步:添加模型配置(model_configs)

AlpacaEval 使用 YAML 文件对模型的加载方式进行配置。

进入你 conda 环境下的安装目录中的 alpaca_eval/models_configs/ 文件夹,添加你的模型配置:

cd path_to_your_conda_env/lib/pythonX.X/site-packages/alpaca_eval/models_configs

mkdir Llama3-8b-alpaca-v2

cd Llama3-8b-alpaca-v2

touch configs.yaml

你可以参考官方提供的 Meta-Llama-3-8B-Instruct 配置 进行编写。

🔐 第2步:设置 API Key(如使用 OpenAI 模型)

如果你的模型调用依赖 OpenAI API,需要设置以下环境变量:

export OPENAI_API_KEY="your-openai-api-key"

export OPENAI_API_BASE="your-openai-api-base-url" # 可选

📤 第3步:生成模型输出

alpaca_eval evaluate_from_model --model_configs 'Llama3-8b-alpaca-v2'

运行后会在 results/ 目录中生成模型输出文件,如:

results/Llama3-8b-alpaca-v2/model_outputs.json

📊 第4步:对模型输出进行 GPT-4 自动评估

alpaca_eval --model_outputs 'results/Llama3-8b-alpaca-v2/model_outputs.json' --annotators_config 'alpaca_eval_gpt4_turbo_fn'

如果你希望将你的模型结果和公开榜单保持一致的标准进行比较,可以使用:

--annotators_config 'weighted_alpaca_eval_gpt4_turbo'

🧪 可选设置:开启 AlpacaEval 2.0 模式

export IS_ALPACA_EVAL_2=True

3. 🔍 除了 AlpacaEval,还有哪些评估工具值得关注?

当前主流的大模型评估框架除了 AlpacaEval,还有以下几种:

1. MT-Bench(from LMSYS)

- 基于 Chatbot Arena 开发

- 支持多轮对话任务评估

- 使用 GPT-4 评分

- 与 Arena 榜单强相关

👉 GitHub:https://github.com/lm-sys/FastChat/tree/main/fastchat/llm_judge

2. OpenCompass(from Shanghai AI Lab)

- 支持千亿参数模型离线评估

- 丰富的任务集(QA、Code、Math等)

- 支持多模型批量评估

👉 GitHub:https://github.com/OpenCompass/OpenCompass

3. TruthfulQA / MMLU / HellaSwag 等静态评估集

- 更偏向单项能力评估(如事实性、常识、推理)

- 不属于自动对比式框架,但常用于补充分析

4. 📏 AlpacaEval 的新特性:长度控制评估(Length-Controlled Evaluation)

在使用 GPT-4 等评审模型进行“模型输出打分”时,一个常见的问题是:输出越长,评分越高。这被称为长度偏差(Length Bias)。

❓ 为什么要控制长度?

- 模型 A 输出详细,模型 B 简洁明了;

- GPT-4 等评审模型倾向于选择“更详细”的那个;

- 即使这并不一定意味着更好。

这种倾向可能导致评估失真——模型只要“啰嗦”,就能赢。为了纠正这一点,AlpacaEval 引入了 长度控制评估 方法。

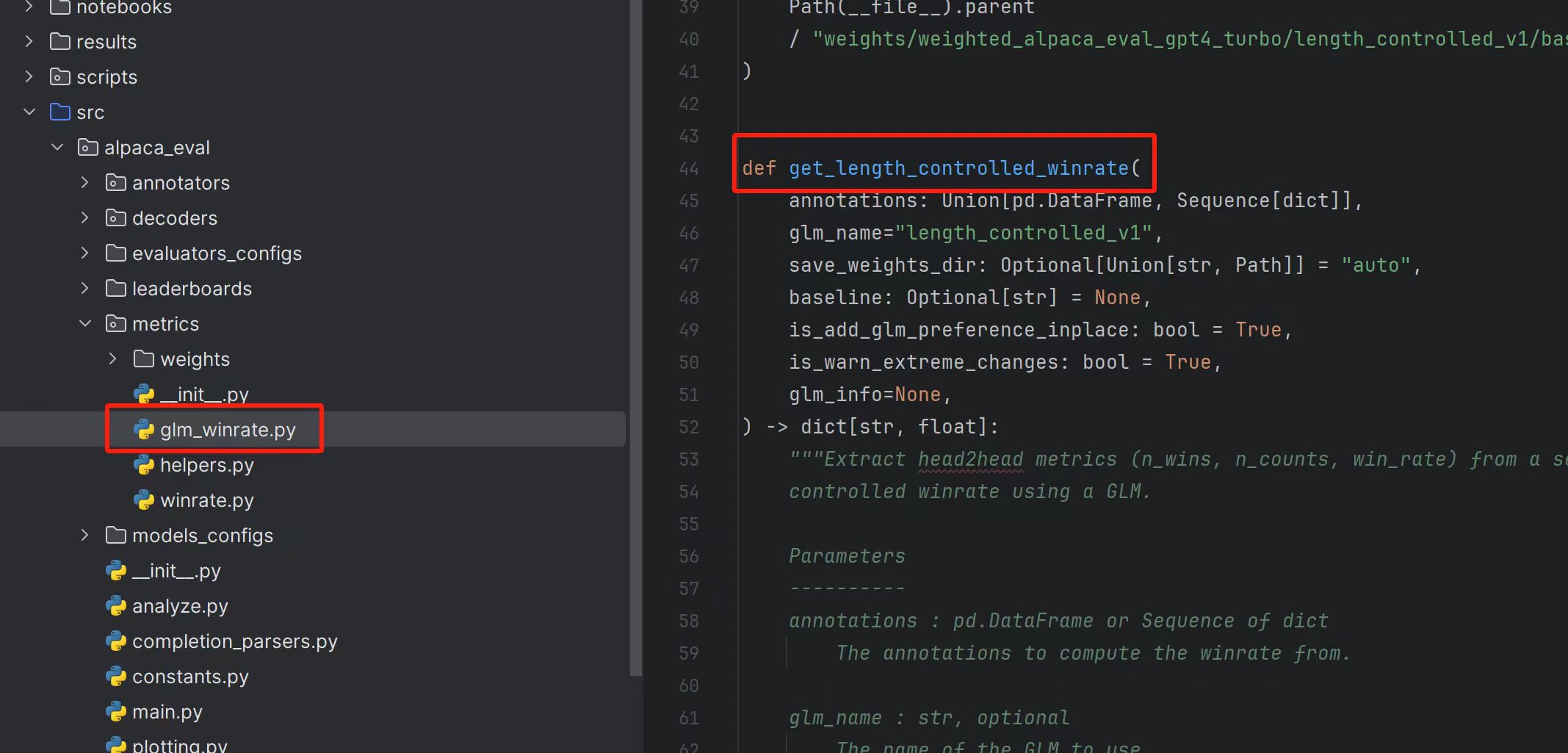

🛠️ 它是如何实现的?

- 建立广义线性回归模型(GLM,没错,这个在代码里是用的GLM来表示):以“模型名称 + 输出长度差异”等作为输入,预测哪一个输出会被 GPT-4 选中。

- 回归归一化:将长度差异设为零,计算如果两个模型输出长度相等,GPT-4 会更偏好哪个。

- 去偏分析:以“等长输出”为假设条件,估计模型的真实胜率。

该方法在技术上也称作 Counterfactual Preference Estimation,即“反事实偏好估计”。

✅ 效果如何?

- 与 LMSYS Chatbot Arena 的人工排名 相关性由 0.94 提升到 0.98

- 模型不再能通过“输出更长”来操控评估分数

📚 参考资料与延伸阅读

-

Length-Controlled AlpacaEval: A Simple Way to Debias Automatic Evaluators

Yann Dubois, Balázs Galambosi, Percy Liang, Tatsunori B. Hashimoto

arXiv:2404.04475 -

Explaining Length Bias in LLM-Based Preference Evaluations

Zhengyu Hu, Linxin Song, Jieyu Zhang, et al.

提出 AdapAlpaca 方法来缓解评估中长度偏差

arXiv:2407.01085 -

博客解读:AlpacaEval 长度控制机制解析

步子哥

CSDN 链接

5. 🧠 总结

AlpacaEval 是一个轻量级但强大的工具,支持以 GPT-4 为判官,快速完成对模型输出的质量评估,特别适合:

- 研究者对模型不同版本的比较分析;

- 评估指令微调的效果;

- 快速复现榜单标准。

如果你也在调试自己的大模型,不妨亲自试一试 AlpacaEval,也许你会发现它是评估环节中最方便的一把“尺子”。

📎 项目地址:https://github.com/tatsu-lab/alpaca_eval

📬 如你有更复杂的模型结构或批量评估需求,欢迎留言交流!

538

538

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?