文章目录

- 1. Mind's eye: A recurrent visual representation for image caption generation(CVPR2015)

- 2.LSTM

- 3.StyleNet: Generating Attractive Visual Captions with Styles(2017,CVPR/198 Citations)

- 4.Translating Videos to Natural Language Using Deep Recurrent Neural Networks(2014,Computer science/690 Citations)

- 5.Show, Attend and Tell: Neural Image Caption Generation with Visual Attention(2015, ICML/7898 Citations)

- 6.Deep Captioning with Multimodal Recurrent Neural Networks (m-RNN)(2014, ICLR/1068 Citations)

- 7.Show and Tell: A Neural Image Caption Generator(2015,CVPR/4787 Citations)

- 8.Multimodal Language Analysis in the Wild: CMU-MOSEI Dataset and Interpretable Dynamic Fusion Graph(2018, ACL/353 Citations)

- 9.A Comprehensive Survey of Deep Learning for Image Captioning(2018, ACM Comput. Surv./363 Citations)

- 10.Multimodal Deep Learning(2011, International Conference on Machine Learning/2611 Citations)

- 11.Flickr30k Entities: Collecting Region-to-Phrase Correspondences for Richer Image-to-Sentence Models(2015, IEEE International Conference on Computer Vision/969 Citations)

- 12.Multimodal Compact Bilinear Pooling for Visual Question Answering and Visual Grounding(2016, Conference on Empirical Methods in Natural Language Processing/1166 Citations)

- 13.Multimodal Language Analysis in the Wild: CMU-MOSEI Dataset and Interpretable Dynamic Fusion Graph(2018, Annual Meeting of the Association for Computational Linguistics/374 Citations)

- 14.Efficient Low-rank Multimodal Fusion With Modality-Specific Factors(2018, Annual Meeting of the Association for Computational Linguistics/250 Citations)

- 15.Learning Two-Branch Neural Networks for Image-Text Matching Tasks

- 16.Memory Fusion Network for Multi-view Sequential Learning(2018, AAAI Conference on Artificial Intelligence/299 Citations)

- 17.Deep Visual-Semantic Alignments for Generating Image Descriptions(2014, IEEE Transactions on Pattern Analysis and Machine Intelligence/4529 Citations)

- 18.Tensor Fusion Network for Multimodal Sentiment Analysis(2017, Conference on Empirical Methods in Natural Language Processing/569 Citations)

- 19.Automatic Description Generation from Images: A Survey of Models, Datasets, and Evaluation Measures(2016, International Joint Conference on Artificial Intelligence/303 Citations)

- 20.Deep Multimodal Representation Learning: A Survey(2019, IEEE Access/151 Citations)

- 3.典型模型

- 21.Foundations and Recent Trends In MultiModal Machine Learning:Principles,Challenges and Open Questions()

- 端到端

- 多模态数据集

1. Mind’s eye: A recurrent visual representation for image caption generation(CVPR2015)

- 心灵之眼:用于图像标题生成的循环视觉表示

- 方法:递归神经网络

- 属于多模态表示:图片和文字,联合架构

A. Introduction

- 有几篇论文探讨了学习图像的联合特征空间及其描述,提出了很多投影方法,包括KCCA、深度神经网络和卷积神经网络。尽管这些方法可以将语义和视觉特征投影到一个公共的嵌入空间,但是没有办法反向得到新的句子或者视觉描述

- 针对之前存在的问题,由此引出这篇文章的方法:A bi-directional representation:capable of generating both novel descriptions from images and visual representations from descriptions

- 这两个任务的关键是一种新颖的表示形式,它可以动态捕捉已经描述过的场景的视觉方面。即,随着单词的生成或读取,视觉表示被更新以反映单词中包含的新信息。使用递归神经网络(RNN)完成此任务。

这篇文章已经提出了RNN存在的缺点

- 在经过几次重复迭代后,RNN在重新记忆概念方面存在弱点。例如,如果没有专门的门控单元 [15],RNN 语言模型在学习长距离关系时经常会遇到困难。

B. Discussion

- 在这篇论文中没有探讨LSTM模型的使用,但肯定了将RNN替换为LSTM可能会更有趣

- 总之,该论文描述了第一个能够生成新颖的图像描述和视觉特征的双向模型。与许多以前使用rnn的方法不同,该篇论文的模型能够学习长期的交互

- 这是由于使用了循环的视觉记忆

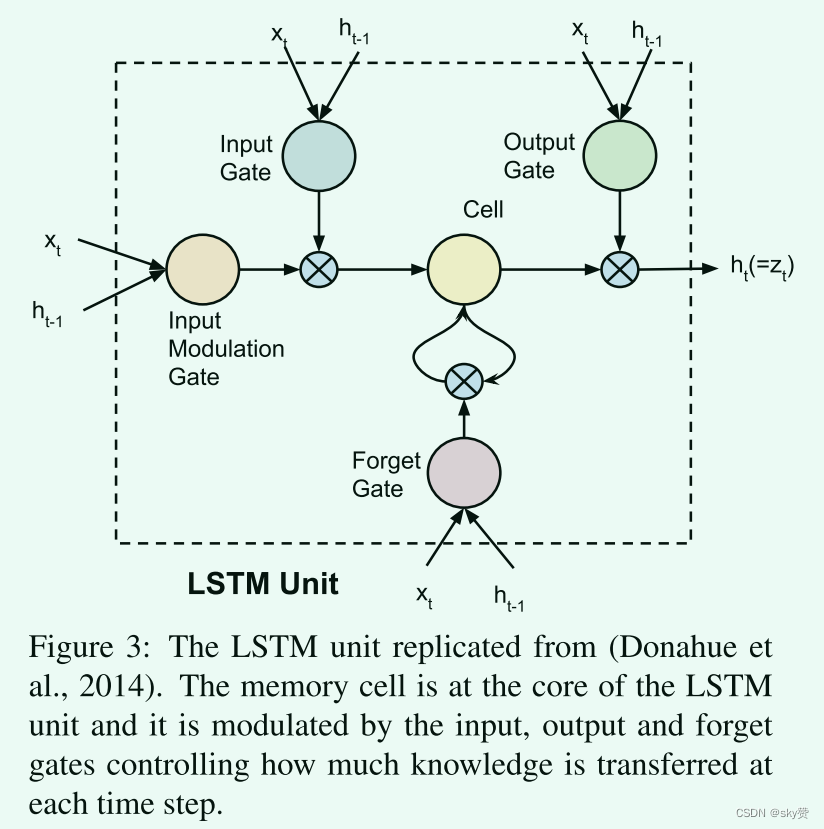

2.LSTM

-

RNN的主要弱点是,善于进行短期记忆,不擅长进行长期记忆。

RNN的主要弱点是,善于进行短期记忆,不擅长进行长期记忆。由于激活函数(输出值取值范围[0,1])的存在,信息和残差在RNN神经元中传递时,会逐时间步损耗(简单来说就是绝对数值越来越小)。这个特点,削弱了RNN神经元保留距离当前时间步较远信息的能力,或者说,弱弱了RNN刻画长序列的能力。假设我们要从“贪污和浪费是极大的犯罪”抽取近义词,当模型从左到右、处理到”犯罪”的时候,“贪污”的语义已经被忘记,那么“犯罪-贪污”这对近义词就无法召回了。当然,实际发生的,是神经元“当前状态”,即语义向量里,所包含”贪污”越来越弱。看起来像是一个加权可以解决的问题。

-

LSTM(Long-Short Term Memory Neural Network,长短期记忆网络)是Transformer出现之前,理论和实践中表现最好的序列建模工具之一,催生了”BiLSTM+CRF”等应用非常广泛的神经网络模型结构

-

LSTM神经元在时间维度上向后传递了两份信息:cell state和hidden state

-

hidden state是cell state经过一个神经元和一道“输出门”后得到的,因此hidden state里包含的记忆,实际上是cell state衰减之后的内容

-

实际上hidden state里存储的,主要是“近期记忆”;cell state里存储的,主要是“远期记忆”

-

另一种解释:通过cell的计算公式可以看出该单元能够存储全部时间步的信息(ft为1),有点highway的感觉,因此能保存长期记忆;而hidden是网络在cell的基础上进行特征选择的结果

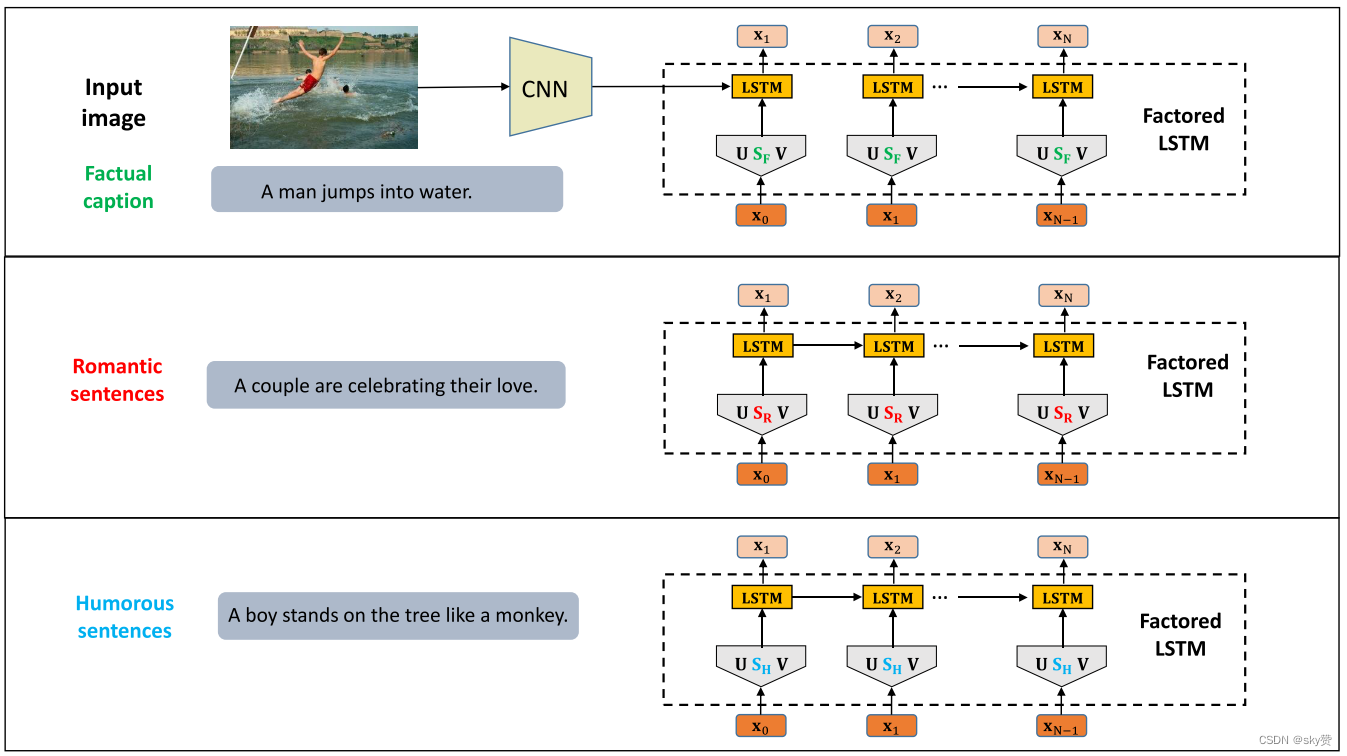

3.StyleNet: Generating Attractive Visual Captions with Styles(2017,CVPR/198 Citations)

提出了一个名为StyleNet的新框架,以解决为图像和视频提供具有不同风格的图片字幕的任务。

- 本文是第一个研究用样式来生成有吸引力的图片字幕的问题,而不需要使用受监督的特殊图像-标题配对数据。

- 本文提出了一个端到端可学习的StyleNet框架,它可以自动从文本库中提取出样式因子。在标题生成中,样式因子可以被显式地合并以产生有吸引力的标题和所需的样式。

- 本文收集了一个新的Flickr图片字幕数据集。希望这个数据集可以帮助推进图像字幕的研究。

- 本文展示的StyleNet框架和Flickr的图片标题数据集也可以用来制作有吸引力的视频字幕。

- 长短期记忆 (LSTM)模型是一种特殊类型的RNN,它解决了常规RNN体系结构的消失和爆炸梯度问题。

-

第一层输入图片和真实的图片字幕进行学习

-

第二层和第三层输入浪漫风格和幽默风格的文本集

-

这三层都有一个factored LSTM结构用于学习,其中的参数是共享的除了特定的风格因子矩阵:SF, SR, SH

-

通过多任务学习

-

文献中常用的策略是采用预训练的CNN模型作为编码器,将图像映射到固定维度的特征向量,然后使用LSTM模型作为解码器,根据图像向量生成字幕。

-

Factored LSTM:因式分解传统LSTM中的参数Wx为三个矩阵Ux, Sx, Vx。

变为

4.Translating Videos to Natural Language Using Deep Recurrent Neural Networks(2014,Computer science/690 Citations)

-

是上一篇论文的基础

-

对于机器来说,从视频像素中提取含义并生成听起来自然的语言是一个非常复杂的问题。已经为具有一小组已知操作和对象的狭窄域提出了解决方案,但是对于开放域视频的描述仍然具有挑战

-

在本文中使用单个深度神经网络将视频像素转换为自然语言。通过从辅助任务中转移知识来解决需要大量的监督训练数据问题。

-

使用长短期记忆网络(LSTM)递归神经网络建模

-

“It also allows us to first pre-train the model on a large image and caption database, and transfer the knowledge to the video domain where the corpus size is smaller.”它还允许我们首先在大型图像和字幕数据库上对模型进行预训练,并将知识传输到语料库大小较小的视频域。

这里就是对上篇论文训练方式的补充解释

-

这些模型的工作原理是首先在图像上应用特征变换以生成固定维向量表示。然后,他们使用序列模型,特别是递归神经网络 (RNN),将向量 “解码” 成句子 (即单词序列)。在这项工作中,我们应用了将视觉矢量 “翻译” 成英语句子的相同原理,并表明它可以很好地描述动态视频和静态图像。

-

RNN 可以学习映射预先知道输入和输出之间对齐的序列,但是尚不清楚它们是否可以应用于输入 (xi) 和输出 (zi) 的问题长短不一的。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-o18Kznhc-1687920629632)(C:\Users\81288\AppData\Roaming\Typora\typora-user-images\image-20221113181905227.png)]](https://i-blog.csdnimg.cn/blog_migrate/893a1c2b70692c1f69f3cd6d74737ac8.png)

-

训练流程:使用 LSTM 来“解码”代表视频的视觉特征向量以生成文本输出。

- 此过程的第一步是生成一个固定长度的视觉输入,以有效地总结短视频。为此,我们使用CNN,特别是公开可用的Caffe参考模型,这是AlexNet的次要变体。该网络在ImageNet数据集的1.2M图像ILSVRC-2012对象分类子集上进行了预训练,因此为识别对象提供了强大的初始化,从而加快了训练速度。

- 我们对视频中的帧进行采样(每 10 帧中有 1 帧)并提取 fc7 层的输出,并对帧执行平均池化,为每个视频生成一个 4096 维向量。

- 生成的视觉特征向量形成第一个 LSTM 层的输入。

- 我们将另一个 LSTM 层堆叠在顶部,第一层中 LSTM 的隐藏状态是第二层中 LSTM 单元的输入。句子中的一个单词构成输出 LSTM 单元的目标。在这项工作中,我们使用“one-hot”向量(即1-of-N编码,其中N是词汇大小)来表示单词。

-

注意:

- 该论文中特征提取器采用的是AlexNet,用FC7层(4096维向量)的输出作为编码器输出。

- LSTM采用两层而不是一层,根据前人实验经验得出的结论。

- 视频中的每10帧采样1帧。

- 鉴于视频数据集过小,文中采用image caption训练好的模型做迁移学习。不过词库需要调整为两者的结合。

5.Show, Attend and Tell: Neural Image Caption Generation with Visual Attention(2015, ICML/7898 Citations)

-

想看全文翻译可以参考这篇博客:http://t.csdn.cn/TOZ0Z

-

这篇文章首先引入基于注意力的机制

-

这篇文章的主要贡献有如下几点:

- 我们在一个通用框架下介绍了俩个基于注意力机制的图片字幕生成器:1)可通过标准反向传播方法训练的“软”确定性注意力机制 2)一种“硬”随机注意力机制,可以通过最大化一个近似的变分下限来训练,或者等效地通过强化来训练。

- 我们通过可视化注意力关注在哪儿是什么来展示这个框架是如何获得洞察力和解释这个结果。

- 最后,我们在三个基准数据集上定量验证了注意力在字幕生成中的有用性,具有最先进的性能:Flickr8k、Flickr30k和 MS COCO 数据集。

-

这篇论文的模型

-

编码器:卷积功能

解码器:长短时记忆力网络

LSTM结构图,模仿的上面那篇论文的

-

权重αt可以由前一步系统隐变量ht-1经过若干全连接层获得,编码et用于存储前一步的信息。在这项工作中,我们使用一个深度输出层来计算给定LSTM状态、上下文向量和前一个单词的输出单词概率。fatt 是耦合计算区域 i 和时刻 t 这两个信息的打分函数,也就是为t时刻区分区域的相关度。

-

在文章后面讨论注意力模型fatt的两种替代机制:“硬”随机注意机制和“软”确定性注意机制

-

-

可以看出,整体仍是 Encoder-Decoder 结构,Encoder 部分没有做改变,在 Decoder 中引入了 attention。

6.Deep Captioning with Multimodal Recurrent Neural Networks (m-RNN)(2014, ICLR/1068 Citations)

- 以前,获取图片的句子描述的许多方法都将其视为一个检索任务,通过从句子数据库中检索它们来生成图像标题。因此缺乏生成新句子或描述包含物体和场景新组合的图像的能力。

- 2014年10月,百度研究院的Junhua Mao和Wei Xu等人在arXiv上发布论文《Explain Images with Multimodal Recurrent Neural Networks》,提出了multimodal Recurrent Neural Network(即m-RNN),创造性地将 CNN 和 RNN 结合起来,用于解决图像标注和图像语句检索等问题。

- 这篇文章提出了一个多模态递归神经网络(m-RNN)框架,该框架在三个任务中具有最先进的性能:句子生成、给定查询图像的句子检索和给定查询句子的图像检索。

- 该模型由一个深度RNN、一个深度CNN组成,这两个子网络在一个多模态层中相互作用。

- 整个m-RNN模型包含语言模型部分、视觉部分和多模态部分。语言模型部分学习字典中每个单词的密集特征嵌入,并将语义时间上下文存储在循环层中。视觉部分包含一个深度卷积神经网络(CNN) ,用于生成图像表示。多模态部分通过一层表示将语言模型和深层细胞神经网络连接在一起。这篇文章的 m-RNN 模型是使用对数似然代价函数学习的。误差可以反向传播到 m-RNN 模型的三个部分,同时更新模型参数。

- 这篇文章的第二章节相关部分工作与第一章节的介绍相对照:1、计算机视觉和自然语言的深度模型。2、图像-句子检索。3.为图像生成新颖的句子描述。这篇文章的逻辑很好。

- 这篇文章的工作与之前方法有两个主要区别:

- 这篇文章在m-RNN网络结构中加入了一个两层词嵌入系统,该系统比单层词嵌入更有效地学习词表示。

- 不使用循环层来存储视觉信息。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-GuNmOzaW-1687920629633)(C:\Users\81288\AppData\Roaming\Typora\typora-user-images\image-20221115170901281.png)]](https://i-blog.csdnimg.cn/blog_migrate/492c21a7508bc7594f5f5b4e074acaa9.png)

简单循环神经网络 (RNN) 和我们的多模式循环神经网络 (m-RNN) 架构的图示。 (a)简单的循环神经网络。 (b)这篇文章的 m-RNN 模型。

文章模型的输入是图像及其相应的句子描述。 w1, w2, …, wL 表示句子中的单词。为所有训练句子添加一个开始标志 wstart 和一个结束标志 wend。该模型在给定先前单词和图像的情况下估计下一个单词的概率分布。

它由五层(即两个词嵌入层、一个循环层、一个多模态层和一个 softmax 层)和每个时间帧中的深度 CNN 组成。每层上方的数字表示该层的维度。权重在所有时间范围内共享。 (最好看彩色)

- Mao, Junhua, Xu, Wei, Yang, Yi, Wang, Jiang, and Yuille, Alan L.Explain images with multimodal recurrent neural networks. NIPS DeepLearning Workshop, 2014.属于开创性文章

7.Show and Tell: A Neural Image Caption Generator(2015,CVPR/4787 Citations)

- 这篇文章提出了一个模型: NIC,这是一个端到端的神经网络系统,可以自动查看图像并用简单的英语生成合理的描述。

- 编码器-解码器结构

- NIC基于卷积神经网络,该网络将图像编码为紧凑的表示形式,然后是生成相应句子的递归神经网络。

- 相对于m-RNN,NIC 具有如下不同:

- 用 LSTM 替代 RNN;

- 不同于 m-RNN 的 AlexNet,CNN 部分使用了效果更好的卷积网络;

- CNN 提取到的图像特征只在开始时输入一次。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-64zpzWOx-1687920629634)(C:\Users\81288\AppData\Roaming\Typora\typora-user-images\image-20221117160536699.png)]](https://i-blog.csdnimg.cn/blog_migrate/5cda7feabd0cc63bda4e236e2b6a40b6.png)

- 模型介绍

- 图像编码器(encoder)是深度卷积神经网络。这种类型的网络被广泛用于图像任务,比如目标识别和检测最新技术。我们特别选择的网络是在ILSVRC-2012-CLS图像分类数据集上预先训练的Inception v3图像识别模型。

- 解码器(decoder)是一个长期的短期记忆(LSTM)网络。这种类型的网络通常用于序列建模任务,如语言建模和机器翻译。在Show and Tell模型中,LSTM网络被训练成一个以图像编码为条件的语言模型。

- 优点:非常灵活,不限输入和输出的模态,同时不限制两个网络的类型

- 缺点:当输入端是文本时,将变长序列表达为固定维数向量,存在信息损失,并且目前还不能处理太长的文本。

8.Multimodal Language Analysis in the Wild: CMU-MOSEI Dataset and Interpretable Dynamic Fusion Graph(2018, ACL/353 Citations)

论文中描述的CMU-MOSEI数据集规模最大的三模态数据集之一,且具有情感和情绪两个标签,情感从negative到positive一共有7个类别,情绪包含愤怒、开心、悲伤、惊讶、害怕和厌恶6个类别,标签的数值在[-3~3]之间。数据集给出了原始数据,但是过于原始,即给出的是文本,音频和视频文件,图像还得自己去以固定频率捕获并且和文本语音对其还是比较麻烦的。大多实验都使用处理好的实验数据。

9.A Comprehensive Survey of Deep Learning for Image Captioning(2018, ACM Comput. Surv./363 Citations)

作者通过归纳不同的方面,将目前主流的caption方法归类为以下几种:(在section 2里面详细说明)

- 基于模板的图像描述(Template -based )

- 基于检索的图像描述(Retrieval-based)

- 新颖的图像描述生成(Novel imag caption generation),大多数基于深度学习的归类于此

其次作者又再次将基于深度学习的方法归类为以下几种:(在section 3中详细说明)

- Visual space-basedMultimoda space-based

- Supervised learning,

- Other deep learning,

- Dense captioning,

- Whole scene-based,

- Encoder-Decoder Architecture-based,

- Compositional Architecture-based,

- LSTM(Long Short-Term Memory) [54] language model-based,

- Others language model-based,

- Attention-Based,

- Semantic concept-based,

- Stylized captions

-

视觉空间vs.多模态空间

-

在基于视觉空间的方法中,图像特征和相应的字幕独立地传递给语言解码器。

-

相反,在多模态空间的情况下,从图像和相应的字幕文本中学习共享的多模态空间。然后将这种多模态表示传递给语言解码器。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-MxqfDoZd-1687920629634)(image-20221122105920499.png)]](https://i-blog.csdnimg.cn/blog_migrate/916555642581aabcecbd7292ea4d7d3b.png)

-

视觉部分使用深度卷积神经网络作为特征提取器来提取图像特征。语言编码器部分提取单词特征,并学习每个单词的密集特征嵌入。然后它将语义时间上下文转发到循环层。

-

多模态空间部分将图像特征映射到具有单词特征的公共空间中。

-

然后将生成的映射传递给语言解码器,该解码器通过解码映射生成描述。

该类别中的方法遵循以下步骤 :

(1) 使用深度神经网络和多模态神经语言模型在多模态空间中共同学习图像和文本。

(2) 语言生成部分使用来自步骤1的信息生成字幕。

-

-

-

监督学习vs.其他深度学习

-

在监督学习中,训练数据带标签 。

基于监督学习的图像描述方法分为不同的类别:(i)编码器-解码器架构,(i i)组合架构,(i i i)基于注意力机制,(i v)基于语义概念,(v)风格化描述,(v i)基于对象的新的描述,以及(v i i)密集图像描述。

-

无监督学习不带标签 。比如GAN和强化学习。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-LV0Qpoil-1687920629634)(image-20221122193317835.png)]](https://i-blog.csdnimg.cn/blog_migrate/639565a0db0d16437dc479cd13c9f492.png)

此类别中的方法遵循以下步骤:

- 基于CNN和RNN的组合网络生成字幕

- 另一个基于CNN-RNN的网络评估字幕并向第一网络发送反馈以生成高质量字幕。

-

-

密度描述vs.整个场景的描述

- 在密度字幕中,会为场景的每个区域生成字幕。而其他方法则是为整个场景生成字幕。

![- [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-DN94Iwa8-1687920629634)(image-20221122205342889.png)]](https://i-blog.csdnimg.cn/blog_migrate/df2ccfc0dc3458cc5f6463da08b4b338.png)

这一类的典型方法有以下步骤:- 为给定图像的不同区域生成区域建议。

- 利用CNN获取基于区域的图像特征。

- 步骤2的输出被一个语言模型用于生成每个区域的标题。

- 编码器-解码器架构、合成架构、基于注意、基于语义概念、风格化描述、新颖的基于对象的图像描述以及其他基于深度学习网络的图像描述方法为整个场景生成单个或多个描述。

- 在密度字幕中,会为场景的每个区域生成字幕。而其他方法则是为整个场景生成字幕。

-

编码器-解码器体系结构vs.合成架构

-

在该网络中,从CNN的隐藏激活中提取全局图像特征,然后将其输入到LSTM中生成单词序列。

-

编码器-解码器体系结构

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-CLKb8mpu-1687920629635)(image-20221123193013182.png)]](https://i-blog.csdnimg.cn/blog_migrate/11871f003e89d52af1853f0ef756f231.png)

此类典型方法具有以下一般步骤:

- 使用普通CNN获取场景类型,检测目标及其关系。

- 步骤1的输出由语言模型使用以将它们转换成产生图像字幕的单词、组合短语。

-

合成架构

![- [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-xLqx4kGB-1687920629635)(image-20221125161556543.png)]](https://i-blog.csdnimg.cn/blog_migrate/a1889cb8fa782a96d61b9b81a8c95ffa.png)

-

基于组合体系结构的方法,由几个独立的功能构建块组成:首先,使用CNN从图像中提取语义概念。然后使用语言模型来生成候选字幕集合。在生成最终字幕时,使用深度多模态相似性模型对这些候选字幕进行重新排序。

-

此类别的典型方法包含以下步骤:

- 使用CNN获得图像特征

- 从视觉特征获得视觉概念

- 通过使用步骤1和步骤2的信息的语言模型来生成多个字幕

- 使用深度多模态相似性模型对所生成的字幕进行重新排序,以选择高质量的图像字幕

-

-

-

其余方法

-

基于注意力的图像描述

- 基于注意力的方法与其他方法的主要区别在于它们可以集中注意力于图像的显著部分,同时生成相应的单词

![- [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gopBUAFv-1687920629635)(重要文章.assets/image-20221206175206538.png)]](https://i-blog.csdnimg.cn/blog_migrate/95217f35f949f4a8cc343fdfda1d1c17.png)

这类典型方法采用以下步骤:

- 通过CNN获得基于整个场景的图像信息。

- 语言生成阶段基于步骤1的输出生成单词或短语。

- 基于所生成的单词或短语,在语言生成模型的每个时间步长中聚焦给定图像的显著区域。

- 动态更新字幕直到语言生成模型的结束状态。

- 基于注意力的方法与其他方法的主要区别在于它们可以集中注意力于图像的显著部分,同时生成相应的单词

-

-

这篇文章写的很详细,但我觉得逻辑不是很好,特别是在总分结构的举例子里

-

基于语义概念的图像描述

-

基于语义概念的方法有选择地关注从图像中提取的一组语义概念建议,然后将这些概念组合成隐藏状态和循环神经网络的输出。

![- [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-xuyKkkAG-1687920629635)(重要文章.assets/image-20221206174314808.png)]](https://i-blog.csdnimg.cn/blog_migrate/26ba18a8dbaf2b21eecf0949a48667b7.png)

-

该类别中的方法遵循以下步骤 :

- 基于CNN的编码器用于对图像特征和语义概念进行编码

- 将图像特征输入到语言生成模型的输入中

- 将语义概念添加到语言模型的不同隐藏状态中

- 语言生成部分产生带有语义概念的字幕

-

-

基于新对象的图像描述

-

尽管最近基于深度学习的图像覆盖方法已经取得了很好的效果,但它们在很大程度上依赖于成对的图像和句子描述数据集。这些类型的方法只能生成上下文中对象的描述。因此,这些方法需要大量的训练图像-句子对。新的基于对象的图像描述方法可以生成不在成对图像描述数据集中的新对象的描述。

-

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qVPY5eiQ-1687920629636)(重要文章.assets/image-20221206174253492.png)]](https://i-blog.csdnimg.cn/blog_migrate/089ddbedffafbe5242d6630ebf2bbe01.png)

- 这类方法遵循以下一般步骤:

- 对未配对的图像数据和未配对的文本数据分别训练一个单独的词汇分类器和一个语言模型。

- 对成对的图像字幕数据进行了深度字幕模型的训练。

- 最后,将这两个模型组合在一起,进行联合训练,从而为新对象生成标题。

- 这类方法遵循以下一般步骤:

-

-

风格化描述

-

现有的图像字幕系统仅基于图像内容生成字幕,也可以称为事实描述。他们没有将文本的风格化部分与其他语言模式分开考虑。但是,风格化的字幕比仅对图像的平面描述更具表现力和吸引力。

-

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-oWdgNRUF-1687920629636)(重要文章.assets/image-20221206174223676.png)]](https://i-blog.csdnimg.cn/blog_migrate/3f3df1ac9cf6538310ddf7f0c27ba373.png)

- 此类方法遵循以下一般步骤:

- 采用基于CNN的图像编码器获取图像信息

- 准备单独的文本语料库,从培训数据中提取各种风格化概念(例如:浪漫、幽默)

- 语言生成部分可以使用步骤1和步骤2的信息生成风格化和吸引人的描述

- 此类方法遵循以下一般步骤:

-

-

LSTM vs. Others

-

传统的RNN存在着消失和爆炸的梯度问题,不能充分处理长期的时间依赖性。

-

LSTM网络是一种RNN,除了标准单元外,还具有特殊单元。LSTM单元使用一个存储单元,它可以在内存中长期保存信息。近年来,基于LSTM的学习任务排序模型被广泛应用。另一个网络,选通循环单元(GRU)的结构与LSTM相似,但它不使用单独的内存单元,使用较少的选通来控制信息流。

-

然而,LSTMs忽略了句子的底层层次结构。由于通过内存单元的长期依赖性,它们还需要大量的存储。相比之下,CNN可以学习句子的内部层次结构,并且它们的处理速度比LSTM快。因此,最近,卷积结构在其他序列中用于对任务进行排序,例如,条件图像生成和机器翻译。

-

10.Multimodal Deep Learning(2011, International Conference on Machine Learning/2611 Citations)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-HFHY1RTX-1687920629636)(image-20221129102752679.png)]](https://i-blog.csdnimg.cn/blog_migrate/756e4e1e1c9018d24d13bd76633de34d.png)

-

总体任务可以分为三个阶段:特征学习,监督训练和测试

-

三种学习设置:多模式融合,交叉模态学习和共享表示学习

-

在多模态融合设置中,来自所有模态的数据在所有阶段都可用; 这代表了在视听语音识别中的大多数先前工作中考虑的典型设置

-

在交叉模态学习中,来自多种模态的数据仅在特征学习期间可用; 在监督训练和测试阶段,仅提供来自单一模态的数据。对于这种设置,目的是在给定来自多个模态的未标记数据的情况下学习更好的单模态表示

-

共享的表示学习设置,该设置的独特之处在于为监督训练和测试提供了不同的方式。此设置使我们能够评估特征表示是否可以捕获不同模态之间的相关性

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-2CyepdGv-1687920629637)(image-20221129102809172.png)]](https://i-blog.csdnimg.cn/blog_migrate/1887c1a82a0ef1068f826cdef45ccbce.png)

-

最直接的特征学习方法之一是分别针对音频和视频训练RBM模型。我们使用这个模型作为基准来比较我们的多模态模型的结果,以及预训练深度网络(图 2a,b)。

-

为了训练多模式模型,一种直接方法是在连接的音频和视频数据上训练RBM (图2c)。虽然这种方法对音频和视频数据的分布进行联合建模,但它仅限于浅层模型。特别是,由于音频和视频数据之间的相关性是高度非线性的,因此 RBM 很难学习这些相关性并形成多模态表示。

-

因此,文章考虑在每个模态的预训练层贪婪的训练一个RBM,前面的第一层的隐藏值作为新层的训练数据。通过学习到的第一层特征来表示数据可以更容易的让模型来学习跨模态的高阶相关性。通俗的来说,第一层特征相当于音位和视位,第二层模型化了他们之间的关系。

-

(a)中示出了“仅视频”输入模型,其中该模型在仅给定视频作为输入的情况下学习重建两种模态。对于“仅音频”输入设置,可以绘制类似的模型。

-

我们以去噪方式训练 (b) 双模态深度自动编码器,使用带有示例的增强数据集,这些示例要求网络在仅给定一个模态的情况下重建两种模态。两种模型都使用稀疏 RBM 进行了预训练(图 2d)。

但实际上,我们扩充时一个模态用全零作为输入,另一个模态用原始值作为输入,但是依旧要求模型重建这两个模态。因此,三分之一的训练数据只有视频作为输入,三分之一的训练数据只有语音作为输入,最后三分之一既有视频又有语音。

由于使用稀疏 RBM 进行初始化,我们发现即使在深度自动编码器训练之后,隐藏单元的预期激活也很低。因此,当其中一个输入模态设置为零时,第一层表示也接近于零。在这种情况下,我们实际上是在训练特定于模式的深度自动编码器网络(图 3a)。实际上,该方法学习了一个模型,该模型对不存在模态的输入具有鲁棒性。

-

第二章只有2.1,这篇文章是不是不太规范

11.Flickr30k Entities: Collecting Region-to-Phrase Correspondences for Richer Image-to-Sentence Models(2015, IEEE International Conference on Computer Vision/969 Citations)

- Flickr30k数据集已经成为基于句子的图像描述的标准基准。

12.Multimodal Compact Bilinear Pooling for Visual Question Answering and Visual Grounding(2016, Conference on Empirical Methods in Natural Language Processing/1166 Citations)

-

这篇文章与多模态特征融合是相关的,但是是双模态

-

分类:表示和融合

-

Visual Grounding 视觉定位:

-

visual grounding涉及计算机视觉和自然语言处理两个模态。简要来说,输入是图片(image)和对应的物体描述(sentence\caption\description),输出是描述物体的box。听上去和目标检测非常类似,区别在于输入多了语言信息,在对物体进行定位时,要先对语言模态的输入进行理解,并且和视觉模态的信息进行融合,最后利用得到的特征表示进行定位预测

-

Visual grounding系列–领域初探 - 森林海的文章 - 知乎 https://zhuanlan.zhihu.com/p/388504127

-

-

特征融合即输入两个模态的特征向量,输出融合后的向量。最常用的方法是拼接(concatenation)、按位乘(element-wise product)、按位加(element-wise sum)。MCB的作者认为这些简单的操作效果不如外积(outer product),不足以建模两个模态间的复杂关系。但外积计算存在复杂度过高的问题。由于外积由于其高维度而通常是不可行的,因此作者提出多模态紧凑双线性池(MCB),在VQA和视觉定位任务中都取得了先进的结果。

-

递归神经网络 (RNN) 通常用于表示句子或短语 ,并且卷积神经网络 (CNN) 已显示出最能表示图像 。

![- [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-9o0x0uLb-1687920629637)(./assets/image-20221129192816409.png)]](https://i-blog.csdnimg.cn/blog_migrate/5690f0a20835788c4b5b7dbc05a763e7.png)

- 通过将图像和文本表示随机投影到更高维空间

- 然后通过在快速傅立叶变换(FFT)空间中使用逐元素乘积来有效地卷积两个向量

-

本文的还有一个亮点在于,对于VQA任务,使用两次MCB-一次用于预测对于空间特征的attention,另一次用于融合文本特征和视觉特征。

-

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-T45Jspks-1687920629637)(./assets/image-20221130171438585.png)]](https://i-blog.csdnimg.cn/blog_migrate/eea94406fd76adbe8236ffb7d39dbf62.png)

-

在VQA中,模型的输入是图像和问题,目标是回答问题。模型提取图像和问题的表示形式,使用MCB池向量,并通过将问题视为具有3,000可能类的多类分类问题来得出答案。

-

这里用到了两次MCB模块,第一个MCB融合图像特征和文本特征计算图像每个空间位置的attention weight。第二个MCB融合图像特征和文本特征得到答案。

-

首先使用在 ImageNet 数据 上预训练的 152 层残差网络 提取图像特征。图像大小调整为 448×448,我们使用 1000 路分类器之前的层(“pool5”)的输出。然后我们对 2048-D 向量执行 L2 归一化。

对于视觉表示中的每个空间网格位置,使用 MCB 池将视觉特征的切片与语言表示合并。

为了整合空间信息,在MCB池化方法上使用软注意力。

在池化之后,使用两个卷积层来预测每个网格位置的注意力权重。

-

输入问题首先被标记为单词,单词被单热编码并通过学习嵌入层传递。嵌入后使用 tanh 非线性。嵌入层之后是一个 2 层 LSTM,每层有 1024 个单元。每个 LSTM 层的输出连接起来形成一个 2048 维向量。

-

然后这两个向量通过 MCB。 MCB 之后是逐元素符号平方根和 L2 归一化。在 MCB 池化之后,一个完全连接的层将生成的 16,000 维多模态表示连接到 3,000 个最佳答案。

-

-

-

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-59lAsNQZ-1687920629637)(./重要文章.assets/image-20221130214127709.png)]](https://i-blog.csdnimg.cn/blog_migrate/e47a36ee80cc1a64fc3ae4f33ad293a7.png)

- 对于具有多个选项的VQA,可以额外嵌入答案。为了处理多个可变长度答案选择,每个选择都使用词嵌入和LSTM层进行编码,这些层的权重在候选语句之间共享。

- 除了使用带有注意力机制的MCB之外,还使用了额外的MCB池化来将编码的答案选择与原来的多模式表示合并。

-

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-nvZPb3jS-1687920629638)(重要文章.assets/image-20221130214444152.png)]](https://i-blog.csdnimg.cn/blog_migrate/52fe6f989ee3776721c772084cb1edfe.png)

- 模型的输入是查询自然语言短语和图像以及多个标注框。目标是预测与查询短语对应的框。

13.Multimodal Language Analysis in the Wild: CMU-MOSEI Dataset and Interpretable Dynamic Fusion Graph(2018, Annual Meeting of the Association for Computational Linguistics/374 Citations)

-

这是一个数据集

-

论文中描述的CMU-MOSEI数据集规模最大的三模态数据集,且具有情感和情绪两个标签。但是这里要注意,数据集是多标签特性,即每一个样本对应的情绪可能不止一种,对应情绪的强弱也不同,在[-3~3]之间。数据集的原始数据给出了,但是过于原始,即给出的是文本,音频和视频文件,图像还得自己去以固定频率捕获并且和文本语音对其还是比较麻烦的。大多实验都使用处理好的实验数据。

14.Efficient Low-rank Multimodal Fusion With Modality-Specific Factors(2018, Annual Meeting of the Association for Computational Linguistics/250 Citations)

- 以后摘要的格式可以按照这篇论文来写

- 这篇文章的相关工作也是关于数据融合的,可以作为主要参考文章

- 先有TFN(Tensor Fusion Network for Multimodal Sentiment Analysis),在此基础上提出LMF(Efficient Low-rank Multimodal Fusion with Modality-Specific Factors)对TFN方法进行改进,接着在这篇文章基础上又有了:Low Rank Fusion based Transformers for Multimodal Sequences

- 多模态数据的融合是将多个单模态表示集成为一个紧凑的多模态表示的过程。融合的目标是结合多种模态,以利用异构数据的互补性,并提供更稳健的预测。

A. Introduction

- Introduction部分紧扣多模态融合的主题,第一段先讲多模态研究的好处,第二段介绍多模态融合是多模态研究的重要挑战,其目标、不足,接着针对不足提出了这篇文章的方法:LMF

-

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-EGwKVEZY-1687920629638)(重要文章.assets/image-20221201165700796.png)]](https://i-blog.csdnimg.cn/blog_migrate/6ee0399529c3a12b7ca70f4286d53d99.png)

- LMF首先通过将单峰输入xa、xv、xl分别传递到三个子嵌入网络fv、fa、fl中来获得单峰表示za、zv、zl。LMF通过执行具有模态特定因子的低秩多模态融合来产生多模态输出表示。然后可以使用多模态表示来生成预测任务。

-

本文的主要贡献如下:

- 提出了用于多模态融合的低秩多模态融合方法,该方法可以在模态数量上线性缩放。

- 展示了模型在公共数据集上评估的三个多模态任务的性能上与最先进的模型进行了比较。

- 展示了模型在计算上是有效的,与以前的基于张量的方法相比具有更少的参数。

-

B.相关工作

-

多模态融合使我们能够利用多模态数据中存在的互补信息,从而发现信息对多模态的依赖性。

-

多模态融合方法

-

早期融合

- feature concatenation 直接拼接特征。

- 这类方法的缺点是,尽管它在早期阶段实现了融合,但是模态内交互可能被抑制,从而失去了每个模态内的上下文和时间依赖性。

-

晚期融合

- 后期融合为每个模态构建单独的模型,然后使用多数表决或加权平均等方法将输出集成在一起

- 由于为每种模态建立单独的模型,因此通常不能有效地对模态间的相互作用进行建模。

-

中间融合

-

both intra- and inter- modal.

-

上一篇12.双线性池化文章就属于这一类。类似于利用交互的想法,Zadeh 等人. (2017) 提出张量融合网络(Tensor Fusion Network,TFN),它计算来自三种不同模态的单模态表示之间的外积,以计算张量表示。

-

但是,此类方法的计算复杂度呈指数增长,因为多个模态上的外积会导致极高维张量表示。

-

-

然而,这些先前的工作中没有一个旨在将低秩张量技术应用于多模态融合。

-

本文的低秩多模态融合方法提供了一个更有效的方法来计算基于张量的多模态表示,具有更少的参数和计算复杂度。

-

15.Learning Two-Branch Neural Networks for Image-Text Matching Tasks

- 参考链接:Image Caption 深度学习方法综述 - 知乎 (zhihu.com)

- 基本都是CNN提取图片特征,RNN进行解码,LSTM也是特殊的RNN

- Image Caption是结合了CV和NLP的综合性任务

- 图文匹配的双流神经网络架构

- 跨媒体检索-有监督方法、文本图像跨媒体检索。属于多模态任务中的映射和对齐。

- 本文研究了双分支神经网络,以了解这两种数据模态之间的相似性。文中假定两种网络产生不同的输出理解。首先,学习一个显式、具有最大边际排序损失和新的邻域约束的共享嵌入空间。第二个网络结构,称为相似性网络,通过按位相乘融合两个分支,并且用回归损失训练来直接预测相似性得分。

16.Memory Fusion Network for Multi-view Sequential Learning(2018, AAAI Conference on Artificial Intelligence/299 Citations)

-

记忆融合网络MFN

TFN是张量融合网络 -

文章分类:表示和融合

-

这篇文章的介绍部分首先简介了什么叫多视角数据,即多模态数据,接着介绍了多视图序列学习存在两种交互,接着提出MFN并对结构进行介绍,最后介绍模型的验证,以及和之前的方法相比取得了最优结果。

-

17,18年是注意力机制开始统治学术界的一年,很多工作都做了这方面的工作。

-

Multi-View Sequential Learning:多视图序列学习 ,即多模态序列学习。多视图学习通过挖掘不同视图之间的一致性和互补性,可以比单视图学习更有效、更有前景、泛化能力更强。文章中的multi view其实指代可以很广泛,许多地方也叫做多模态。本文中的多模态数据以序列形式来表示。

-

对于多模态序列学习而言,模态往往存在两种形式的交互:模态内关联(view-specific interactions)和模态间关联(cross-view interactions)。这篇文章提出了Memory Fusion Network(MFN)方法来处理这种多模态序列建模,用于对模态内与模态间的不同处理。

-

-

MFN组成:

- 第一个组成部分:LSTM系统。 在LSTM系统中,每个视图被分配一个LSTM函数以建模视图内的交互。

- 第二个组成部分:Delta-memory Attention Network(DMAN),DMAN通过将相关性得分与每个LSTM的记忆维度相关联来识别交叉视图交互。

- 第三个组成部分:Multi-view Gated Memory,该存储器基于DMAN的输出和其先前存储的内容来更新其内容,充当动态存储器模块。

- 预测是通过集成特定视图和跨视图信息来执行的。

- 2和3致力于处理模态间的交互。

-

-

用memory的目的是能保存上一时刻的多模态交互信息,gated过滤,Attention分配权重。

17.Deep Visual-Semantic Alignments for Generating Image Descriptions(2014, IEEE Transactions on Pattern Analysis and Machine Intelligence/4529 Citations)

- 用于生成图像描述的深度视觉语义对齐

- 分类:对齐,转换

- 本文对齐模型是基于图像区域上的卷积神经网络(CNN),句子上的双向递归神经网络(RNN),以及通过多模态嵌入将两种模式对齐来达到结构化目标。然后使用一个多模态递归神经网络架构,它使用推断的对齐来学习生成新的图像区域的描述。

- 这篇文章在当时有两个方面的突破:

- 提出了一种深度神经网路模型,该模型用来将训练样本中图片中的一些重点部分与生成句中的词组相对应。

- 提出一种多通道RNN框架来描述一张图片。

18.Tensor Fusion Network for Multimodal Sentiment Analysis(2017, Conference on Empirical Methods in Natural Language Processing/569 Citations)

- 多模态融合的baseline

- 用于多模态情感分析的张量融合网络

- 张量积(tensor product) ,可以应用于不同的上下文中如向量、矩阵、张量、向量空间、代数、拓扑向量空间和模。在各种情况下这个符号的意义是同样的:最一般的双线性运算。在某些上下文中也叫做外积。

- 本文提出了多模态情感分析的问题,即模态内和模态间动态建模问题,也就是要求既能考虑各模态之间的特征融合,也要有效地利用各特定模态的特征。本文引入了一个新的模型,称为张量融合网络(TFN),它端到端地学习模态内和模态间的动态。所提出的方法是针对在线视频中口语的易变性以及伴随的手势和声音而定制的。

- 本文在大量实验中,展示了

- TFN优于之前的多模态情感分析方法,

- 多模态情感分析张量融合方法的特征和能力

- 三个模态嵌入子网络(语言、视觉和听觉)中的每一个也优于单模态情感分析方法。

- 图1说明了复杂的模态间动态。“This movie is sick”这句话本身可能是模棱两可的(无论是积极的还是消极的),但如果说话者同时也在微笑,那么它就会被认为是积极的。另一方面,同样的话如果皱着眉头,会被认为是负面的。一个大声说“This movie is sick”的人仍然是模棱两可的。这些例子说明了双模态相互作用。

- 图1显示了三模态互动的例子,较大的声音会使情绪变得积极。第二个三模态的例子显示了模态间动态的复杂性,在这个例子中,考虑到“fair”这个词的强影响,“This movie is fair”这句话仍然是弱积极的。

A.TFN

- TFN模型组成部分:

- Modality Embedding Subnetworks:单模态特征为输入,输出丰富的模态嵌入。

- Tensor Fusion Layer:使用模态嵌入的3-fold笛卡尔积显式地模拟单模态、双模态和三模态相互作用。

- Sentiment Inference Subnetwork是以张量融合层的输出为条件进行情感推理的网络。

Modality Embedding Subnetworks

模态嵌入子网络按照三个不同的模态分为Spoken Language Embedding Subnetwork、Visual Embedding Subnetwork和Acoustic Embedding Subnetwork。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-iDZgfNKu-1687920629639)(重要文章.assets/c89186ca840a442f908489c2625eb179.png)]](https://i-blog.csdnimg.cn/blog_migrate/571a25fcca2c1e695ee62f2f67948403.png)

在上图提取语言模态特征时,首先通过GloVe将每个单词转化为300维的向量,然后通过LSTM来恢复之前被稀释或丢失的可用信息并输出hi,将h1、h2、h3……hTi串联而成的语言矩阵表示为hl。然后将hl用作全连接网络的输入,该网络生成语言嵌入zl。

Visual Embedding Subnetwork

作者使用FACET模型来检测说话人的面部表情,并提取7种基本情绪(愤怒、蔑视、厌恶、恐惧、喜悦、悲伤和惊讶)和两种高级情绪(挫折和困惑)。还使用OpenFace对每帧的头部位置、头部旋转和68个面部地标位置进行了估计。

Acoustic Embedding Subnetwork

对于每个意见音频,作者使用COVAREP声学分析框架来提取一组声学特征。

B.Tensor Fusion Layer

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qoYITm7H-1687920629640)(重要文章.assets/image-20221209155823294.png)]](https://i-blog.csdnimg.cn/blog_migrate/3c0f5a302197f1d7dde23f358378ad51.png)

- 上图中有七个语义不同的子区域。前三个子区域zl、zv和za是在在张量融合中形成单模态相互作用的模态嵌入子网络的单模态嵌入。三个次区域zl⊗zv,zl⊗za和zv⊗za捕捉张量融合中的双模态相互作用。最后,zl⊗zv⊗za捕捉了三模态相互作用。

C. Sentiment Inference Subnetwork

在张量融合层之后,每个观点话语都可以表示为一个多模态张量 。作者使用了一个完全连接的深层神经网络,称为情绪推理子网络Us,其权重Ws以为条件。该网络的体系结构由两层128个ReLU激活单元组成,连接到决策层。

另外,作者在实验中使用了Us网络的三种变体形式,分别用来完成三个不同的情感分类任务。

(1)第一个网络训练用于二元情感分类,使用二元交叉熵损失的单个sigmoid输出神经元。

(2)第二个网络设计用于五类情绪分类,并使用分类交叉熵损失的softmax概率函数。

(3)第三个网络使用单个sigmoid输出,使用均方误差损失进行情绪回归。

19.Automatic Description Generation from Images: A Survey of Models, Datasets, and Evaluation Measures(2016, International Joint Conference on Artificial Intelligence/303 Citations)

20.Deep Multimodal Representation Learning: A Survey(2019, IEEE Access/151 Citations)

-

这篇文章可以再引申一下

- 传统方法在【17】:Multi-view learning overview: Recent progress and new challenges

- 【18】:Multimodal machine learning: A survey and taxonomy

- 18-20都可以参考

-

多模态表示学习的主要目标是缩小联合语义子空间中的分布差距,同时保持特定模态的语义的完整。

-

典型模型与三个框架之间的联系

-

三种框架的典型应用总结

-

- 根据图中所示的底层结构,将深度多模态表示方法分为三种不同类型的框架:

- 联合表示,旨在将单模态表示一起投射到一个共享的语义子空间,以便融合多模态特征;

- 协调表示,包括跨模态相似模型和规范相关分析,它寻求学习协调子空间中的每个模态的分离但受约束的表示;

- 编码器-解码器模型,努力学习用于将一种模态映射到另一种模态的中间表示。

- 用于图像特征学习的最流行模型是卷积神经网络(CNN),如LeNet、AlexNet、GoogleNet、VGGNet[48]和ResNet

- 根据图中所示的底层结构,将深度多模态表示方法分为三种不同类型的框架:

A. 特定模态表示

尽管各种不同的多模态表示学习模型可能共享相似的架构,但用于提取特定模态特征的基本组件彼此之间可能会有很大的不同。

它们可以集成到多模态学习模型中,并与其他组件一起进行训练。

B.联合表示

整合不同类型的特征来提高机器学习方法性能的策略一直被研究使用。

为了弥合不同模态的异质性差距,联合表示的目的是将单峰表示投射到一个共享的语义子空间中,在那里多模态特征可以融合。

在每个模态通过单个神经网络编码后,它们都将被映射到一个共享的子空间,在那里,模态共享的概念将被提取并融合到一个单一的向量中。

- 用于处理数据缺失的训练技巧也有助于获得模态不变属性,这意味着模态之间的统计分布的差异被最小化,或者换句话说,特征向量包含最小的模态特定特征。

- 学习到的向量不能保证会融合互补的语义,形成不同的模式,因为联合表示倾向于保留跨模态的共享语义,而忽略了特定于模态的信息。

- 一个解决方案是在优化目标中添加额外的正则化项。例如,多模态自动编码器[1]中使用的重构损失,作为保持模态独立性发挥作用。

- 对网络权值进行跟踪范数正则化,以揭示多模态特征的隐藏相关性和多样性。直观地说,如果一对特征高度相关,那么用于融合它们的权重应该是相似的,这样它们对融合表示的贡献将大致相等。因此,跟踪范数正则化的目的是发现模态之间的关系,并相应地调整融合层的权重。他们在视频分类任务中的实验表明,这个正则化项有助于提高性能。

优点:

- 可以方便地融合多模式,不需要明确地协调模式

- 共享的公共子空间倾向于是模态不变的,这有助于将知识从一种模态转移到另一种[1],[73]。

缺点:

不能用来推断每个模态的分离表示。

C. 协调表示

协调表示框架是在某些约束[18]下学习每个模态的分离但协调的表示。

由于在不同模式中包含的信息是不平等的,学习分离的表示有助于坚持独家和有用的模式特异性特征[31]。

通常,在约束类型的条件下,协调表示方法可以分为两组,基于跨模态相似性和基于跨模态相关性。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-i9ColONe-1687920629643)(重要文章.assets/bc2056b2e56c47c0bdd0afa3de05fda7.png)]](https://i-blog.csdnimg.cn/blog_migrate/764af9dd6a38adeb4d1c9460ed911a8f.png)

基于跨模态相似性的方法旨在学习一个共同的子空间,其中向量的距离可以直接测量[75],而基于跨模态相关的方法的目的是学习一个共享的子空间,从而使不同模式的表示集的相关性最大化[5]。

这里主讲前者,后者留到后面

跨模态相似度方法在相似度度量的约束下学习协调表示。该模型的学习目标是保持模态间和模态内相似结构,缩小类内矩扩大类间距。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ZDXKFJmA-1687920629643)(重要文章.assets/c0e4e013f0e948f58036a7899d5ec758.png)]](https://i-blog.csdnimg.cn/blog_migrate/d221745ae74332663ce8a8ef479eedaf.png)

除了学习模态间相似性度量外,跨模态应用还应保持模态内相似性结构。

一种广泛使用的策略[30],[79]是对学习特征进行分类,使它们在每个模态中都具有鉴别性。

另一种方法是在每个视图中保持邻域结构。

另外[80]提出通过协调表示模型来学习图像-文本嵌入,该模型将交叉视图排序约束与视图损失函数内邻域结构保存约束相结合。

与其他框架相比,协调表示倾向于坚持每个模态中唯一且有用的模态特定特征

优点:

由于不同的模态被编码在分离的网络中,每个模态都可以单独推断出来。这一有利于跨模态迁移学习,旨在跨不同的模式或跨领域转移知识。

缺点:

大多数情况下,很难学习具有两种以上模式的表示。

D.编解码器

将一种模态映射到另一种模态 编码器将源模态映射到一个潜在的向量v中,然后,基于向量v,解码器将生成一个新的目标模态样本。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-hDvhZqi3-1687920629643)(重要文章.assets/80e96c7defd74d769dc7b7d36e2c5c80.png)]](https://i-blog.csdnimg.cn/blog_migrate/250249e34d8e25975d9bcfdfbc2fbc93.png)

表面上,编码解码器模型学习到的潜在向量似乎只与源模式有关,但实际上,它与源模式和目标模式都密切相关。由于纠错信号的流动方向是从解码器到编码器的,因此编码器在训练过程中由解码器引导。随后,生成的表示法倾向于从这两种模式中捕获共享的语义。

优点:

能够在源模态表示上生成目标模态条件新的样本。

缺点:

每个编码器-解码器只能编码其中一种模式。此外,应该考虑到设计生成器的复杂性,因为生成合理目标的技术仍在其开发中。

3.典型模型

A. 概率图(GRAPHICAL)模型

包括深度置信网络(DBN)[97]和深度玻尔兹曼机(DBM)[98]。前者是由定向信念网络和RBM层组成的部分有向模型,后者是完全无向模型。

优点:

- 可以以无监督的方式进行训练,允许使用未标记的数据

- 来自于它们的生成性质使得可以在其他的[96]上生成缺失的模态条件成为可能

缺点:

相当高的计算成本[102]

B. 多模态自编码器

无监督,不需要标签[103]

编码器将输入转换为一个压缩的隐藏向量,也称为潜在表示,而解码器则努力基于这种潜在表示重构输入,从而使重构损失最小化。

使用自动编码器来提取中间特征的模型可以分成两个阶段。 第一步,在无监督学习的基础上,通过分离的自动编码器提取特定于模态的特征。

然后,将施加一个特定的监督学习程序来捕获跨模态相关性。

优点:

- 学习到的潜在表示可以保留输入数据的主要语义信息。从生成模型的角度来看,由于输入可以从这种潜在的表示中重构,因此可以相信生成输入的关键因素已经被编码。

- 可以通过无监督的方式进行训练,而不需要标签。

缺点:

由于该模型主要是为通用目的而设计的,为了提高其在特定任务中的性能,需要涉及额外的约束或监督学习过程。

C. 深度规范相关分析(CCA)

是一种最初用于测量一对集合之间的相关性的方法。在多模态表示学习场景中,给定两组数据,每对都是包含两种模式的数据样本,CCA的目标是找到两组基向量用于将多模态数据映射到共享的d维子空间,使得这样投影表示之间的相关性最大化[5],[110]。

如果每个集合的均值为零,目标函数如下

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-DcoZ3xLr-1687920629643)(重要文章.assets/089c98507c91476a8ca1a40a9275b2ed.png)]](https://i-blog.csdnimg.cn/blog_migrate/ec7fef9b128265bba60f7efd37ec68af.png)

基本的CCA仅限于建模线性关系,一个非线性扩展是核CCA[111],它在应用CCA方法之前将数据转换为高维希尔伯特空间。但是可伸缩性[112]较差,因为它的封闭形式的解决方案需要计算高时间复杂度和内存消耗;而且效率很差,这是由于它在转换一个看不见的实例[117]时需要访问所有的训练集。

通常,最大化相关目标侧重于学习共享的语义信息,但往往忽略特定模态的知识。为了解决这个问题,应该考虑额外的正则化术语。

优点:

可以以无监督的方式进行训练

缺点:

计算复杂度较高,这可能会限制其在数据大小上的可伸缩性。

D. 生成对抗网络

作为一种无监督的学习方法,它可以用于学习数据表示,而不涉及标签,从而显著降低了对人工注释的依赖性。

此外,作为一种生成方法,它可以根据训练数据的分布生成高质量的新样本。

与经典的表示学习方法相比,GANs的一个明显区别是,数据表示的学习过程并不简单。这是一种隐含的范式。与传统的无监督表示方法不同,如直接学习从数据到潜在变量的映射的自动编码器,GANs学习从潜在变量到数据样本的反向映射。具体来说,生成器将一个随机向量映射到一个独特的样本中。因此,这个随机信号是一个对应于生成的数据的表示。

- 生成对抗网络是非监督式学习的一种方法,通过让两个神经网络相互博弈的方式进行学习。该方法由Google研究人员Ian Goodfellow于2014年提出。生成对抗网络由一个生成网络与一个判别网络组成。生成网络从潜在空间(latent space)中随机采样作为输入,其输出结果需要尽量模仿训练集中的真实样本。判别网络的输入则为真实样本或生成网络的输出,其目的是将生成网络的输出从真实样本中尽可能分辨出来。而生成网络则要尽可能地欺骗判别网络。两个网络相互对抗、不断调整参数,最终目的是使判别网络无法判断生成网络的输出结果是否真实。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UqLHysaj-1687920629644)(重要文章.assets/image-20221212115946149.png)]](https://i-blog.csdnimg.cn/blog_migrate/c3086379813bc1c04ac0e351c8f05f71.png)

21.Foundations and Recent Trends In MultiModal Machine Learning:Principles,Challenges and Open Questions()

多模态问题的两个关键特点和六个核心挑战

两个原则

- 不同模态之间是异构的,因此不同模态中的信息通常表现出不同的质量、结构,例如文本,图像,音频,视频,时间序列,面板数据,图数据等等

- 模态是相互关联的,对于下游任务而言,它们通常相互存在关联、共享某些共性或具有复杂的相互作用,从而产生新的信息。

端到端

-

端到端指的是输入是原始数据,输出是最后的结果,原来输入端不是直接的原始数据,而是在原始数据中提取的特征

多模态数据集

- 多模态分析数据集(Multimodal Dataset)整理 - 骑着白马的王子的文章 - 知乎 https://zhuanlan.zhihu.com/p/189876288

![> [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-jm2uELm4-1687920629641)(重要文章.assets/c9a7382bb1d14733808e2114b744f6ea.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-NOjuwLlt-1687920629641)(重要文章.assets/23f7be3cb33143d58051ce607f852cf2.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-JIvubpIZ-1687920629641)(重要文章.assets/59b46c57291b42278dfdec651dce6708.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-XX0LBiMH-1687920629642)(重要文章.assets/4c0d116023474ec5895d82f1869a8930.png)]](https://i-blog.csdnimg.cn/blog_migrate/571c61f6750e079e09e5c27fb34ecede.png)

681

681

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?