这是我精读的第一篇IEEE2020论文,我认为这一篇论文非常有意义,因为它是目前为止最先进显著性预测模型,在理解论文过程中,我查阅了许多相关资料,其中一些放在文章最后的补充概念部分,这对理解SalBiNet360的原理非常重要。另外,如果翻译过程中有什么不妥之处,欢迎在评论区留言指正。

英文名称:SalBiNet360: Saliency Prediction on 360° Images with Local-Global Bifurcated Deep Network

中文名称:基于局部-全局二叉式深度网络的360°全景图显著性预测

论文会议:2020 IEEE Conference on Virtual Reality and 3D User Interfaces (VR)

论文地址:https://ieeexplore.ieee.org/abstract/document/9089519

文章目录

摘要

随着虚拟现实应用的发展,在360°全景图上预测人类的视觉注意对理解用户的行为至关重要。基于360°全景图全局和局部视觉显著性的特点,论文提出了一个用于360°全景图显著性检测的框架(SalBiNet360)。在全局深度子网络中,利用多个多尺度的上下文模块和一个多级解码器来整合网络中层和深层的特征。在局部深层子网络中,只利用一个多尺度上下文模块和一个单级解码器来减少局部显著性特征的冗余。最后利用线性组合方法,结合全局和局部显著图的特点,生成最终的融合显著图。在两个公开数据集上进行的定性和定量实验表明,SalBiNet360的性能优于当前最先进的方法,特别是能够更好地预测低显著性区域和图像左右边界附近的区域。

关键词: 360°度全景图,SalBiNet360,虚拟现实 (VR)

关于视觉注意及视觉显著性检测见本文最后的补充概念

1 引言

360°全景图在VR技术中扮演着至关重要的角色。与2D图像不同,360°全景图允许观察者从各个方向观察场景,因此其特性吸引了研究者更多的兴趣。此外,预测观察者在360°图像上的视觉注意力,可以帮助研究人员了解观察者佩戴VR设备时的行为,它还可以应用在计算机视觉的各个方面,如图像压缩和图像裁剪。

显著性模型是在人类没有明确意图的情况下,观察图像所注意的物体或区域。随着神经网络的兴起和发展,对传统二维图像上的显著性预测模型进行了深入的研究。许多优秀的模型已经出现,并建立了大量的数据集,如MIT Saliency Benchmark(一个显著性预测框架)。然而,到目前为止,关于360°全景图的显著性预测的研究还比较少,尤其是以神经网络为框架的研究。一般情况下,我们通常会通过ERP投影的方式将360°全景图投射到一个平面上,但这种投影方式会使360°全景图对应球面的两个极点被转换为上界和下界,从而导致图像过度变形。

关于ERP投影见本文最后的补充概念

如果将传统二维图像上的显著性预测模型直接应用于ERP图像上,效果将不理想。图1©显示了在传统二维图像上,由显著性模型预测的全局ERP显著图。与ground truth(图1(b))相比,全局显著图大致预测了显著性区域(赤道区域)。但是对于其它低显著性的区域(观察者不太关注的区域),传统模型无法预测它们。

图1:(a)ERP图像,(b)ground truth显著图,©(d)分别是全局和局部的显著图,(e)-(j)通过立方体投影的直线显著图。

为了解决这个问题,利用立方体投影将360°全景图投射到立方体的六个面,每个面的视场角(FOV)为90°,显示六个方向的景物,而且比ERP图像失真小,这些立方体图被命名为rectilinear images,我将其译为直线图像。图1(e)-(j)说明了这六张直线显著图,而图1(d)则说明了由这些直线显著图重新投影出来的局部显著图。与全局显著图相比,局部显著图可以精细地预测显著性区域,即使是一些显著性较低的区域也可以预测。(这里全局和局部特征我理解为:如果从整张ERP图片提取特征就是全局特征,如果从立方体投影的六个面分别提取特征,再重新投影到一张图上,那么得到的就是局部特征)

关于立方体投影及视场角(FOV)见本文最后的补充概念

然而,在预测缺乏全局性的直线显著图时,模型增强了低显著性区域,甚至一些不被人类关注的区域也被错误地预测出来。在图1(i)和图1(j)中,除了云层和坑洞,几乎没有什么物体,它们显然是突出的。所以在局部显著性图(图 1(d))中,这两类物体很容易被预测出来。但是预测整幅图像时,在其它物体的存在下,云层和坑洞就显得不那么突出了。因此,模型对云层和坑洞的敏感度较低,所以,在缺乏全局性的直线图像中,模型对低显著性的区域是很敏感的。

为了解决上述问题,作者提出了一种基于360全景图的全局和局部显著性预测的新框架(SalBiNet360)。这是一个包含全局和局部显著性预测子网络的(二叉式)深度网络框架。在全局深度子网络中,我们利用多个多尺度的上下文模块从网络的中层和深层提取上下文特征,然后,这些特征由一个多级解码器整合,预测全局显著性图。对于局部深层子网络,为了降低网络对一些低显著性区域的敏感性,只利用一个多尺度上下文模块,然后利用单级解码器来还原图像的分辨率,生成直线显著图。最后,将多张直线显著图重新投影成局部显著图(如图1(d)),利用线性组合策略将全局显著图与局部显著图融合。综上所述,我们做出了以下贡献:

- 本文提出了一种全新的二叉式深度网络,该网络有两个子网络,分别预测360°全景图的全局和局部显著性特征,通过线性组合将全局显著图和局部显著图融合生成最终的显著图。

- 提出了一种新的多尺度上下文模块,以提取360°全景图多尺度的上下文特征。

- 采用全局子网络中的多级解码器,以减小不同层网络的判别特征之间的差距。

- 在两个公开可用的数据集上进行的广泛实验说明,所提出的SalBiNet360优于经过测试的最先进的方法。

2 相关工作

到目前为止,大多数360°全景图的显著性预测模型都是在传统二维图像模型基础上改进的(所谓的传统二维图像模型是指用二维图形训练和测试的模型),主要有三个研究方向,分别是赤道偏移、凝视位置的数据映射和投影变换。

赤道偏移。当观察者观看VR全景图像时,他们往往会更多地关注赤道附近的内容,这被命名为赤道偏移。Battisti等人利用这一特性,将360°全景图划分为多个区域,每个区域赋予它们不同的显著性权重,区域越靠近图像的赤道,权重越大。Ding等人从图像层面细化到像素层面,利用高斯分布模型来模拟赤道偏差,从而提高了精度。但他们都只是基于360°全景图的全局属性设计模型,并没有考虑到局部的显著性。

凝视位置的数据映射。一些显著性预测方法,是基于凝视位置的数据映射,就是利用观察者的凝视位置数据来建立显著图。这类方法将观察者有限的注视位置扩展为一般的显著图。Upenik等人利用头部运动轨迹来预测显著性,根据头部角度速度来确定观察者观察图像某些区域时所花费的时间。Abreu等人根据观察者的固定时间来区分观察者的视觉注意(即根据观察者看某一部分区域的大概时间来区分显著性区域)。

对于投影变换,最常用的方法是ERP投影。为了解决ERP图像的边界失真问题,Lebreton等人将几个不同经度边界的ERP投影的显著图均匀地整合在一起,从而得到最终的显著图。但是,他们没有解决图像上下边界附近发生严重失真的问题。Startsev等人将360°全景图投射到ERP图像和反ERP图像上,然后对这两幅图像进行预测,并将其融合,解决了等ERP图像左右边界不连续的问题。此外,他们还单独预测了图像上下边界附近的显著性。但是他们直接使用了预训练的显著性模型,而不是通过360°全景图来训练它们,所以这些模型无法提取360°全景图的具体特征。而球面投影则是将360°全景图投射到球面上,使图像具有连续性,图像上的景物不易失真,可以提高模型的精度。但是,应用这些模型预测立体空间中的图像是复杂的。Bogdanova等人提出了一个基于球面投影的显著模型,构建球形金字塔模块,从而输出球面显著图。

除以上几种投影变换方法外,还有立方体、八面体、正金字塔投影等。立方体投影是比较常用的,Maugey等人提出了双立方体投影法,以解决立方体投影中的边界畸变和不连续问题。该方法将360°全景图投影到两个水平和垂直相差45°的立方体上,然后通过旋转将两个显著图融合。虽然它可以精细地预测局部的显著图,但由于直线图像缺乏全局性,导致一些低显著性的区域被错误地预测。Chao等人提出的SalGAN360在上述方法基础上扩展到多立方投影,也分别预测了全局和局部的显著图。但是,它始终利用SalGAN预测全局和局部的显著性特征,而没有考虑到360°全景图的全局和局部属性,以提高网络。

本文根据360°全景图的全局和局部属性,将提出的网络分为两个不同的深度子网络,分别预测全局和局部的显著性特征,通过融合得到最终的显著图。

3 方法

在本节中,构建了包含全局和局部深度子网络的二叉式网络(SalBiNet360)。在全局深度子网络中,生成了一个全局的显著图,可以检测所有方向的视觉注意力。在局部深度子网络中,生成了一个以精细方式检测视觉注意力的局部显著图。最后,通过与全局和局部显著图的线性组合,生成融合的显著图。

3.1 SalBiNet360机制

3.1.1 Framework

所提出的模型框架如图2所示,它利用ResNet50作为骨架。ResNet50有四个卷积块(输入层还有一个卷积)。对于一个输入图像,在第四个卷积块中,分辨率降低了32倍。这里从网络中第二个卷积块的最后一层开始,我们将网络分成两个深度子网络,其中一个子网络预测全局的显著性,而另一个子网络预测局部的显著性。这两个子网络都有ResNet50最后两个卷积块。图2蓝色的方块就是ResNet50的convBlock块,一个convBlock包含多个卷积操作,若想对ResNet50有更深的理解,ResNet残差网络及变体详解,相信会让你有所收获。

图2:SalBiNet360的框架。该网络分为全局和局部深度子网络,分别用来预测360°图像的全局和局部显著性特征。

在全局显著性预测中,将整个ERP图像纳入全局子网络,输出全局显著性图。一般来说,神经网络的第一个卷积块会提取一些低级特征,如形状、纹理、轮廓等,但这些特征对显著性预测的贡献较小。此外,不同尺度的卷积层可以保留精细的上下文信息,尤其是中间*的特征图的尺度相对较大,这使得更多的全局信息得以保留。因此,将最后三个卷积块的特征被提取出来,分别输入到三个相同的多尺度上下文模块(MCM)中,然后生成三个不同层次的特征图。之后,采用多级解码器对三个特征图进行整合,生成全局显著图。

在局部显著性预测中,首先通过立方体投影将360°全景图投射到立方体的六个面上,每个面的FOV为90°,可以得到多个直线图像。然后,把这些直线图像输入到局部子网络,局部子网络输出相应的直线显著图。最后,ResNet50的后三个卷积块的特征也在局部子网络中被提取出来。如果在局部子网络中加入多个多尺度的上下文模块(就像全局子网络的架构一样),会增加局部显著图的冗余度。在图3中,沟渠和灯具是ground truths中显著性较低的对象,与只有一个多尺度上下文模块的局部子网络相比,有多个多尺度上下文模块的局部子网络会错误地将这些显著性较低的对象预测为高显著性的对象。

图3:具有一个和多个多尺度上下文模块的地面真相和局部显著图的视觉比较。("MCM"表示多尺度上下文模块)

因此,与全局子网络中的操作不同,局部子网络的最后三个卷积块中的特征图是连在一起的,只是输入到一个多尺度的上下文模块中。之后,采用卷积-上采样操作的单级解码器,将多尺度上下文模块输出的结果恢复到与输入的分辨率一样的大小。然后,利用重投影法将这些直线显著图重新投影成多个ERP显著图,通过使用平均法将所有的ERP显著图重叠,得到局部显著图。

最后,将全局和局部的显著图进行线性组合融合,得到融合的显著图。多尺度上下文模块和多级解码器的具体内容将在3.2节和3.3节中介绍。

3.1.2 预训练

在没有360°全景图的大型数据集的情况下,SalBiNet360必须由SALICON进行预训练(SALICON是一个显著性检测数据集)。该数据集包含20 000张二维图像以及相应的显著图,其中10,000张用于训练,5,000张用于验证,5 000张用于测试。将二维图像放入模型中,相应地同时生成两张预测的二维显著图,一个是来自全局子网络,另一个是来自局部子网络。然后利用 ground truth的显著图,根据二元交叉熵损失来监督这两个子网络的训练。

3.1.3 微调

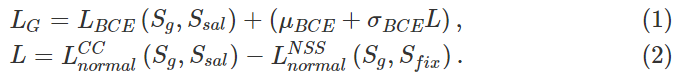

在使用SALICON预训练模型后,将全局和局部深度子网络进行联合微调。做法是将训练的直线图像分别放入模型中,相应地同时生成两个预测的直线显著图,一个是来自全局子网络,另一个是来自局部子网络。在360°全景图显著性预测模型中,经常使用皮尔逊相关系数(Pearson’s Correlation Coefficient,简称CC) 和归一化扫描路径显著性(Normalized Scanpath Saliency,简称NSS)这两个指标来衡量模型的有效性。因此,在二元交叉熵中加入这两个指标来优化模型训练的过程。对于全局子网络,损失可以定义如下:

其中,ܵ S g S_g Sg、 S s a l S_{sal} Ssal、 S f i x S_{fix} Sfix 分别是全局子网络预测的直线显著图、ground truth的直线显著图和二元直线定点图, μ B C E \mu_{BCE} μBCE和 σ B C E \sigma_{BCE} σBCE表示SalBiNet360对预测的二维图像计算出的 L B C E L_{BCE}

SalBiNet360是一种创新的深度学习模型,针对360°全景图的显著性预测。论文提出全局-局部二叉式网络,通过多尺度上下文模块和多级解码器整合特征,预测全局和局部显著图。实验表明,SalBiNet360在360°全景图显著性检测上优于现有方法,尤其擅长预测低显著性和边界区域。

SalBiNet360是一种创新的深度学习模型,针对360°全景图的显著性预测。论文提出全局-局部二叉式网络,通过多尺度上下文模块和多级解码器整合特征,预测全局和局部显著图。实验表明,SalBiNet360在360°全景图显著性检测上优于现有方法,尤其擅长预测低显著性和边界区域。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1406

1406

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?