论文标题:Qwen2.5 Technical Report

论文地址:https://arxiv.org/abs/2412.15115

论文发布时间:2024年12月19日

这篇论文看的还是比较爽的,基本上10分钟就看完了。而且Qwen2.5技术报告主要是从训练角度介绍和Qwen2的区别,技术原理没有深入。

虽然Qwen并没有率先做出来推理,也没有像DeepSeek一样爆火出圈,但是但凡去看一下这几年来它开源出来的上百个模型,伟大无须多言。

Abstract & Introduction

论文介绍了Qwen2.5系列 LLM,该系列在预训练和后训练阶段均有显著改进。

预训练数据集扩展至18万亿个token,为常识、专业知识和推理能力奠定坚实基础。后训练采用监督微调和多阶段强化学习,增强人类偏好和长文本生成、结构数据分析和指令跟踪能力。

Architecture & Tokenizer

模型架构仍然没变,为Decoder Only,只是在训练语料和训练流程上做出了改进。

Qwen2.5模型核心组件仍然为:

- GQA 分组注意力

- SwiGLU Swish+GLU激活

- RoPE 旋转位置编码

- RMSNorm 均方根归一化

- DCA 双块注意力

- YaRN

其开发了各种尺寸的模型:

Pre-training

预训练数据

与前身 Qwen2 相比,Qwen2.5 在训练前数据质量方面表现出显著增强:

(1) 更好的数据筛选。利用 Qwen2-Instruct 模型作为数据质量过滤器,以评估和评分训练样本。增强功能可实现更细致的质量评估,从而提高高质量训练数据的保留率,并更有效地筛选多种语言中的低质量样本。

(2) 更好的数学和代码数据。在 Qwen2.5 的预训练阶段,整合了来自 Qwen2.5-Math 和 Qwen2.5-Coder 的训练数据。

(3) 更好的合成数据。为了生成高质量的合成数据,特别是在数学、代码和知识领域,利用 Qwen2-72B-Instruct 和 Qwen2Math-72B-Instruct 。通过使用专有的通用奖励模型和专门的 Qwen2-Math-RM-72B 模型进行严格过滤,进一步提高了这些合成数据的质量。

这里其实已经在蒸馏了。。

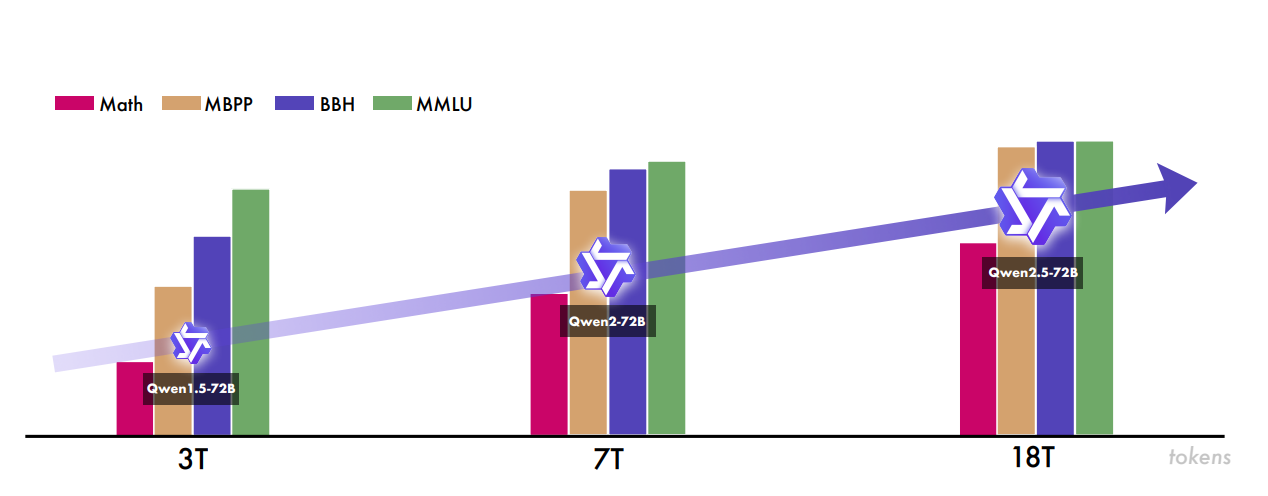

基于这些技术,开发了一个更大、更高质量的预训练数据集,从 Qwen2 中使用的 7 万亿个token扩展到 18 万亿个token。

继续探索Scaling Law

虽然以前的研究主要使用Scaling Law来确定给定计算预算的最佳模型大小,但是Qwen团队利用它们来识别跨模型架构的最佳超参数。具体来说,Scaling Law有助于确定密集模型和不同大小的 MoE 模型的关键训练参数,例如批量大小 B 和学习率 μ。

此外,利用Scaling Law来预测和比较具有不同参数计数的 MoE 模型的性能与密集的对应模型。该分析指导了对 MoE 模型的超参数配置,使能够通过仔细调整激活参数和总参数来实现与特定密集模型变体(例如 Qwen2.5-72B 和 Qwen2.5-14B)的性能相等。

长上下文预训练

Qwen2.5 采用了两阶段的预训练方法:

初始阶段具有 4096 个标记的上下文长度,然后是扩展阶段(用于较长序列)。

在最后的预训练阶段,将除 Qwen2.5-Turbo 之外的所有模型变体的上下文长度从 4096 个令牌扩展到 32768 个令牌。同时,使用 ABF 技术将 RoPE 的基本频率从 10000 增加到 1000000。

为了增强的模型在推理过程中处理较长序列的能力,实施了YARN 和 DCA。通过这些创新,序列长度容量增加了四倍,使 Qwen2.5-Turbo 能够处理多达 100 万个token,而其他模型可以处理多达 131072 个token。

后训练

与 Qwen 2 相比,Qwen 2.5 在其训练后设计中引入了两项重大改进:

(1) 扩大了监督微调数据覆盖范围:监督微调过程利用了包含数百万个高质量样本的海量数据集。这种扩展专门解决了之前模型存在局限性的关键领域,例如长序列生成、数学问题解决、编码、指令跟踪、结构化数据理解、逻辑推理、跨语言迁移和健壮的系统指令。

(2) 两阶段强化学习:Qwen 2.5 中的强化学习 (RL) 过程分为两个不同的阶段:离线强化学习 RL 和在线强化学习。

后训练技术DPO、SFT、GRPO都有用到

156

156

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?