YOLOv8添加注意力机制方法

注意力机制示例1:MHSA

1、 注意力机制文件放在nn文件夹下

2、 task.py文件导入注意力机制文件

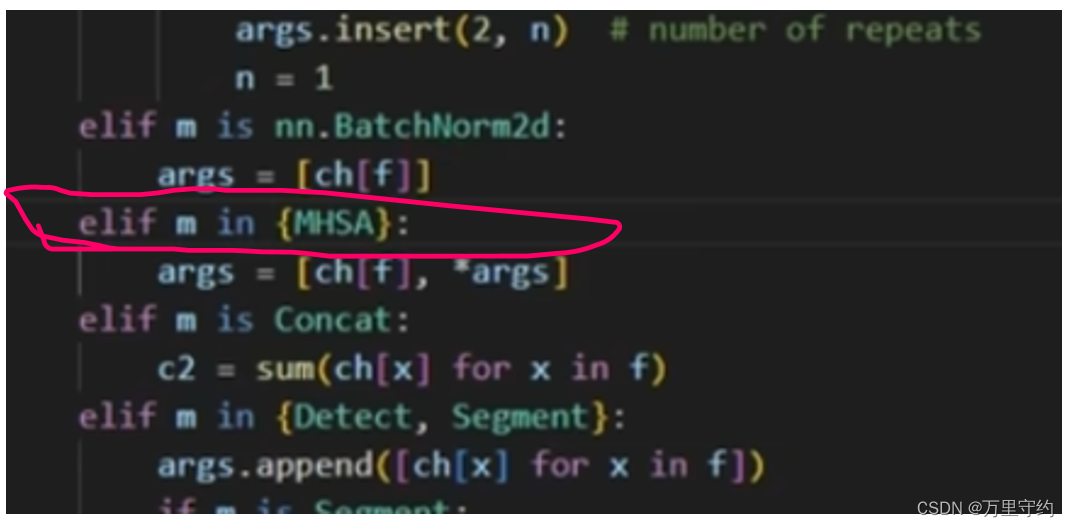

3、 task.py中parse_model函数添加elif语句:

注意是in

4、 改模型配置文件

原模型(左图)和添加注意力机制后的(右图)

这里的参数要看MHSA的参数要求

该注意力机制属于有参数的

注意力机制示例2:ShuffleAttention

1、 nn文件夹下添加.py文件,task.py文件导入ShuffleAttention

2、 parse_model函数添加elif语句,由于该注意力机制也接收通道数为参数,所以方法和MHSA相同

本文介绍了如何在YOLOv8模型中添加MHSA注意力机制,包括文件结构的调整、模型配置的修改以及ShuffleAttention和SiAM机制的引入。着重说明了不同注意力机制的导入方式和参数处理。

本文介绍了如何在YOLOv8模型中添加MHSA注意力机制,包括文件结构的调整、模型配置的修改以及ShuffleAttention和SiAM机制的引入。着重说明了不同注意力机制的导入方式和参数处理。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3321

3321

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?