一、整体部分

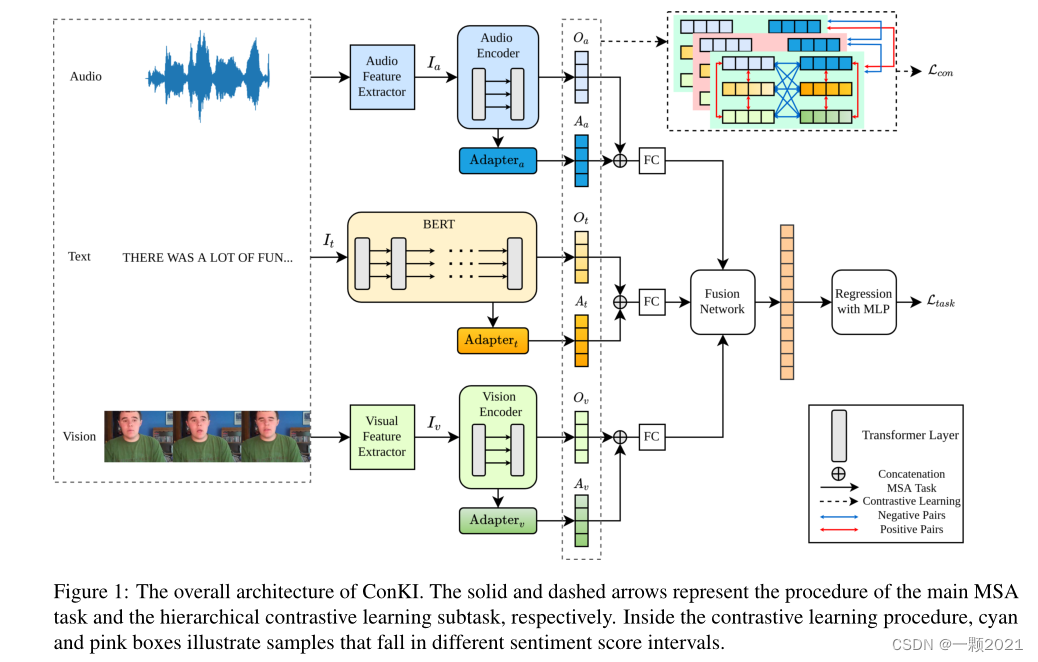

话不多说,先上整体框架图。同样的和大多数做法一样,对于文本模态,用Bert提取,音频和视频使用transformer提取特征。这里创新的一点是,通过知识注入适配器Adapter将外部知识注入到每个模态,称为特定知识,再和特征提取器提出来的称为泛知识融合。然后再进行跨模态融合。通过层次对比学习来区分特定知识和泛知识。

主要贡献:

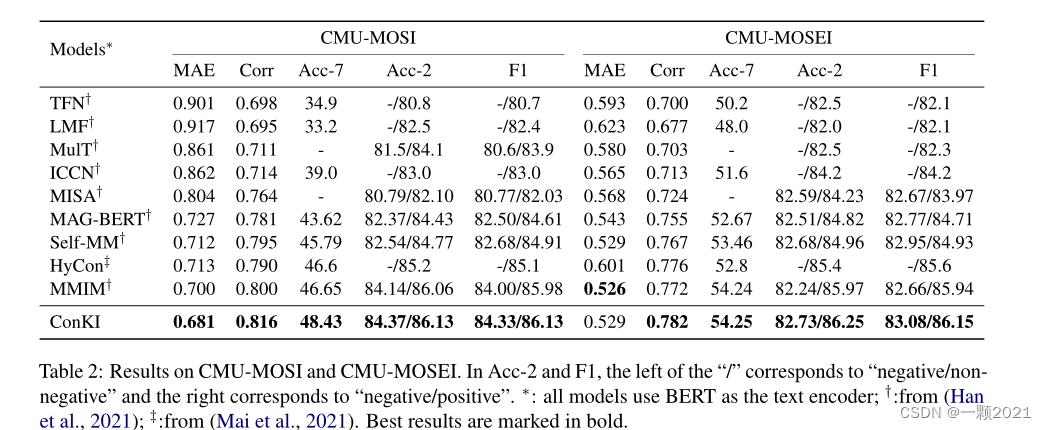

1.我们提出了ConKI,一个用于多模态情感分析的对比知识注入框架。ConKI旨在通过从其他数据集注入外部知识和分层对比学习来提高模型性能,这被证明比简单地使用外部数据集进行微调更好。

2.我们提出了层次对比学习,它使用统一的对比损失来将泛知识表示从特定知识表示中分离出来,因为它们属于不同的知识领域,应该相互补充。

3.我们在三个流行的基准MSA数据集上进行了广泛的实验,并在所有指标上获得了优于现有最先进的MSA基线的结果,证明了在ConKI中提出的方法的有效性。

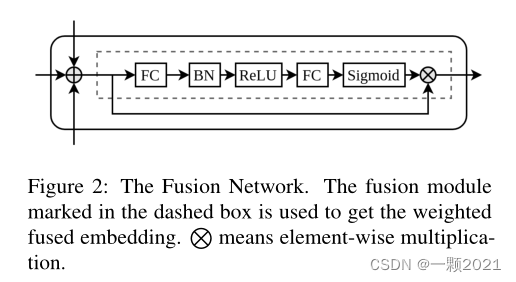

二、融合网络

跨模态融合网络,常规,无需多介绍。

知识注入适配器结构,穿插再编码器的transformer块中,从外部获取特定知识。关于知识注入,以前的做法是将类似于情感词典的特殊知识注入到NLP情感分析网络中,因为实际的或测试的数据的一句话都很短,难以或误判其情感,该方法在提高性能上有效。该文首次将知识注入应用到多模态中,关于图像和音频模态,如何知识注入,文章好像没有详细展开说。

三、层次对比学习、分层融合

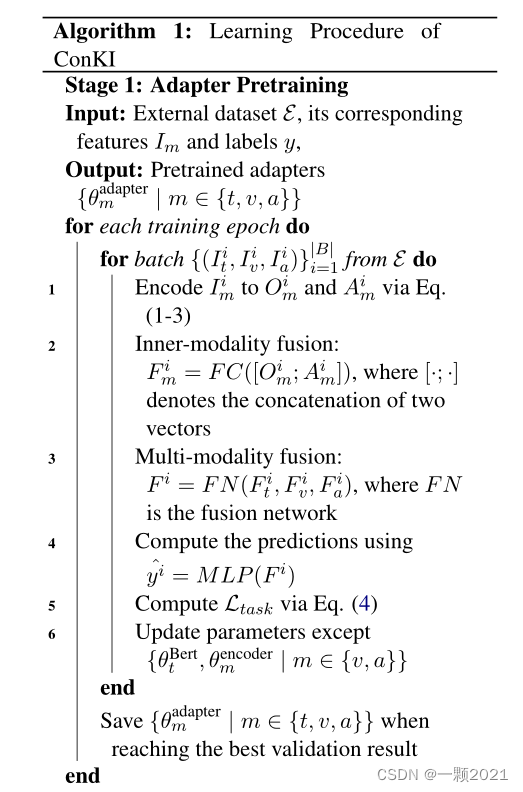

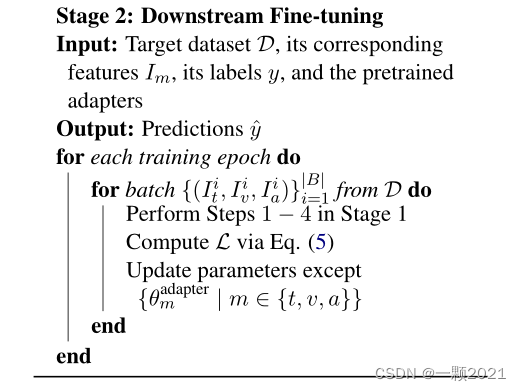

先贴上算法流程

可能没有太看懂,我的理解是,文章用了4个对比学习,分别是:

1.对于单个视频的说话动机,比如说话者表达了开心,那么他的三个模态应该具有相同的说话动机和特征,因此将其各模态特征拉近,作为正样本对,P代表positive。O和A分别代表泛知识和特定知识。

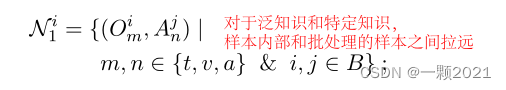

2.对于一般预训练编码器提取的泛知识和知识注入的特定知识,属于不同领域,在样本间和批次间应该拉远,作为负样本对。

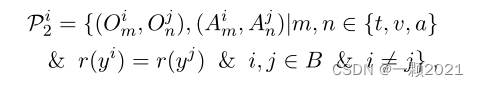

3.对于具有相似情感的样本i和j,情感得分四舍五入后,应该拉近这两个样本的三个对应的O和A,形成正样本对。这里的r()是四舍五入函数。

4.除上述三方面推导出的对外,其余同批次样本i的对设为负对。

这个分层对比学习子任务背后的基本原理如下。首先,我们在每个样本的每个知识类型中捕获三种模式的共性,以减少共享动机下的模式差距。其次,我们对每个知识类型中亲密情感样本的共性进行建模,以减少样本差距。第三,我们捕获了每个样本中泛知识表示和知识特定表示之间的差异,从而导致两种知识类型表示的互补效应。最后但并非最不重要的是,我们捕获了每个知识类型中不同情感样本之间的差异,以学习不同情感区间的动态。

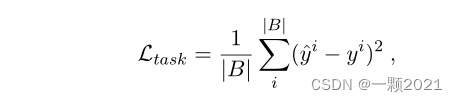

两个损失函数如下:

最终损失加起来。

四、实验结果

总结,感觉这篇文章很新很厉害。可惜没有公开代码,很想去实验看看效果。

1161

1161

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?