9.2 图像分割

场景描述:

| 图像分类 | 图像识别 | 图像分割 | |

|---|---|---|---|

| 不同 | 标注出每个目标的类别 | 像素级别的图像识别,标注出图像中每个像素所属的对象类别 | |

| 不同 | 对整张图像进行识别 | 进行稠密的像素级分类 | |

| 应用场景 | 视频软件中的背景替换、避开人物的弹幕模板、自动驾驶以及医疗辅助判断等 | ||

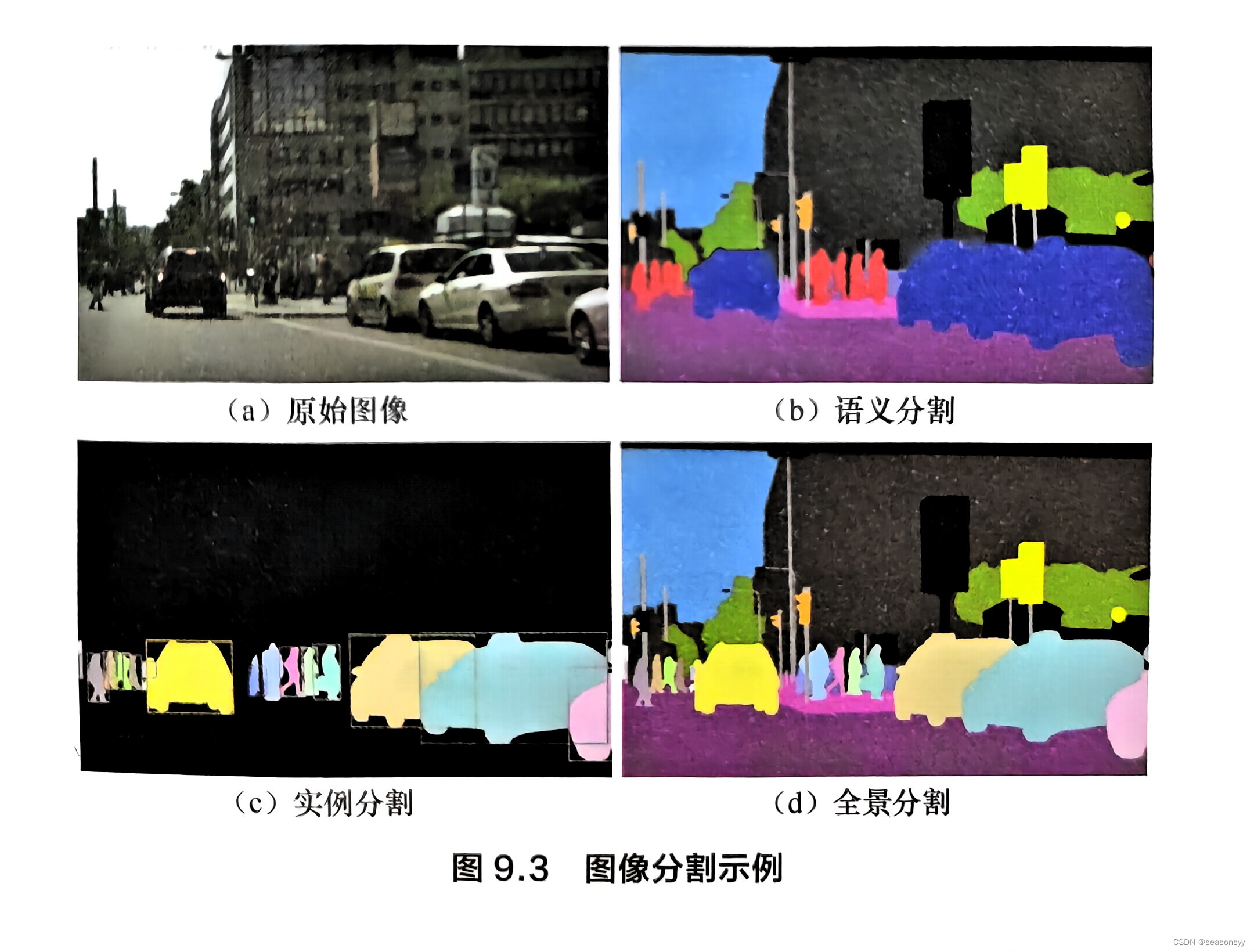

| 分类 | 前景分割(foreground segmentation)、 语义分割(semanticsegmentation)、 实例分割(instance segmentation) 2018年开始兴起的全景分割(panoptic segmentation)(图9.3) | ||

| 常用数据集 | PASCAL VOC2012[23]、 MS COCO[25]、 CityScapes[24] |

- 图像分割是指像素级别的图像识别,即标注出图像中每个像素所属的对象类别。

- 与图像分类对整张图像进行识别不同,图像分割需要进行稠密的像素级分类。

- 图像分割的应用场景有很多,比如我们看到的视频软件中的背景替换、避开人物的弹幕模板、自动驾驶以及医疗辅助判断等都使用了基于图像分割的技术。

根据应用场景的不同,图像分割任务可以更精细地划分成以下几类:

- 前景分割(foreground segmentation),

- 语义分割(semanticsegmentation),更注重类别之间的区分;

- 实例分割(instance segmentation),更注重个体之间的区分;

- 2018年开始兴起的全景分割(panoptic segmentation),如图9.3所示[22],语义分割和实例分割结合

学术界常用的图像分割方面的数据集有PASCAL VOC2012[23]、MS COCO[25]和CityScapes[24]。

知识点:图像分割、编码器-解码器结构、空洞卷积、DeepLab算法

9.2.1 简述图像分割中经常用到的编码器-解码器网络结构的设计理念。

- 图像分割中的编码器可视为特征提取网络,通常使用池化层来逐渐缩减输入数据的空间维度;

- 而解码器则通过上采样/反卷积等网络层来逐步恢复目标的细节和相应的空间维度。

图9.4以U-Net为例,给出了一个具体的编码器-解码器网络结构[27]。

在编码器中,引入池化层可以增加后续卷积层的感受野,并能使特征提取聚焦在重要信息中,降低背景干扰,有助于图像分类。

√问题:然而,池化操作使位置信息大量流失,经过编码器提取出的特征不足以对像素进行精确的分割。这给解码器逐步修复物体的细节造成了困难,使得在解码器中直接由上采样/反卷积层生成的分割图像较为粗糙。

√解决:因此,一些研究人员提出在编码器和解码器之间建立快捷连接(shortcut/skip connection),使高分辨率的特征信息参与到后续的解码环节,进而帮助解码器更好地复原目标的细节信息。

列举出2~3个基于编码器-解码器结构的图像分割算法。

经典的图像分割算法 FCN (Fully Convolutional Networks) [26]、U-Net[27]和SegNet[28]都是基于编码器-解码器的理念设计的。

FCN和U-Net是最先出现的编码器-解码器结构,都利用了快捷连接向解码器中引入编码器提取的特征。

- FCN中的快捷连接是通过将编码器提取的特征进行复制,叠加到之后的卷积层提取出的特征上,作为解码器的输入来实现的。

- 与FCN不同,SegNet提出了最大池化索引(max-pooling indicies)的概念,快捷连接传递的不是特征本身,而是最大池化时所使用的索引(位置坐标)。利用这个索引对输入特征进行上采样,省去了反卷积操作,这也使得SegNet比FCN节省了不少存储空间。

[22] KIRILLOV A, HE K, GIRSHICK R, et al. Panoptic segmentation[J].arXiv preprint arXiv:1801.00868, 2018.

[23] EVERINGHAM M, WINN J. The PASCAL visual object classes challenge 2012(VOC2012) development kit[J]. Pattern Analysis, Statistical Modelling and Computational Learning, Tech. Rep, 2011.

[24] LIN T-Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: Common objects incontext[C]//European Conference on Computer Vision. Springer, 2014: 740-755.

[25] CORDTS M, OMRAN M, RAMOS S, et al. The cityscapes dataset for semantic urban scene understanding[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 3213-3223.

[26] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015.

[27] RONNEBERGER, OLAF, FISCHER P, BROX T. U-Net: Convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention, 2015:234-241.

[28] BADRINARAYANAN V, KENDALL Alex, CIPOLLA R. SegNet: A deep convolutional encoder-decoder architecture for image segmentation[J].IEEE Transactionson Pattern Analysis and Machine Intelligence,2017.

参考文献:

《百面深度学习》 诸葛越 江云胜主编

出版社:人民邮电出版社(北京)

ISBN:978-7-115-53097-4

2020年7月第1版(2020年7月北京第二次印刷)

推荐阅读:

//好用小工具↓

// 深度学习经典网络↓

1593

1593

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?