本篇主要介绍DenseNet,其他ResNet系列及其变体介绍见如下blog目录 :

DenseNet

Residual networks behave like ensembles of relatively shallow networks指出在ResNet训练过程中,梯度的主要来源是shortcut分支。 DenseNet针对ResNet中的shorcut进行改进。既然shortcut有效,多加点!

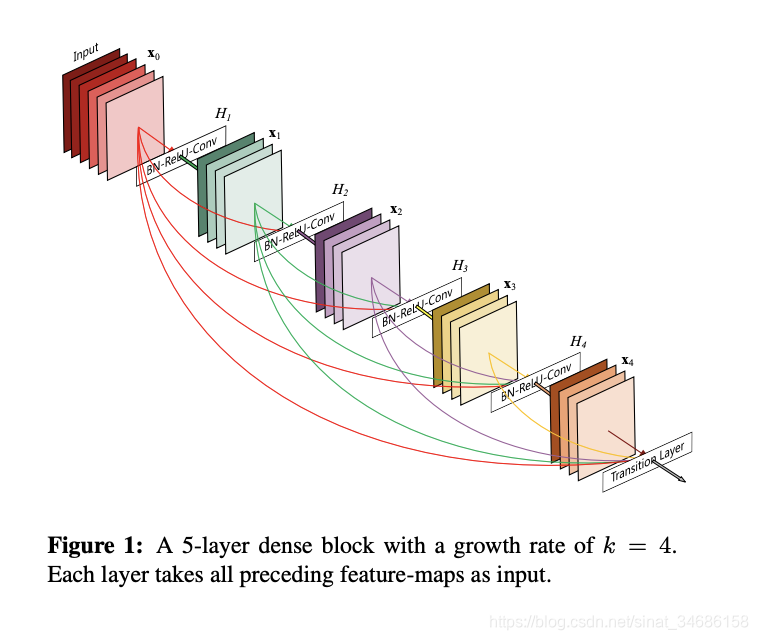

DenseNet 的核心思想:对每一层都加一个单独的 shortcut,使得任意两层之间都可以直接相连。

- DenseBlock是包含很多层的模块,每个层的特征图大小相同,层与层之间采用密集连接方式。

- Transition模块是连接两个相邻的DenseBlock,并且通过Pooling使特征图大小降低。BN+ReLU+1x1 Conv+2x2 AvgPooling

本文深入探讨DenseNet,一种改进自ResNet的深度学习模型。DenseNet通过密集连接每个层,使得任意两层间直接相连,增强了梯度反向传播,简化网络训练,减少了vanishing-gradient问题。其特征重用机制降低了参数数量,提高了计算效率。DenseBlock和Transition模块是其关键结构,尽管可能导致较高的GPU内存消耗,但可以通过优化实现高效运行。

本文深入探讨DenseNet,一种改进自ResNet的深度学习模型。DenseNet通过密集连接每个层,使得任意两层间直接相连,增强了梯度反向传播,简化网络训练,减少了vanishing-gradient问题。其特征重用机制降低了参数数量,提高了计算效率。DenseBlock和Transition模块是其关键结构,尽管可能导致较高的GPU内存消耗,但可以通过优化实现高效运行。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?