本文总结了ICML 2023 有关时间序列预测(Time Series Forecasting,TSF)和时空预测(spatial-temporal forecasting,STF)的文章,包含时序预测,可解释性,扩散模型,不确定性量化等工作。

相关链接中,我也总结了机器学习三大会以及数据挖掘顶会中时序和时空相关的文章,感兴趣的读者也可以参考学习。

如果对您有用,还请您点赞,收藏和转发。感谢您的支持。

欢迎关注公众号“时空探索之旅”

时间序列(time series)

1. Learning Deep Time-index Models for Time Series Forecasting

论文链接:https://icml.cc/virtual/2023/poster/24424

**代码:**https://github.com/salesforce/DeepTime

作者:Gerald Woo · Chenghao Liu · Doyen Sahoo · Akshat Kumar · Steven Hoi

关键词:时间序列预测

**摘要:**深度学习已被积极应用于时间序列预测,从而催生了大量属于历史价值模型类别的新方法。 然而,尽管时间指数模型具有吸引人的特性,例如能够对基础时间序列动态的连续性进行建模,但人们却很少关注它们。 事实上,虽然朴素的深度时间指数模型比经典时间指数模型的手动预定义函数表示更具表现力,但它们不足以进行预测,由于缺乏归纳偏差,无法泛化到看不见的时间步长。 在本文中,提出了 DeepTime,这是一种元优化框架,用于学习深度时间索引模型,克服了这些限制,从而产生了高效且准确的预测模型。 在长序列时间序列预测设置中对现实世界数据集进行的大量实验表明,DeepTime通过最先进的方法取得了有竞争力的结果,并且非常高效。

2. Self-Interpretable Time Series Prediction with Counterfactual Explanations(oral)

论文链接:https://icml.cc/virtual/2023/poster/23975

**代码:**https://github.com/Wang-ML-Lab/self-interpretable-time-series (删库跑路?)

作者:Jingquan Yan · Hao Wang

关键词:反事实,时间序列预测

**摘要:**可解释的时间序列预测对于医疗保健和自动驾驶等安全关键领域至关重要。 大多数现有方法侧重于通过为时间序列片段分配重要分数来解释预测。 在本文中,采取了一条不同且更具挑战性的路线,旨在开发一种可自我解释的模型,称为反事实时间序列(CountTS),它为时间序列预测生成反事实且可操作的解释。 具体来说,形式化了时间序列反事实解释问题,建立了相关的评估协议,并提出了一种具有时间序列溯因、行动和预测的反事实推理能力的变分贝叶斯深度学习模型。 与最先进的基线相比,自解释模型可以生成更好的反事实解释,同时保持可比较的预测准确性。

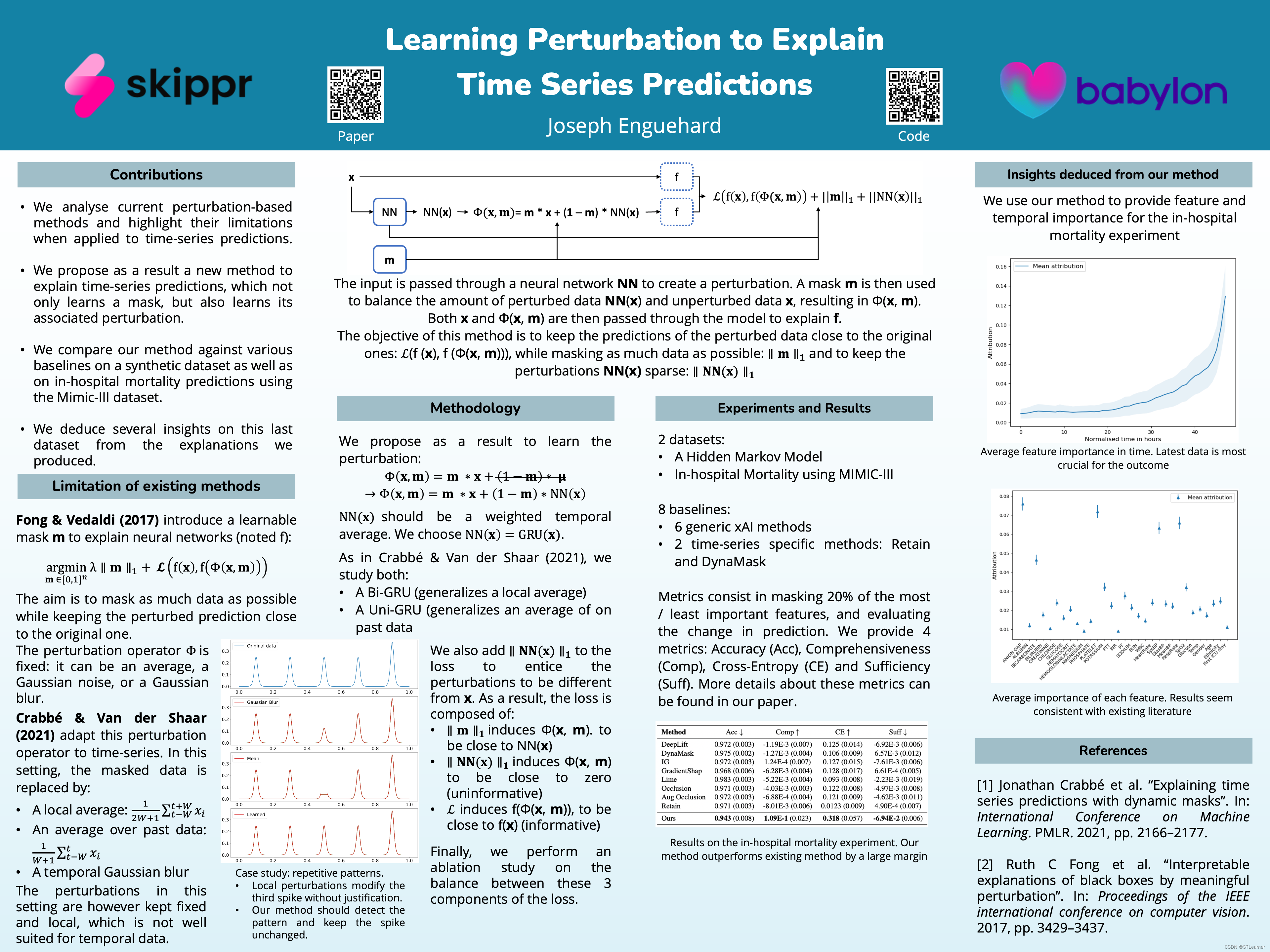

3. Learning Perturbations to Explain Time Series Predictions

论文链接:https://icml.cc/virtual/2023/poster/24182

作者:Joseph Enguehard(独立一个作者太牛了!)

关键词:可解释性,时间序列预测

**摘要:**基于多元时间序列数据解释预测不仅需要处理多个特征,而且还需要处理时间依赖性。 不仅发生了什么很重要,而且何时发生也很重要,并且根据时间信息,相同的特征可能会对预测产生非常不同的影响。 之前的工作使用基于扰动的显着性方法来解决这个问题,使用可训练的掩码扰乱输入,以发现哪些特征在哪些时间驱动预测。 然而,这些方法引入了固定的扰动,其灵感来自于静态数据上的类似方法,而似乎没有动力在时态数据上这样做。 在这项工作中,目标不仅是通过学习掩码,还通过学习相关的扰动来解释预测。 实验表明,学习这些扰动可以显着提高对时间序列数据的解释的质量。

4. Theoretical Guarantees of Learning Ensembling Strategies with Applications to Time Series Forecasting

论文链接:https://icml.cc/virtual/2023/poster/23862

作者:Alex Reneau · Jerry Yao-Chieh Hu · Ammar Gilani · Han Liu

关键词:特征工程,多元时间序列预测

**摘要:**引入了用于时间序列建模的可编程特征工程的概念,并提出了特征编程框架。 该框架为嘈杂的多元时间序列生成大量预测特征,同时允许用户以最小的努力合并他们的归纳偏差。 框架的关键动机是将任何多元时间序列视为细粒度轨迹增量的累积和,每个增量都由新颖的自旋气体动力学 伊辛(Ising) 模型控制。 这种细粒度的视角促进了一组简约算子的开发,这些算子以抽象的方式总结多元时间序列,作为大规模自动化特征工程的基础。 在数值上,验证了方法在几个合成的和现实世界的噪声时间序列数据集上的有效性。

4. Theoretical Guarantees of Learning Ensembling Strategies with Applications to Time Series Forecasting

论文链接:https://icml.cc/virtual/2023/poster/24910

作者:Hilaf Hasson · Danielle Robinson · Yuyang Wang · Gaurav Gupta · Youngsuk Park

关键词:集成学习,时间序列预测

**摘要:**集成是机器学习 (ML) 中最流行的工具之一,因为它可以有效地最小化方差,从而提高泛化能力。 大多数黑盒基学习器的集成方法都属于“堆叠泛化”的范畴,即训练将基学习器的推论作为输入的 ML 算法。 虽然堆叠已在实践中广泛应用,但其理论特性却知之甚少。 在本文中,证明了一个新颖的结果,表明基于交叉验证性能从(有限或有限维)堆叠泛化系列中选择最佳堆叠泛化的性能并不比预言机最佳性能“差很多”。 结果加强并显着扩展了 Van der Laan 等人的结果。 (2007)。 受理论分析的启发,进一步在概率预测的背景下提出了一系列特定的堆叠概括,每个概括对于允许集合权重在项目、预测范围内的时间戳和分位数之间变化的程度具有不同的敏感性。 实验结果证明了所提出方法的性能增益。

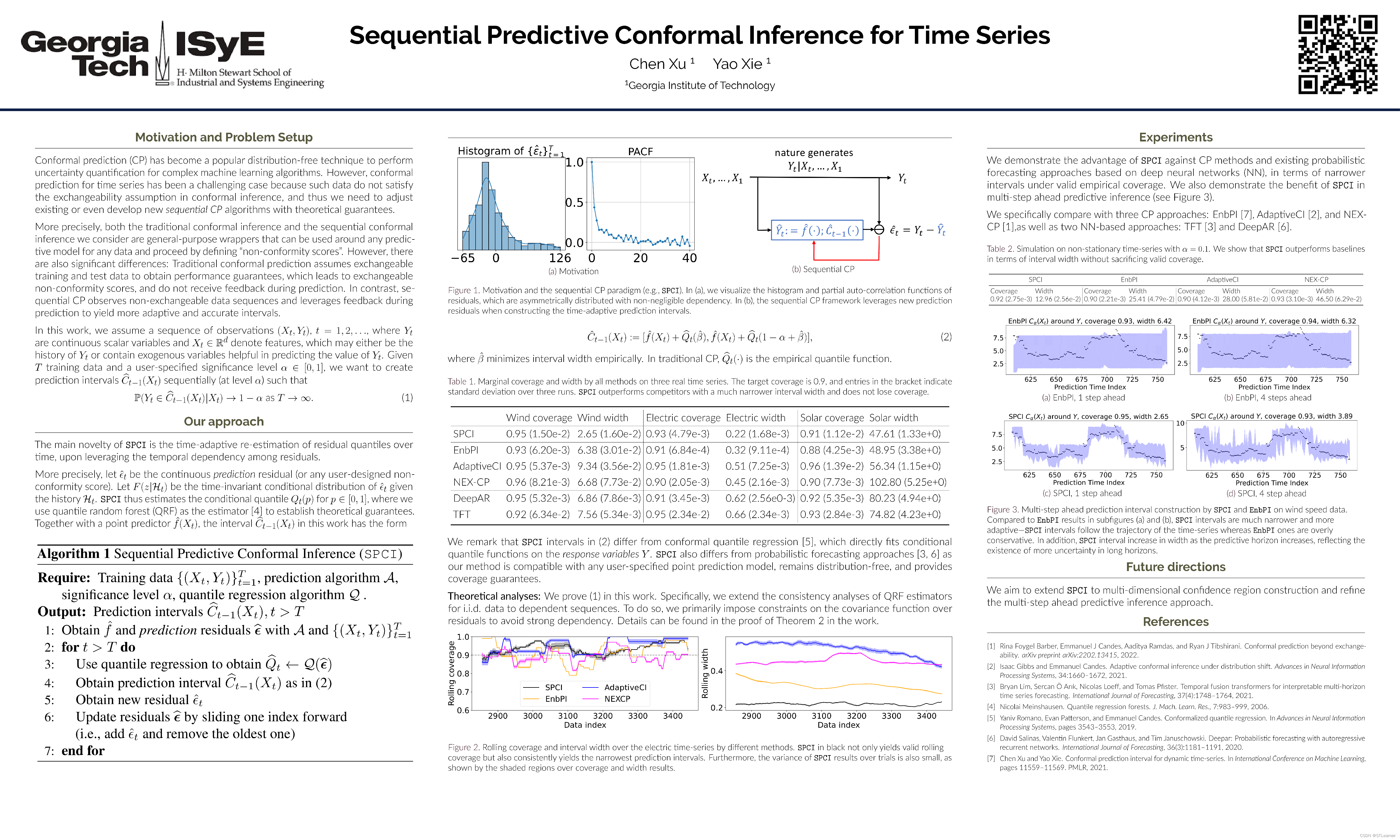

5. Sequential Predictive Conformal Inference for Time Series

论文链接:https://icml.cc/virtual/2023/poster/24627

作者:Chen Xu · Yao Xie

关键词:共形预测,不确定性

**摘要:**提出了一种用于序列数据(例如时间序列)的新的无分布共形预测算法,称为序列预测共形推理(SPCI)。 我们特别考虑了时间序列数据不可交换的性质,因此许多现有的共形预测算法不适用。 主要思想是利用不合格分数(例如,预测残差)之间的时间依赖性,自适应地重新估计它们的条件分位数。 更准确地说,本文将共形预测区间问题转化为在给定用户指定的点预测算法的情况下预测未来残差的分位数。 理论上,我们通过在分位数回归中扩展一致性分析来建立渐近有效条件覆盖。 通过模拟和真实数据实验,证明了在所需的经验覆盖范围内,与其他现有方法相比,SPCI 的区间宽度显着减小。

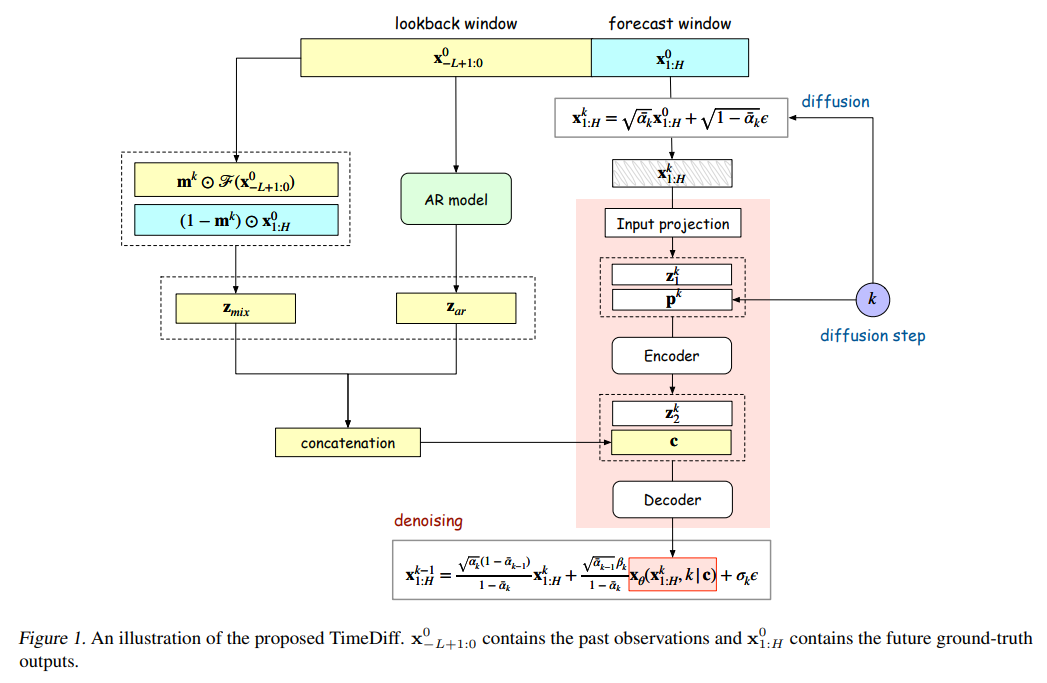

6. Non-autoregressive Conditional Diffusion Models for Time Series Prediction

论文链接:https://icml.cc/virtual/2023/poster/25084

作者:Lifeng Shen · James Kwok

关键词:扩散模型,时间序列预测

**摘要:**最近,去噪扩散模型在图像、音频和文本的生成方面取得了重大突破。 然而,如何将其强大的建模能力应用于时间序列建模仍然是一个悬而未决的问题。 在本文中,提出了 TimeDiff,这是一种非自回归扩散模型,通过引入两种新颖的条件机制(未来混合和自回归初始化)来实现高质量的时间序列预测。 与教师强制类似,未来混合允许对未来的部分真实预测进行调节,而自回归初始化有助于更好地使用基本时间序列模式(例如短期趋势)初始化模型。 在九个真实世界的数据集上进行了广泛的实验。 结果表明,TimeDiff 始终优于现有的时间序列扩散模型,并且在各种现有的强基线(包括 Transformer 和 FiLM)中也实现了最佳整体性能。

时空预测

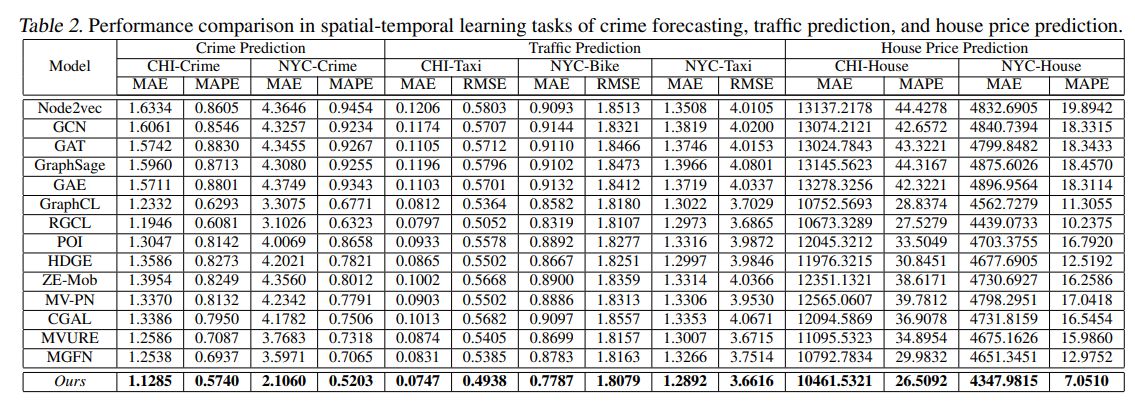

7. Spatial-Temporal Graph Learning with Adversarial Contrastive Adaptation

论文链接:https://icml.cc/virtual/2023/poster/24346

**代码:**https://github.com/HKUDS/GraphST

作者:Qianru Zhang · Chao Huang · Lianghao Xia · Zheng Wang · Siu Ming Yiu · Ruihua Han

关键词:时空图预测、对比学习

**摘要:**时空图学习已成为最先进的解决方案,用于在学习各种城市感知任务(例如犯罪预测、交通流量预测)的区域表示中对结构化时空数据进行建模。 然而,由于不艺术的图结构信息聚合模式,大多数现有模型容易受到生成区域图质量的影响。 现实生活场景中普遍存在的时空数据噪声和不完整性给生成高质量的区域表示带来了困难。 本文提出了一种时空对抗图对比学习模型(STAG)来应对自适应自监督图增强的这一挑战。 具体来说,提出了一种可学习的对比学习函数,该函数能够自动蒸馏重要的多视图自监督信号,以实现自适应时空图增强。 为了增强表征辨别能力和鲁棒性,设计的对抗性对比学习机制使STAG能够自适应地识别硬样本,以实现更好的自我监督。 最后,引入跨视图对比学习范式来建模跨视图特定区域表示的相互依赖关系并保留潜在的关系异质性。在多个基准数据集上验证了STAG 方法在各种时空预测任务中的优越性。

相关链接

ICLR 2024 时间序列(Time Series)高分论文

欢迎关注公众号“时空探索之旅”

905

905

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?