初中数学之平方根(2)导学案

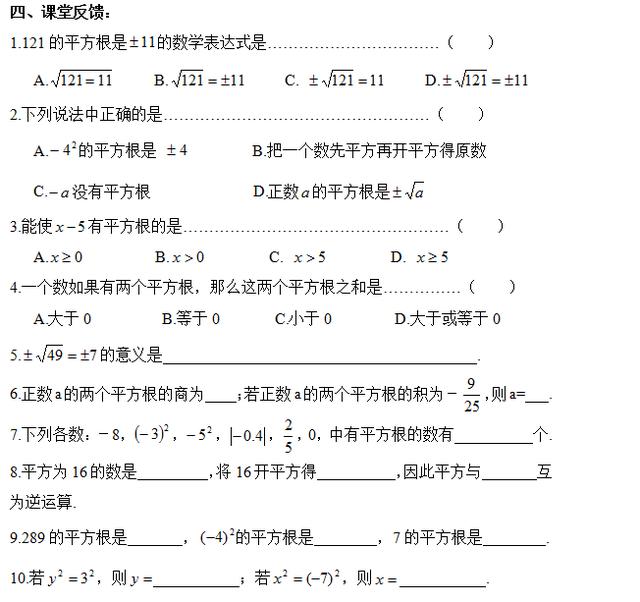

学习目标:

1.了解平方根的概念,会用根号表示数的平方根.

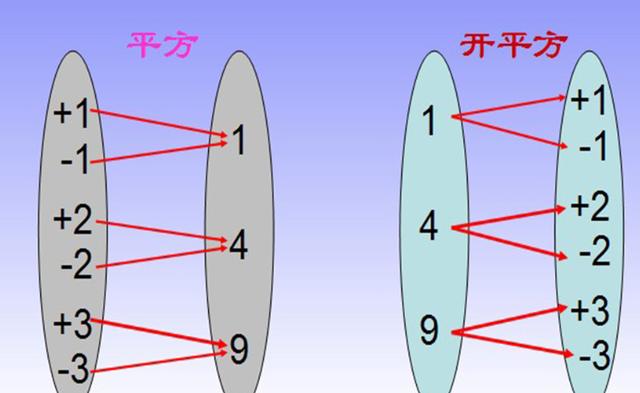

2.了解开平方与平方互为逆运算,会用平方根的概念求某些非负数的平方根.

学习重点:

了解开方与乘方互为逆运算,能熟练地用平方根求某些非负数的平方根.

学习难点:

平方根的意义.

自主学习

一、复习巩固:

1.填空:5的平方是 ; eq f(3,4)的平方是 ;0的平方是 ;

(-3)2= ;(- eq f(3,5))2= .

总结:观察上述结果,发现:任意有理数的平方是 数.

2.我们知道:4的平方是16, 的平方也是16,所以 的平方是16.

类似的: 的平方是25; 的平方是121; 的平方是 eq f(25,49);

的平方是1 eq f(7,9); 的平方是0; 的平方是-4.

3.算术平方根的概念:

二、新知讲解:

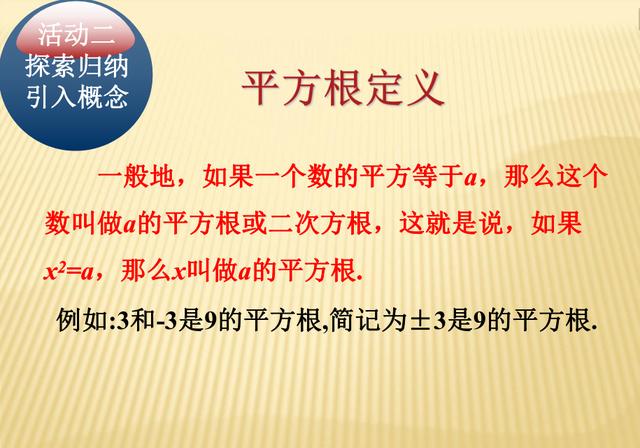

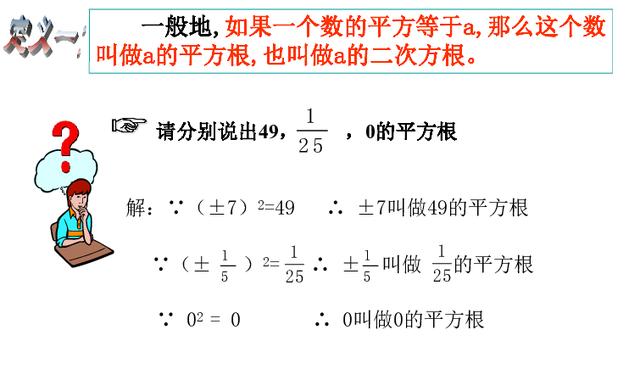

一般在,如果一个数x的平方等于a,那么这个数叫做a的平方根,也称为二次方根.也就是说,如果 ,那么x就叫做a的 .记作 .

初步感悟:

① 因为

= , = ,所以 ±5是 的平方根 .

② 平方得81的数是 ,因此81的平方根是 .

③ 9的平方根是 ;

的正的平方根是 ;1.44的负的平方根是 .

讨论提高:

① 4有 个平方根,它们互为 数,记作 .

② 0有 个平方根,0的平方根是 .

③ -4、-8、-36有平方根吗?为什么?

总结:一个数的平方根有几个?

三、例题研讨:

例3 求下列各数的平方根:

(1)64; (2)

; (3)0.0004; (4); (5)11

213

213

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?