论文名称: Taming Transformers for High-Resolution Image Synthesis

发表时间:CVPR2021

作者及组织: Patrick Esser*, Robin Rombach*, Bjorn Ommer, 来自Heidelberg Collaboratory for Image Processing, IWR, Heidelberg University, Germany。

前言

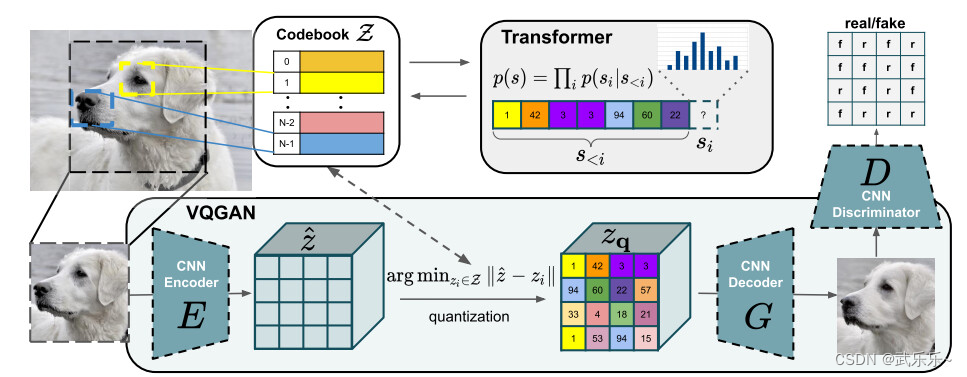

本文类似VQVAE,区别在于引入了GAN的思想来强制codebook学到更逼真的图像成分表示,另外,自回归模型替换成了长序建模更强的Transformer来替代PixelCNN。(在codebook上进行自回归是因为Transformer计算代价大)。

1、方法

1.1.codebook学习

这块类似VQVAE,损失函数类似:

其中 表示Decoder的生成图,

1.2.+GAN

,来判断每块特征图

其中 是原始图像,

是Decoder生成图。 另外,VQGAN使用了

1.3.自回归

在codebook训练完成后,将其置为推理阶段,然后推理图像并根据codebook得到gt索引,并用Transformer来自回归预测下一个索引。自回归损失用 一个交叉熵即可:

1.4.生成

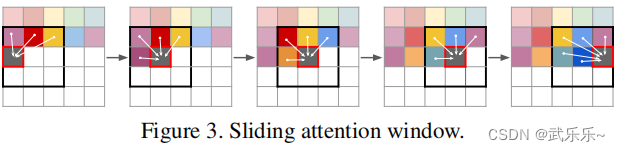

便能生成图像。但若想生成百万像素还是有困难,因此,作者采用了一个滑动窗口生成策略:

借助Transformer只能看见以前的信息的性质,便能分块生成大图。

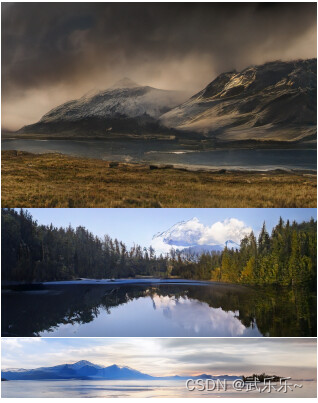

2、效果

思考

针对不同训练任务需要训练不同的codebook+自回归,比较麻烦。

189

189

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?