摘要

本文提出了一种新的针对图像语义分割的知识蒸馏方法,称为类内和类间知识蒸馏(I2CKD)。该方法的重点是在教师(繁琐模型)和学生(紧凑模型)的中间层之间捕获和传递知识。对于知识提取,我们利用从特征图派生的类原型。为了促进知识转移,我们**采用了三重损失来最小化类内的差异,最大化教师和学生原型之间的类间差异。**因此,I2CKD使学生能够更好地模仿每个类的教师的特征表示,从而提高紧凑网络的分割性能。

介绍

一般来说,教师和学生之间的知识质量是使用均方误差(MSE)等几个指标以密集的两两方式计算的,而不考虑类内和类间的特征关系。

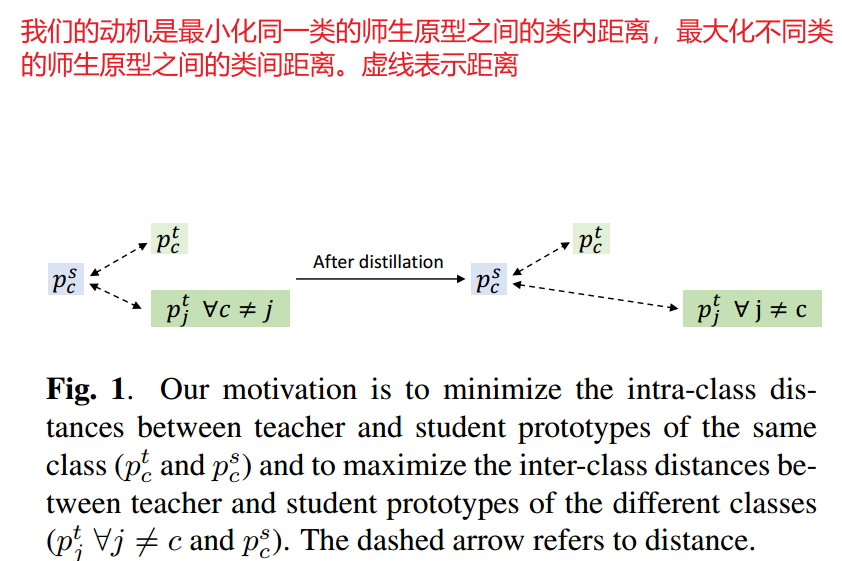

在本文中,我们提出了一种针对语义分割的新型知识蒸馏方法,称为类内和类间知识蒸馏(I2CKD)。首先,我们使用特征映射和ground truth(mask)计算每个类的教师原型(质心)。我们工作背后的假设是,教师的良好表现得益于他们合适的制作原型。因此,我们建议将这些知识传授给学生。为此,正如方法的名称所暗示的那样,我们通过最小化/最大化他们之间的类内和类间距离来强迫每个类的学生原型模仿老师原型(见图1)。作为这种约束的一种复杂损失,我们利用了三重损失。

相关工作

面向语义分割的知识蒸馏

[9]中,提取率0阶和1阶两类知识。0阶计算像素类概率之间的差。1阶考虑中心像素与其8个领域之间的差异。[12]专注于匹配教师和学生的特征图大小,并提出应用自编码器。然后,计算两两关联图来量化教师和学生知识之间的关系。[10]提出了一个结构化蒸馏(SKD)方案,该方案考虑了使用图的特征图之间的中间蒸馏。分数图之间的像素蒸馏以及通过对抗学习的整体蒸馏。Wang等开发了一种名为Intra-class Feature Variation Distillation(IFVD)的新方法,学习学生模仿教师的Intra-class关系。为了传递IFV知识,使用了余弦距离。Shu等人开发了一种称为通道知识蒸馏(CWD)的方法,该方法的通道维度计算教师和学生激活通道映射的softmax之间的KLD。在我们之前的工作中,我们利用教师特征图之间的相互依赖性作为知识蒸馏。这些知识使用自注意机制捕获,并使用MSE转移。

在获得满意的性能的同时,这些方法忽略了特征图(原型)中每个类的有意义的知识。这些知识可以有效地用于测量教师和学生网络之间的类内和类间相似性。这就是我们方法I2CKD的目的。

方法

总体

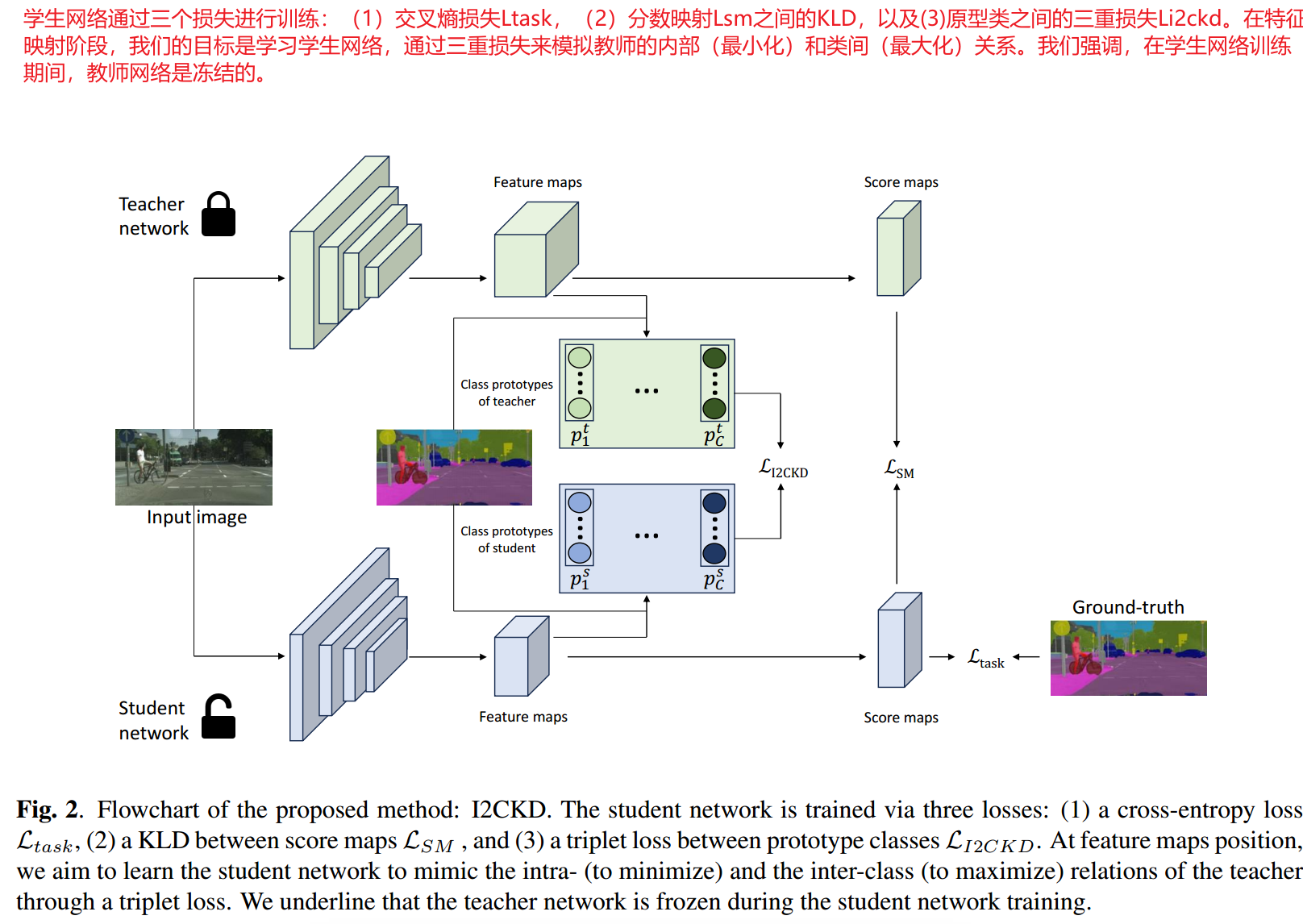

如图2所示,我们的方法I2CKD将知识从训练有素的教师网络中提炼出来,传递给学生。对于学生网络的每个训练阶段。我们都冻结了教师网络。学生网络通过三个损失来更新其权重,分别捕获得分图和特征图级别的学生/ground truth差异和教师/学生差异。贡献的核心在于特征映射级别,我们建议利用教师和学生之间的类内和类间关系。为此,我们计算了教师和学生类原型之间的三元组损失。

类内和类间的知识蒸馏

类原型计算

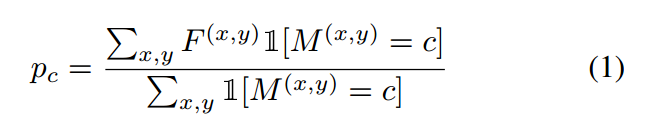

对于给定通道的特征映射 ,类c的原型表示为:

,类c的原型表示为:

其中 表示ground truth(掩码)。

表示ground truth(掩码)。 是一个指示函数,如果参数为真,则等于1,否则等于0。对于教师和学生网络,我们在特征映射上计算所有类的原型。得到矩阵大小为

是一个指示函数,如果参数为真,则等于1,否则等于0。对于教师和学生网络,我们在特征映射上计算所有类的原型。得到矩阵大小为 ,其中C和K分别表示类和通道的数量。

,其中C和K分别表示类和通道的数量。

三重损失

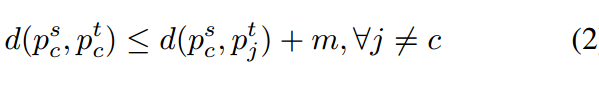

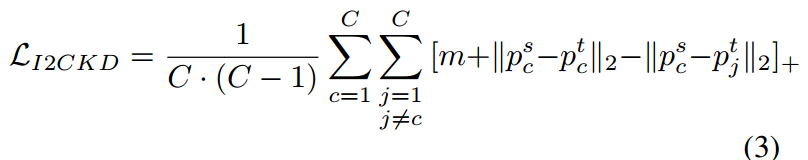

我们蒸馏方案的最终目标是最小化类内的差异,最大化教师和学生网络之间的类间差异。具体来说,我们的目标是执行以下约束:

这里d(*)是一个距离函数,m代表一个恒定的边界。 是从教师和学生网络中提取出的类原型。

是从教师和学生网络中提取出的类原型。 表示与C不同的类的原型,m是给定的余量。

表示与C不同的类的原型,m是给定的余量。

这一约束的执行允许将学生和教师类原型之间的损失表述如下:

表示函数

表示函数 ,

, 为

为 范数,

范数,

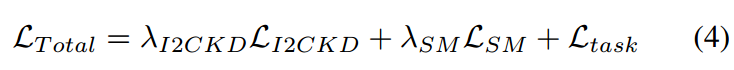

学生训练的总损失

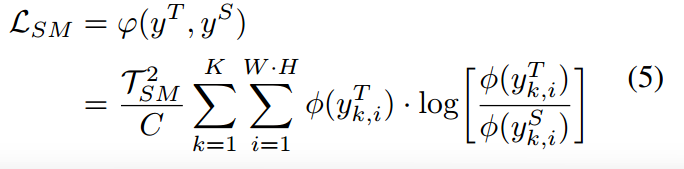

语义切分的总体学生训练损失如下:

是平衡所考虑的损失的超参数。

是平衡所考虑的损失的超参数。

是教师分数图

是教师分数图 与学生分数图

与学生分数图 之间的KLD。

之间的KLD。

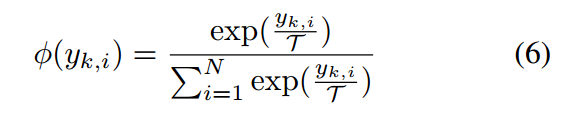

是softmax函数

是softmax函数

是ground truth与分割后的图像之间的损失,在我们的工作中,我们使用交叉熵损失。

是ground truth与分割后的图像之间的损失,在我们的工作中,我们使用交叉熵损失。

3501

3501

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?