CVPR'2023

code:

Abstract

由于人脸处理技术带来的严重安全问题,人脸伪造检测变得越来越重要。当训练和测试的人脸伪造物来自同一域时,近年来在深度伪造检测方面的研究取得了可喜的结果。然而,当人们试图将检测器推广到训练期间由看不见的方法产生的伪造时,问题仍然具有挑战性。观察到面部操作可能改变不同面部动作单元之间的关系,我们提出了动作单元关系学习框架来提高伪造检测的通用性。具体来说,它由动作单元关系transformer(ART)和篡改AU预测(TAP)组成。该方法构建了与非识别分支和特定分支的不同识别分支之间的关系,它们相互补充,共同利用伪造线索。在篡改AU预测中,我们在图像级别篡改AU相关区域,并在特征级别开发具有挑战性的伪样本。然后对模型进行训练,用生成的位置特定监督来预测被篡改的AU区域。实验结果表明,我们的方法在数据集内和跨数据集评估中都能达到最先进的性能。

1. Introduction

生成对抗网络(generative Adversarial Networks, GAN)[21]等生成模型的成功迅速提高了人脸伪造的质量,这促使研究人员追求对立的反检测方法,以应对潜在的社会安全问题。虽然最近的研究已经证明了它们在识别训练中使用的已知伪造方法中的伪造图像方面的有效性[4,10,29,39,43],但无法保证对未知伪造方法的泛化[9,17,27,52]。

最近的一些研究[6,31,45,49,50,55]已经注意到了这个迫在眉睫的问题,并试图捕捉更多的内在伪造线索,以提高识别方法的通用性。具体来说,这些工作大致可以分为两个分支:1)数据修改,即使用精心挑选的增强图像[50]或仅使用真实图像手动生成伪造图像[31,45,55],以扩大训练数据的多样性,同时避免对特定缺陷的过拟合;2)辅助任务集成,即定义亲和损失,帮助模型学习真实人脸和虚假人脸之间的潜在差异[6,55]。尽管他们取得了成功,但人们注意到,在生物学研究中用于理解人类面部特征的面部单元之间的关系很少被探索,这阻碍了模型泛化的进一步提高。

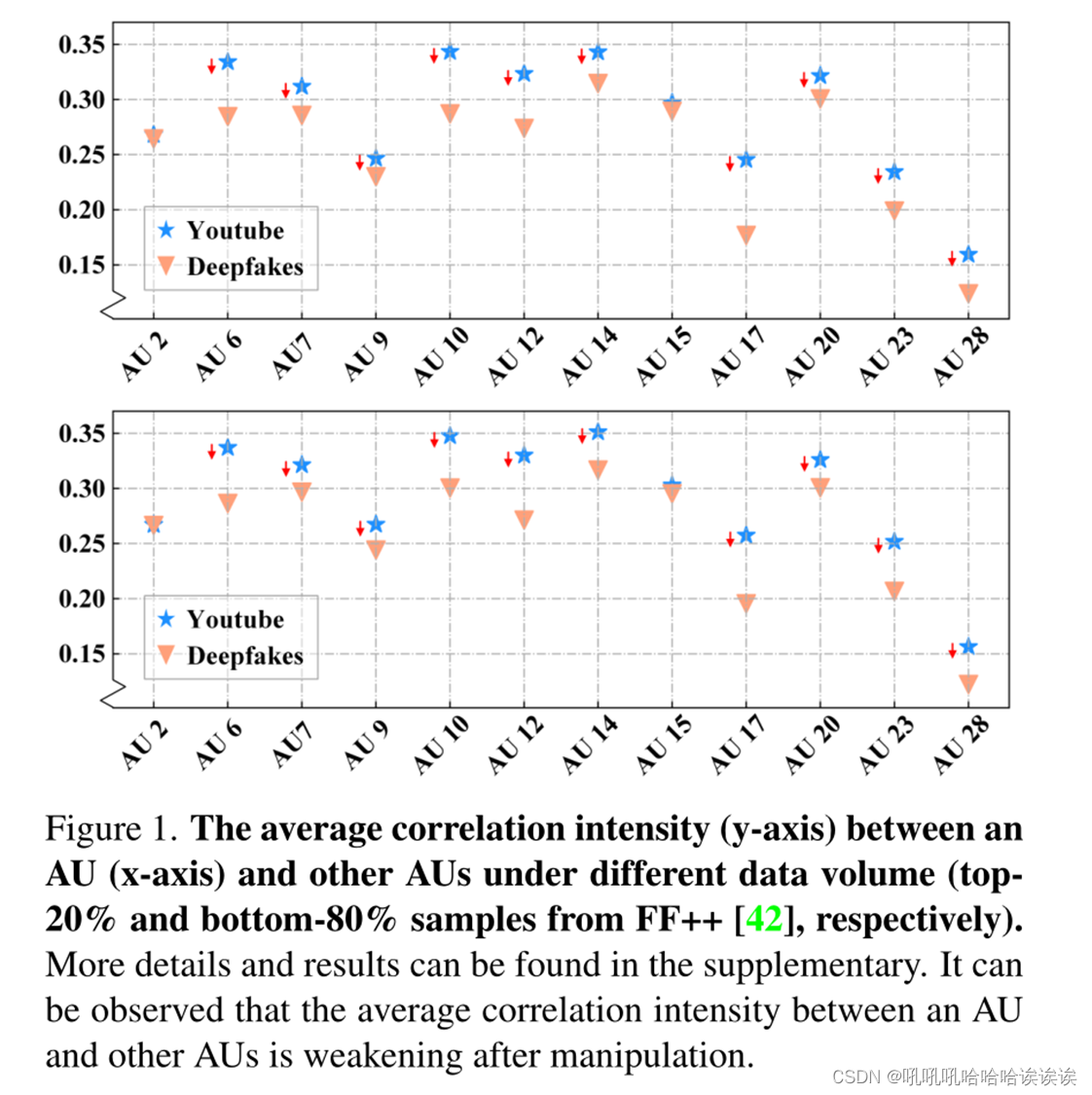

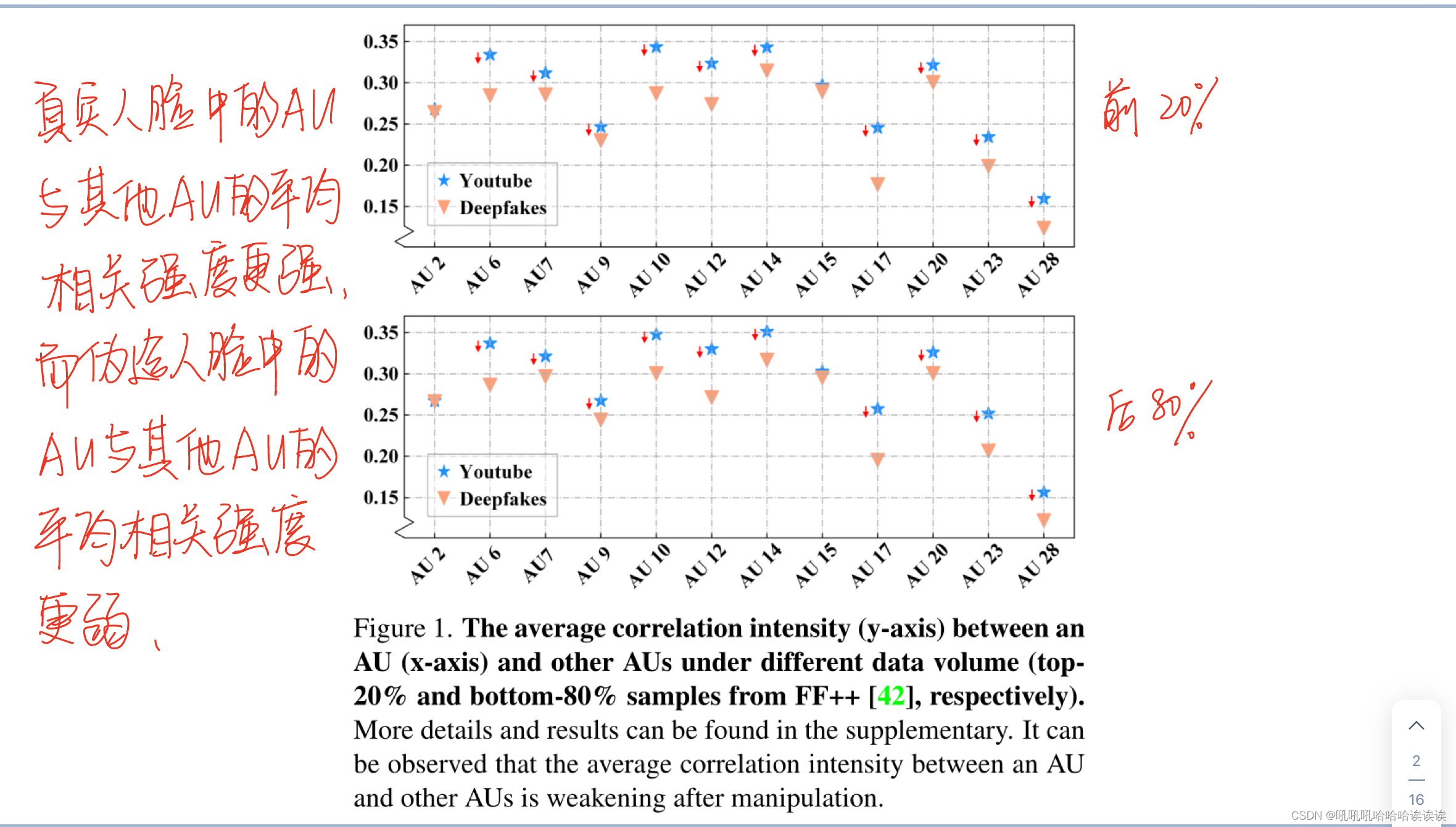

在本工作中,我们的目标是构建一个将数据修改和辅助任务集成方案与面部动作单元的关系线索相结合的人脸伪造检测框架。我们的见解源于面部动作编码系统[18]中的理论,该理论通过一组称为面部动作单元(AU)的面部肌肉运动来表示人脸。更具体地说,在面部形态学中,一块肌肉控制着不同的au。当表现出某种情绪时,一组au会同时被激活,说明au之间存在着潜在的联系。因此,直接的直觉是,在真实的和被操纵的人脸中,au之间的关系可能是不同的,因为事实上的方法使用图形化方法修改整个人脸,或者通过GAN生成单个面部区域。我们在图1中的实验证明了这一假设,图1显示真实人脸中的AU与其他AU(星形)的平均相关强度更强,而伪造人脸中的AU与其他AU(三角形)的平均相关强度更弱。

为了探索这些线索,我们将重点放在与AUs相关的局部区域之间的关系上,并提出了动作单元关系学习框架,以提高伪造检测器的鲁棒性和泛化性。该框架由AU关系转换(ART)和篡改AU预测(TAP)两部分组成。ART明确地学习AUs之间的关系,作为一个双重网络工作。具体来说,它包括一个特定于au的分支,用于学习与au对齐的区域之间的关系,以及一个与au无关的分支,用于学习图像补丁区域之间的关系。AU-specific Branch提取与单个AU对齐的嵌入,并通过注意机制建立它们之间的关系。au不可知论分支是一个标准的Vision-Transformer块[16],用于构建不同图像补丁之间的关系。这两个分支相互补充,用于构建输入人脸图像的详细全局视图。从另一个角度来看,TAP制定了一个辅助任务来增强模型感知局部伪造缺陷的能力。特别地,它通过从面部区域中随机去除au相关区域来构建局部脸mask。利用mask在图像和特征级别修改剩余区域的数据,以生成具有挑战性的假对应。然后在局部篡改监督的帮助下训练模型来预测被操纵的区域。通过这样做,网络对已被操纵的au相关区域更加敏感,这有利于识别伪造图像。值得注意的是,所提出的动作单元关系学习框架吸收了数据修改和辅助任务集成方案的优点。

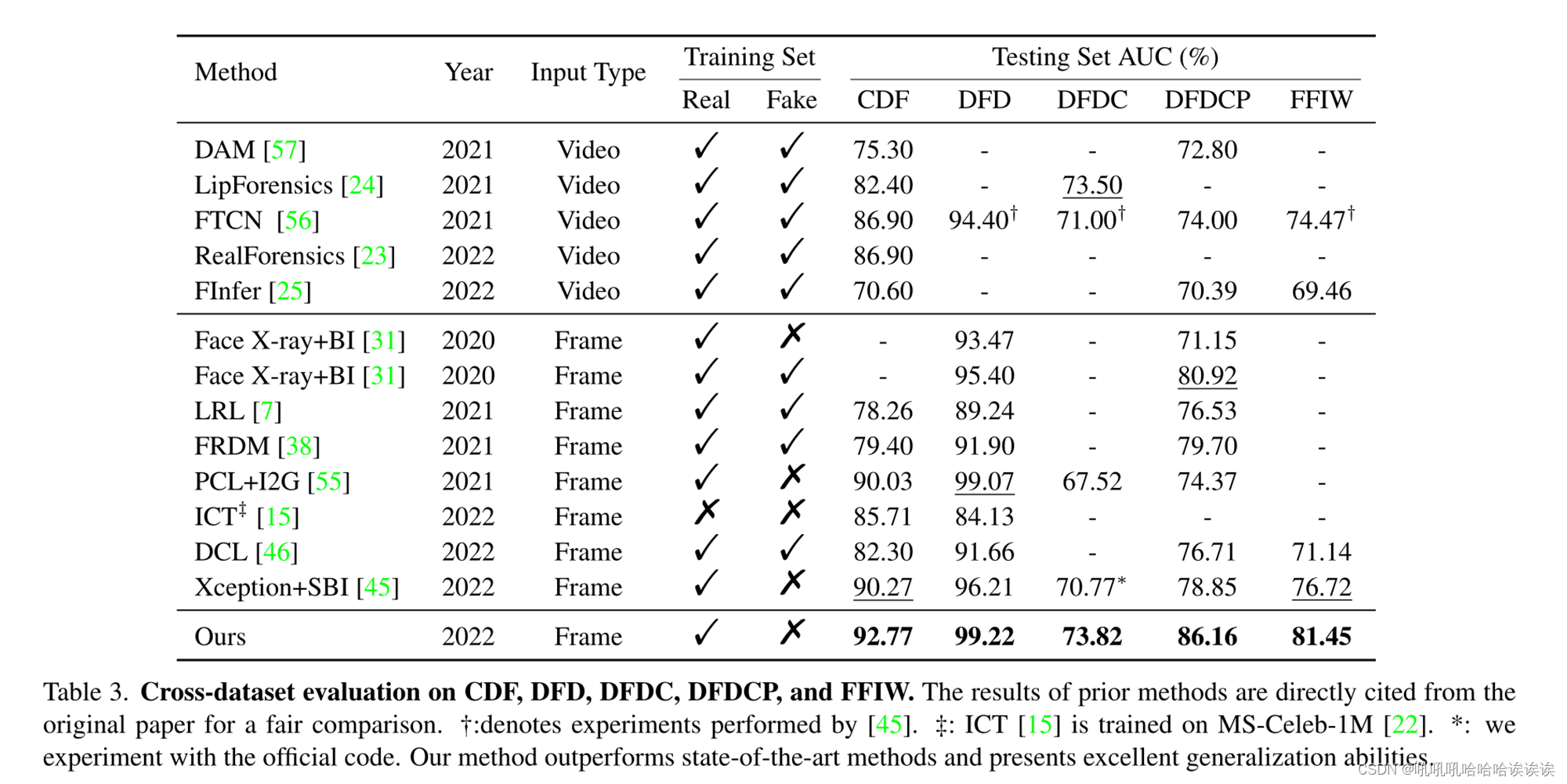

我们根据跨数据集协议和跨操作协议评估我们的框架。在跨数据集评估中,我们的方法与其他最先进的检测器相比表现良好,在CDF[36]、DFD[1]、DFDC[13]、DFDCP[14]和FFIW[57]数据集上的AUC得分分别为92.77%、99.22%、73.82%、86.16%、81.45%。在交叉操作评估中,我们的方法在DF[2]、F2F[48]、FS[3]和NT[47]上的AUC分别达到99.98%、99.60%、99.89%和98.38%。实验结果证明了该框架的有效性和通用性。

我们的贡献可以总结如下:

•我们提出了动作单元关系transformer(ART)来有效地建立不同au相关区域之间的相关性,最终提高伪造检测的性能。

•我们提出了篡改AU预测(TAP)作为辅助任务,以增强模型感知局部伪造区域的能力。

•数据集内和跨数据集评估协议的实验结果证明了我们框架的有效性和泛化性。

2. Related Work

2.1. Conventional Deepfake Detection

人脸伪造检测是计算机视觉领域的一个经典课题。早期的研究集中在手工制作的特征上,例如眨眼[26,34],头部姿势不一致[53]和视觉伪影[5,35]。随着深度学习的快速发展,近年来基于深度神经网络的方法取得了较好的效果。[10,54]应用注意机制来突出被操纵的区域。除了关注空间域外,[20]还注意到隐藏在频域的伪影信息。随后,许多工作[30,37,38,40]利用频率线索作为RGB信息的补充。近年来,由于Transformer[16]出色的表征能力,FTCN-TT[56]、ICT[15]也将Transformer扩展到深度检测任务。虽然上述方法在域内取得了令人满意的结果,但在跨数据集场景下,它们的性能下降相当大。

2.2. General Deepfake Detection

最近的工作集中在一般的人脸伪造检测。FWA[35]关注gan生成的人脸与自然人脸之间的质量差异,并通过在真实图像上模糊人脸区域来再现这种差异。[49]认为缺乏泛化性是对视觉伪影的过度拟合的结果,并提出了一种动态数据增强方案。[50]发现,通过仔细的预处理和后处理以及数据增强,标准图像分类器能够很好地泛化到未见过的数据集。Face X-ray[31]仅使用真实图像生成训练数据,并专注于预测假人脸的混合边界。PCL[55]还从成对的两张原始图像中创建混合人脸,并对生成的数据执行成对的自一致性学习。SBI[45]通过将单幅图像中的伪源图像和伪目标图像混合合成假图像。尽管有很好的改进,但这些方法主要集中在数据处理上,缺乏一个模块来探索一般和内在的面部表征。为此,我们构建了一个在吸收数据修改优点的同时学习AU关系的框架来建模人脸信息。

3. Methods

3.1. Overview

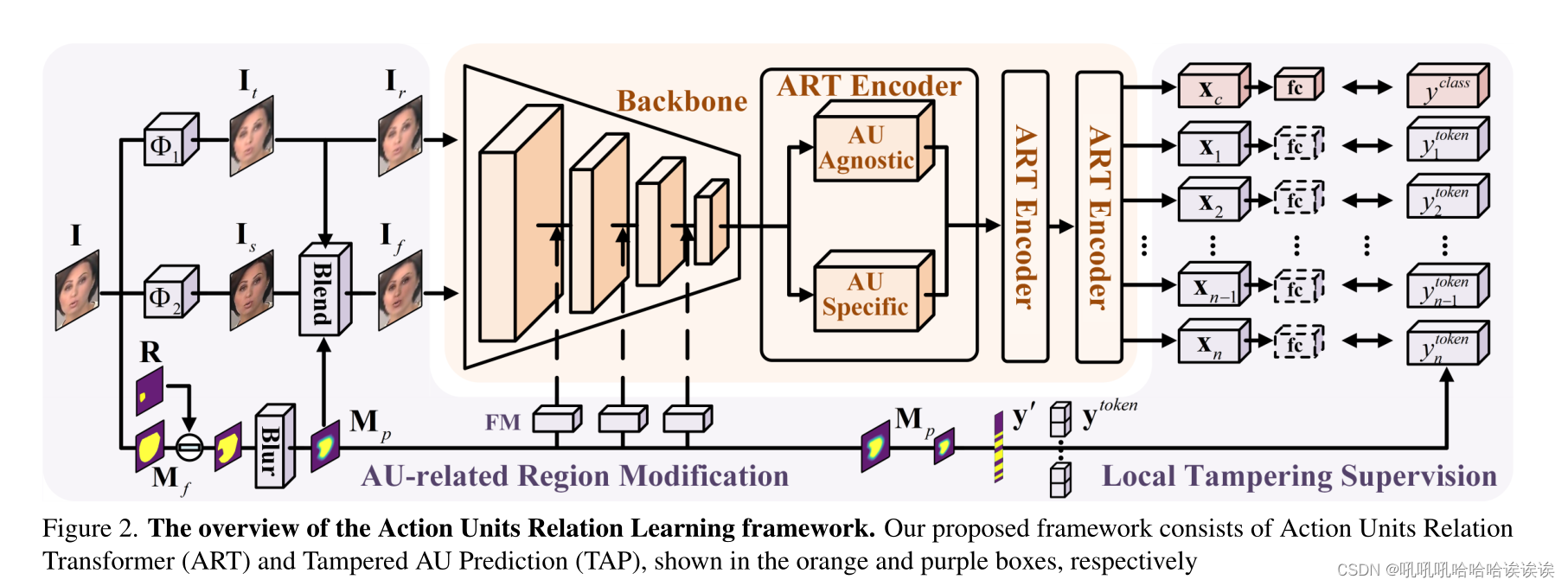

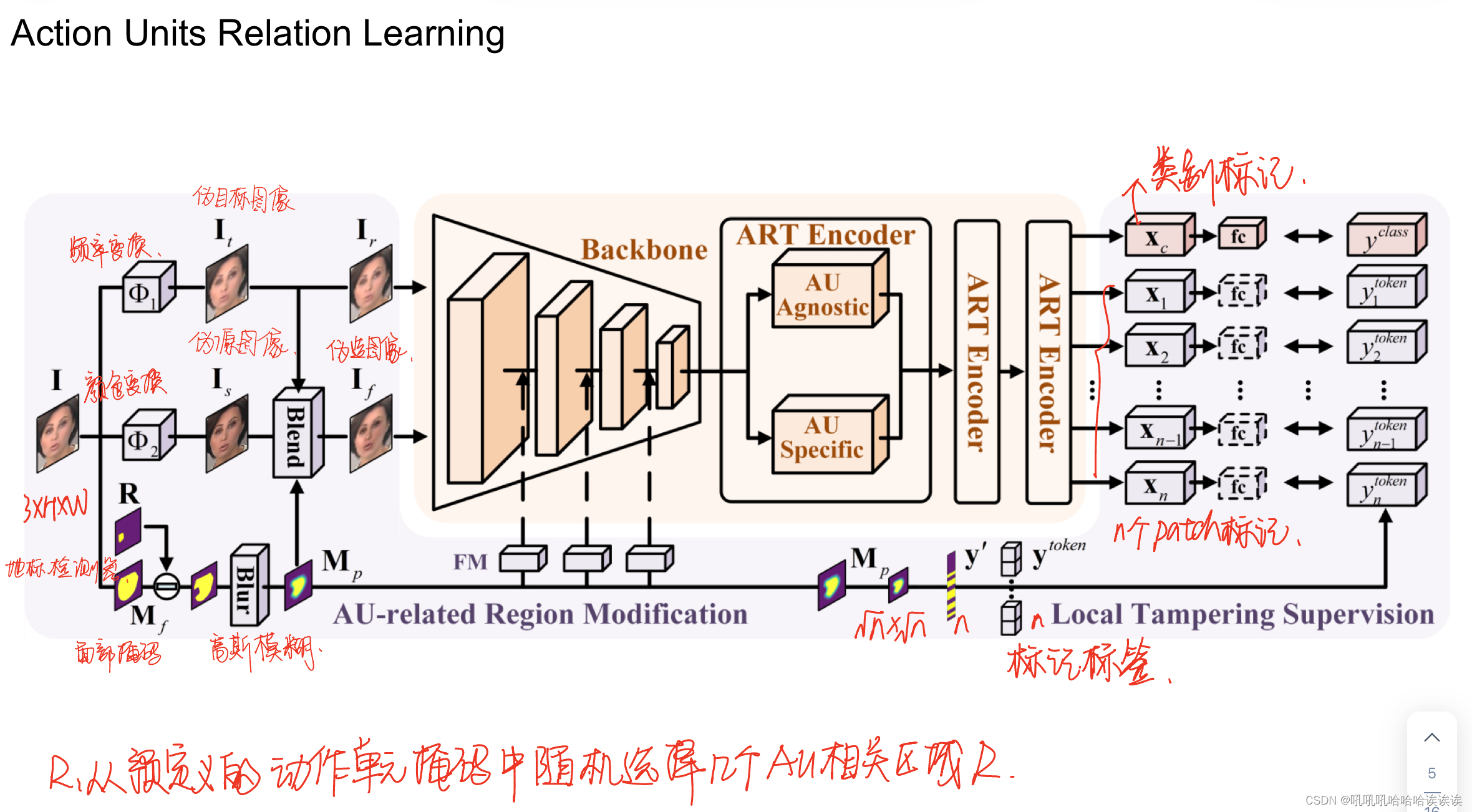

如图2所示,我们提出的动作单元关系学习框架由动作单元关系Transformer(ART)和篡改AU预测(TAP)组成。ART探索了au相关区域之间关系的线索,以提高伪造的识别。TAP对au相关区域进行篡改,并提供局部篡改监督,提高泛化能力。

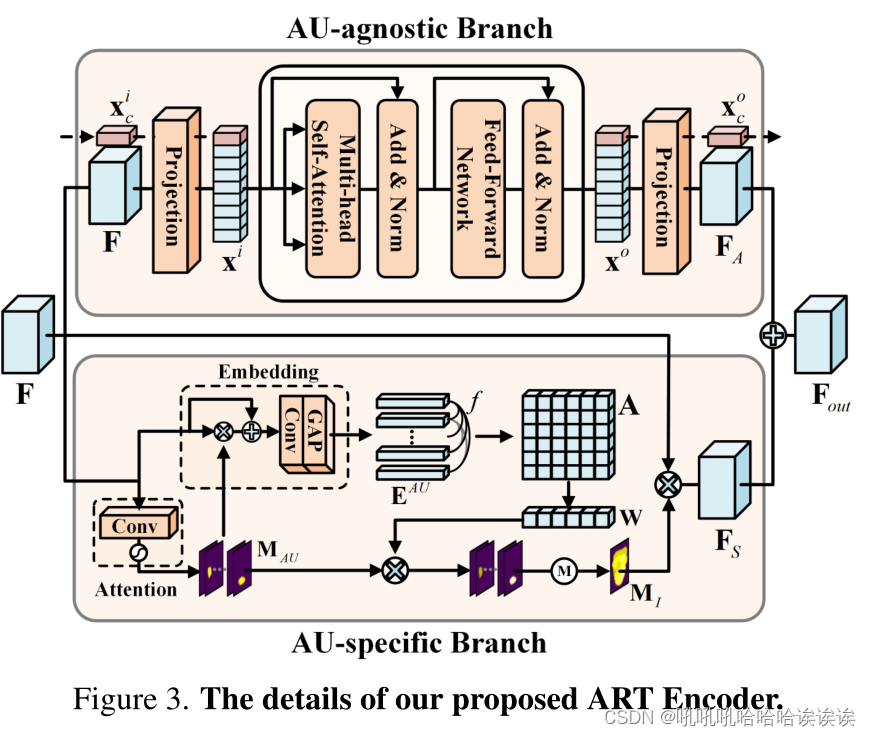

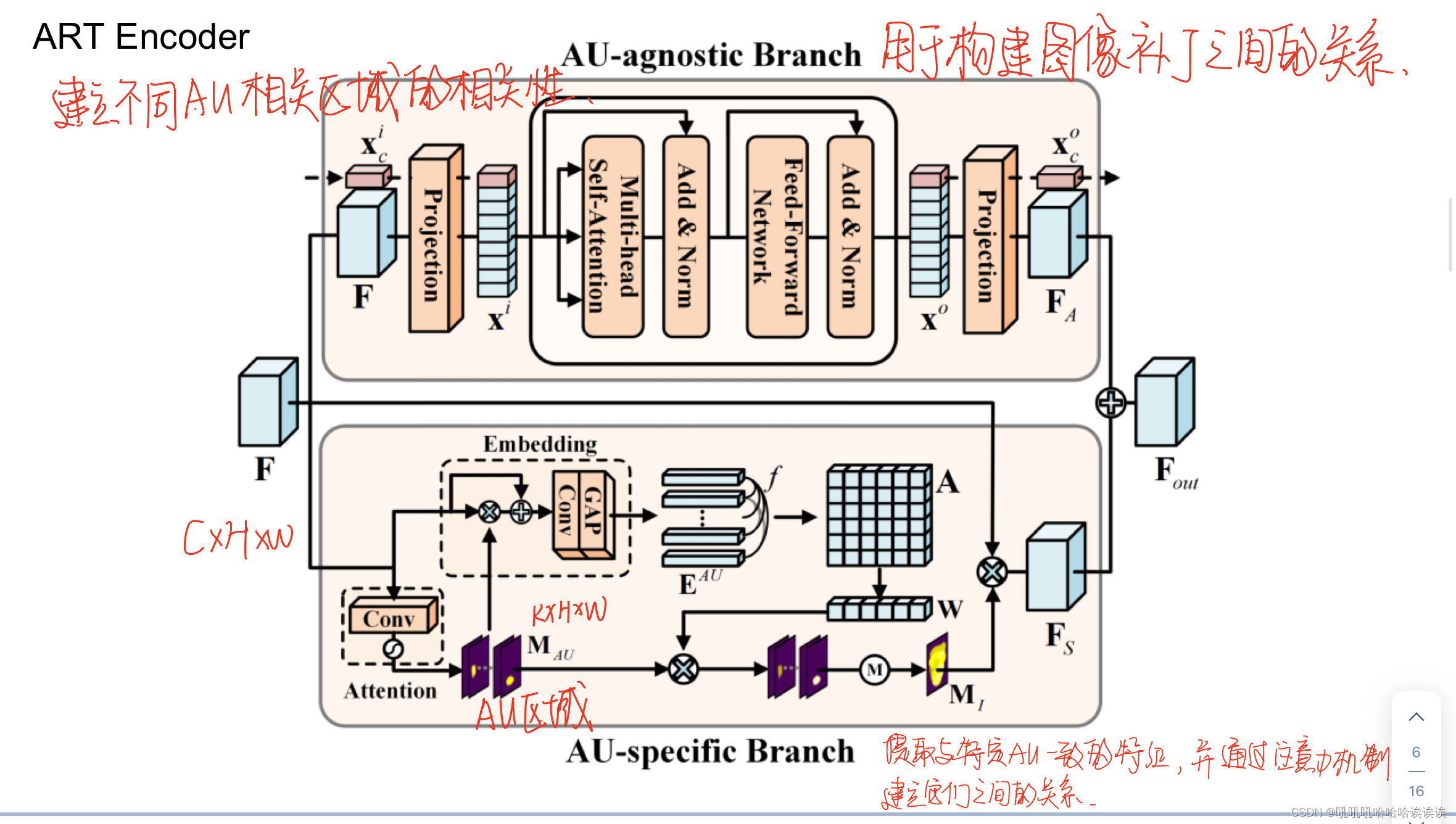

3.2. Action Units Relation Transformer

在动作单元关系Transformer(ART)中,输入图像经过主干处理提取特征。三个ART编码器堆叠在一起,充分利用了au相关区域之间的关系。每个编码器由一个特定于au的分支和一个与au无关的分支组成。特定AU分支提取与特定AU一致的特征,并通过注意机制建立它们之间的关系。au不可知分支设计用于构建图像补丁之间的关系,其中补丁既包含au相关区域,也包含其他潜在有用的面部线索。ART编码器的细节如图3所示。

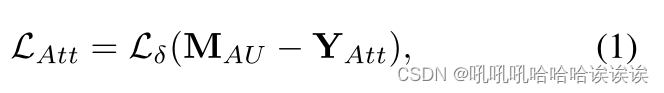

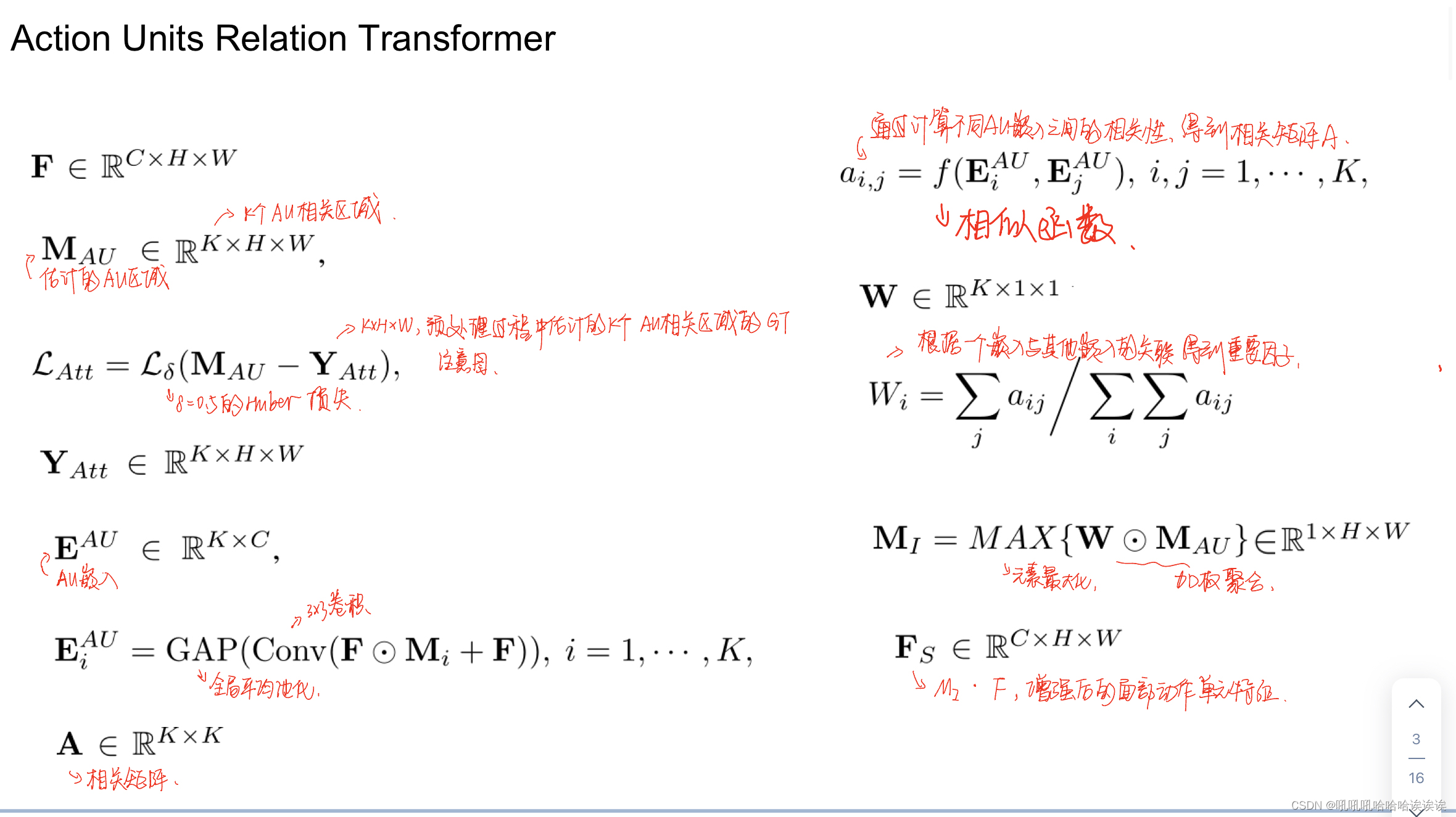

AU-specific Branch. 在这个分支中,首先生成与au相关的注意图。设F∈RC×H×W表示主干的输出特征映射。利用注意力模块估计AU区域MAU∈RK×H×W,对应K个AU相关区域。注意模块由两个3 × 3卷积层、一个1 × 1的K滤波器卷积层和一个sigmoid激活函数组成。为了更准确地针对au相关区域,我们对预测的注意力图进行如下监督:

其中LAtt为参数δ = 0.5的Huber损失函数,YAtt∈RK×H×W为预处理过程中估计的K个au相关区域的ground-truth attention map。

其中LAtt为参数δ = 0.5的Huber损失函数,YAtt∈RK×H×W为预处理过程中估计的K个au相关区域的ground-truth attention map。

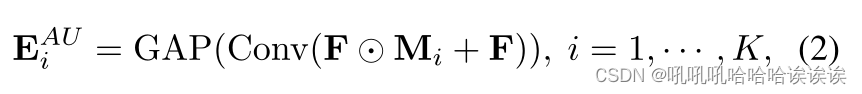

然后,我们提取AU嵌入EAU∈RK×C,它们与单个AU对齐如下:

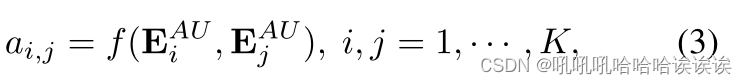

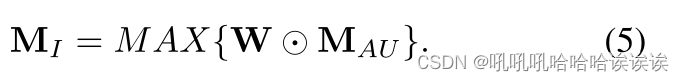

其中Conv表示一个3 × 3卷积层,GAP是一个全局平均池化层,⊙是Hadamard积。获取AU嵌入后,通过计算不同AU嵌入之间的相关性,得到相关矩阵A∈RK×K:

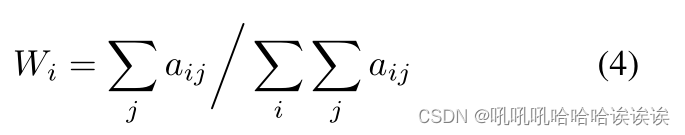

其中f是点积相似函数。然后,根据一个嵌入与其他嵌入的关联,我们得到重要因子W∈RK×1×1:

利用学习到的因子W,对MAU进行聚合,并对原始特征图中与AU相关的重要区域进行强化。具体来说,通过元素最大化操作,对AU区域进行重新加权和聚合,生成重要的AU区域MI∈R1×H×W:

最后,我们将MI与原始特征映射F相乘,使用元素级点积获得增强的面部动作单元特征FS∈RC×H×W。

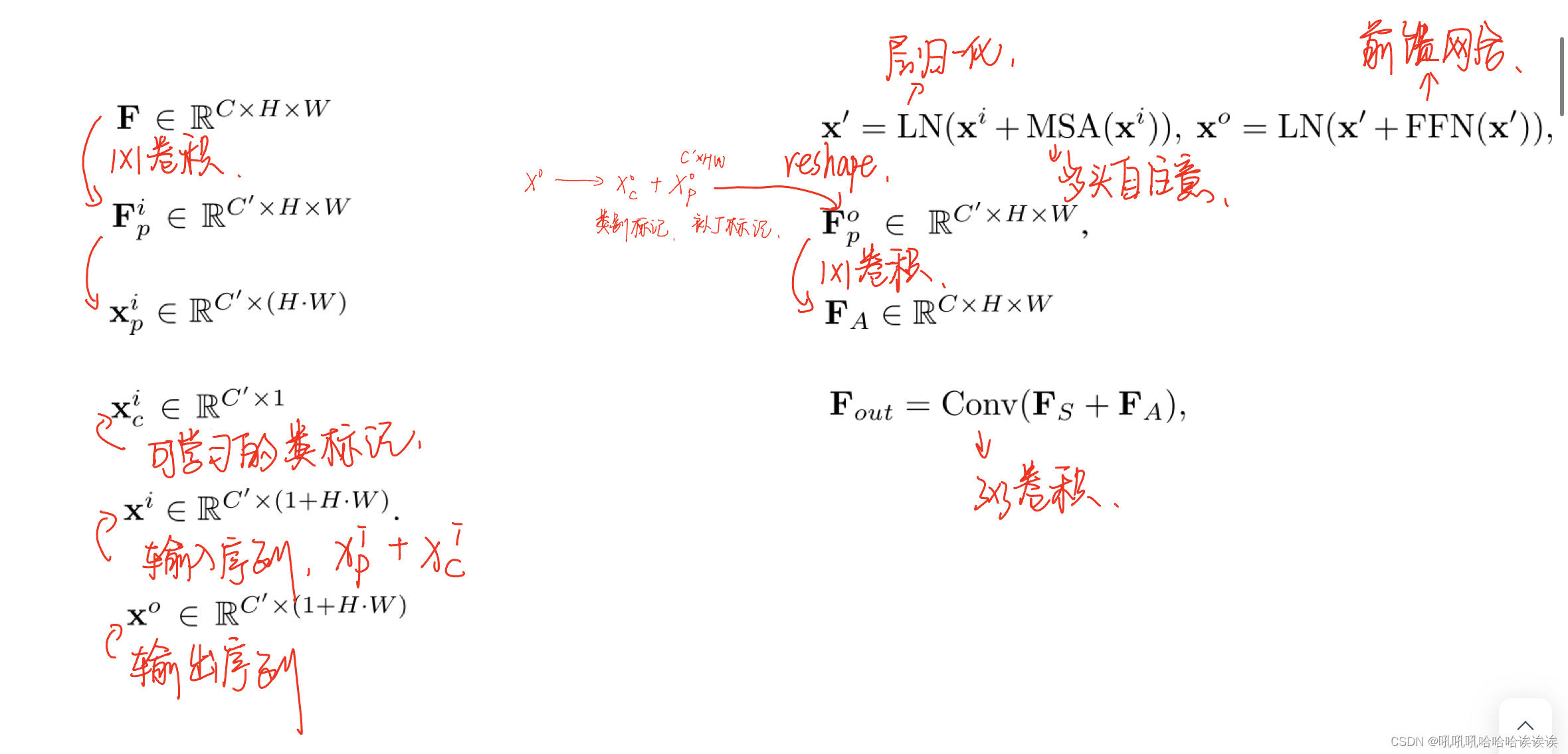

AU-agnostic Branch. 在该分支中,利用Transformer编码器[16]捕获局部图像补丁之间的丰富关系。开发了一个投影模块,将二维序列输入转换为一维序列。具体来说,首先使用1 × 1的卷积层将输入特征映射F∈RC×H×W投影到Fip∈RC ' ×H×W。注意,每个c ' × 1向量都可以被认为是输入图像中相应patch的表示。然后,我们沿着通道维度对特征映射Fip进行切片,并将它们重新排列为一系列特征向量xip∈RC ' x (H·W)。 还附加了一个可学习的类标记xic ∈ RC′×1以获得输入序列xi ∈ RC′×(1+H·W )。

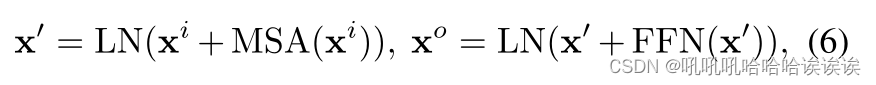

标准Transformer编码器的输出序列xo∈RC ' x (1+H·W)由下式得到:

其中LN、MSA、FFN分别为层归一化、多头自关注和前馈网络。然后,我们将输出序列xo拆分为类别标记xoc和补丁标记xop。将patch标记xop重塑回2D特征图Fop∈RC ' ×H×W,然后用1 × 1卷积层将其投影到输出FA∈RC×H×W。

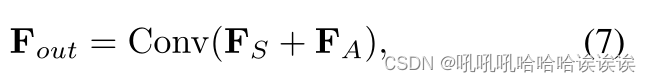

Feature Integration. 在au特定分支和au不可知分支之后,我们得到了具有丰富关系信息的特征FS和FA。一方面,我们提取au对齐的嵌入,并在各个au之间构建丰富的相关性。另一方面,transformer编码器从与au无关的图像补丁中提取au组之间的全局关系。为了结合这些特征,我们通过元素加法和两个3 × 3卷积层来集成FS和FA:

其中,Fout是ART编码器的输出。集成后,这些特征从细节和全局的角度包含关系信息,相互补充,以学习有价值的伪造线索。

3.3. Tampered AU Prediction

在建立有效模型的基础上,我们进一步制定了辅助任务——篡改AU预测(Tampered AU Prediction, TAP),以增强模型对局部伪造缺陷的感知能力。如图2紫色框所示,该任务包括与au相关的区域修改(ARM)和局部篡改监督(LS)。在ARM中,给定一张真实的脸,首先对au相关区域进行图像级篡改,以获得真实的脸和假的脸。Feature-level Mixing将真实特征的统计特征混合到假特征中,从而开发出更具挑战性的假特征。利用真脸和假脸,训练模型在局部篡改监督下预测特定位置的被操纵区域。

AU-related Region Modification. 如图2所示,我们首先为图像级篡改和特征级混合生成部分脸mask Mp。给定一张真实图像I∈R3×H×W,首先对I应用一个地标检测器来预测68个面部地标。计算这些面部标志的凸包,得到面部掩模Mf。我们从预定义的动作单元掩码中随机选择几个au相关区域R。这些选定的区域从脸的mask Mf中移除,然后我们得到高斯模糊后的部分脸的掩码Mp。

然后对真实图像执行图像级篡改。如[45]所提出的,伪目标图像It和伪源图像Is由单幅真实图像I通过不同的增强管道生成:

其中Φ1, Φ2都随机执行颜色变换和频率变换。将源图像Is和目标图像It与掩码Mp混合,得到伪图像If :

注意,背景和被移除的AU区域R在混合过程中保持不变。

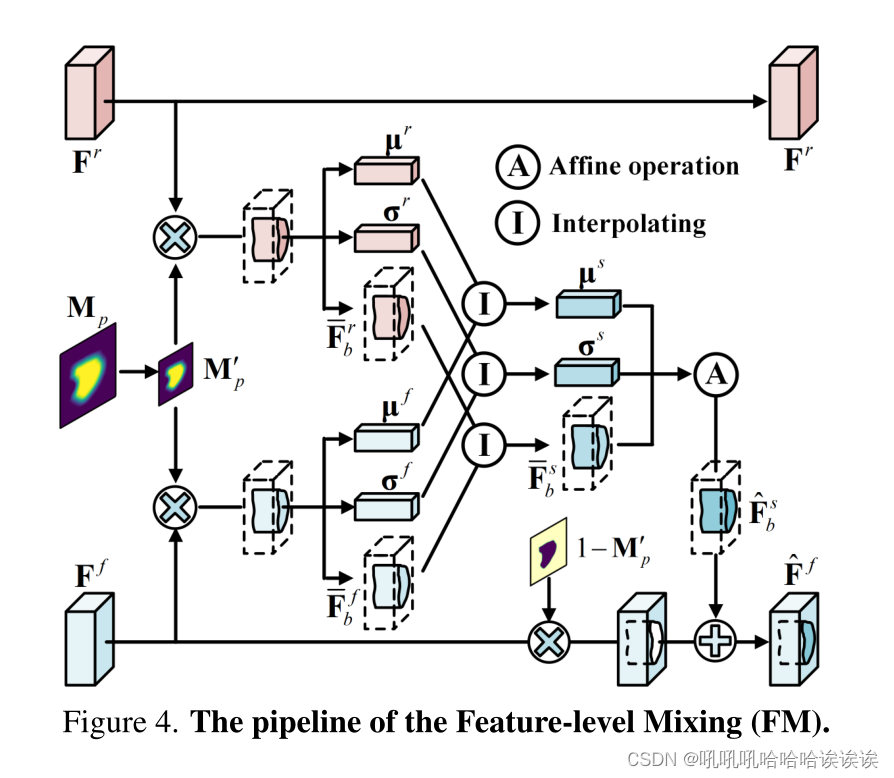

此外,我们在Partial Face Mask Mp中的au相关区域上实现了特征级混合,具体如图4所示。特征空间比输入空间具有更多的维度,因此可以获得更多样化和更具挑战性的样本进行伪造检测。在不失一般性的前提下,我们以第i层的特征为例。设Fr, Ff∈RCi×Hi×W i分别表示真实特征和虚假特征,分别对应于真实图像和虚假图像的激活。设M 'p∈R1×Hi×W i为调整大小的Partial Face Mask。我们首先计算通道均值和标准差µr,µf, σr, σf∈RCi:

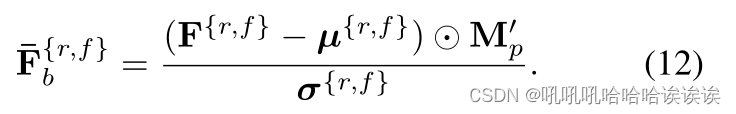

注意,均值和标准差只是借助于掩模M 'p在篡改区域上计算的。然后对篡改区域的特征进行归一化,得到归一化区域特征¯Frb,¯Ff b:

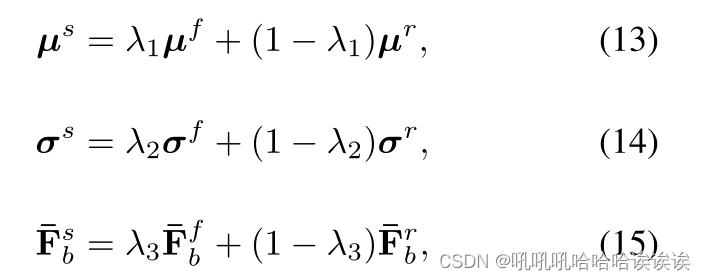

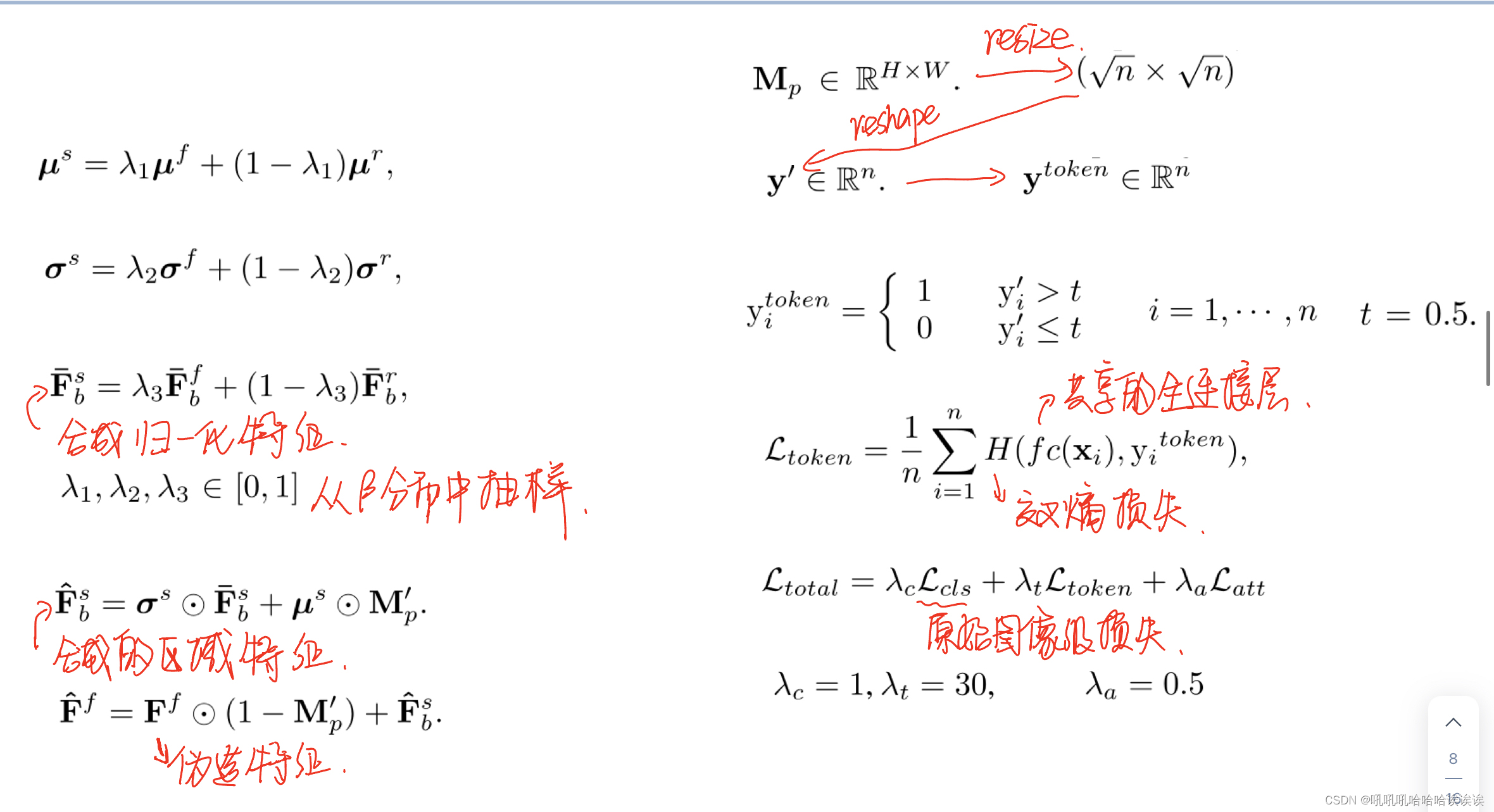

然后将真实特征的统计特征与篡改特征的统计特征混合,得到尺度σs、偏置µs和合成归一化特征¯Fsb:

其中λ1, λ2, λ3∈[0,1]是从β分布中抽样的。将合成的归一化特征¯Fsb与尺度和偏置关联,得到合成的区域特征- Fsb:

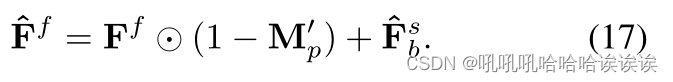

随后,我们将合成的区域特征ˆFsb添加到原始篡改特征中,如下所示:

在整个特征级混合的过程中,只修改了假特征的篡改区域,真实特征和假特征的其他区域保持不变。在每个训练步骤中,特征级混合在一个随机选择的层中进行,以丰富假样本。

Local Tampering Supervision. 目前,基于transformer的人脸伪造检测器通常利用类别标记聚合全局信息来识别人脸伪造。然而,该策略忽略了在各自的局部图像区域上编码丰富信息的其他标记的作用。在局部篡改监督中,我们为每个patch标记分配单独的特定位置的监督,表明在相应的图像区域上存在篡改操作。

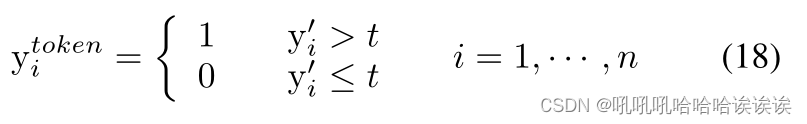

图2提供了一个直观的解释。给定一个图像I,我们表示最后一个transformer块的输出为[xc, x1,···,xn],其中xc和x1,···,xn分别对应类别标记和n个patch标记。为了利用补丁标记中的局部信息,我们首先基于Partial Face Mask Mp∈RH×W生成个人特定于位置的监督。具体来说,掩码Mp被下采样到(√n ×√n)的大小,然后重构得到粗糙版本y′∈Rn。生成标记标签ytoken∈Rn如下:

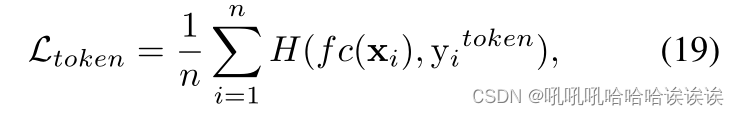

参数t = 0.5。在训练阶段,计算每个patch标记和对应的对齐标记标签之间的交叉熵损失,作为辅助损失。标记标签目标可以定义为:

其中H是softmax交叉熵损失,f c是在每个patch标记上执行的共享全连接层。在推理过程中,基于输出的类别标记和补丁标记计算预测。更多细节见补充文件。

总损失函数可表示为:

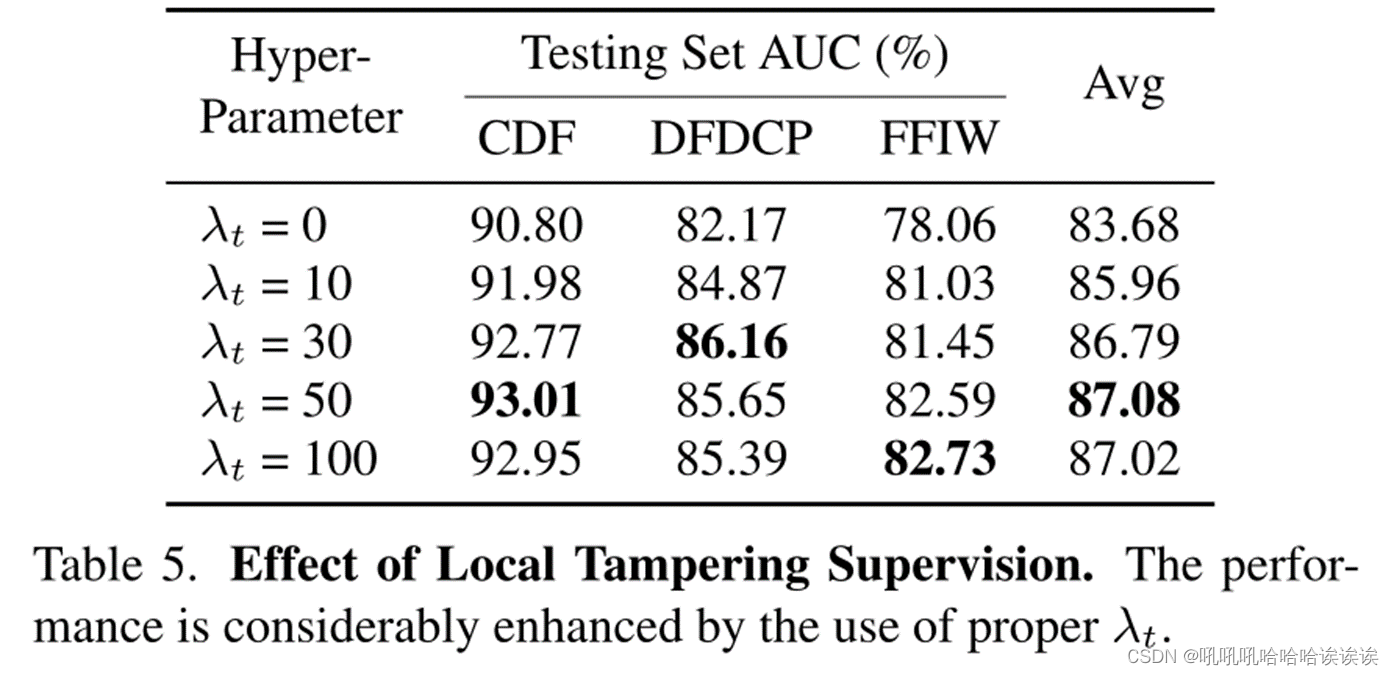

其中Lcls为原始图像级损失函数,Ltoken为标记目标,Latt为式1中提到的Huber损失函数。λc λt λa是这些项的平衡权值。在我们的实验中,我们默认设置λc = 1, λt = 30, λa = 0.5。

4. Experiments

4.1. Implementation Details

Pre-processing. 对于每个视频帧,使用RetinaFace[12]检测人脸裁剪,使用公共工具箱Dlib[28]检测地标。所有的脸部作物被调整为224×224。为了获取GT注意图YAtt,每个行动单元特定的地标的定义与[32,44]类似。我们将椭圆拟合到地标上作为每个动作单元的初始区域,对图像进行高斯平滑(σ = 3),得到15个动作单元蒙版。将这些掩模按通道方向拼接,得到GT YAtt。注意,在推理过程中不需要地标和YAtt;因此,我们只在推理时使用RetinaFace来裁剪人脸。

Training. 我们采用Xception[8]直到block11的部分作为我们的主干。使用ImageNet[11]预训练的权重初始化Xception。给定一个输入图像I∈R3×H×W,我们首先将其输入到backbone中,并在Xception的block11层提取特征F∈RC×H ' ×W '进行进一步计算,其中H ' = H/16, W ' = W/16。我们使用SGD[41]优化器训练模型100次。批大小和学习率分别设置为32和0.001。我们每个视频只采样8帧用于训练。每批图像由真实图像及其对应的生成图像组成。

Datasets. 按照惯例,我们采用Face-Forensics++ (FF++)[42]进行训练。FF++是一个大规模的基准数据集,包含来自youtube的1000个原始视频和相应的假视频,这些假视频是通过四种典型的操作方法生成的:Deepfakes (DF)[2]、Face2Face (F2F)[48]、FaceSwap (FS)[3]和NeuralTextures (NT)[47]。我们按照官方拆分FF++,默认使用总部版本,否则指定版本。为了评估我们方法的泛化性,我们还对最近提出的人脸取证数据集进行了实验,即Celeb-DF (CDF)[36]、DeepfakeDetection (DFD)[1]、DeepfakeDetection Challenge (DFDC)[13]和DFDC Preview (DFDCP)[14]、wilddeepfake (FFIW)[57]。我们还遵循官方拆分来构建测试集。

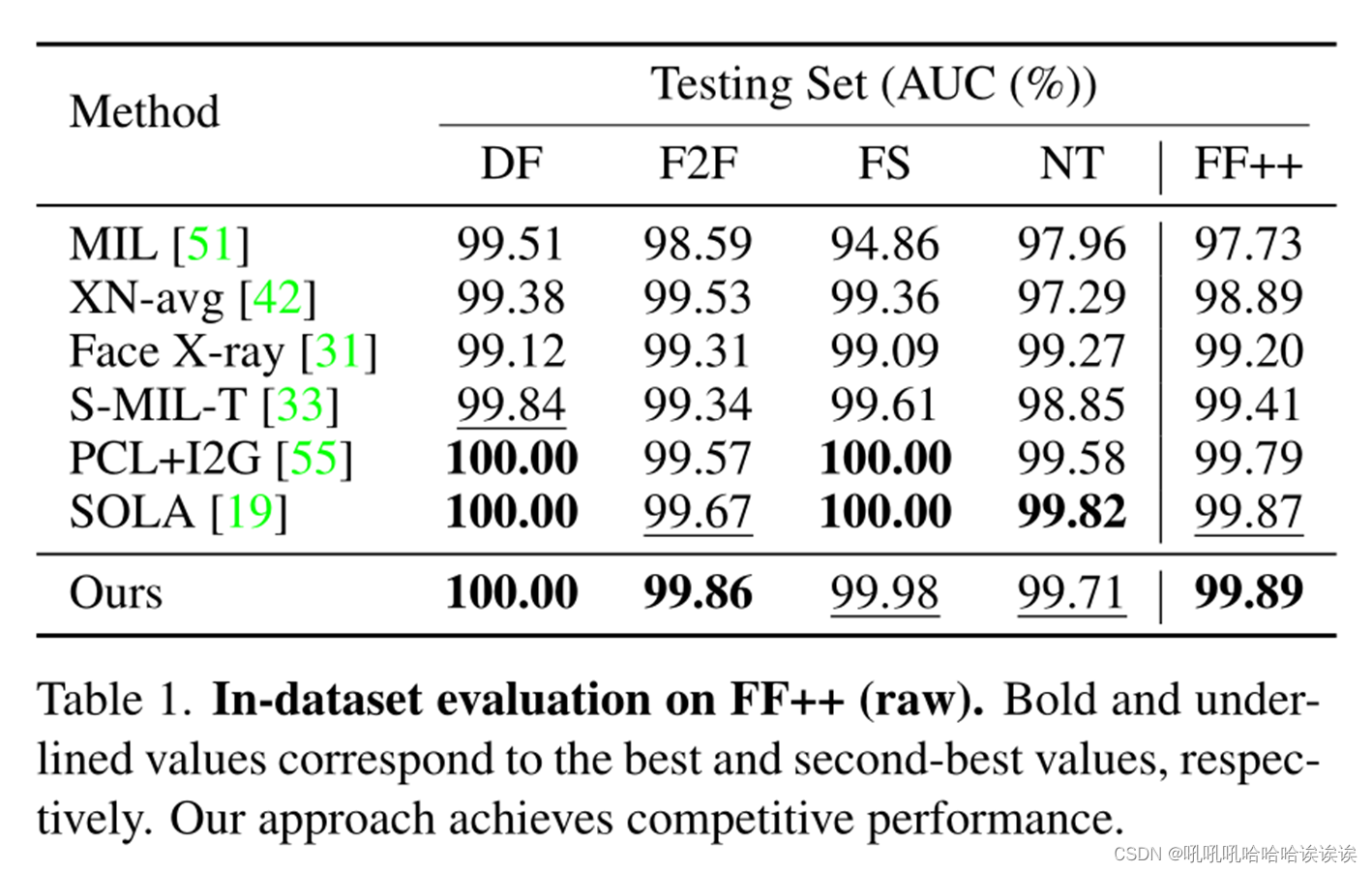

4.2. In-dataset Evaluation

在数据集内评估中,我们在FF++的训练分割[42]的真实和虚假数据上训练了ART,而没有训练提出的TAP。结果如表1所示。我们在补充资料中提供了更多关于CDF[36]和DFDCP[14]的数据集内评价结果。我们的模型在FF++数据集上取得了具有竞争力的性能。具体地,我们在DF和F2F上实现了最佳性能。虽然以前的方法(如SOLA [19], PCL+I2G[55])的性能在FF++上趋于饱和,但我们仍然获得了99.89%的最佳性能。总的来说,ART取得了很好的效果,证明了AU关系学习有利于人脸伪造检测。

4.3. Generalization Ability Evaluation

在真实的检测情况下,防御者通常不知道攻击者的伪造方法。出于这个原因,我们执行评估来验证模型对各种伪造方法的泛化。

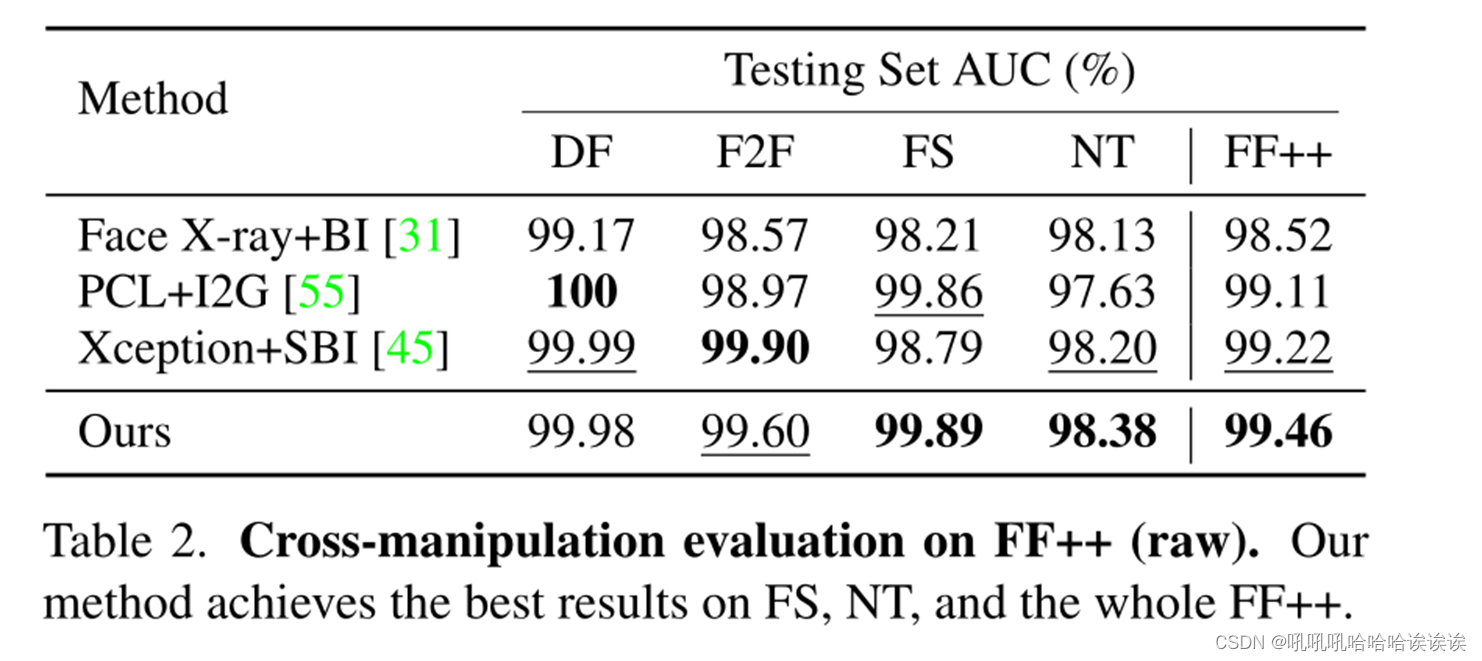

Cross-Manipulation Evaluation. 按照[45]中使用的评估方案,我们对FF++的四种操作方法评估我们的模型。表2是我们对FF++的交叉操作评价结果,其中我们只使用FF++的真实视频进行训练。我们的方法在四个操作上优于或接近于现有的类似方法(DF上99.98%,F2F上99.60%,FS上99.89%,NT上98.38%),并且在整个FF++上达到最佳性能(99.46%对99.22%)。结果表明,我们的方法不仅在深度伪造上有效,而且在其他人脸处理上也很有效。

Cross-Dataset Evaluation. 为了展示我们方法的通用性,我们进一步进行了跨数据集评估,其中我们的框架在FF++的真实图像上进行了训练,并在其他最近发布的数据集上进行了评估。表3给出了跨数据集评估结果。如所见,我们的方法在所有情况下都优于其他模型,并实现了最佳的总体性能。与视频级方法相比,我们的方法在CDF、DFD、DFDC、DFDCP和FFIW上分别优于最先进的基于transformer的方法FTCN[56],分别提高了5.87%、4.82%、2.82%、12.16%和6.98%点,平均提高了6.53%点(与FFIW相比提高了86.68% vs 80.15%)。一个可能的原因是,经过真假视频训练的FTCN仍然专注于FF++的特定伪造模式,这阻碍了泛化的表现。LipForensics[24]针对嘴区域的高级语义不规则性,提高了泛化性能。然而,他们的方法可能会忽略其他面部动作单元的法医线索。这个限制可以解释为什么他们的表现不如我们。

与在真假图像上训练的帧级方法(即LRL[7]、FRDM[38]、DCL[46])相比,我们的方法在AUC方面比他们在CDF上的方法高出10%以上。与在真实图像和合成图像上训练的类似方法(即Face X-ray+BI [31], PCL+I2G [55], Xception+SBIs[45])相比,我们的方法仍然具有更好的泛化性能。特别是,我们在CDF、DFD、DFDC、DFDCP和FFIW上的AUC分别比目前最先进的Xception+ SBIs高出约2.50%、3.01%、3.05%、7.31%和4.73%,平均提高基线4.12%点(86.68%比82.56%)。我们的框架实现了更好的性能,可能是由于精心设计的动作单元关系transformer,以及在图像空间和特征空间中生成更丰富的伪造样本。

4.4. Analysis

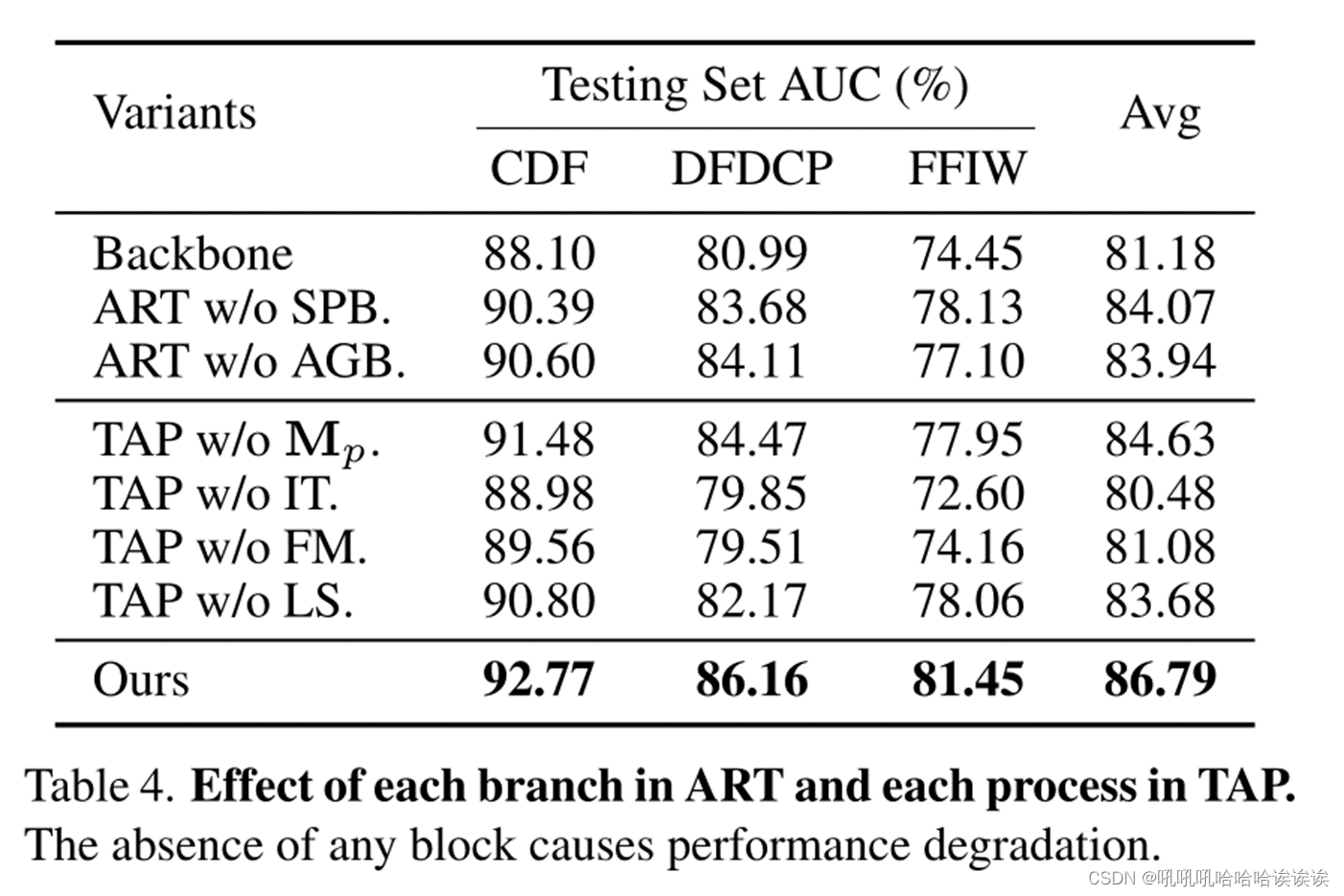

本节分析了ART中的每个分支、TAP中的每个过程、LS中的超参数。我们在补充资料中提供了更多的分析。

Effect of Each Branch in ART. 我们将我们的方法与提议的TAP下的以下变体进行比较。(1)骨干网(Backbone):将我们的骨干网提取后的特征输入到全局平均池化和全连接层。(2)无SPB: ART,无au特异性分支。(3) w/o AGB:没有au不可知分支的ART。

实验对比如表4所示。针对au的分支和与au无关的分支都会在主干上带来性能提升(平均为2.89%和2.76%)。这表明了利用AU关系线索进行人脸伪造检测的有效性。我们还观察到,AGB(84.07%)的模型性能略好于SPB(83.94%)。这可能是由于使用了Transformer编码器,它可以对图像补丁之间的相关性进行建模,从而获得全面的取证线索。然而,AGB忽略了人脸语义的局部信息,这有利于深度伪造检测。当我们将AGB和SPB结合时,我们的模型的性能从81.18%提高到86.79%。这表明同时考虑不同行动单元在au不可知补丁和au特定区域之间的关系是有效的。

Effect of Each Process in TAP. 我们将我们的方法与以下变体进行比较。(1) w/o Mp:用面部标志的凸包(即脸部掩码Mf)代替局部脸掩码Mp。(2)无IT:我们从TAP中去除图像级篡改。(3)无FM:从TAP中去除特征级混合。(4)无LS:我们在TAP的管道中禁用局部篡改监督。

实验对比如表4所示。用Mf代替Mp,平均下降2.16%。这表明从Mf中随机移除AU区域对于整个过程是必要的。其中一个原因是部分面膜Mp提供动态改变AU区域,便于后续篡改和预测,这有利于伪造样本的多样性,增加了辅助任务的难度。我们还观察到,图像级篡改和特征级混合再现了重要的伪像,因为没有它们,性能会显著下降(分别从86.79%降至80.48%和81.08%)。此外,如果没有局部篡改监督,我们的方法会下降3.11%。这表明,引导模型学习额外的特定位置法医线索实际上对人脸法医检测是有效的。

Effect of Local Tampering Supervision. 在本节中,模型在FF++的真实数据上进行训练,并增加λt。结果如表5所示。我们观察到,具有局部篡改监督(λt > 0)的模型优于仅具有二值分类损失(λt = 0)的模型,特别是参数λt = 50训练的模型的AUC得分(3.40%)平均优于参数λt = 0训练的模型。结果表明,在训练过程中适当地使用λt是有益的,这也表明局部篡改监督在成功的过程中起着重要的作用。

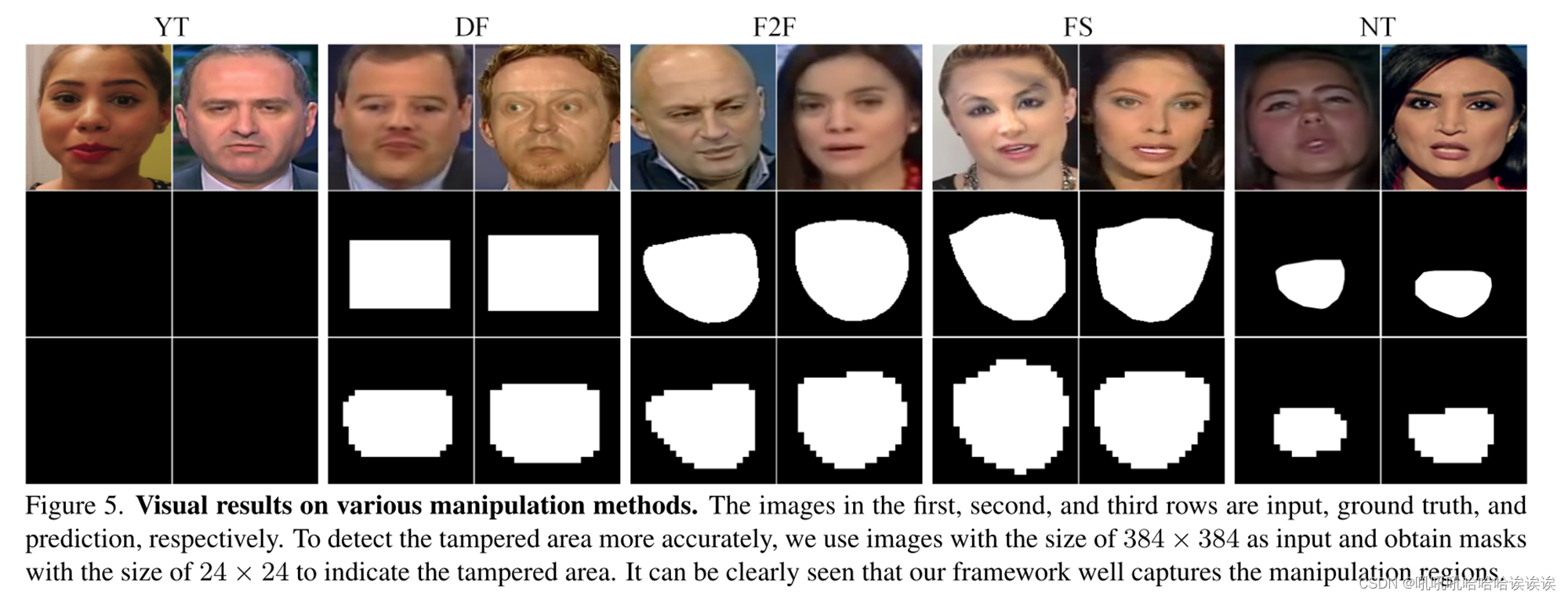

4.5. Qualitative Results

我们的框架增强了深度伪造检测的表示学习,同时也生成了关于修改区域的可解释的可视化线索。为了表示被篡改的区域,将基于patch标记的1D预测结果转换为2D掩码。图5显示了一些预测结果(第三行)以及相应的输入图像(第一行)和真实情况(第二行)。当输入一个真实的图像时,在大多数情况下,可视化是一个纯空白图像,表明输入图像没有被操纵。在测试假图像时,预测的掩模可以充分匹配真实情况。结果表明,我们的框架可以捕获相应的操作区域,而不是简单地分割全脸部分。

5. Conclusion

本文提出了动作单元关系学习框架,该框架由动作单元关系transformer(ART)和篡改AU预测(TAP)组成。在ART中,我们对au不可知patches和特定区域的不同行动单元之间的关系进行了建模。这两个层次的关系学习相辅相成,共同发现伪造线索。我们还制定了一个辅助任务,即篡改AU预测,在AU相关区域实现图像级篡改和特征级混合,并通过局部篡改监督增强模型感知局部伪造缺陷的能力。实验结果表明,我们的框架在流行数据集上与最先进的方法相比具有竞争力,为未来的研究提供了强有力的基线。

3474

3474

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?