文章目录

6 概率与分布(Probability and Distributions)(上)

概率,宽泛地讲,是对不确定性的研究。概率可以被认为是事件发生次数的分值,或者事件的置信度。我们可以用概率来度量实验中发生某事的可能性。如第一章所述,我们经常量化数据中的不确定性,机器学习模型中的不确定性,以及模型产生的预测值中的不确定性。量化不确定性需要随机变量(random variable)的概念,它是一个函数,将随机实验的结果映射到我们感兴趣的一组值。与随机变量相关联的是一个衡量特定结果(或一系列结果)发生概率的函数;这叫做概率分布( probability distribution)。

概率分布被用于其他概念,例如概率建模(第8.4节)、图模型(第8.5节)和模型选择(第8.6节)。在下一节中,我们将介绍定义概率空间的三个概念(样本空间、事件和事件概率),以及它们与第四个称为随机变量的概念之间的关系。过于严谨的陈述可能会掩盖概念背后的直观感觉,所以下文的部分内容会故意夸张化。图6.1显示了本章中介绍的概念的概要。

图6.1 与本章描述的随机变量与概率分布相关的概念的思维导图

6.1 概率空间的构造

概率论旨在定义一种数学结构来描述实验的随机结果。例如,当抛一枚硬币时,我们不能确定结果,但通过多次抛硬币,我们可以通过平均结果观察到规律。我们使用概率这个数学结构的目标是执行自动推理,在这个意义上,概率包括了逻辑推理(Jaynes, 2003)。

6.1.1 哲学问题

在构造自动推理系统时,经典的布尔逻辑不允许我们表达某些形式的似是而非的推理。考虑以下场景:我们观察到A是错的,然后我们会觉得B变得不那么可信了,尽管从经典逻辑中无法得出该结论。我们观察到B是真的。A则变得可信了。我们每天都用这种推理方式。比如我们在等一个朋友,考虑三种可能:

- H1:她准时到了;

- H2:她被交通耽搁了;

- H3:她被外星人绑架。

当我们观察到朋友迟到时,我们合乎逻辑地排除H1。我们也倾向于认为H2更有可能,尽管从逻辑上讲我们不需要这样做。我们还可能认为H3是可能的,但因为太荒谬而否认它。我们是如何断定H2是最合理的答案的?这样看来,概率论可以看作是布尔逻辑的推广。在机器学习的背景下,它经常以这种方式应用于自动推理系统的形式化设计。关于概率理论是推理系统的基础的进一步讨论可以在Pearl(1988)中找到。

Cox(Jaynes,2003)研究了概率的哲学基础,以及概率应该如何与”我们认为应该是真的“(在逻辑意义上)联系起来。另一种思考的方式是,我们构建概率来衡量我们的常识的精确程度。E.T.Jaynes(1922–1998)确定了三个数学标准,这些标准必须适用于所有似是而非的情况:

1 置信(plausibility )程度要用实数表示。

2这些数字必须建立在常识的基础上。

3 由此产生的推理必须一致,“一致”一词有以下三种含义:

- (a) 一致性或非矛盾性:当可以通过不同的方法得到相同的结果时,在所有情况下置信(plausibility )值应是相同的。

- (b) 诚实(Honesty):必须考虑所有可用的数据。

- (c) 可重复性:如果我们对两个问题的认知状态是相同的,那么我们必须对这两个问题赋予相同的置信度。

Cox–Jaynes定理证明了这些性质足以定义适用于概率 p p p的普遍数学规则,直至通过任意单调函数进行变换。最关键的是,这些规则是概率规则。

备注:在机器学习和统计学中,有两种主要的概率解释:贝叶斯主义和频率主义(Bishop, 2006;Efron and Hastie, 2016)。贝叶斯主义使用概率来指定用户对事件的不确定性程度。它有时被称为“主观概率”或“置信程度”。频率主义则考虑感兴趣的事件与所发生事件的总数的相对频率。一个事件的概率定义为当发生事件的总数趋于无限时,该事件的相对频率。

许多机器学习的概率模型描述使用惰性符号和术语,这会令人困惑的。这篇文章也不例外。有多个不同的概念都被称为“概率分布”,读者往往要从上下文中获知其中的含义。一个有助于理解概率分布的技巧是检查我们是在尝试建立一个分类的(离散的随机变量)模型还是一个连续的(连续的随机变量)模型。我们在机器学习中处理的问题的种类与我们要考虑分类模型还是连续模型密切相关。

6.1.2 概率与随机变量

在讨论概率时,有三个不同的概念经常被混淆。首先是概率空间,它允许我们量化概率。然而,我们大多不直接使用这个基本概率空间。取而代之地,我们使用随机变量(第二个概念),这将概率转移到一个更方便的(通常是数值上的)空间。第三个概念是与随机变量相关的分布或规律。我们将在本节介绍前两个概念,并在第6.2节对第三个概念进行展开讨论。

现代概率是基于Kolmogorov提出的一组公理(Grinstead and Snell, 1997; Jaynes, 2003),它介绍了样本空间、事件空间和概率测度这三个概念。概率空间则为一个具有随机结果的真实过程(称为实验)建模。

样本空间 Ω \Omega Ω

样本空间(sample space)是实验的所有可能结果的集合,通常用 Ω Ω Ω表示。例如,连续两次抛硬币的样本空间为 { h h , t t , h t , t h } \{hh,tt,ht,th\} {hh,tt,ht,th},其中“ h h h”表示正面“heads”,“ t t t”表示反面“tails”。

事件空间 A \mathcal{A} A

事件空间(event space)是实验潜在结果的空间。如果在实验结束时我们能观察到特定结果 ω ∈ Ω ω∈Ω ω∈Ω是否在样本空间 Ω Ω Ω的子集 A A A中,则称子集 A A A在事件空间 A \mathcal{A} A中。事件空间 A \mathcal{A} A是由 Ω Ω Ω的子集组成的,对于离散概率分布(第6.2.1节), A \mathcal{A} A通常是 Ω Ω Ω的幂集。

概率 P P P

对于每个事件 A ∈ A A∈\mathcal{A} A∈A,我们用一个数字 P ( A ) P(A) P(A)与它相关联,该数字度量事件发生的概率或置信度。 P ( A ) P(A) P(A)称为 A A A的概率(probability)。

单个事件的概率必须在 [ 0 , 1 ] [0,1] [0,1]区间内,样本空间 Ω Ω Ω中所有结果的总概率必须为 1 1 1,即 P ( Ω ) = 1 P(Ω)= 1 P(Ω)=1。

给定一个概率空间 ( Ω , A , P ) (Ω,\mathcal{A}, P) (Ω,A,P),我们希望使用它来模拟一些现实世界的现象。在机器学习中,我们经常避免直接引用概率空间,而是引用感兴趣的量上的概率,我们用 T \mathcal{T} T表示。在这本书中,我们把 T \mathcal{T} T称为目标空间(target space),把 T \mathcal{T} T的元素称为状态。我们引入了一个函数 X : Ω → T X:Ω→\mathcal{T} X:Ω→T,它接受 Ω Ω Ω元素(一个结果,样本点),并返回感兴趣对象 x x x 的特定量( T \mathcal{T} T中的值)。从 Ω Ω Ω到 T \mathcal{T} T的这种关联/映射称为随机变量(random variable)。

例如,考虑投掷两枚硬币并计算正面数。随机变量 X X X映射到三种可能的结果: X ( h h ) = 2 , X ( h t ) = 1 , X ( t h ) = 1 , X ( t t ) = 0 X(hh) = 2, X(ht) = 1, X(th) = 1, X(tt) = 0 X(hh)=2,X(ht)=1,X(th)=1,X(tt)=0。在这个特殊的情况下, T = { 0 , 1 , 2 } \mathcal{T} =\{0,1,2\} T={0,1,2},我们感兴趣的是 T \mathcal{T} T中元素的概率。对于有限的样本空间 Ω Ω Ω和有限的 T \mathcal{T} T,随机变量对应的函数本质上是一个查找表。对于任意子集 S ⊆ T S \subseteq \mathcal{T} S⊆T,我们将 P X ( S ) ∈ [ 0 , 1 ] P_X(S)∈[0,1] PX(S)∈[0,1](概率)与随机变量 X X X对应的特定事件联系起来。例6.1提供了具体说明。

备注:

前面提到的样本空间 Ω Ω Ω在不同的书籍中有不同的名称。 Ω Ω Ω的另一个常见名称是“状态空间”(Jacod和Protter, 2004),但状态空间有时用于引用动力系统中的状态(Hasselblatt和Katok, 2003)。描述 Ω Ω Ω的其他名称有:“样本描述空间”、“可能性空间”和“事件空间”。

例子 6.1

我们假定读者对事件集合的交集和并集的概率计算已经很熟悉了。

现考虑一个统计实验,在这个实验中我们模拟一款从一个袋子中抽取两枚硬币的游乐场游戏(有放回)。袋子里有来自中国(表示为¥ )和英国(表示为£)的硬币,由于我们从袋子里取出两枚硬币,所以总共有四种结果。即这个实验的状态空间或样本空间 Ω Ω Ω是( ¥, ¥),(¥,£),(£,¥),(£,£)。让我们假设这袋硬币的组合是这样的:随机抽一次硬币得到 ¥的概率为0.3。

我们感兴趣的事件是重复抽取最后得到的¥的总次数。让我们定义一个随机变量

X

X

X,它将样本空间

Ω

Ω

Ω映射到

T

\mathcal{T}

T,

T

\mathcal{T}

T表示我们从袋子中取出 ¥的次数。从前面的样本空间可以看出,我们可以得到0个 ¥,1个 ¥,或2个¥,因此

T

=

{

0

,

1

,

2

}

\mathcal{T} =\{0,1,2\}

T={0,1,2}。随机变量

X

X

X(一个函数或查找表)可以用如下表表示:

X

(

(

¥

,

¥

)

)

=

2

X((¥, ¥))=2

X((¥,¥))=2

X

(

(

¥

,

£

)

)

=

1

X((¥, £))=1

X((¥,£))=1

X

(

(

£

,

¥

)

)

=

1

X((£,¥))=1

X((£,¥))=1

X

(

(

£

,

£

)

)

=

0

X((£, £))=0

X((£,£))=0

因为我们在抽第二枚硬币之前放回了第一枚抽到的硬币,这意味着两次抽硬币是相互独立的,我们将在第6.4.5节讨论这一点。注意到有两个实验结果是映射到同一个事件的,这两个结果都有且只有一个¥。因此,

X

X

X的概率质量函数(第6.2.1节)为:

P

(

X

=

2

)

=

P

(

(

¥

,

¥

)

)

=

P

(

¥

)

⋅

P

(

¥

)

=

0.3

⋅

0.3

=

0.09

\begin{aligned}P(X=2) &=P((¥, ¥)) \\&=P(¥) \cdot P(¥) \\&=0.3 \cdot 0.3=0.09\end{aligned}

P(X=2)=P((¥,¥))=P(¥)⋅P(¥)=0.3⋅0.3=0.09

P

(

X

=

1

)

=

P

(

(

¥

,

£

)

∪

(

£

,

¥

)

)

=

P

(

(

¥

,

£

)

)

+

P

(

(

£

,

¥

)

)

=

0.3

⋅

(

1

−

0.3

)

+

(

1

−

0.3

)

⋅

0.3

=

0.42

\begin{aligned}P(X=1) &=P((¥, £) \cup(£, ¥)) \\&=P((¥, £))+P((£, ¥)) \\&=0.3 \cdot(1-0.3)+(1-0.3) \cdot 0.3=0.42\end{aligned}

P(X=1)=P((¥,£)∪(£,¥))=P((¥,£))+P((£,¥))=0.3⋅(1−0.3)+(1−0.3)⋅0.3=0.42

P

(

X

=

0

)

=

P

(

(

£

,

£

)

)

=

P

(

£

)

⋅

P

(

£

)

=

(

1

−

0.3

)

⋅

(

1

−

0.3

)

=

0.49.

(

6.7

)

\begin{aligned}P(X=0) &=P((£, £)) \\&=P(£) \cdot P(£) \\&=(1-0.3) \cdot(1-0.3)=0.49 .\end{aligned}\qquad(6.7)

P(X=0)=P((£,£))=P(£)⋅P(£)=(1−0.3)⋅(1−0.3)=0.49.(6.7)

在计算中,我们将 X X X输出的概率和 Ω Ω Ω中样本的概率这两个不同的概念等同起来。例如,在(6.7)我们说 P ( X = 0 ) = P ( ( £ , £ ) ) P (X = 0) =P((£,£)) P(X=0)=P((£,£))。考虑随机变量 X : Ω → T X:Ω→\mathcal{T} X:Ω→T和一个子集 S ⊆ T S\subseteq\mathcal{T} S⊆T(例如, T \mathcal{T} T的单个元素,如抛两枚硬币时得到一个正面的结果)。

设

X

−

1

(

S

)

X^{−1} (S)

X−1(S)为

X

X

X对

S

S

S的前像(pre-image),即

Ω

Ω

Ω中能被

X

X

X映射到

S

S

S的元素集合;

{

ω

∈

Ω

:

X

(

ω

)

∈

S

}

\{ω∈Ω:X(ω)∈S\}

{ω∈Ω:X(ω)∈S}。通过随机变量

X

X

X来理解

Ω

Ω

Ω中事件的概率转换的一种方法是将它与

S

S

S的前像概率相关联(Jacod和Protter, 2004)。对于

S

⊆

T

S\subseteq\mathcal{T}

S⊆T,我们有这样的表达:

P

X

(

S

)

=

P

(

X

∈

S

)

=

P

(

X

−

1

(

S

)

)

=

P

(

{

ω

∈

Ω

:

X

(

ω

)

∈

S

}

)

(

6.8

)

P_{X}(S)=P(X \in S)=P\left(X^{-1}(S)\right)=P(\{\omega \in \Omega: X(\omega) \in S\})\qquad (6.8)

PX(S)=P(X∈S)=P(X−1(S))=P({ω∈Ω:X(ω)∈S})(6.8)

(6.8)的左边是我们感兴趣的一组可能结果(例如,¥ 的数目为 1)的概率。通过随机变量 X X X(将状态映射到结果),我们在(6.8)的右侧可以看到(在 Ω Ω Ω中)具有属性(如¥£,£¥)的状态集的概率。我们说随机变量 X X X是根据特定的概率分布 P X P_X PX分布的,它定义了事件和随机变量结果概率之间的概率映射。换句话说,函数 P X P_X PX或等效的 P ◦ X − 1 P◦X^{−1} P◦X−1是随机变量 X X X的规律( law)或分布(distribution)。

备注:目标空间,即随机变量 X X X的值域 T \mathcal{T} T,用来表示概率空间的类型,即一个 T \mathcal{T} T随机变量。当 T \mathcal{T} T是有限的或可数无限的,这被称为离散随机变量(第6.2.1节)。对于连续随机变量(第6.2.2节),我们则考虑 T = R \mathcal{T}= \mathcal{R} T=R或 T = R D \mathcal{T}=\mathcal{R}^D T=RD

6.1.3 统计学

概率论和统计学经常同时出现,但它们涉及不确定性的不同方面。对比它们的一种方式是通过所考虑的问题的类型。

使用概率,我们可以考虑一些过程的模型,其中潜在的不确定性被随机变量捕获,然后我们使用概率规则来推导会发生什么。

在统计学中,我们观察到某些事情发生了,并试图找出解释这些观察结果的潜在过程。从这个意义上说,机器学习的目标接近于统计学,即构建一个充分代表生成数据过程的模型。另外我们可以使用概率规则来获得一些数据的“最佳拟合”模型。

另一个方面,我们对机器学习系统的泛化误差感兴趣(见第8章)。这意味着我们对机器学习系统在未观察到的实例上的性能感兴趣,这些实例与我们已有的实例不完全相同。这种对未来表现的分析依赖于概率和统计,其中大部分都超出了本章将介绍的内容。鼓励感兴趣的读者阅读Boucheron et al.(2013)和Shalev Shwartz and Ben David(2014)的书。我们将在第8章看到更多关于统计的内容。

6.2 离散和连续概率

让我们来关注6.1节中提到的的描述事件概率的方法上。根据目标空间是离散的还是连续的,有不同的表示分布的方式。当目标空间 T \mathcal{T} T是离散的时,我们可以指定随机变量 X X X取特定值 x ∈ T x∈\mathcal{T} x∈T的概率,记为 P ( X = x ) P(X = x) P(X=x),离散的随机变量 X X X的表达式 P ( X = x ) P(X = x) P(X=x)称为概率质量函数(probability mass function)。当目标空间 T \mathcal{T} T是连续的,例如,实线 R \mathbb{R} R,更自然的指定概率随机变量 X X X的方式是用一个区间,即用 P ( a ≤ X ≤ b ) , 其 中 a < b P (a \le X \le b),其中a < b P(a≤X≤b),其中a<b。按照惯例,如果我们要指定概率随机变量 X X X小于某一特定值 x x x,则用 P ( X ≤ x ) P (X\le x) P(X≤x)表示。关于连续随机变量 X X X的表达式 P ( X ≤ x ) P (X\le x) P(X≤x)称为累积分布函数(cumulative distribution function)。我们将在第6.2.2节讨论连续随机变量。在第6.2.3节中,我们将重新讨论离散和连续随机变量的术语,并对它们进行对比。

备注:

单变量分布(univariate distribution)指的是一个随机变量的分布(其状态用非黑体的

x

x

x表示)。而多个随机变量的分布则称为多变量分布(multivariate distributions),并通常会考虑随机变量的向量(状态用黑体

x

\boldsymbol{x}

x表示)。

6.2.1 离散概率

当目标空间是离散的时,我们可以把多个随机变量的概率分布想象成一个(多维)数组。图6.2展示了一个例子。

图 6.2 随机变量为

X

X

X和

Y

Y

Y的离散双变量概率质量函数的可视化。这张图改编自Bishop(2006)。

联合概率的目标空间是每个随机变量的目标空间的笛卡尔积。我们将联合概率(joint probability)定义为两个值的联合输入

P

(

X

=

x

i

,

Y

=

y

j

)

=

n

i

j

N

P\left(X=x_{i}, Y=y_{j}\right)=\frac{n_{i j}}{N}

P(X=xi,Y=yj)=Nnij

其中 n i j n_{ij} nij是状态为 x i x_i xi和 y j y_j yj的事件的数量, N N N为事件总数。联合概率是两个事件相交的概率,即 P ( X = x i , Y = y j ) = P ( X = x i ∩ Y = y j ) P\left(X=x_{i}, Y=y_{j}\right)=P\left(X=x_{i} \cap Y=y_{j}\right) P(X=xi,Y=yj)=P(X=xi∩Y=yj)。

图6.2说明了离散概率分布的概率质量函数(probability mass function,pmf)。对于两个随机变量 X X X和 Y Y Y, X = x X=x X=x和 Y = y Y=y Y=y的概率(惰性地) 写为 p ( x , y ) p(x,y) p(x,y),称为联合概率。我们可以把概率看作是一个函数,它接受状态 x x x和 y y y并返回一个实数,这就是我们写成 p ( x , y ) p(x,y) p(x,y)的原因。 X X X取 x x x值的边缘概率(marginal probability)(惰性地)是指不考虑变量 Y Y Y取值的概率,写为 p ( x ) p(x) p(x)。我们写 X ∼ p ( x ) X∼p(x) X∼p(x)来表示随机变量 X X X是服从 p ( x ) p(x) p(x)分布的。只考虑实例 X = x X=x X=x的前提下,实例 Y = y Y=y Y=y的分值(fraction)(条件概率, conditional probability)写为 p ( y ∣ x ) p(y | x) p(y∣x)。

例 6.2

考虑两个随机变量

X

X

X和

Y

Y

Y,其中

X

X

X有五种可能的状态,

Y

Y

Y有三种可能的状态,如图6.2所示。

我们用 n i j n_{ij} nij表示状态 X = x i X=x_i X=xi切 Y = y j Y=y_j Y=yj的事件个数,用 N N N表示事件总数。值 c i c_i ci是第 i i i列的各个频数之和,即 c i = ∑ j = 1 3 n i j c_{i}=\sum_{j=1}^{3} n_{i j} ci=∑j=13nij。类似地,值 r j r_j rj是频数的行和,即 r j = ∑ i = 1 5 n i j r_{j}=\sum_{i=1}^{5} n_{i j} rj=∑i=15nij。利用这些定义,我们可以简洁地表示 X X X和 Y Y Y的分布。

每个随机变量的概率分布,即边缘概率,可以看作是一行或一列上概率之和

P

(

X

=

x

i

)

=

c

i

N

=

∑

j

=

1

3

n

i

j

N

P\left(X=x_{i}\right)=\frac{c_{i}}{N}=\frac{\sum_{j=1}^{3} n_{i j}}{N}

P(X=xi)=Nci=N∑j=13nij

P

(

Y

=

y

j

)

=

r

j

N

=

∑

i

=

1

5

n

i

j

N

P\left(Y=y_{j}\right)=\frac{r_{j}}{N}=\frac{\sum_{i=1}^{5} n_{i j}}{N}

P(Y=yj)=Nrj=N∑i=15nij

其中

c

i

c_i

ci和

r

j

r_j

rj分别是概率表的第

i

i

i列和第

j

j

j行。按照惯例,对于事件数有限的离散随机变量,我们假设概率之和为1,即,

∑

i

=

1

5

P

(

X

=

x

i

)

=

1

and

∑

j

=

1

3

P

(

Y

=

y

j

)

=

1

(

6.12

)

\sum_{i=1}^{5} P\left(X=x_{i}\right)=1 \quad \text { and } \quad \sum_{j=1}^{3} P\left(Y=y_{j}\right)=1\qquad(6.12)

i=1∑5P(X=xi)=1 and j=1∑3P(Y=yj)=1(6.12)

条件概率是特定单元格在行或列所占的分值。例如,给定

X

X

X,

Y

Y

Y的条件概率为:

P

(

Y

=

y

j

∣

X

=

x

i

)

=

n

i

j

c

i

P\left(Y=y_{j} \mid X=x_{i}\right)=\frac{n_{i j}}{c_{i}}

P(Y=yj∣X=xi)=cinij

给定 Y Y Y, X X X的条件概率为

P ( X = x i ∣ Y = y j ) = n i j r j P\left(X=x_{i} \mid Y=y_{j}\right)=\frac{n_{i j}}{r_{j}} P(X=xi∣Y=yj)=rjnij

在机器学习中,我们使用离散概率分布对分类变量(categorical variables)进行建模,也就是说,变量取一组有限的无序值。它们可以是分类特征,比如用于预测一个人薪水的大学学位,也可以是分类标签,比如手写数字识别的字母表。离散分布也经常被用于结合有限个连续分布构造概率模型(第11章)。

6.2.2 连续概率

在本节中,我们考虑实值随机变量,即,我们考虑的目标空间是实线

R

\mathbb{R}

R的一个区间。在这本书中,我们假设我们可以对实随机变量进行操作,就跟对有限状态的离散概率空间的操作一样。然而,这种简化假设在两种情况下并不精确:当我们无限频繁地重复某件事时,以及当我们想从一个区间中画一个点时。

第一种情况出现在我们讨论机器学习中的泛化误差时(第8章)。第二种情况出现在我们想讨论连续分布时,如高斯分布(6.5节)。

备注:

在连续空间中,还有两个额外的反直觉的技术问题。

首先,所有子集的集合(在第6.1节中用于定义事件空间

A

\mathcal{A}

A)表现得不够好。

A

\mathcal{A}

A需要被限制在补集,交集,并集下才能表现良好。

第二,如何度量集合的大小是个棘手的问题(在离散空间中可以通过计算元素个数来获得)。一个集合的大小被称为它的度量(measure)。例如,离散集的基数、

R

\mathbb{R}

R中的区间长度和

R

d

\mathbb{R}^d

Rd中的区域体积都是度量值。在集合操作下表现良好并具有另一种拓扑的集合称为Borel

σ

σ

σ-代数(Borel σ-algebra)。Betancourt详细介绍了从集合理论出发的概率空间的仔细构造,而没有陷入技术性的困境;见https://tinyurl.com/yb3t6mfd。为了更准确地构造,我们参考Billingsley(1995)和Jacod和Protter(2004)。

在本书中,我们考虑实值随机变量及其相应的Borel σ-代数。我们考虑在 R D \mathbb{R}^D RD中有值的随机变量为实值随机变量的向量。

定义 6.1 概率密度函数

函数 f : R D → R f: \mathbb{R}^{D} \rightarrow \mathbb{R} f:RD→R被称为概率密度函数(probability density function,pdf)的条件是:

1 ∀ x ∈ R D : f ( x ) ⩾ 0 \forall \boldsymbol{x} \in \mathbb{R}^{D}: f(\boldsymbol{x}) \geqslant 0 ∀x∈RD:f(x)⩾0

2 它的积分存在且:

∫

R

D

f

(

x

)

d

x

=

1

(

6.15

)

\int_{\mathbb{R}^{D}} f(\boldsymbol{x}) \mathrm{d} \boldsymbol{x}=1\qquad (6.15)

∫RDf(x)dx=1(6.15)

对于离散随机变量的概率质量函数(probability density function,pmf),可将(6.15)中的积分替换为和(6.12)。

观察到概率密度函数是任何非负的并且积分为1的函数

f

f

f。我们把随机变量

X

X

X和函数

f

f

f联系起来:

P

(

a

⩽

X

⩽

b

)

=

∫

a

b

f

(

x

)

d

x

(

6.16

)

P(a \leqslant X \leqslant b)=\int_{a}^{b} f(x) \mathrm{d} x\qquad(6.16)

P(a⩽X⩽b)=∫abf(x)dx(6.16)

其中 a , b ∈ R a,b\in\mathbb{R} a,b∈R, x ∈ R x\in \mathbb{R} x∈R为连续随机变量 X X X的结果。状态向量 x ∈ R D \boldsymbol{x} \in \mathbb{R}^{D} x∈RD则通过 x ∈ R x∈R x∈R的向量的近似定义,(6.16)这种关系称为随机变量 X X X的规律(law)或分布(distribution)。

备注:

与离散随机变量不同,连续随机变量

X

X

X取特定值

P

(

X

=

x

)

P(X = x)

P(X=x)的概率为零。这就像试图在(6.16)中指定一个a = b的区间一样。

定义 6.2 累积分布函数

状态为

x

∈

R

D

\boldsymbol{x} \in \mathbb{R}^{\mathcal{D}}

x∈RD的多元实值随机变量

X

X

X的累积分布函数(Cumulative Distribution Function,cdf)为:

F

X

(

x

)

=

P

(

X

1

⩽

x

1

,

…

,

X

D

⩽

x

D

)

F_{X}(\boldsymbol{x})=P\left(X_{1} \leqslant x_{1}, \ldots, X_{D} \leqslant x_{D}\right)

FX(x)=P(X1⩽x1,…,XD⩽xD)

其中 X = [ X 1 , … , X D ] ⊤ , x = [ x 1 , … , x D ] ⊤ X=\left[X_{1}, \ldots, X_{D}\right]^{\top}, \boldsymbol{x}=\left[x_{1}, \ldots, x_{D}\right]^{\top} X=[X1,…,XD]⊤,x=[x1,…,xD]⊤,右边表示随机变量 X i X_i Xi取小于等于 x i x_i xi的概率。

cdf也可以表示为概率密度函数

f

(

x

)

f(\boldsymbol{x})

f(x)的积分:

F

X

(

x

)

=

∫

−

∞

x

1

⋯

∫

−

∞

x

D

f

(

z

1

,

…

,

z

D

)

d

z

1

⋯

d

z

D

F_{X}(\boldsymbol{x})=\int_{-\infty}^{x_{1}} \cdots \int_{-\infty}^{x_{D}} f\left(z_{1}, \ldots, z_{D}\right) \mathrm{d} z_{1} \cdots \mathrm{d} z_{D}

FX(x)=∫−∞x1⋯∫−∞xDf(z1,…,zD)dz1⋯dzD

备注:

在讨论分布时,实际上有两个不同的概念。一个是概率密度函数(用

f

(

x

)

f(x)

f(x)表示)的概念,它是一个非负函数,求和为1。另一个是随机变量

X

X

X的分布,即随机变量

X

X

X与概率密度函数

f

(

x

)

f(x)

f(x)的关系。

在本书的大部分内容里,我们不会使用符号 f ( x ) f(x) f(x)和 F X ( x ) F_X(x) FX(x),因为我们不需要区分概率密度函数和累积分布函数 。然而,在6.7节中,我们需要对概率密度函数和 累积分布函数格外小心。

6.2.3 对比离散分布和连续分布

回想一下第6.1.2节,概率是正的,并且总概率和为1。对于离散随机变量(见(6.12)),这意味着每个状态的概率必须在区间[0,1]内。然而,对于连续随机变量,归一化(见(6.15))并不意味着概率密度的所有值都小于或等于1。我们在图6.3中用离散和连续随机变量的均匀分布(uniform distribution)来说明这一点。

图6.3(a)离散均匀分布和(b)连续均匀分布的例子。参见示例6.3了解分布的详细信息。

例 6.3

我们考虑两个均匀分布的例子,其中每种状态发生的可能性相等。这个例子说明了离散和连续概率分布之间的一些区别。

设

Z

Z

Z为离散均匀随机变量,具有三个状态

{

z

=

−

1.1

,

z

=

0.3

,

z

=

1.5

}

\{z =−1.1,z = 0.3, z = 1.5\}

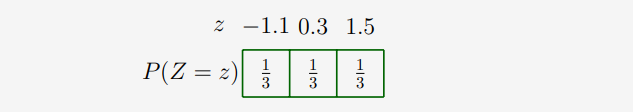

{z=−1.1,z=0.3,z=1.5}(这些状态的实际值在这里没有实际的意义)。概率质量函数可以表示为概率值表:

或者,我们可以把它看作一个图形(图6.3(a)),我们用

x

x

x轴表示状态,而

y

y

y轴代表特定状态的概率。图6.3(a)中的

y

y

y轴被故意扩展,以便与图6.3(b)对比。

设

X

X

X是一个连续随机变量,取值范围为

0.9

≤

X

≤

1.6

0.9\le X\le 1.6

0.9≤X≤1.6,如图6.3(b)所示。可以观察到密度的高度可以大于1。然而,它需要保证:

∫

0.9

1.6

p

(

x

)

d

x

=

1

\int_{0.9}^{1.6} p(x) \mathrm{d} x=1

∫0.91.6p(x)dx=1

备注:

关于离散概率分布还有一个微妙之处。状态 z 1 , … , z d z_1,…, z_d z1,…,zd通常无法比较,例如 z 1 = 红 色 , z 2 = 绿 色 , z 3 = 蓝 色 z_1 =红色,z_2 =绿色,z_3 =蓝色 z1=红色,z2=绿色,z3=蓝色。然而,在许多机器学习应用中,离散状态可以数值化,例如 z 1 = − 1.1 , z 2 = 0.3 , z 3 = 1.5 z_1 =−1.1,z_2 = 0.3, z_3 = 1.5 z1=−1.1,z2=0.3,z3=1.5,我们可以说 z 1 < z 2 < z 3 z_1 < z_2 < z_3 z1<z2<z3。离散状态数值化特别有用,因为我们经常需要考虑随机变量的期望值(第6.4.1节)。

不幸的是,机器学习许多相关文献使用的符号和术语隐藏了样本空间 Ω Ω Ω、目标空间 T \mathcal{T} T和随机变量 X X X之间的区别。对于随机变量 X X X的一组可能结果的值 x x x,即 x ∈ T x∈\mathcal{T} x∈T, p ( x ) p(x) p(x)表示随机变量 X X X为结果 x x x的概率。对于离散随机变量,这表示为 p ( X = x ) p(X=x) p(X=x),这称为概率质量函数。概率质量函数通常被称为“分布”。对于连续变量, p ( x ) p(x) p(x)称为概率密度函数(通常称为密度),而累积分布函数 P ( x ≤ X ) P(x\le X) P(x≤X)通常也被称为“分布”。在本章中,我们将使用符号 X X X来表示一元和多元随机变量,并分别用 x x x和 x \boldsymbol{x} x表示状态。我们在表6.1中总结了术语。

表 6.1 概率分布的术语。

| 类型 | “点的概率” | “积分的概率” |

|---|---|---|

| 离散 | P ( X = x ) P(X=x) P(X=x),概率质量函数 | 不适用 |

| 连续 | p ( x ) p(x) p(x),概率密度函数 | P ( X ≤ x ) P(X\le x) P(X≤x) , 累积分布函数 |

备注:

我们用“概率分布”表达离散的概率质量函数以及连续的概率密度函数,尽管这在技术上是不正确的。与大多数机器学习文献一样,我们也依赖上下文来区分“概率分布”这个短语的不同用法。

6.3 加法法则、乘法法则和贝叶斯定理

我们把概率论看作是逻辑推理的延伸。正如我们在第6.1.1节中讨论的,这里提出的概率规则自然地从满足(Jaynes, 2003,第2章)的要求。概率建模(第8.4节)为设计机器学习方法提供了一个原则基础。一旦我们定义了对应于数据和问题的不确定性的概率分布(第6.2节),可以发现分布有两个基本法则, 加法法则和乘法法则。

回想(6.9)中的 p ( x , y ) p(\boldsymbol{x},\boldsymbol{y}) p(x,y)是两个随机变量 x \boldsymbol{x} x, y \boldsymbol{y} y的联合分布。分布 p ( x ) p(\boldsymbol{x}) p(x)和 p ( y ) p(\boldsymbol{y}) p(y)是相应的边缘分布, p ( y ∣ x ) p(\boldsymbol{y} | \boldsymbol{x}) p(y∣x)是给定 x \boldsymbol{x} x, y \boldsymbol{y} y的条件分布。给定第6.2节中离散和连续随机变量的边缘概率和条件概率的定义,我们现在可以给出概率论中的两个基本法则。

第一个法则,是求和法则(sum rule):

p ( x ) = { ∑ y ∈ Y p ( x , y ) 如果 y 是离散的 ∫ Y p ( x , y ) d y 如果 y 是连续的 p(\boldsymbol{x})=\left\{\begin{array}{ll}\sum_{\boldsymbol{y} \in \mathcal{Y}} p(\boldsymbol{x}, \boldsymbol{y}) & \text { 如果 } \boldsymbol{y} \text { 是离散的 } \\\int_{\mathcal{Y}} p(\boldsymbol{x}, \boldsymbol{y}) \mathrm{d} \boldsymbol{y} & \text { 如果 } \boldsymbol{y} \text { 是连续的 }\end{array}\right. p(x)={∑y∈Yp(x,y)∫Yp(x,y)dy 如果 y 是离散的 如果 y 是连续的

其中

Y

\mathcal{Y}

Y是随机变量

Y

Y

Y目标空间的状态。这意味着我们对随机变量

Y

Y

Y的状态集

y

\boldsymbol{y}

y求和(或积分)。求和法则也被称为边缘化属性(marginalization property)。求和法则将联合分布与边缘分布联系了起来。一般来说,当联合分布包含两个以上的随机变量时,求和法则可以应用于随机变量的任何子集,从而产生可能不止一个随机变量的边缘分布。更具体地说,如果

x

=

[

x

1

,

…

,

x

D

]

⊤

\boldsymbol{x}=\left[x_{1}, \ldots, x_{D}\right]^{\top}

x=[x1,…,xD]⊤,我们得到

p

(

x

i

)

=

∫

p

(

x

1

,

…

,

x

D

)

d

x

\

i

p\left(x_{i}\right)=\int p\left(x_{1}, \ldots, x_{D}\right) \mathrm{d} \boldsymbol{x}_{\backslash i}

p(xi)=∫p(x1,…,xD)dx\i

通过反复应用加法法则,除

x

i

x_i

xi外,我们可以积分/求和出所有随机变量的概率。

\

i

\backslash i

\i表示“除

i

i

i以外的所有”

备注:

概率建模的许多计算困难都是由于应用了求和法则。当有许多变量或具有许多状态的离散变量时,求和法则执行的是高维求和或积分。执行高维求和或积分通常是难以计算,因为没有已知的多项式时间(polynomial-time)算法来精确计算它们。

第二个规则称为乘法法则(product rule),它将联合分布与条件分布联系起来:

p

(

x

,

y

)

=

p

(

y

∣

x

)

p

(

x

)

(

6.22

)

p(\boldsymbol{x}, \boldsymbol{y})=p(\boldsymbol{y} \mid \boldsymbol{x}) p(\boldsymbol{x})\qquad (6.22)

p(x,y)=p(y∣x)p(x)(6.22)

乘积法则可以解释为两个随机变量的联合分布能被因子分解(乘积形式)为其他两个分布。这两个因子分别是:第一个随机变量的边缘分布 p ( x ) p(\boldsymbol{x}) p(x),以及给定第一个随机变量,第二个随机变量的条件分布 p ( y ∣ x ) p(\boldsymbol{y} | \boldsymbol{x}) p(y∣x)。 p ( x , y ) p(\boldsymbol{x},\boldsymbol{y}) p(x,y)中随机变量的顺序是任意的,这意味着 p ( x , y ) = p ( x ∣ y ) p ( y ) p(\boldsymbol{x},\boldsymbol{y})=p(\boldsymbol{x} | \boldsymbol{y})p(\boldsymbol{y}) p(x,y)=p(x∣y)p(y)。准确地说,(6.22)表示为离散随机变量的概率质量函数。对于连续随机变量,乘积规则用概率密度函数(第6.2.3节)表示。

在机器学习和贝叶斯统计中,如果我们观察到部分随机变量,我们通常会对未观察到的(潜在的)随机变量的推断感兴趣。假设我们有一些关于未观测随机变量

x

\boldsymbol{x}

x的先验(prior)知识

p

(

x

)

p(\boldsymbol{x})

p(x),并且们可以观察到

x

\boldsymbol{x}

x和第二个随机变量

y

\boldsymbol{y}

y之间的关系

p

(

y

∣

x

)

p(\boldsymbol{y} | \boldsymbol{x})

p(y∣x)。那么如果我们观察到

y

\boldsymbol{y}

y,我们就可以利用贝叶斯定理,在

y

\boldsymbol{y}

y的观测值前提下,得出

x

\boldsymbol{x}

x的一些结论。贝叶斯定理(也叫贝叶斯法则或贝叶斯定律)

p

(

x

∣

y

)

⏟

后验

=

p

(

y

∣

x

)

⏞

似然

p

(

x

)

⏞

先验

p

(

y

)

⏟

证据

(

6.23

)

\underbrace{p(\boldsymbol{x} \mid \boldsymbol{y})}_{\text {后验}}=\frac{\overbrace{p(\boldsymbol{y} \mid \boldsymbol{x})}^{\text {似然 }} \overbrace{p(\boldsymbol{x})}^{\text {先验 }}}{\underbrace{p(\boldsymbol{y})}_{\text {证据}}}\qquad (6.23)

后验

p(x∣y)=证据

p(y)p(y∣x)

似然 p(x)

先验 (6.23)

是(6.22)中的乘法规则直接得到的,因为

p

(

x

,

y

)

=

p

(

x

∣

y

)

p

(

y

)

p(\boldsymbol{x}, \boldsymbol{y})=p(\boldsymbol{x} \mid \boldsymbol{y}) p(\boldsymbol{y})

p(x,y)=p(x∣y)p(y)

且:

p

(

x

,

y

)

=

p

(

y

∣

x

)

p

(

x

)

p(\boldsymbol{x}, \boldsymbol{y})=p(\boldsymbol{y} \mid \boldsymbol{x}) p(\boldsymbol{x})

p(x,y)=p(y∣x)p(x)

所以:

p

(

x

∣

y

)

p

(

y

)

=

p

(

y

∣

x

)

p

(

x

)

⟺

p

(

x

∣

y

)

=

p

(

y

∣

x

)

p

(

x

)

p

(

y

)

p(\boldsymbol{x} \mid \boldsymbol{y}) p(\boldsymbol{y})=p(\boldsymbol{y} \mid \boldsymbol{x}) p(\boldsymbol{x}) \Longleftrightarrow p(\boldsymbol{x} \mid \boldsymbol{y})=\frac{p(\boldsymbol{y} \mid \boldsymbol{x}) p(\boldsymbol{x})}{p(\boldsymbol{y})}

p(x∣y)p(y)=p(y∣x)p(x)⟺p(x∣y)=p(y)p(y∣x)p(x)

在(6.23)中, p ( x ) p(x) p(x)是先验(prior),它是我们在观察到任何数据之前对未观察到(潜在)的变量 x \boldsymbol{x} x的主观先验知识。我们可以选择任何对我们有意义的先验,但关键是要确保先验在所有可能的 x \boldsymbol{x} x上有一个非零的概率密度函数(或概率质量函数),即使 x \boldsymbol{x} x非常罕见。

似然(likelihood,有时也被称为“测量模型”。) p ( y ∣ x ) p (\boldsymbol{y} | \boldsymbol{x}) p(y∣x)描述了 x \boldsymbol{x} x和 y \boldsymbol{y} y是如何相关的,对于离散概率分布,它是已知潜在变量 x \boldsymbol{x} x前提下,数据 y \boldsymbol{y} y的概率。注意,似然 p ( y ∣ x ) p (\boldsymbol{y} | \boldsymbol{x}) p(y∣x)不是 x \boldsymbol{x} x的分布,而是 y \boldsymbol{y} y的分布。并且我们称 p ( y ∣ x ) p (\boldsymbol{y}| \boldsymbol{x}) p(y∣x)为“ x \boldsymbol{x} x的似然 (给定 y \boldsymbol{y} y)”或“给定 x \boldsymbol{x} x, y \boldsymbol{y} y的概率”,但不是 y \boldsymbol{y} y的似然 (MacKay, 2003).

后验(posterior) p ( x ∣ y ) p(\boldsymbol{x} | \boldsymbol{y}) p(x∣y)是贝叶斯统计中感兴趣的量,因为它准确地表达了我们感兴趣的东西,即我们在观察到 y \boldsymbol{y} y后对 x \boldsymbol{x} x的认知。

p ( y ) : = ∫ p ( y ∣ x ) p ( x ) d x = E X [ p ( y ∣ x ) ] ( 6.27 ) p(\boldsymbol{y}):=\int p(\boldsymbol{y} \mid \boldsymbol{x}) p(\boldsymbol{x}) \mathrm{d} \boldsymbol{x}=\mathbb{E}_{X}[p(\boldsymbol{y} \mid \boldsymbol{x})]\qquad (6.27) p(y):=∫p(y∣x)p(x)dx=EX[p(y∣x)](6.27)

是边缘似然/证据(marginal likelihood/evidence)。

(6.27)的右边使用我们在第6.4.1节中定义的期望操作符。根据定义,边缘似然是(6.23)贝叶斯公式的分子对潜在变量

x

\boldsymbol{x}

x的积分。因此,边缘似然与

x

\boldsymbol{x}

x无关,它保证了后验

p

(

x

∣

y

)

p(\boldsymbol{x} | \boldsymbol{y})

p(x∣y)被标准化。边缘似然也可以解释为期望似然,关于先验

p

(

x

)

p(\boldsymbol{x})

p(x)的期望。除了用于后验标准化之外,边缘似然在贝叶斯模型选择中也起着重要作用,我们将在第8.6节中讨论。由于(8.44)中的积分,证据(evidence)通常很难计算。

贝叶斯定理(6.23)允许我们反转由似然给出的 x \boldsymbol{x} x和 y \boldsymbol{y} y之间的关系。因此,贝叶斯定理有时也被称为概率逆(probabilistic inverse.)。我们将在8.4节进一步讨论贝叶斯定理。

备注:

在贝叶斯统计中,后验分布是我们感兴趣的量,因为它包含了所有来自先验和数据的可用信息。我们把重点放在后验的一些统计量上,例如后验的最大值,这将在8.3节中讨论。然而,只关注后验的统计量会导致信息的丢失。如果我们在更大的背景下思考,那么后验还可以在决策系统中使用。拥有完整的后验非常有用,它可以得到对干扰具有鲁棒性的决策。例如,在基于模型的强化学习中,Deisenroth等人(2015)表明,使用似然转移函数的完全后验分布可以非常快速(数据/样本高效)学习,而关注最大的后验则会导致一致性失败。因此,拥有完整的后验对于下游任务非常有用。在第9章中,我们将在线性回归的背景下继续这个讨论。

翻译自:

《MATHEMATICS FOR MACHINE LEARNING》作者是 Marc Peter Deisenroth,A Aldo Faisal 和 Cheng Soon Ong

公众号后台回复【m4ml】即可获取这本书。

2545

2545

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?