目前,通过互联网上的数据训练生成模型可以产生非常逼真的文本、图像和视频。如果生成模型能够模拟真实世界中的各种行为,比如驾驶汽车、准备饭菜等,人类就能够与不同场景和物体进行“互动”,机器人也能从模拟经验中学习而不会带来物理损伤的风险。此外,模拟的“真实世界”数据还可以用来训练其他类型的人工智能。最近,加州大学伯克利分校、谷歌DeepMind以及麻省理工学院的研究人员提出了一种名为UniSim的真实世界模拟器,它能够模拟人类和机器人长期交互时所处的视角。这种模拟器可用于训练和评估机器人在真实世界中进行交互时所具有的能力。

论文地址:https://openreview.net/pdf?id=sFyTZEqmUY

1.学习一个可交互的真实世界模拟器

真实世界中的模拟器是一个模型,在给定一些世界状态(如图像帧)时,能够接受某些动作输入,并产生相应视觉效果(以视频形式)。学习这样的模拟器很困难,因为不同类型的动作具有不同格式(如语言指令、机器人控制、摄像头移动),同时视频也具有不同帧率。

针对上述问题,作者提出了特定策略来处理各种类型数据, 使得能够统一各种格式和对齐可变长度视频和相应操作。通过通用接口关联操作和视频, 可以训练条件生成模型, 从而整合跨数据集信息。

在本文中,作者使用了多个数据集,包括模拟执行和渲染、真实机器人数据、人类活动视频、全景扫描和互联网文本-图像数据。并且使用T5语言模型嵌入,将文本标记处理为连续表示,并与低级动作(如机器人控制)连接起来。这样就形成了模拟器的最终统一动作空间。

接下来,作者介绍了通过观察预测来模拟长期互动的方法。他们使用了不同环境中的观察转换成的视频和不同格式的动作转换成的连续嵌入来构建一个通用的模拟器。作者将这个通用模拟器定义为一个观察预测模型,它根据动作和先前的观察来预测观察结果。通过这个模型,可以模拟与许多真实世界环境的互动。作者还指出,这个观察预测模型可以使用视频扩散来参数化。通过这种方法,模拟器可以在所有任务中保持一致,并且可以与任何奖励函数结合使用。通过学习奖励函数,可以优化策略,并使用现有的决策制定算法(如规划和强化学习)来训练RL代理和视觉语言模型(VLM)。

如图下所示,UniSim是一个视频扩散模型,通过给定过去的观察和上一个动作输入,来预测下一个的观察帧集合。UniSim可以处理各种模态的时间扩展动作,例如运动控制(∆x1,∆ω1,∆x2,…),语言描述(“擦桌子”),以及从相机运动和其他来源提取的动作。每个虚线箭头表示将下一个视频段的初始噪声样本与前一帧进行连接。

2.模拟真实世界交互

作者展示了UniSim可以支持的丰富的操作模拟,包括从相同的初始帧开始进行不同的厨房任务(左上方),按下不同的开关(右上方)或者导航场景(底部)。可以通过自然语言指令来完成以上操作,例如“切胡萝卜”、“洗手”和“拿起碗”。这些模拟操作可以在同一个初始帧中进行,并且可以根据不同的指令进行不同的操作。

随后介绍了长期视角模拟的示例。他们展示了8个连续的交互示例,通过在每个交互中结合先前的观察和新的语言指令来进行模拟。UniSim成功地保留了之前指令中操作的物体,这些示例展示了UniSim在模拟长期视角交互方面的能力。

UniSim是一个可以支持高度多样化和随机性的模拟器,如下图,在移除上面的毛巾后会出现不同的物体,物体的颜色和位置也会不同,摄像机角度也会发生变化。扩散模型的灵活性促进了高度随机的环境模拟,这些环境无法通过操作来控制,因此策略可以学习仅控制可控部分。

为了进一步了解他们提出的UniSim模型的性能和特点,他们进行了一些消融实验,以评估模型在不同条件下的表现。首先,他们比较了UniSim在不同数量的过去帧条件下的性能。

作者通过比较FVD、FID、Inception score和CLIP score这些指标,结果发现,相比于单个帧的条件,使用4个帧的条件效果更好。

在UniSim的训练过程中,作者发现简单地将不同大小的数据集组合在一起可能会导致低数据领域生成质量低下。他们发现将领域标识符(例如数据集的名称)附加到被条件化的动作上可以提高低数据领域的生成质量。下图是通过在语言动作前加上数据集标识符,可以得到的视频样本(上)。

尽管这种领域标识符可以提高生成质量,但特定领域的标识符会对其他领域的泛化能力产生负面影响,因此只有在测试领域与训练领域的分布相同的情况下才应用这种标识符。

3.UniSim的应用

目前,语言模型和视觉语言模型(VLM)被用作可以在基于图像或文本的观察和行动空间中操作的策略。学习这样的代理的一个主要挑战在于需要大量的语言行动标签。随着任务的增加,数据收集的强度也会增加。使用UniSim可以通过事后重标记生成大量用于VLM策略训练的训练数据。

此外,作者定义了减少到目标距离(RDG)指标来衡量距离的减少程度。如下表所示,使用生成的长期视角数据训练的VLM策略在完成长期视角目标任务时比使用原始数据表现出3-4倍的性能提升。表明了通过使用模拟器生成的数据进行训练,VLM策略在处理复杂任务时能够更好地减小与目标之间的距离。

接着,作者接着探讨了通过提供一个可以并行访问的真实环境模拟器,来实现强化学习代理的有效训练的可行性。

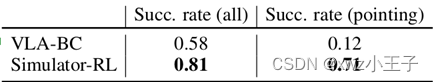

如下表所示,通过使用VLA策略生成的控制动作,在模拟器中进行模型驱动的推演。强化学习训练显著提高了VLA策略在各种任务中的性能。

之后,作者直接将在模拟器中训练的强化学习策略应用于真实机器人,并成功完成了任务。

UniSim还是可以作为生成训练数据的模拟器,用于收集难以收集的数据,比如犯罪或事故的录像。

作者通过使用UniSim生成的数据来训练视觉语言模型,并在视频字幕生成任务中观察到了显著的性能提升。这意味着UniSim可以作为一个有效的数据生成器,用于改进更广泛的视觉语言模型。

- UniSim的局限性与结论

UniSim可以模拟真实的视觉体验,用于与人类互动和训练自主代理。然而,模拟器存在一些限制需要未来的工作来解决: - 幻觉:当给定的动作与场景不符合时,UniSim会出现幻觉,例如将桌子变成水槽或将视角从桌面机器人转向水槽。作者希望UniSim能够检测到无法模拟的动作,而不是产生不现实的结果。

- 有限的记忆:UniSim只能根据最近几帧的历史来生成模拟结果,无法捕捉长期记忆。这表明如果将苹果放在抽屉里是发生在很久之前,当打开抽屉时,苹果可能会消失。UniSim需要多少历史记录取决于应用本身的需要(例如应用与近似马尔可夫条件下的学习,或者需要长期记忆的问题回答)。

- 有限的领域外泛化能力:UniSim在训练数据中主要针对4种机器人形态进行训练,对于未见过的机器人的泛化能力有限。进一步扩大训练数据规模可能有助于改善这一问题,因为目前的训练数据远远不及互联网上所有的视频数据。

- 仅限于视觉模拟:UniSim不适用于一些动作不会造成视觉上变化的环境(例如在抓取静态杯子时施加不同的力)。一个真正的通用模拟器应该能够捕捉到世界的所有方面(例如声音、感官等),而不仅仅是视觉体验方面。

252

252

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?