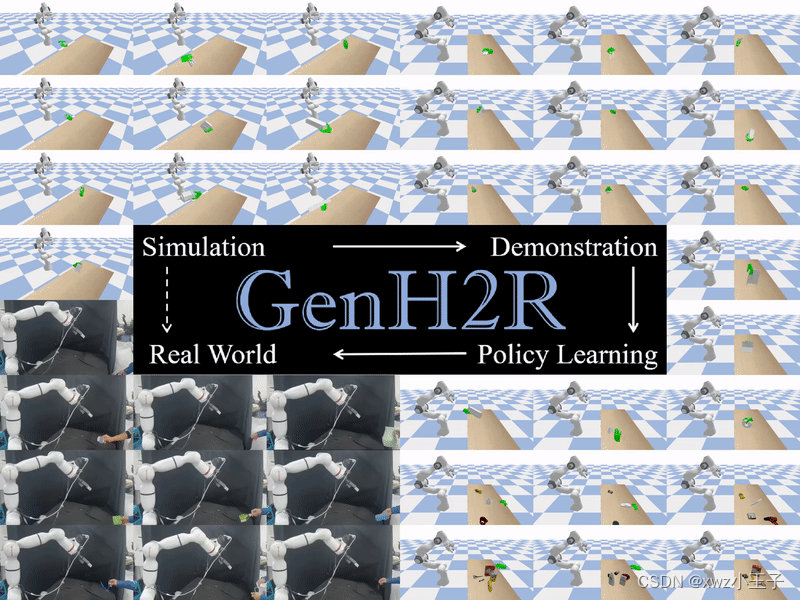

在最新的CVPR论文《GenH2R: Learning Generalizable Human-to-Robot Handover via Scalable Simulation, Demonstration, and Imitation》中,来自清华大学3DVICI Lab的弋力助理教授团队提出了「GenH2R」框架,一个可泛化人机交互(Human-Robot Interaction)技能学习方案。它能帮助机器人学习通用的与人交接物体的技能,面对任何物体、任何人类抓取方式与交接运动方式,都能够可靠完成交接任务。

该方案不需要依赖任何真实示例数据,完全借助大规模合成数据赋能机器人。通过多样化的虚拟人递物行为仿真、自动化机器人示例生成、大规模4D模仿学习,此方案极大突破了现有方法的性能上限与泛化性,在各种测试集上的成功率都有至少10%的提升。

背景介绍

随着具身智能(Embodied AI)时代的来临,我们期待智能体能主动与环境进行交互。在这个过程中,让机器人融入人类生活环境、与人类进行交互(Human Robot Interaction)变得至关重要。我们需要思考如何理解人类的行为和意图,以最符合人类期望的方式满足其需求,将人类放在具身智能的中心(Human-Centered Embodied AI)。其中一个关键的技能是可泛化的人机交接[1,2,3](Generalizable Human-to-Robot Handover),它使机器人能够更好地与人类合作,完成各种日常通用任务,如烹饪、居室整理和家具组装等。

大模型的火爆发展预示着海量高质量数据+大规模学习是走向通用智能的一种可能方式[4,5,6],那么能否通过海量机器人数据与大规模策略模仿获取通用人机交接技能?然而,若考虑在现实世界中让机器人与人类进行大规模交互学习是危险且昂贵的,机器很有可能会伤害到人类:

而在仿真环境中(Simulation)进行训练,用人物仿真和动态抓取运动规划来自动化提供海量多样的机器人学习数据[7,8,9,10,11],然后将其部署到真实机器人上(Sim-to-Real Transfer),是一种更可靠的基于学习的方法,可以大大拓展机器人与人协作交互的能力。

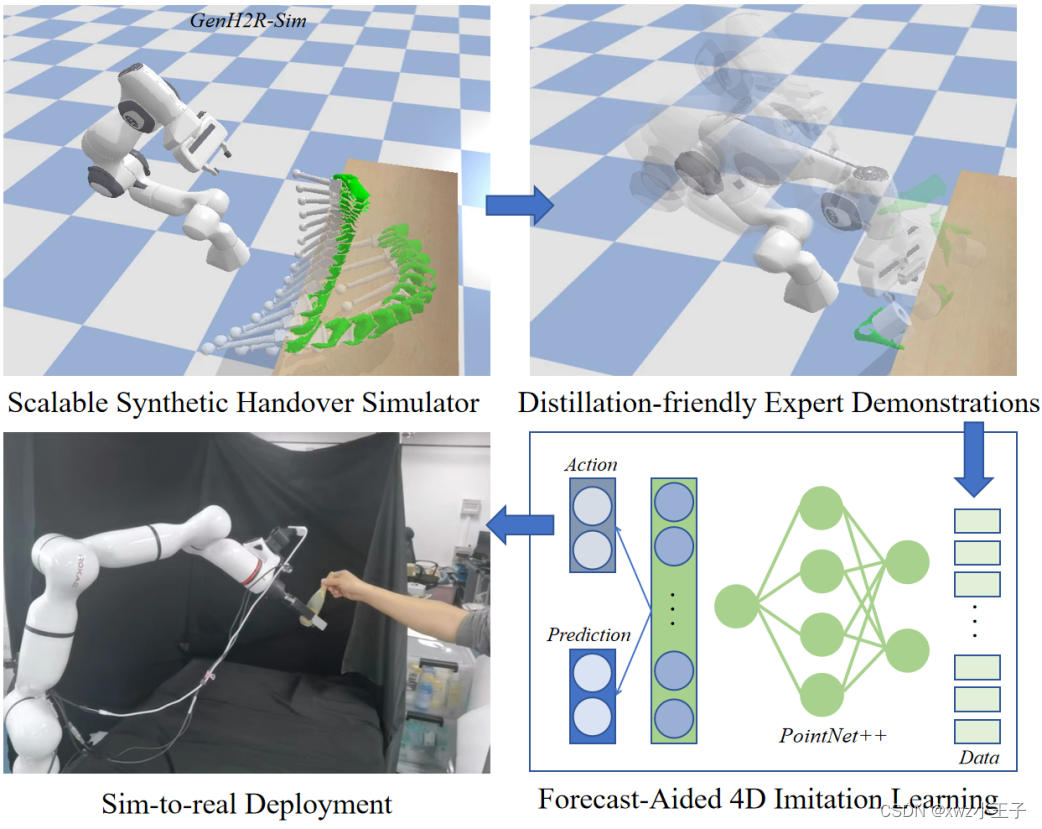

因此,「GenH2R」框架被提出,分别从仿真(Simulation),示例(Demonstration),模仿(Imitation)三个角度出发,让机器人第一次基于端到端的方式学习对任意抓取方式、任意交接轨迹、任意物体几何的通用交接:1)在「GenH2R-Sim」环境中提供了百万级别的易于生成的各种复杂仿真交接场景,2)引入一套自动化的基于视觉-动作协同的专家示例(Expert Demonstrations)生成流程,3)使用基于4D信息和预测辅助(点云+时间)的模仿学习(Imitation Learning)方法。

相比于SOTA方法(CVPR2023 Highlight)[12],GenH2R的方法在各种测试集上平均成功率提升14%,并在真机实验中取得更加鲁棒的效果。

论文地址:https://arxiv.org/pdf/2401.00929.pdf

论文主页:https://GenH2R.github.io (点击文末“阅读原文”可跳转至论文主页)

论文视频:https://www.youtube.com/watch?v=BbphK5QlS1Y

方法介绍

A.仿真环境(GenH2R-Sim)

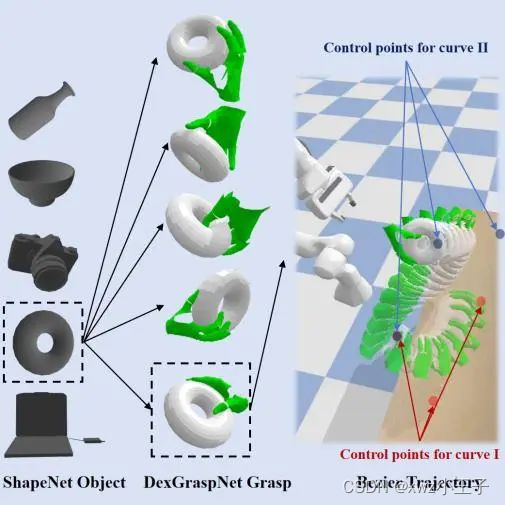

为了生成高质量、大规模的人手-物体数据集,GenH2R-Sim环境从抓取姿势和运动轨迹两方面对场景建模。

在抓取姿势方面,GenH2R-Sim从ShapeNet[13]中引入了丰富的3D物体模型,从中挑选出3266个适合交接的日常物体,使用灵巧抓取的生成方法(DexGraspNet[14]),总共生成了100万个人手抓住物体的场景。在运动轨迹方面,GenH2R-Sim使用若干控制点生成多段光滑的Bézier曲线,并引入人手和物体的旋转,模拟出手递物体的各种复杂运动轨迹。

GenH2R-Sim的100万场景中,不仅在运动轨迹(1千 vs 100万)、物体数量(20 vs 3266)两方面远超之前最新工作,此外,还引入了接近真实情境的互动信息(如机械臂足够靠近物体时,人会配合停止运动,等待完成交接),而非简单的轨迹播放。尽管仿真生成的数据不能完全逼真,但实验结果表明,相比小规模的真实数据,大规模的仿真数据更有助于学习。

B.大规模生成利于蒸馏的专家示例

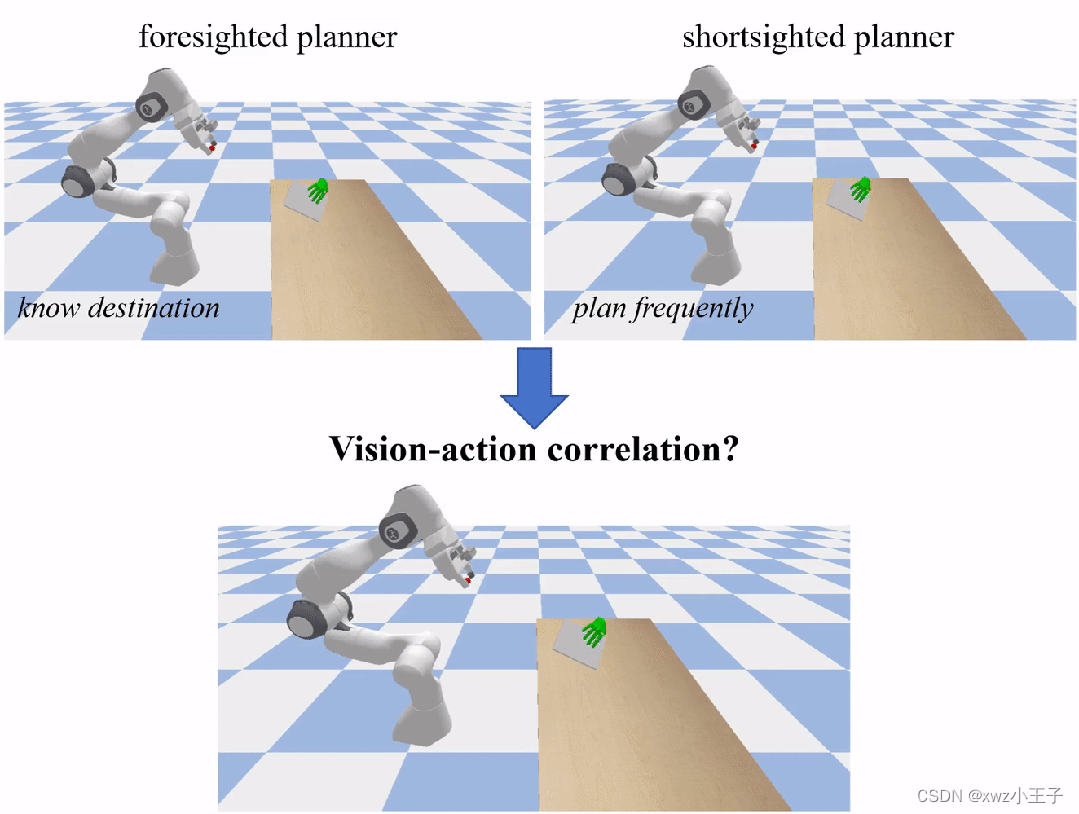

基于大规模的人手和物体运动轨迹数据,GenH2R自动化地生成了大量专家示例。GenH2R寻求的“专家”是经过改进后的Motion Planner(如OMG Planner[15]),这些方法是非学习、基于控制优化的,不依赖于视觉的点云,往往需要一些场景状态(比如物体的目标抓取位置)。为了确保后续的视觉策略网络能够蒸馏出有益于学习的信息,关键在于确保“专家”提供的示例具有视觉-动作相关性(Vision-action correlation)。规划时如果知道最后落点,那么机械臂可以忽略视觉而直接规划到最终位置“守株待兔”,这样可能会导致机器人的相机无法看到物体,这种示例对于下游的视觉策略网络并没有任何帮助;而如果频繁地根据物体位置进行重新规划,可能会导致机械臂动作不连续,出现奇怪的形态,无法完成合理的抓取。

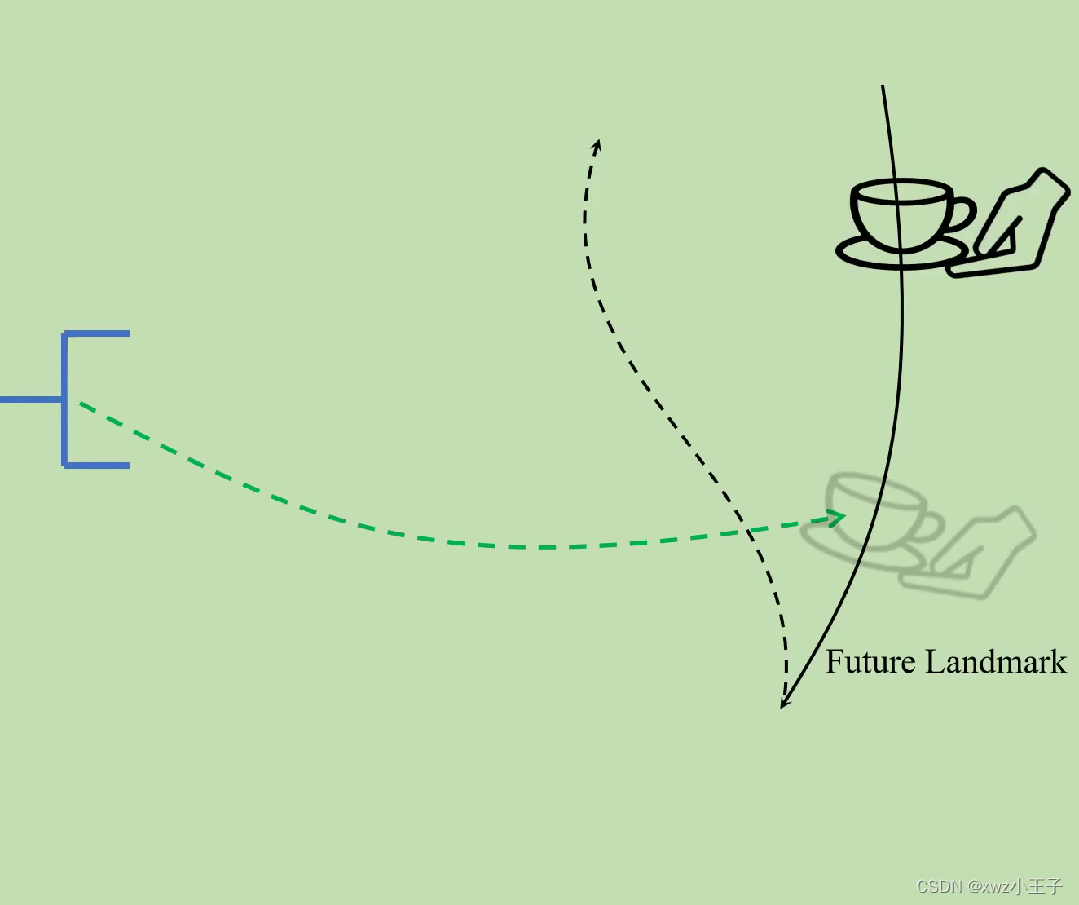

为了生成出利于蒸馏(Distillation-friendly)的专家示例,GenH2R引入了Landmark Planning。人手的运动轨迹会按照轨迹光滑程度和距离被分成多段,以Landmark作为分割标记。在每一段中,人手轨迹是光滑的,专家方法会朝着Landmark点进行规划。这种方法可以同时保证视觉-动作相关性和动作连续性。

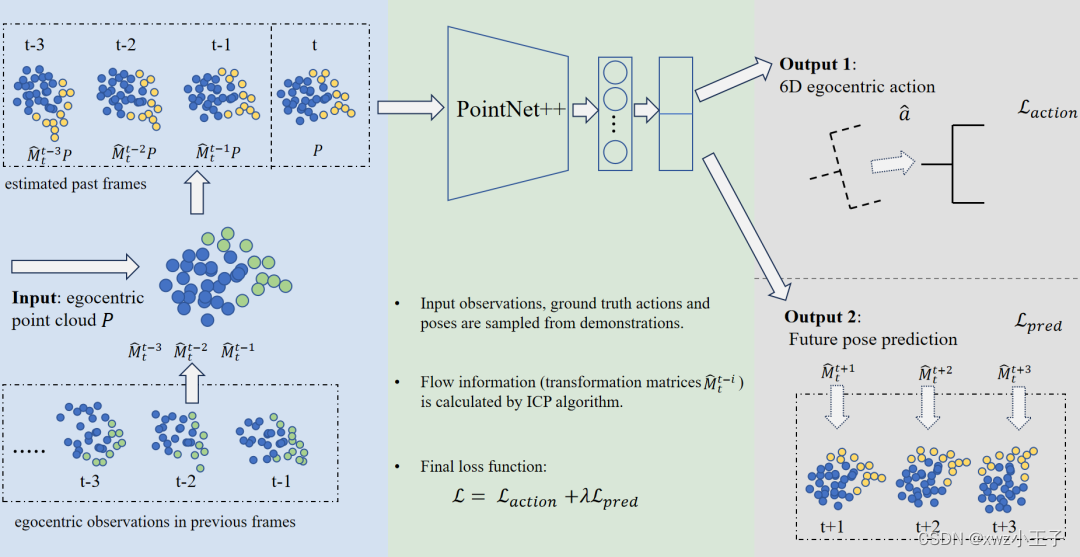

C.以预测为辅助的4D模仿学习网络

基于大规模专家示例,GenH2R使用模仿学习的方法,构建4D策略网络,对观察到的时序点云信息进行几何和运动的分解。对于每一帧点云,通过迭代最近点算法(Iterative Closest Point)计算和上一帧点云之间的位姿变换,以估计出每个点的流(flow)信息,使得每一帧点云都具有运动特征。接着,使用PointNet++[16]对每一帧点云编码,最后不仅解码出最终需要的6D egocentric动作,还会额外输出一个物体未来位姿的预测,增强策略网络对未来手和物体运动的预测能力。

不同于更加复杂的4D Backbone(例如Transformer-based),这种网络架构的推理速度很快,更适用于交接物体这种需要低延时的人机交互场景,同时它也能有效地利用时序信息,做到了简单性和有效性的平衡。

实验

A.仿真环境实验

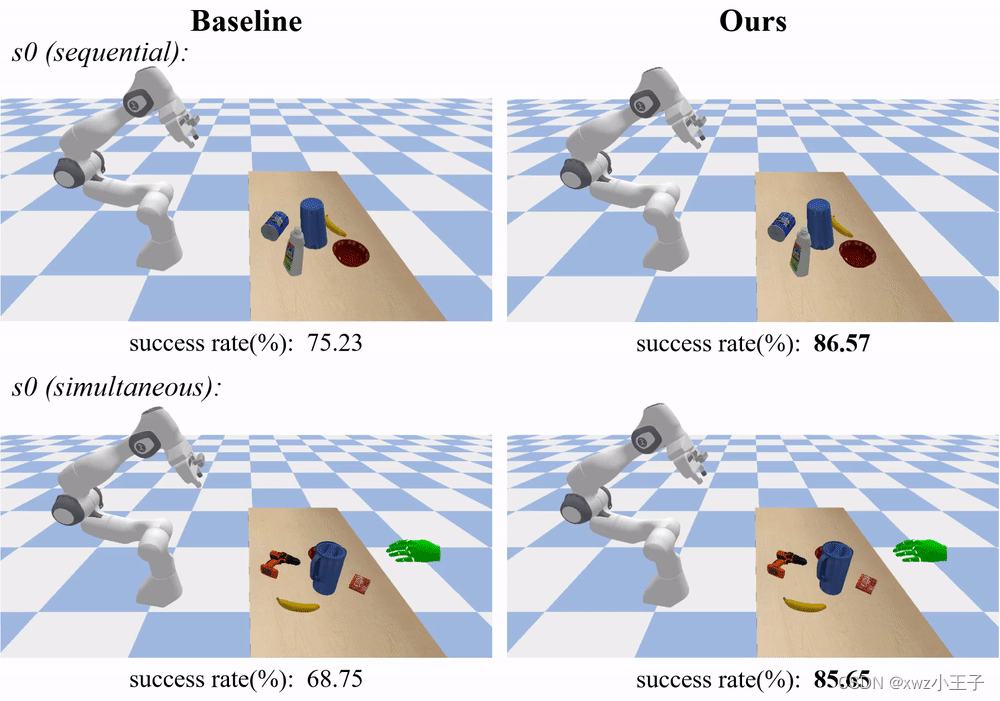

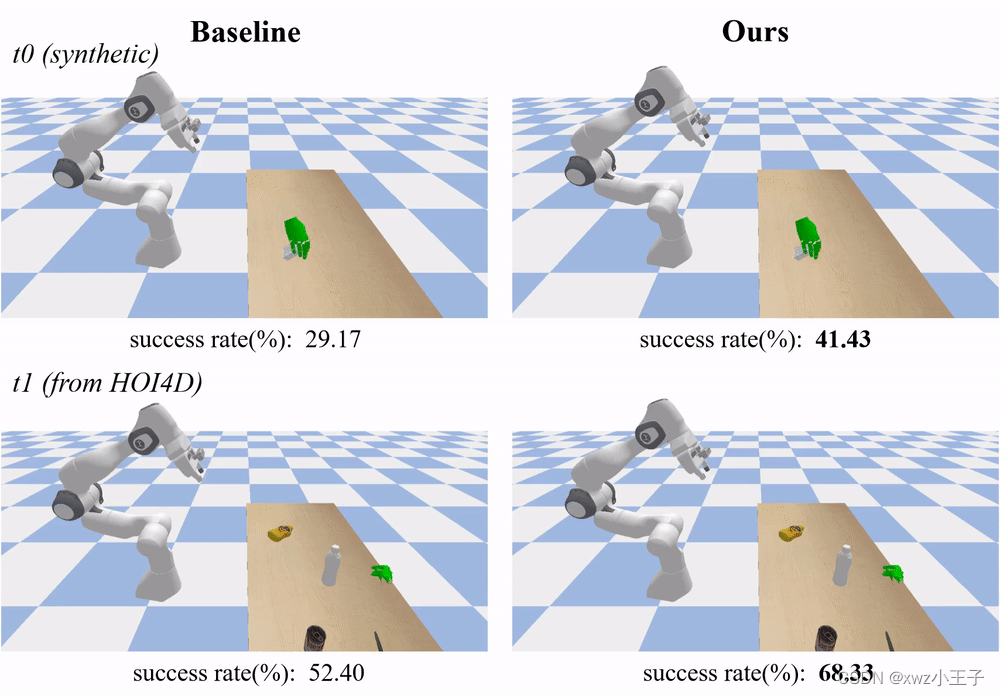

GenH2R和SOTA方法进行了各种设定下的比较,相比于使用小规模真实数据训练的方法,在GenH2R-Sim中使用大规模仿真数据进行训练的方法,可以取得显著的优势(在各种测试集上成功率平均提升14%)。

在真实数据测试集s0中,GenH2R的方法可以成功交接更复杂的物体,并且能够提前调整姿势,避免在夹爪靠近物体时再频繁进行姿势调整:

在仿真数据测试集t0(GenH2R-Sim引入)中,GenH2R的方法可以能够预测物体的未来姿势,以实现更加合理的接近轨迹:

在真实数据测试集t1(GenH2R-Sim从HOI4D引入,比之前工作的s0测试集增大约7倍)中,GenH2R的方法可以泛化到没有见过的、具有不同几何形状的真实世界物体。

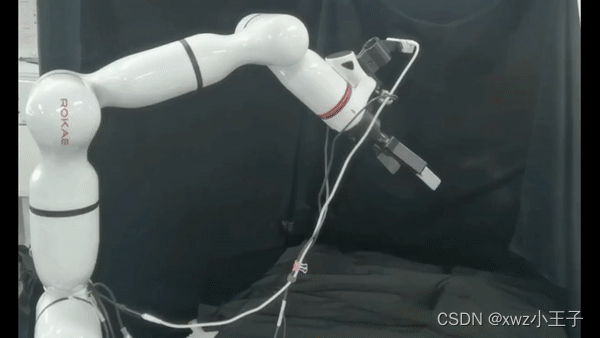

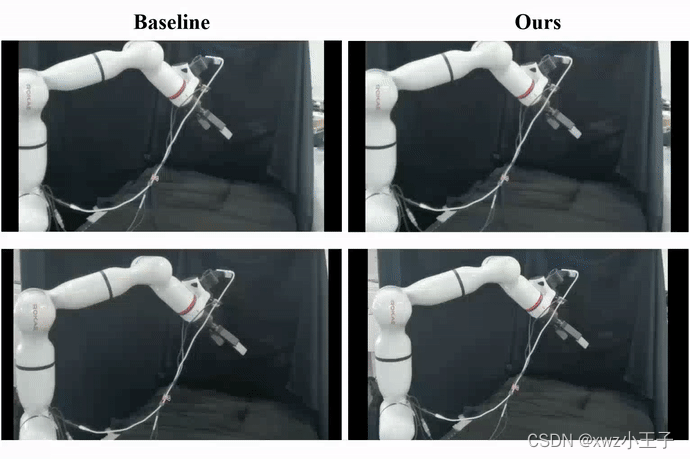

B.真机实验

GenH2R同时将学到的策略部署到现实世界中的机械臂上,完成“sim-to-real“的跳跃。

对于更复杂的运动轨迹(例如旋转),GenH2R的策略展示出更强的适应能力;对于更复杂的几何,GenH2R的方法更可以展现出更强的泛化性:

GenH2R完成了对于各种交接物体的真机测试以及用户调研,展示出很强的鲁棒性。

总结与展望

「GenH2R」框架分别从Simulation, Demonstration, Imitation三个角度出发,让机器人第一次基于端到端的方式学习对任意抓取方式、任意交接轨迹、任意物体几何的通用交接。GenH2R-Sim提供了百万级别的易于生成的各种复杂仿真交接场景,引入一套自动化的基于视觉-动作协同的专家示例生成流程,并使用基于4D信息和预测辅助的模仿学习方法。

该方案极大突破了现有方法的性能上限与泛化性,在各种测试集上的成功率都有至少10%的提升。未来的探索方向是更复杂的交接场景(更逼真的人的行为仿真、更复杂的场景设置)、更有效的基于视觉-动作协同的专家示例生成过程以及更多的机器人真机部署上(不仅仅局限于7DoF的机械臂)。

1176

1176

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?