对比损失(contrastive loss)和信息最大化非条件估计损失(infoNCE loss)是两种常用于对比学习的损失函数。

不同点:

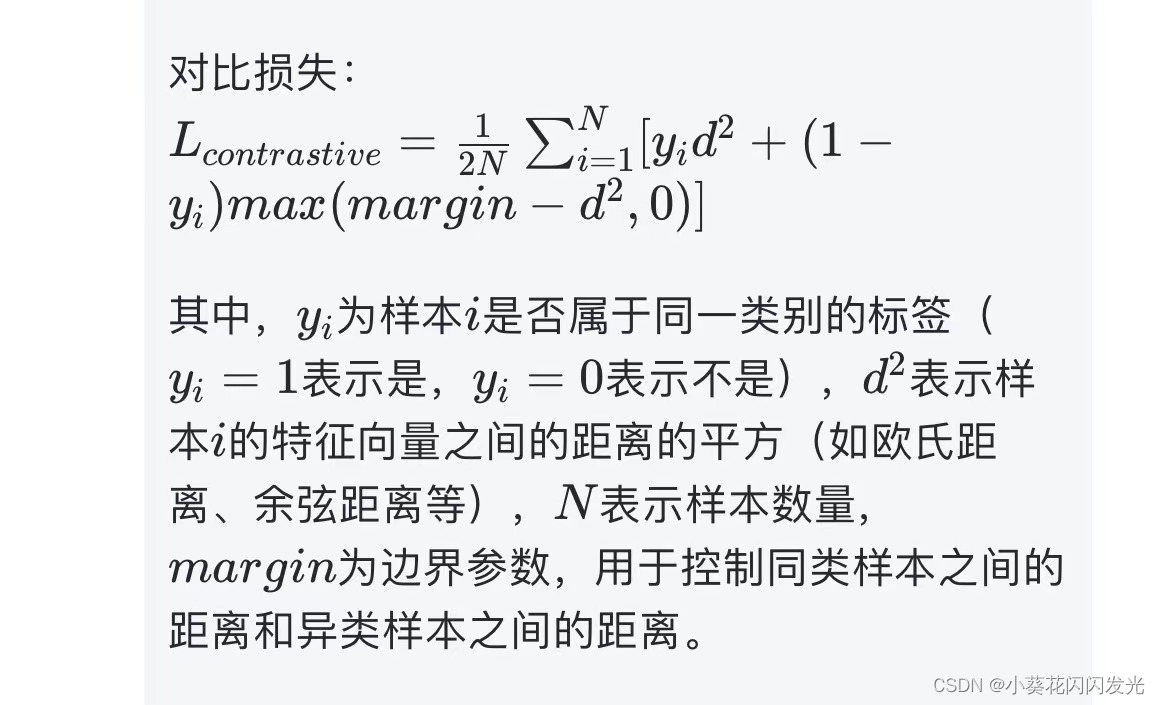

- 对比损失是通过将同类样本靠近、异类样本远离的方式进行训练,而infoNCE损失则是通过最大化正样本的概率和最小化负样本的概率来进行训练。

- 对比损失通常使用欧氏距离或余弦距离作为相似性度量,而infoNCE损失则使用信息论中的互信息来度量样本之间的相关性。

- 在实践中,对比损失常用于Siamese网络等结构中,而infoNCE损失则常用于自编码器等结构中。

相同点:

- 目标都是通过对比样本的相似性来学习特征表示。

- 都属于无监督学习方法,不需要标签信息。

- 都通过最大化特征之间的相似性或最小化特征之间的差异性来进行训练。

总的来说,对比损失和infoNCE损失都是有效的对比学习方法,可以用于无监督学习任务。选择使用哪种损失函数取决于具体的任务和模型结构,以及对样本相似性度量的需求。

3840

3840

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?