注意力机制已经成了模型设计的基础架构,现在模型里没个Attention都不好意思发出来。

从注意力机制发布到今天,学术界一直在对Attention进行各种魔改。魔改后的Attention能够提升模型的表达能力、增强跨模态能力和可解释性,以及优化模型大小与效率。

最重要的一点,很多注意力模块都是即插即用的。我们可以在自己的模型里用学术大牛的注意力模块,这样再做实验写论文绝对是事半功倍了。

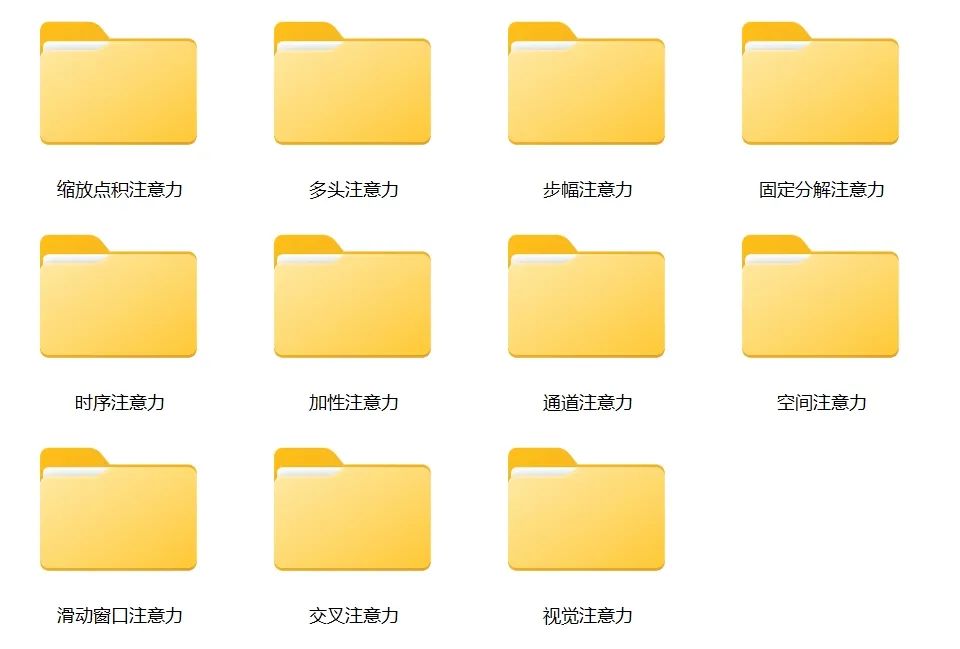

近期,包括缩放点积注意力、多头注意力、交叉注意力、空间注意力、通道注意力等在内的11种主流注意力机制都有许多创新研究。今天分享112个11种主流注意力机制的创新研究,最新更新到24年9月。最新的创新思路非常适合大家用在实验中!

112个11种主流注意力机制的创新研究,paper和代码都帮大家下载整理好了。欢迎扫码领取。

扫码领112个11种主流注意力机制

创新研究paper和代码

缩放点积注意力

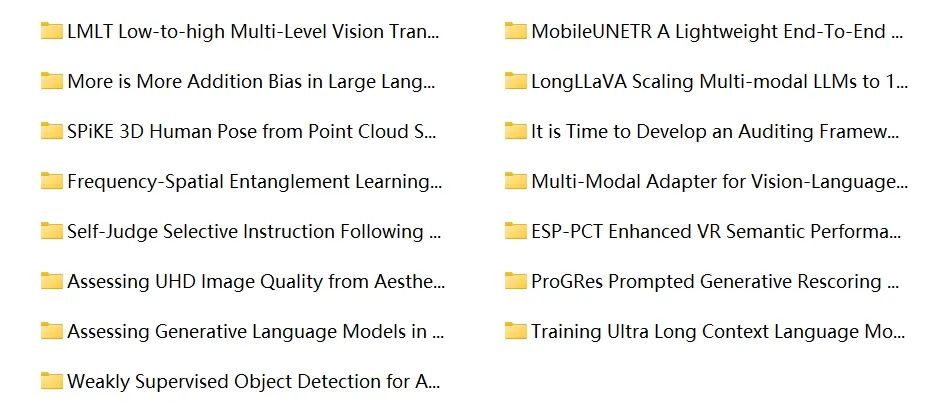

5.Sep.2024—LMLT:Low-to-high Multi-Level Vision Transformer for Image Super-Resolution

4.Sep.2024—MobileUNETR:A Lightweight End-To-End Hybrid Vision Transformer For Efficient Medical Image Segmentation

4.Sep.2024—More is More Addition Bias in Large Language Models

4.Sep.2024—LongLLaVA:Scaling Multi-modal LLMs to 1000 Images Efficiently via Hybrid Architecture

......

扫码领112个11种主流注意力机制

创新研究paper和代码

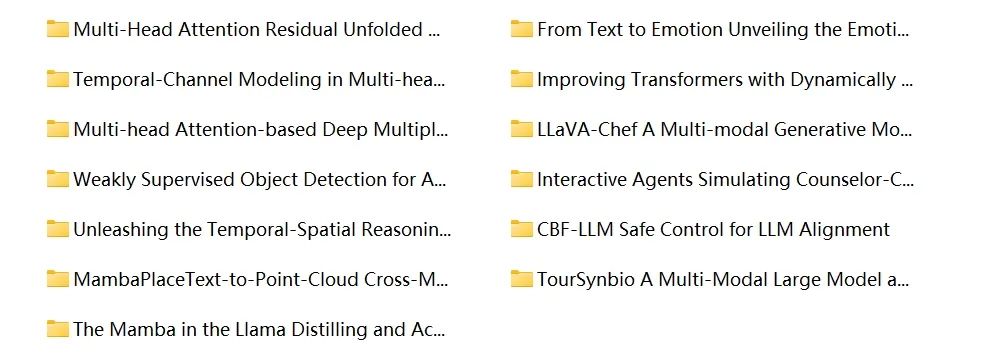

多头注意力

4.Sep.2024—Multi-Head Attention Residual Unfolded Network for Model-Based Pansharpening

30.Aug.2024—From Text to Emotion: Unveiling the Emotion Annotation Capabilities of LLMs

25.Jun.2024—Temporal-Channel Modeling in Multi-head Self-Attention for Synthetic Speech Detection

14.May.2024—Improving Transformers with Dynamically Composable Multi-Head Attention

......

扫码领112个11种主流注意力机制

创新研究paper和代码

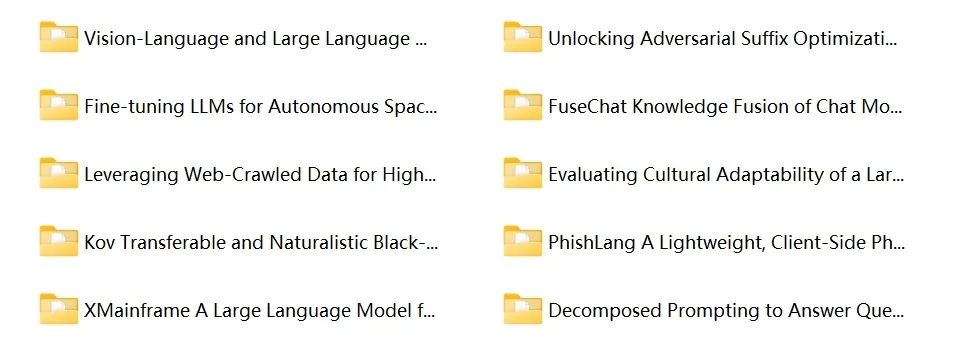

步幅注意力

25.Aug.2024—Vision-Language and Large Language Model Performance in Gastroenterology: GPT, Claude, Llama, Phi, Mistral, Gemma, and Quantized Models

21.Aug.2024—Unlocking Adversarial Suffix Optimization Without Affirmative Phrases: Efficient Black-box Jailbreaking via LLM as Optimizer

16.Aug.2024—Fine-tuning LLMs for Autonomous Spacecraft Control: A Case Study Using Kerbal Space Program

15.Aug.2024—FuseChat Knowledge Fusion of Chat Models

......

扫码领112个11种主流注意力机制

创新研究paper和代码

2641

2641

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?