DCdetector: Dual Attention Contrastive Representation Learning for Time Series Anomaly Detection

作者:Yiyuan Yang, Chaoli Zhang, Tian Zhou

发表年份:KDD 2023

1. Introduction and Conclusion

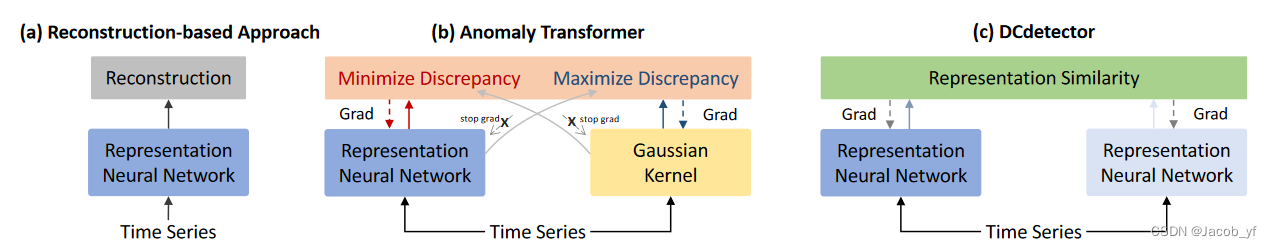

这篇文章的归纳偏置和Anomaly Transformer相似。

异常点和整个序列关联少(少见),和临近的点关联相对多;而正常点可能共享一些潜在的模式,与其他点的关联相对强。

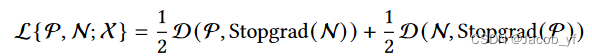

Anomaly Transformer通过可学习高斯核和注意力权重分布的关联差异(差异小,注意力集中在局部,更可能是异常)来检测异常。对比于Anomaly Transformer,这篇文章通过对比学习的方法实现了类似的目标。

1.1 Problems

|

1.2 Contributions

|

2. Method

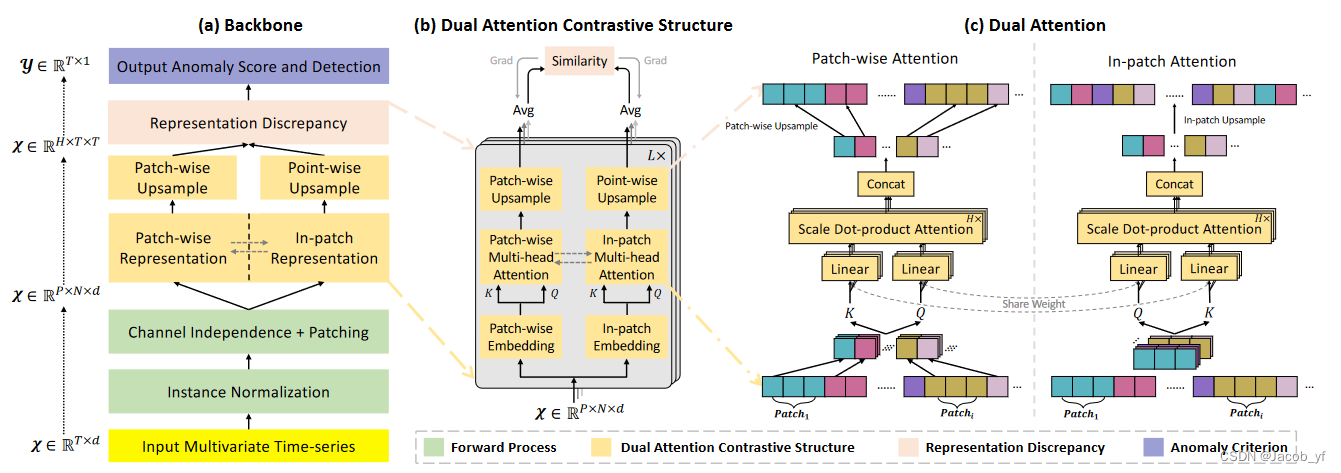

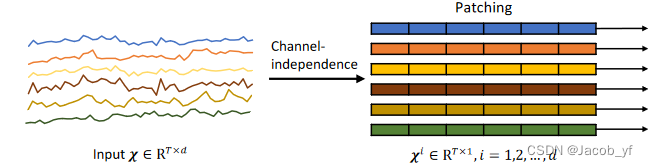

2.1 通道独立->patching

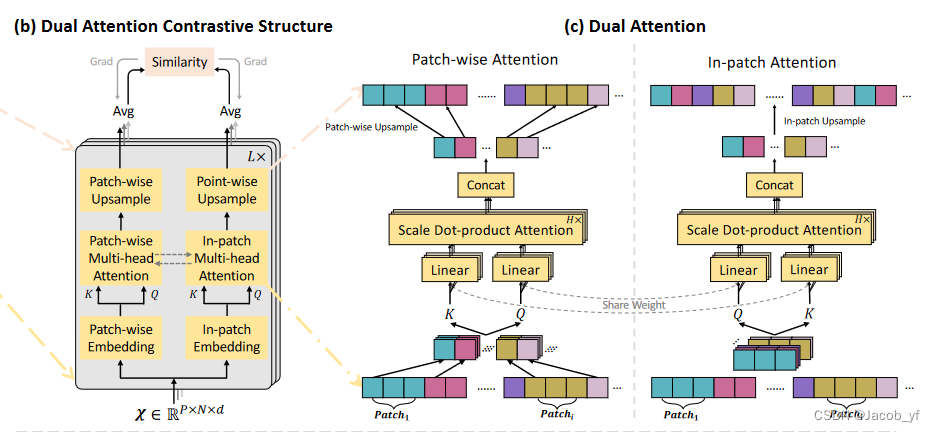

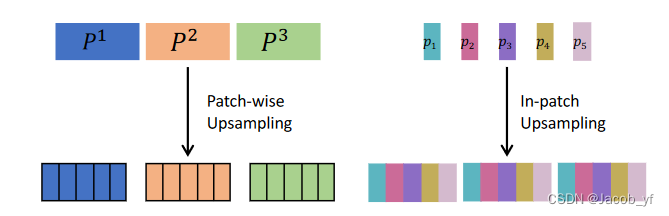

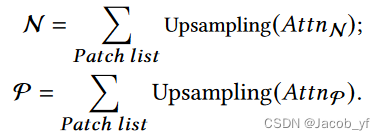

2.2 patch-wise attention,patch-in attention。(+上采样+多尺度)

2.2.1

patch-wise,patch和patch之间(在P上embed,P x N x d -> N x d);patch-in,patch内部(P x N x d -> P x d)。见上示意图。对于某个时刻的点来说,patch-wise就是去计算它与其他几个patch相同位置的attention,patch-in就是计算同一个patch内它与其他点的attention。

Wq和Wk参数共享权重。

2.2.2 上采样

2.2.3 多尺度是指patch的大小不同,最后每个不同patch size的相加。

可以将这两种表示视为排列的多视图表示。(e.g. aabbcc -> abcabc)

归纳偏置:正常点可以在排列下保持其表示,而异常点则不能。从这种对比学习中学习一种排列不变的表示。

2.3 损失函数(KL散度)

![]()

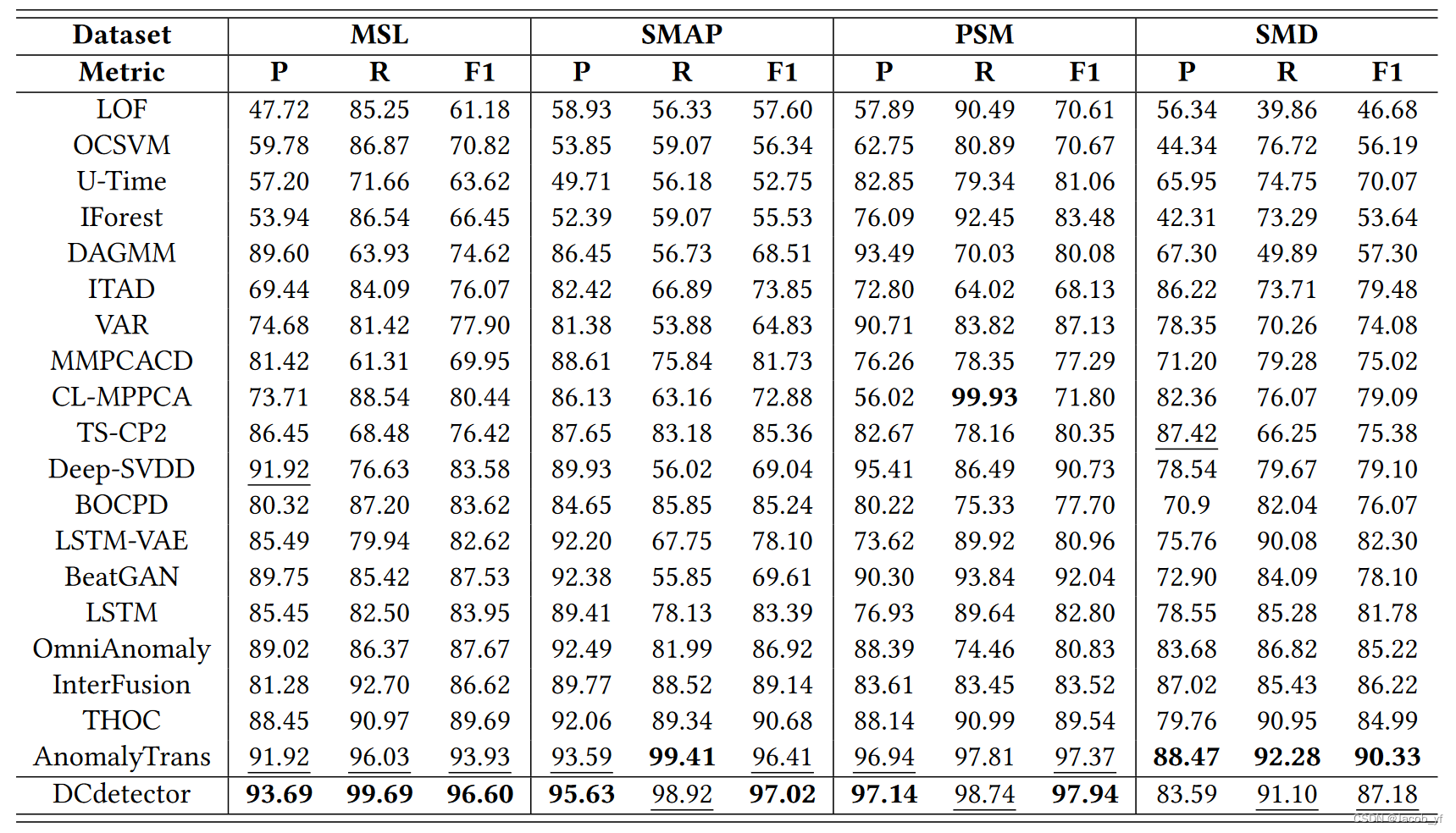

3. Experiments

2029

2029

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?