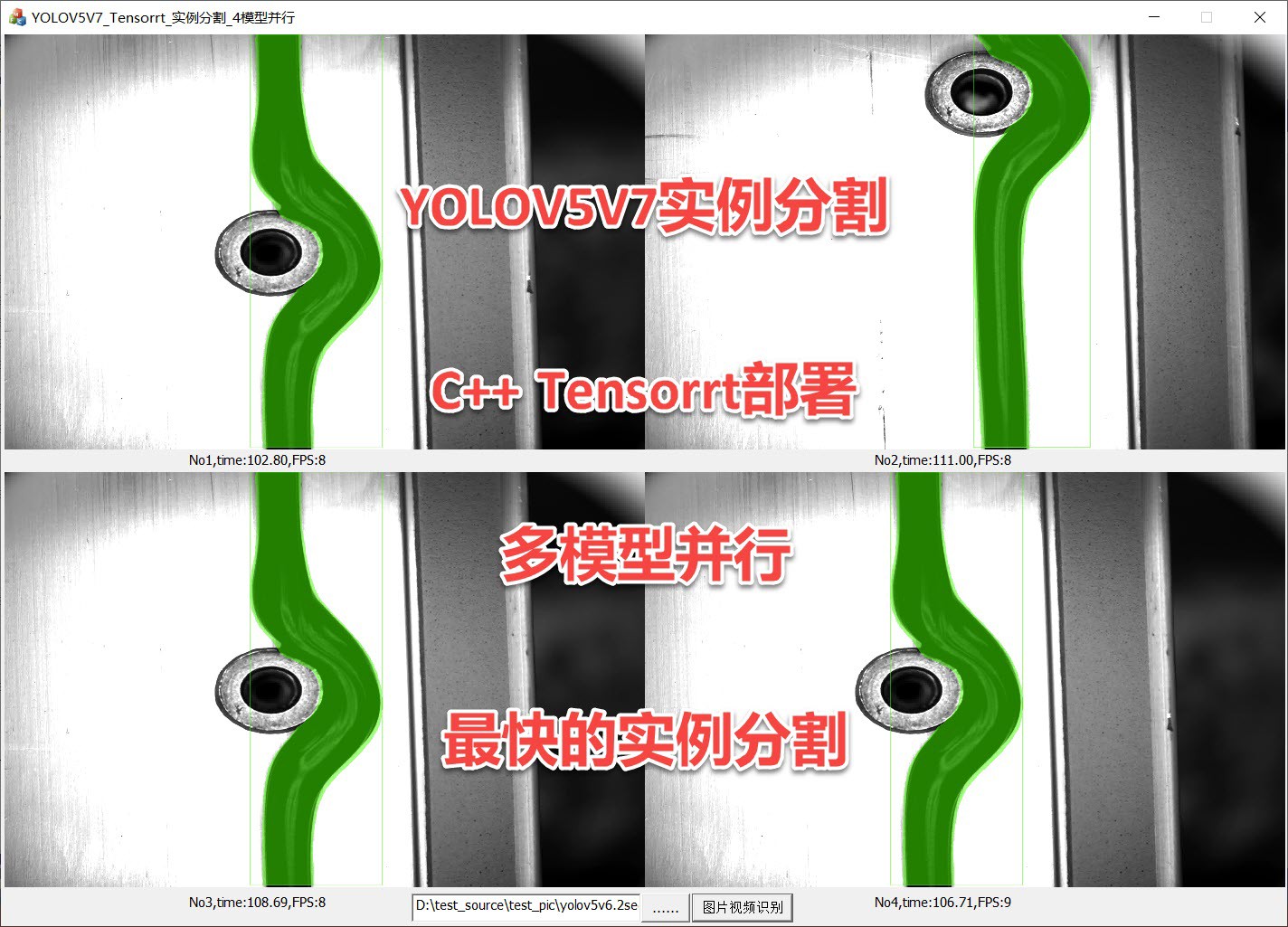

yolov5v7.0 segmet 实例分割 tensorrt C++部署

专门的onnx导出trt软件,训练后导出成onnx,再经过导出软件导出成trt

C++ tensorrt推理dll库,支持多模型并行运行,支持自训练自定义模型

支持界面MFC/C#/Qt调用

MFC和Qt windows下,支持硬解码拉流调用

ID:793600694310055639

IT干将

本文将围绕"yolov5v7.0 segmet 实例分割 tensorrt C++部署"这一主题展开,介绍如何使用专门的onnx导出trt软件将训练后的模型导出成onnx格式,再通过导出软件导出成trt格式。同时还会介绍C++ tensorrt推理dll库的使用,该库支持多模型并行运行,并且可以支持自训练自定义模型。此外,文章还会介绍如何在MFC、C#、Qt界面中调用该库,并且支持硬解码拉流调用。

首先,我们来介绍一下yolov5v7.0 segmet 实例分割算法。Yolov5v7.0是一种基于深度学习的实时目标检测算法,它能够快速准确地检测出图像中的目标物体。而segmet 实例分割算法则是在目标检测的基础上,还能够将检测出的目标物体进行像素级别的分割,以实现更加精细的物体识别。

在将训练好的模型部署到C++中时,我们需要将其导出成onnx格式。为此,我们可以使用专门的onnx导出trt软件来完成这一步骤。该软件能够将已经训练好的模型转换成onnx格式,以便在后续的部署过程中使用。

不过,由于onnx格式在实际部署中可能会存在一些性能问题,因此我们可以再次使用导出软件将onnx格式转换成trt格式。TensorRT是一个高性能的推理引擎,通过优化深度学习模型,可以实现更快速、更高效的推理。通过导出软件将模型导出成trt格式后,我们可以在C++中使用tensorrt推理dll库来进行推理。

这里值得一提的是,tensorrt推理dll库支持多模型的并行运行。也就是说,在同一个应用程序中,我们可以同时加载多个模型进行推理,从而提高系统的处理能力。

另外,该库还支持自训练自定义模型。通过在训练过程中使用自定义的数据集进行训练,我们可以得到更加适用于特定场景的模型。而tensorrt推理dll库可以很好地支持这类自定义模型的推理过程。

对于界面的调用,我们可以根据具体的需求选择MFC、C#或者Qt。无论我们选择哪一种界面,都可以通过调用相关的接口来实现对tensorrt推理dll库的调用。比如,在MFC界面中,我们可以使用相关的API来加载模型、进行推理,并将结果展示在界面上。

此外,针对硬解码拉流调用的需求,我们可以在MFC和Qt的Windows下实现。通过调用相关的硬解码API,我们可以将视频流进行硬件解码,然后再将解码后的图像数据输入到tensorrt推理dll库中进行目标检测和分割。

综上所述,通过yolov5v7.0 segmet 实例分割算法、专门的onnx导出trt软件、C++ tensorrt推理dll库以及MFC、C#、Qt界面的调用,我们可以实现对训练好的模型的部署和使用。无论是在性能上还是在功能上,我们都能够达到较为理想的效果。只需要按照上述步骤进行操作,便可以轻松地将模型应用到实际的项目中,实现精准的目标检测和分割。

【相关代码,程序地址】:http://fansik.cn/694310055639.html

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?