在之前的文章中已经和大家介绍过阿里提出的角色图像动画方法Animate Anyone,感兴趣的小伙伴可以点击下面链接阅读~

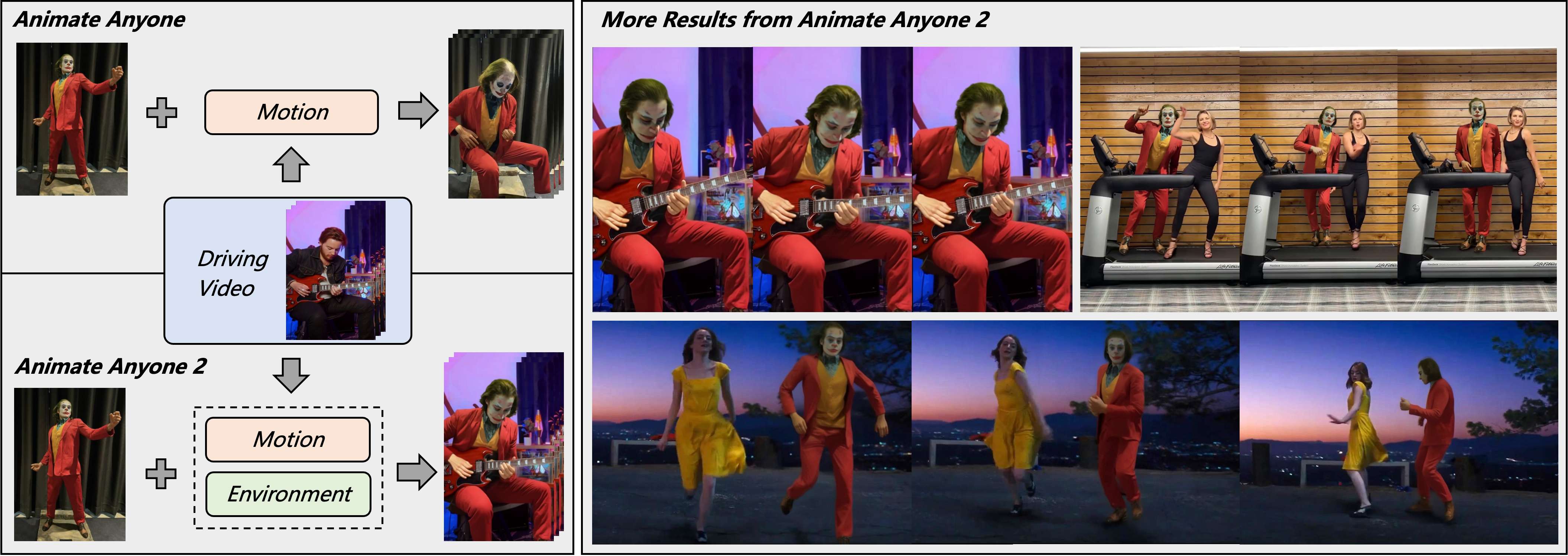

使用过Animate Anyone的小伙伴可能知道该方法在将角色与其环境的关联上存在不足。为了弥补这一缺点,阿里通义实验室更新提出了“Animate Anyone 2”,旨在使角色动画与环境之间更具互动性,从而提升动画的真实感和一致性。

相关链接

-

论文:https://arxiv.org/pdf/2502.06145

-

主页:https://humanaigc.github.io/animate-anyone-2/

论文介绍

最近基于扩散模型的角色图像动画方法(例如 Animate Everyone)在生成一致且可推广的角色动画方面取得了重大进展。然而,这些方法无法在角色和其环境之间建立合理的关联。为了解决这一限制,我们推出了 Animate Everyone 2,旨在通过环境可供性为角色制作动画。除了从源视频中提取运动信号外,我们还捕获环境表示作为条件输入。环境被表述为排除角色的区域,我们的模型生成角色来填充这些区域,同时保持与环境上下文的一致性。

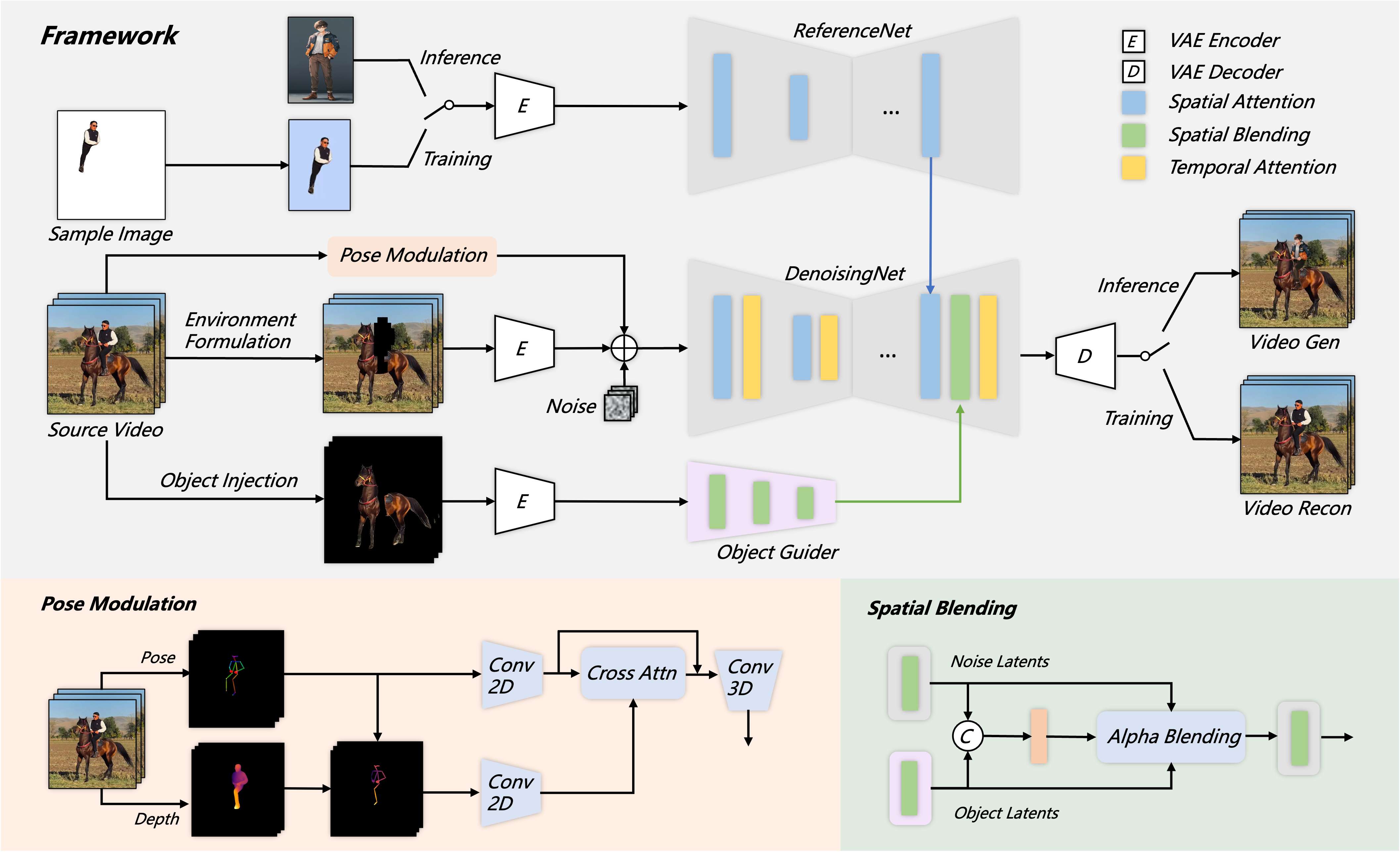

我们提出了一种与形状无关的掩码策略,可以更有效地描述角色与环境之间的关系。此外,为了增强对象交互的保真度,我们利用对象引导器提取交互对象的特征并采用空间混合进行特征注入。我们还引入了一种姿势调制策略,使模型能够处理更多样化的运动模式。实验结果证明了所提方法的卓越性能。

动机

我们提出了 Animate Everyone 2,它不同于以前仅利用运动信号来制作角色动画的角色图像动画方法。我们的方法还从驾驶视频中提取了环境表征,从而使角色动画能够展现环境可供性。

方法

Animate Someone 2 的框架。 我们从源视频中捕获环境信息。环境被表述为没有角色的区域并作为模型输入,从而实现角色-环境融合的端到端学习。为了保留对象交互,我们额外注入了与角色交互的对象的特征。这些对象特征由轻量级对象引导器提取并通过空间混合合并到去噪过程中。为了处理更多样化的运动,我们提出了一种姿势调制方法来更好地表示身体肢体之间的空间关系。

结果

环境互动

Animate Everyone 2 展现出了生成具有上下文连贯环境交互的角色的卓越能力,其特点是无缝的角色场景集成和强大的角色对象交互。

动态运动

Animate Everyone 2 展现出了处理多样化和复杂动作的强大能力,同时确保了角色的一致性并保持与环境背景的合理交互。

人机交互

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?