一、查看结果

之前我们对self-prompt SAM进行复现了,我们应该要投入我们的检测集看看是否符合我们的预期。

这里我们点击运行后就开始进行小样本的训练。

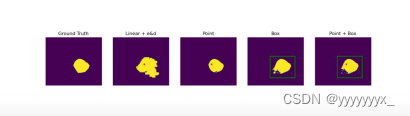

观察分割结果。

我们发现这样的方法是能够分割出息肉的,但是精确度达不太到我们的预期。

那么我们该如何改进这一模型,提高精度呢

二、微调SAM模型

微调SAM模型肯定是有助于更好地分割出息肉的,因为本质上这还是利用了SAM模型的分割能力对息肉进行了分割。

那么我们该如何微调SAM模型呢,市面上是有一些微调SAM模型的例子的。

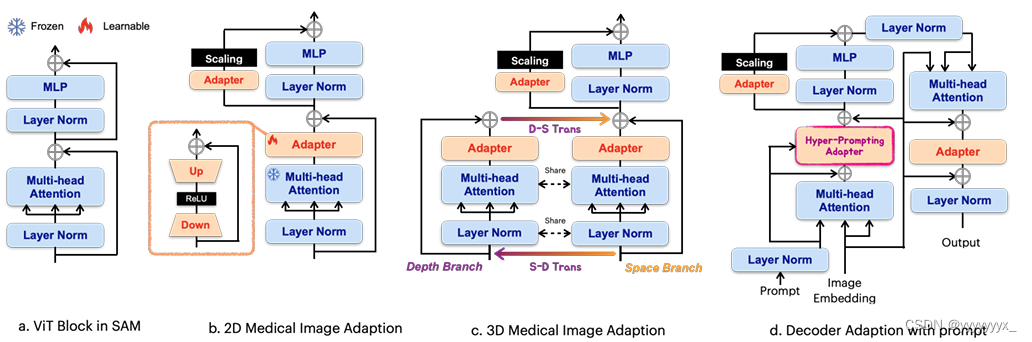

我们这里可以借鉴使用adapter模块对SAM模型进行微调。

PEFT 已被证明是一种针对特定用途微调大型基本模型的有效策略(Zaken、Rav fogel 和 Goldberg 2021)。与完全微调相比,它使大多数参数保持冻结状态,并且学习的参数要少得多,通常不到总数的 5%。这样可以提高学习效率和更快的更新速度。研究还表明,PEFT 方法比完全不调整效果更好,因为它们避免了灾难性的遗忘,并且更好地生成了域外场景,尤其是在低数据状态下(Zaken、Ravfogel 和 Goldberg 2021)。在所有PEFT策略中,Adaption(胡等人,2021)是微调下游任务的大型基本视觉模型的有效工具,不仅在NLP中,而且在计算机视觉中也是如此。最近的研究表明,Adaption 可以很容易地被用于各种下游计算机可视化任务(He et al. 2022;Chen 等人,2022 年)。因此,我们认为 Adaption 是将 SAM 带到医疗领域的最合适技术。

在 SAM 编码器中,我们为每个 ViT 块使用两个适配器。对于标准ViT模块,第一个适配器位于多头注意力之后和残差连接之前。第二个适配器放置在多头注意力之后的 MLP 层的残差路径中。在第二个适配器之后,我们立即使用比例因子缩放嵌入。在 SAM 解码器中,我们为每个 ViT 块集成了三个适配器。第一个 Adapter 用于集成提示嵌入,解码器中的第二个适配器的部署方式与编码器中的部署方式完全相同,以适应 MLP 增强的嵌入。第三个适配器是在 im age 嵌入到提示交叉注意力的残余连接之后部署的。适应后连接另一个残差连接和层归一化,以输出最终结果

这里因为微调还是需要一定的算力的,因此我们是打算放到后面进行微调的,先把其余的工作继续开展,但是我们已经准备好了数据集以及微调的环境。

3733

3733

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?