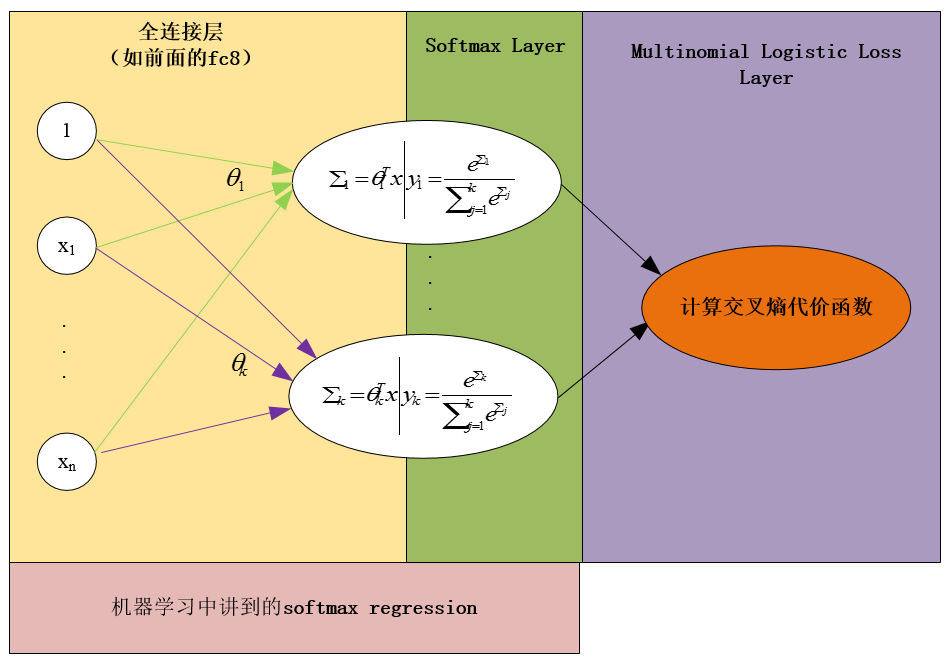

caffe中的softmaxWithLoss其实是:

softmaxWithLoss = Multinomial Logistic Loss Layer + Softmax Layer

其中:

Multinomial Logistic Loss Layer 即为交叉熵代价函数

Softmax Layer其实就是指softmax function(全连接那一步在它前面的fc中实现)

示意图如下:

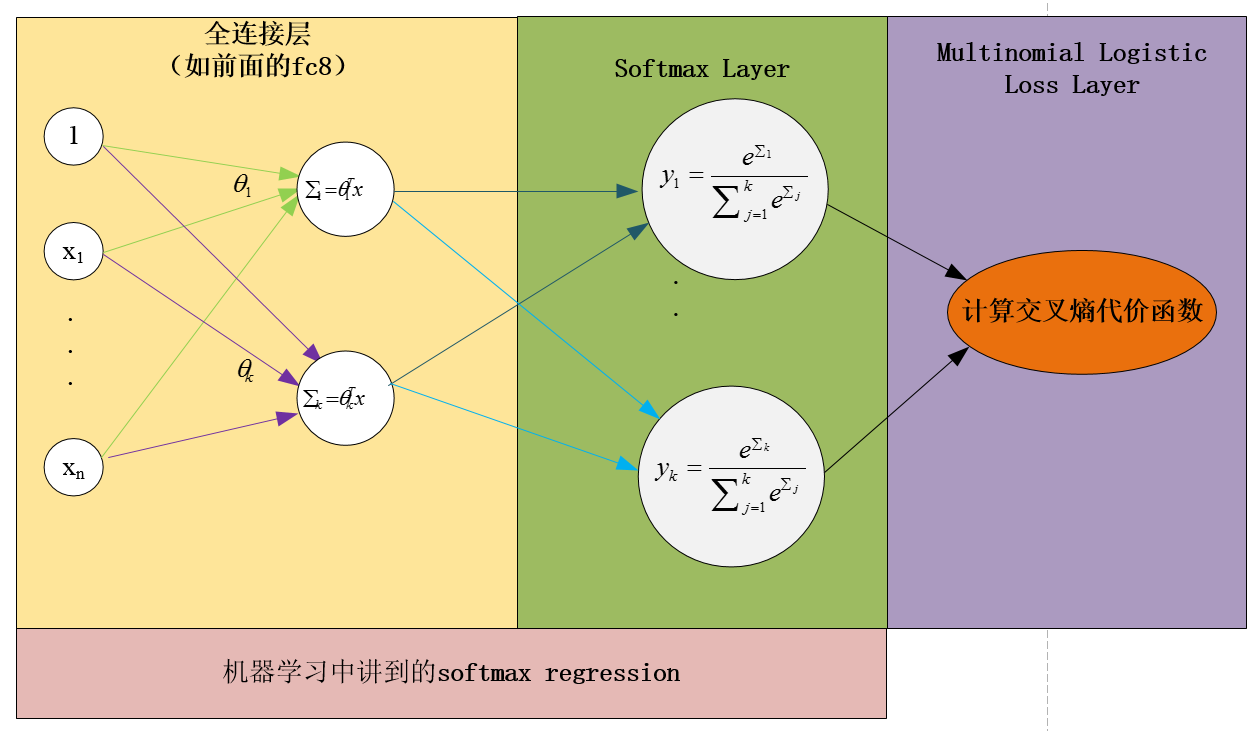

应该注意,这里的Softmax Layer与机器学习中提到的softmax regression有一个小小的不同:它没有将前面的全连接层考虑在内,也就是说,它将softmax regression进行了分解:

softmax regression = 全连接层 + softmax layer (即softmax function)

另外,softmax function那个过程,按照如下方式绘制展示可能会更加明白

4973

4973

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?