摘要

通过从大规模、多样化且与任务无关的数据集中迁移知识,现代机器学习模型能够在零样本学习情境下,或仅借助少量特定任务数据集,就达到解决特定下游任务的高性能水平。尽管这一能力已在计算机视觉、自然语言处理或语音识别等其他领域得到验证,但在机器人学领域,这一能力仍有待证明。由于收集现实世界中的机器人数据难度较大,因此模型在该领域的泛化能力尤为关键。我们认为,这类通用机器人模型成功的关键之一在于开放式、与任务无关的训练,再结合能够吸收各种多样化机器人数据的高容量架构。在本文中,我们提出了一类模型,称为“机器人Transformer”(Robotics Transformer),这类模型展现出有望实现可扩展性的特性。我们基于对现实机器人执行现实任务的大规模数据收集,开展了一项关于不同模型类别及其泛化能力的研究,研究内容包括数据规模、模型规模以及数据多样性对泛化能力的影响,从而验证了我们的结论。该项目的网站和视频可在robotics-transformer.github.io访问。

1 引言

端到端机器人学习(无论是通过模仿学习还是强化学习)通常需要在针对机器人应执行任务而专门定制的单任务(Kalashnikov 等人,2018;Zhang 等人,2018)或多任务(Kalashnikov 等人,2021b;Jang 等人,2021)环境中收集特定任务的数据。这种工作流程与其他领域(如计算机视觉和自然语言处理)中的经典监督学习方法类似,在这些领域中,会收集、标注特定任务的数据集,并将其用于解决单个任务,而任务之间几乎不存在相互影响。

近年来,计算机视觉、自然语言处理以及其他领域发生了变革,从孤立、小规模的数据集和模型,转向在广泛、大规模数据集上进行预训练的大型通用模型。这类模型成功的关键在于开放式、与任务无关的训练,以及能够吸收大规模数据集中所有知识的高容量架构。如果一个模型能够像“海绵吸水”一样积累经验,以学习语言或感知中的一般模式,那么它就能更高效地将这些知识应用于单个任务。尽管在监督学习中去除对大规模特定任务数据集的需求通常具有吸引力,但在机器人学领域,这一需求更为关键,因为收集数据集可能需要工程复杂度较高的自主操作,或者成本高昂的人类演示。

因此,我们提出以下问题:我们能否利用包含各种机器人任务的数据,训练出一个单一、能力强、大规模的多任务骨干模型?这样的模型能否像在其他领域观察到的那样,受益于零样本泛化能力,从而适应新任务、新环境和新物体?

在机器人学领域构建这样的模型并非易事。尽管近年来文献中提出了几种大型多任务机器人策略(Reed 等人,2022;Jang 等人,2021),但这些模型往往在实际任务覆盖面上存在局限,例如 Gato 模型(Reed 等人,2022),或者侧重于训练任务而非泛化到新任务,例如近期的一些指令跟随方法(Shridhar 等人,2021;2022),或者在新任务上的性能相对较低(Jang 等人,2021)。

(a) RT-1 模型接收图像和自然语言指令作为输入,并输出离散化的机器人基座(base)和机械臂(arm)动作。尽管该模型规模较大(拥有 3500 万个参数),但得益于其高效且高容量的架构设计,它仍能以 3 赫兹(Hz)的频率运行:该架构由一个基于特征线性调制(Feature-wise Linear Modulation,简称 FiLM,Perez 等人,2018)的条件化高效网络(EfficientNet,Tan & Le,2019)、一个令牌学习器(TokenLearner,Ryoo 等人,2021)以及一个Transformer(Vaswani 等人,2017)组成。

(b) RT-1 模型通过大规模的真实世界训练(收集了 13 万次演示数据)和评估(开展了 3000 次真实世界试验),展现出了令人瞩目的泛化能力、鲁棒性,以及从多样化数据中学习的能力。

图 1:对 RT-1 模型架构、数据集以及评估方式的高层次概述。

构建有效的机器人学习系统主要面临两大挑战:一是收集合适的数据集,二是设计恰当的模型。

在众多大规模机器学习项目中,数据收集与整理工作往往被视为“幕后英雄”(Radford 等人,2021;Ramesh 等人,2021)。而在机器人学领域,这一情况尤为突出,因为机器人数据集通常针对特定机器人定制,且往往需手动收集(Dasari 等人,2019;Ebert 等人,2021)。正如我们在后续评估中所展示的,良好的泛化能力需要兼具规模与广度的数据集,覆盖多样化的任务与场景。同时,数据集中的任务应具备足够紧密的关联性,以促进泛化,使模型能够发现结构相似任务之间的模式,并以新颖方式将这些模式组合起来执行新任务。我们利用在 17 个月内通过 13 台机器人收集的数据集开展研究,该数据集包含约 13 万个片段(episodes)和超过 700 项任务。在评估过程中,我们对该数据集的各个方面进行了消融实验分析。

第二个挑战在于模型设计本身。有效的机器人多任务学习需要高容量的模型,而 Transformer(Vaswani 等人,2017)模型在这方面表现出色,尤其是在需要根据语言指令学习多种任务的情况下。然而,机器人控制器必须具备足够的实时运行效率,这对 Transformer 模型而言是一大挑战。为此,我们提出了一种名为 RT-1(Robotics Transformer 1,机器人 Transformer 1)的新型架构。该架构通过将高维输入(如摄像头图像、指令)和输出(如电机指令)编码为紧凑的令牌(token)表示,供 Transformer 使用,从而实现了运行时的高效推理,使实时控制成为可能。

我们的贡献在于提出了 RT-1 模型,并在一个大规模、多样化的真实世界机器人任务数据集上对该模型进行了实验。实验结果不仅表明,与现有技术相比,RT-1 在泛化能力和鲁棒性方面均有显著提升,还对模型设计和训练集构成中的诸多设计选择进行了评估与消融分析。结果显示,RT-1 能够以 97% 的成功率执行超过 700 条训练指令,并且在面对新任务、干扰物和不同背景时,其泛化能力分别比次优基线高出 25%、36% 和 18%。这一性能水平使得我们能够在 SayCan(Ahn 等人,2022)框架中执行多达 50 个阶段的超长序列任务。此外,我们还证明 RT-1 能够整合来自仿真环境甚至其他类型机器人的数据,在保持原始任务性能的同时,提升对新场景的泛化能力。图 1b 对 RT-1 的能力进行了简要概述。

2 相关研究

近期,多项研究提出了基于 Transformer 的机器人控制策略。与 RT-1 类似,部分研究将经 Transformer 处理的语言指令作为稳健框架,用于指定新任务并实现泛化(Zhang & Chai, 2021; Pashevich 等人, 2021; Silva 等人, 2021; Jang 等人, 2021; Ahn 等人, 2022; Nair 等人, 2022)。我们的研究进一步拓展了 Transformer 的应用范畴,将语言和视觉观测到机器人动作的映射视为序列建模问题,并利用 Transformer 学习该映射关系。这一思路直接受到游戏领域(Chen 等人, 2021; Lee 等人, 2022a)以及模拟机器人导航(Fang 等人, 2019)、移动(Janner 等人, 2021; Gupta 等人, 2022)和操作(Jiang 等人, 2022)环境中所取得成功的启发。我们注意到,其中多项研究不仅局限于文本条件,还利用 Transformer 实现跨机器人形态(例如 Gupta 等人, 2022)以及任务规范的其他模态(例如 Jang 等人, 2021; Jiang 等人, 2022)的泛化。这些拓展方向为 RT-1 的未来发展提供了极具潜力的思路。

除基于 Transformer 的策略外,本研究的核心聚焦于大规模可泛化且稳健的真实世界机器人操作。现有基于 Transformer 的真实世界机器人操作研究主要关注如何从每个任务的一组演示中高效学习任务(Shridhar 等人, 2022)。行为 Transformer(Shafiullah 等人, 2022)和 Gato(Reed 等人, 2022)主张在大规模机器人和非机器人数据集上训练单一模型。然而,这些研究在真实世界机器人任务方面存在局限性。例如,Gato 仅有效学习了单一任务(彩色积木堆叠),且未评估其在不同新任务或多样化真实场景中的泛化能力。从技术层面来看,本研究探讨了如何构建基于 Transformer 的策略,以将高容量与泛化能力相结合,同时满足实时控制所需的计算效率。

尽管利用高容量 Transformer 模型学习机器人控制策略是近期才出现的创新,但机器人学在多任务学习和语言条件学习方面已有深厚积淀,RT-1 正是基于这些基础而构建。大量研究致力于学习机器人抓取的策略和预测模型(Saxena 等人, 2006; Lenz 等人, 2015; Pinto & Gupta, 2016; Gupta 等人, 2018; Viereck 等人, 2017),旨在实现对新物体的泛化。此前的研究尝试通过组合语言解析、视觉和机器人控制的流水线方法(MacMahon 等人, 2006; Kollar 等人, 2010; Tellex 等人, 2011)以及端到端方法(Mei 等人, 2016; Stepputtis 等人, 2020; Lynch & Sermanet, 2020; Ahn 等人, 2022)来解决机器人语言理解问题。多任务机器人学习也从学习达成目标(Chung 等人, 2015; Raffin 等人, 2019; Jurgenson 等人, 2020; Huang 等人, 2020)以及学习能够在离散任务集或某种参数化形式下执行任务的策略(Deisenroth 等人, 2014; Devin 等人, 2017; Fox 等人, 2019; Kalashnikov 等人, 2021a)等角度展开研究。机器人学领域的多项前期研究还专注于收集包含演示或试验的数据集,这些数据集展示了多种不同任务(Sharma 等人, 2018; Dasari 等人, 2019; Yu 等人, 2020; Singh 等人, 2020; James 等人, 2020)。本研究进一步提供了证据,有力支持了多任务、语言条件化机器人学习的强大能力,在大规模实验中展现了更为丰富的行为、物体和场景,并提出了新的架构和设计选择,使机器人学习能够在更大规模上得以实现。

3 前置知识

4 系统概述

5 RT-1:机器人变换器(Robotics Transformer)

在本节中,我们将介绍图像、文本和动作的离散化方式(tokenization),并进一步阐述 RT-1 模型的架构设计。随后,我们将说明如何实现满足实时控制需求的运行速度。最后,我们还将描述数据采集的流程,以及数据集中包含的技能和指令内容。

图 2:

(a) 用于大规模数据采集的机器人教室;

(b) 一个真实办公厨房,是用于评估的两个逼真环境之一(在本文其余部分中称为 Kitchen1);

(c) 另一个用于评估的不同办公厨房(在本文其余部分中称为 Kitchen2);

(d) 贯穿本文使用的移动操作机器人;

(e) 一组用于大多数技能的物体,用以扩展技能多样性;

(f) 一组更为多样的物体,主要用于扩展“抓取”技能的物体多样性。

5.1 模型

我们的模型基于 Transformer 架构(Vaswani 等人,2017),输入为图像历史序列与任务描述,直接输出动作的离散 token,如图 1a 所示,详细结构见图 3。以下按照图 3 的自上而下顺序介绍模型的各个组成部分。关于大规模模型选择的更多细节见附录 C.3。

指令与图像的离散化表示(Tokenization)。

RT-1 架构依赖于对图像和语言指令进行高效且紧凑的 token 化。RT-1 通过 ImageNet 预训练的 EfficientNet-B3 模型(Tan & Le, 2019)对图像历史序列(共 6 张图像)进行编码。该模型接收 6 张分辨率为 300×300 的图像作为输入,并在其最后一个卷积层输出一个形状为 9×9×512 的空间特征图。与 Reed 等人(2022)不同,我们并未将图像切分为视觉 token 后再送入 Transformer 主干网络,而是直接将 EfficientNet 的输出特征图展平为 81 个视觉 token,并将其传递给网络的后续层。

为了引入语言指令,我们使用预训练的语言嵌入形式,将自然语言指令作为条件输入给图像编码器,使其能够更早地提取与任务相关的图像特征,从而提升 RT-1 的性能。具体地,指令首先通过 Universal Sentence Encoder(Cer 等人,2018)进行嵌入。该嵌入随后被用作 FiLM 层(Perez 等人,2018)的输入,用于调节预训练 EfficientNet 中的特征提取过程。

通常情况下,在预训练网络的中间插入 FiLM 层可能会破坏中间激活值,从而抵消预训练权重的优势。为了解决这个问题,我们将用于生成 FiLM 仿射变换的全连接层(fc 和 hC)的权重初始化为零,使得 FiLM 层最初充当恒等映射,从而保留预训练模型的功能结构。我们发现,即使在从零开始训练 EfficientNet(即未使用 ImageNet 预训练)时,使用这种恒等初始化的 FiLM 也能取得更好的效果,但仍不如上述方法性能优越。

图 3 展示了图像 tokenizer 的结构。通过 FiLM 调制的 EfficientNet-B3,RT-1 总共包含约 1600 万个参数,由 26 层 MBConv 模块和 FiLM 层构成,输出 81 个融合视觉与语言的 token。

TokenLearner 模块。

为了进一步压缩 RT-1 需要关注的 token 数量、加快推理速度,RT-1 引入了 TokenLearner(Ryoo 等人,2021)。TokenLearner 是一种逐元素注意力模块,能够学习将大量 token 映射为更少量的信息密集 token。通过这种方式,我们可以根据 token 的信息量“软选择”图像 token,仅将最重要的 token 组合传递给后续的 Transformer 层。通过引入 TokenLearner,我们将预训练 FiLM-EfficientNet 输出的 81 个视觉 token 下采样为 8 个最终 token,再传递给 Transformer 模块处理。

图 3:RT-1 的架构图。指令首先被转换为一个 USE(通用句子编码器)嵌入向量,并通过 FiLM 层用于对预训练的 EfficientNet 进行条件化处理。由此产生的视觉-语言混合 token 通过 TokenLearner 进行压缩,随后输入到一个仅包含解码器的 Transformer 中,最终输出离散化的动作。

5.2 数据

表 1:RT-1 所采集的技能清单,包括每项技能的描述及对应的示例指令。

6 实验

6.1 实验设置

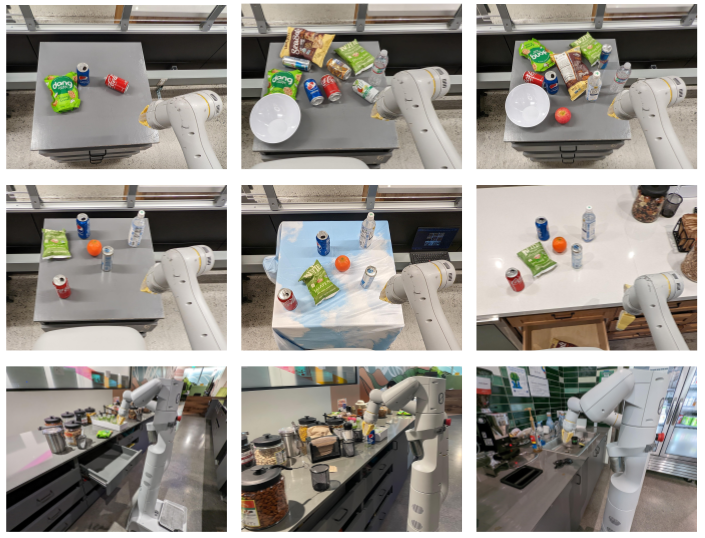

图 4:干扰物场景(第一行)的评估设置,从左至右依次为:简单(0 - 5 个干扰物)、中等(9 个干扰物)、困难(9 个干扰物且存在目标物体被遮挡的情况);背景场景(第二行)的评估设置,从左至右依次为:原始环境、带有图案的桌布背景、全新厨房环境;以及真实厨房中的现实场景(第三行)的评估设置,泛化级别从左至右依次为:L1、L2 和 L3。

6.2 RT-1能否执行大量指令并泛化到新任务、物体与环境?

对真实指令的泛化能力

接下来,我们测试我们的方法是否能在之前评估过的所有不同维度上实现足够程度的泛化,从而能够部署到真实厨房环境中。真实厨房环境会同时带来多种分布偏移,例如新的任务组合、作为干扰物的物体,以及全新的环境。

为了在真实厨房的现实场景中评估我们的算法,我们构建了一系列任务序列,以完成多个实际目标。具体任务包括:机器人将零食重新摆放至抽屉中,整理被碰倒的调料瓶并关上人类未关的抽屉,用橙子和餐巾纸准备一份小吃,以及从厨房的多个位置找回丢失的太阳镜和章鱼玩具。这些场景中使用的详细指令列于附录 D.1 中。办公室厨房环境与训练环境存在显著差异,我们根据这些场景中任务的泛化程度进行了分类:L1 代表对全新台面布局和光照条件的泛化,L2 代表在此基础上进一步对未见过的干扰物进行泛化,L3 代表对全新任务设置、全新任务物体或在未见过的位置(如水槽附近)的物体进行额外泛化。图 4 的最后一行展示了与真实厨房中补货、准备小吃和找回丢失物品这三个任务相对应的三个泛化级别。不同泛化级别的示例轨迹图在附录的图 11 中给出。

我们在表 3 中报告了这些现实场景下各任务的成功率,以及不同泛化级别的数据。结果显示,RT-1 在所有泛化级别上均表现出最强的鲁棒性。Gato 在第一级泛化上表现尚可,但在更具挑战性的泛化场景中性能显著下降。BC-Z 及其 XL 版本在 L2 级别上表现良好,且在 L3 级别上优于 Gato,但仍未达到 RT-1 的泛化水平。

6.3 我们能否通过整合异构数据源(如仿真数据或来自不同机器人的数据)进一步提升最终模型的性能?

接下来,我们探索 RT-1 在利用高度异构数据方面的极限。我们展示了 RT-1 如何能够整合并从截然不同的数据源中学习,同时利用这些数据提升性能,且不会牺牲其在这些数据所涵盖的多样化任务上的原始任务表现。为此,我们进行了两项实验:(1)在真实数据和仿真数据上同时训练和测试 RT-1;(2)RT-1 模型是通过跨多个不同任务的大型数据集进行训练的,这些数据集最初由不同的机器人收集而来。关于每个数据集的更多详细信息,请参见附录 D.2。

表 3:现实场景下的泛化能力评估:我们在真实的谷歌厨房场景中,对模型在不同泛化级别下的成功率进行了比较。泛化级别共分为三级:

- L1 级泛化:针对全新的台面布局和光照条件进行泛化;

- L2 级泛化:在 L1 级泛化的基础上,进一步对未见过的干扰物进行泛化;

- L3 级泛化:在 L2 级泛化的基础上,进一步对全新任务设置、全新任务物体,或在如水槽附近等未见过的位置进行泛化。

吸收仿真数据

表 4 展示了 RT-1 模型及各基准方法在融合真实数据与仿真数据方面的能力。为验证这一点,我们采用了所有真实演示数据,并额外提供了仿真数据,其中包含机器人从未在现实世界中见过的物体。具体而言,我们设定了不同的泛化场景:

- 针对真实物体的已掌握技能:训练数据中包含该指令的真实数据(即对已见任务的表现)。

- 针对仿真物体的已掌握技能:训练数据中包含该指令的仿真数据(例如,“拾取一个仿真物体”,该物体存在于仿真环境中)。

- 针对仿真物体的未掌握技能:训练数据中包含该物体的仿真数据,但无论是仿真环境还是现实世界中,均不存在描述使用该物体执行该技能的指令示例(例如,“将一个仿真物体移动到苹果旁边”,尽管机器人仅练习过拾取该仿真物体,而未练习过将其靠近其他物体)。

所有评估均在现实世界中进行,但为减少评估指令的数量,我们重点考察了拾取与移动技能。

从表 4 中我们发现,相较于仅使用真实数据集(Real Only),RT-1 模型在添加仿真数据后性能并未下降。然而,在仅于仿真环境中见过的物体和任务上,性能显著提升(从 23% 提升至 87%),几乎达到了现实环境中的表现水平,展现了出色的领域迁移能力。此外,在未见过的指令上,性能也显著提升(从 7% 提升至 33%),考虑到所涉及的物体在现实世界中从未见过,且指令也完全未见,这一提升尤为显著。总体而言,我们发现 RT-1 模型能够高效地吸收新数据,即便这些数据来自截然不同的领域。

吸收来自不同机器人的数据

为进一步探索 RT-1 模型的数据吸收能力极限,我们开展了一项额外实验,将两个源自不同机器人的数据源相结合:一是库卡(Kuka)IIWA 机器人,二是迄今为止实验中使用的日常机器人(Everyday Robots)移动机械臂。库卡数据包含了在 QT-Opt(Kalashnikov 等人,2018 年)中收集的所有成功示例,对应 20.9 万个片段,其中机器人无差别地从料箱中抓取物体(参见表 5 中库卡片段的一个示例)。为验证 RT-1 模型能否有效吸收这两个截然不同的数据集,我们进行了标准“课堂评估”(Classroom eval),同时评估了新构建任务的表现,这些任务反映了库卡数据中存在的料箱抓取设置,我们称之为“料箱抓取评估”(Bin-picking eval)(参见图 6)。

我们希望通过强调数据集之间的主要差异来凸显这一实验设置的难度。不仅收集数据的机器人在外观和动作空间上存在差异,而且它们所处的环境在外观和动力学特性上也各不相同。此外,QT-Opt 数据呈现了完全不同的动作分布——它是由强化学习(RL)智能体收集的,而非我们数据集中的人类演示。

实验结果见表 5。我们发现,混合 RT-1 数据与库卡数据的模型在原始任务(即课堂评估)上的性能仅略有下降(2%)。更为重要的是,在料箱抓取评估中,我们观察到基于多机器人数据训练的模型表现达到了 39%,而仅基于 RT-1 数据训练的模型表现仅为 22%。这一性能差异达 17%(近乎翻倍)。此外,在库卡料箱抓取数据上训练的 RT-1 模型,若在日常机器人(EDR)上进行料箱抓取任务评估,则性能为 0%,这证实了从另一种机器人形态迁移行为存在困难。

然而,将两个机器人的数据混合后,RT-1 模型能够在面对库卡机器人观察到的状态时,推断出 EDR 机器人的正确动作。这一过程无需 EDR 机器人进行明确的料箱抓取演示,而是利用了库卡机器人过去收集的经验。这些结果表明,RT-1 模型的吸收特性还包括通过观察其他机器人的经验来获取新技能的能力,为未来工作开辟了一条令人振奋的途径,即通过结合更多多机器人数据集来增强机器人的能力。

表 5:混合来自两个不同机器人的数据的实验结果。在 RT-1 模型中融入来自 QT-Opt(Kalashnikov 等人,2018 年)的库卡(Kuka)机器人料箱抓取数据后,对标准课堂评估(Classroom Evaluation)的性能影响微乎其微,同时在日常机器人(Everyday Robots)机械臂上,针对与库卡数据场景相似的料箱抓取评估(Binpicking Evaluation)任务中,模型的泛化能力实现了近两倍的提升。

6.4 不同方法在长程机器人场景中的泛化能力如何?

在接下来的实验中,我们评估了我们的方法是否具备足够的泛化能力,以应用于长程、真实的厨房环境中。为回答这一问题,我们在两个不同的真实厨房场景中,基于 SayCan(Ahn 等人,2022 年)框架执行了 RT-1 模型及多种基准方法。由于 SayCan 通过组合多个低层指令来执行高层指令,因此随着技能数量的增加,可能的高层指令数量会呈组合级数增长,从而能够全面展现 RT-1 模型的技能广度(有关 SayCan 算法的更多细节,请参阅 Ahn 等人(2022 年)的论文)。此外,长程任务的成功率也会随着任务长度的增加而呈指数级下降,因此操作技能的高成功率尤为重要。再者,由于移动操作任务同时涉及导航与操作,策略对基座位置(机器人本体位置)的鲁棒性至关重要。

更多实验细节详见附录 D.3。

表 6 展示了我们的实验结果(指令详情见附录表 12)。除原始 SayCan 方法外,所有方法的规划成功率均达到 87%,而 RT-1 模型在 Kitchen1 厨房中的执行成功率最高,为 67%。Kitchen2 厨房构成了一个更具挑战性的泛化场景,因为机器人课堂(Robot Classroom)的训练场景是基于 Kitchen1 构建的(参见图 2 中厨房的图片)。由于这一泛化难度,结合 Gato 的 SayCan 方法未能完成任何长程任务,而结合 BC-Z 的 SayCan 方法仅实现了 13% 的成功率。原始的 SayCan 论文并未评估在新厨房环境中的性能表现。令人惊讶的是,我们的方法在从 Kitchen1 迁移到 Kitchen2 时,操作性能并未出现明显下降。在补充视频中,我们展示了 RT-1 模型能够在 Kitchen2 中操作未见过的抽屉,并能够利用 SayCan-RT1 规划并执行超长程任务,任务步骤多达 50 步。

在 Kitchen1 和 Kitchen2 中基于 SayCan 风格的长程任务表现

6.5 泛化能力指标如何随数据量与数据多样性的变化而改变?

尽管先前的研究已证明,基于 Transformer 的模型(如 Lee 等人,2022a;Reed 等人,2022;Jiang 等人,2022)可通过扩大模型参数规模提升性能,但在许多机器人学习任务中,模型规模往往并非主要瓶颈。由于在真实机器人上运行此类模型存在延迟要求,模型的最大规模受到限制。因此,本研究转而聚焦于分析数据集规模(data quantity)与数据多样性(data diversity)的影响,因为二者在传统数据受限的机器人学习领域中扮演着关键角色。

由于真实机器人的数据收集成本高昂,量化模型在何种数据特性下能够达到特定性能与泛化能力显得尤为重要。因此,本研究的最后一个问题聚焦于探讨 RT-1 模型在不同数据特性下的扩展能力。在表 7 中,我们展示了当数据集规模(% 数据量)和数据集多样性(% 任务覆盖)减少时,RT-1 模型在性能、泛化能力与鲁棒性方面的变化趋势。

为分离数据集规模与多样性的影响,我们通过以下方式创建规模更小的数据集(同时保持任务多样性不变):从数据量最大的任务中移除部分数据,将每个任务的样本数限制为最多 200 例(数据量减少至 51%)、100 例(37%)和 50 例(22.5%)。为创建任务覆盖更窄的数据集,我们移除数据量最少的任务,从而保留 97% 的总数据量,但仅覆盖 75% 的任务。

实验结果表明:

- 随着数据集规模的减少,模型性能呈现整体下降趋势,泛化能力的下降更为显著。

- 当数据集的任务覆盖范围变窄时,模型性能的下降幅度更为剧烈,尤其在泛化能力方面。例如,移除 25% 的任务(仅保留 75% 的任务)但保留 97% 的数据量,其泛化性能与将数据集规模减少 49% 的效果相当。

因此,我们的核心结论是:数据多样性比数据量更为关键。

7 结论、局限性及未来工作

我们提出了 Robotics Transformer 1(RT-1),这是一种机器人学习方法,能够高效吸收大规模数据,并随数据量与多样性的增加实现扩展。我们在一个包含超过 13 万条轨迹(episodes)的大型演示数据集上训练了 RT-1,这些数据由 13 台机器人在 17 个月内收集完成。在广泛的实验中,我们证明了 RT-1 能够以 97% 的成功率执行超过 700 条指令,并在新任务、新物体和新环境中的泛化能力显著优于先前发布的基准方法。此外,我们还验证了 RT-1 能够成功融合来自仿真环境与其他机器人形态的异构数据,同时不牺牲原始任务的性能,并提升了对新场景的泛化能力。最后,我们展示了 RT-1 在 SayCan(Ahn 等人,2022)框架下成功执行多达 50 步的长程任务的能力。

尽管 RT-1 在基于数据吸收模型的大规模机器人学习领域迈出了重要一步,但它仍存在若干局限性。首先,RT-1 是一种模仿学习方法,因此继承了该类方法的固有挑战,例如可能无法超越演示者的性能水平。其次,其对新指令的泛化能力仅限于已有概念的组合,目前尚无法泛化至完全未见的全新动作。最后,我们的方法在大量但灵活性有限的操控任务上进行了验证。我们计划通过扩展 RT-1 能够支持与泛化的指令集,以应对这一挑战。

在探索未来研究方向时,我们希望通过开发允许非专家通过定向数据收集与模型提示(model prompting)训练机器人的方法,加速机器人技能的扩展。尽管当前版本的 RT-1 尤其在抗干扰物体方面表现稳健,但其对背景与环境的鲁棒性仍可通过大幅提升环境多样性进一步优化。此外,我们希望通过可扩展的注意力机制与记忆模块,提升 RT-1 的响应速度与上下文保持能力。

为促进研究社区基于本工作进一步发展,我们已开源了 RT-1 的代码[^4],期望为未来机器人学习扩展性研究提供有价值的资源。

683

683

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?