1、YOLO11

YOLO11是Ultralytics推出的新一代计算机视觉模型,为YOLO家族树立了新的里程碑。以下是对YOLO11的详细介绍:

1.1、主要特性与优势

无与伦比的速度和精度:YOLO11的设计旨在实现快速运行而不牺牲精度。其优化的模型架构提供了快速的推理时间,使其适用于自动驾驶、安全系统和工业自动化等实时应用。YOLO11在速度和准确性之间取得了平衡,满足了需要快速决策的场景需求。 高级物体检测功能:YOLO11在复杂环境中的物体检测能力得到了显著提升。它能够容忍遮挡并更好地区分重叠物体,这对于城市监控或事件监控等拥挤环境中的应用至关重要。 应用多功能性:YOLO11不仅擅长对象检测,还具备实例分割、姿势估计和跟踪等高级功能。这种多功能性使其可应用于从医疗保健到农业的各个领域,提供了广泛的适用性。 增强的设计和计算效率:YOLO11在YOLOv9和YOLOv10的基础上进行了扩展,集成了卓越的架构框架、精炼的特征提取方法和优化的训练协议。它使用更少的参数实现了更高的平均精度(mAP)得分,提高了计算效率。 高效的部署能力:YOLO11的处理能力极其高效,适合在云端和边缘设备上部署。它提供了灵活性,可适应各种计算机视觉挑战。

1.2、技术创新

增强的特征提取:YOLO11采用改进的主干网络和颈部架构,提高了特征提取能力,以实现更精确的目标检测和更复杂的任务性能。 优化效率和速度:YOLO11引入了精细的架构设计和优化的训练流程,提供了更快的处理速度,并在准确性和性能之间保持了最佳平衡。 参数更少,精度更高:凭借模型设计的进步,YOLO11m在COCO数据集上实现了更高的平均精度均值(mAP),同时使用的参数比YOLOv8m少22%,从而在不影响精度的前提下提高了计算效率。 跨环境适应性:YOLO11可以无缝部署在各种环境中,包括边缘设备、云平台和支持NVIDIA GPU的系统,确保了最大的灵活性。

1.3、应用领域

自动驾驶汽车:提高小目标和遮挡目标的检测能力,增强安全性和导航能力。 医疗保健:YOLO11的精确性有助于医学成像任务,如肿瘤检测,准确性至关重要。 零售和库存管理:跟踪客户行为,监控库存,并在零售环境中增强安全性。 监控:其速度和准确性使其适合实时监控和威胁检测。 机器人技术:YOLO11使机器人能够更好地导航环境并自主与目标互动。

综上所述,YOLO11以其出色的速度、精度、多功能性和计算效率,成为了Ultralytics迄今为止开发的最熟练的模型之一,为计算机视觉领域带来了新的突破。

(二)使用详情

1、应用服务

实例创建完成后,滑动下方滚动条,在实例右侧有应用服务按钮,点击打开界面。

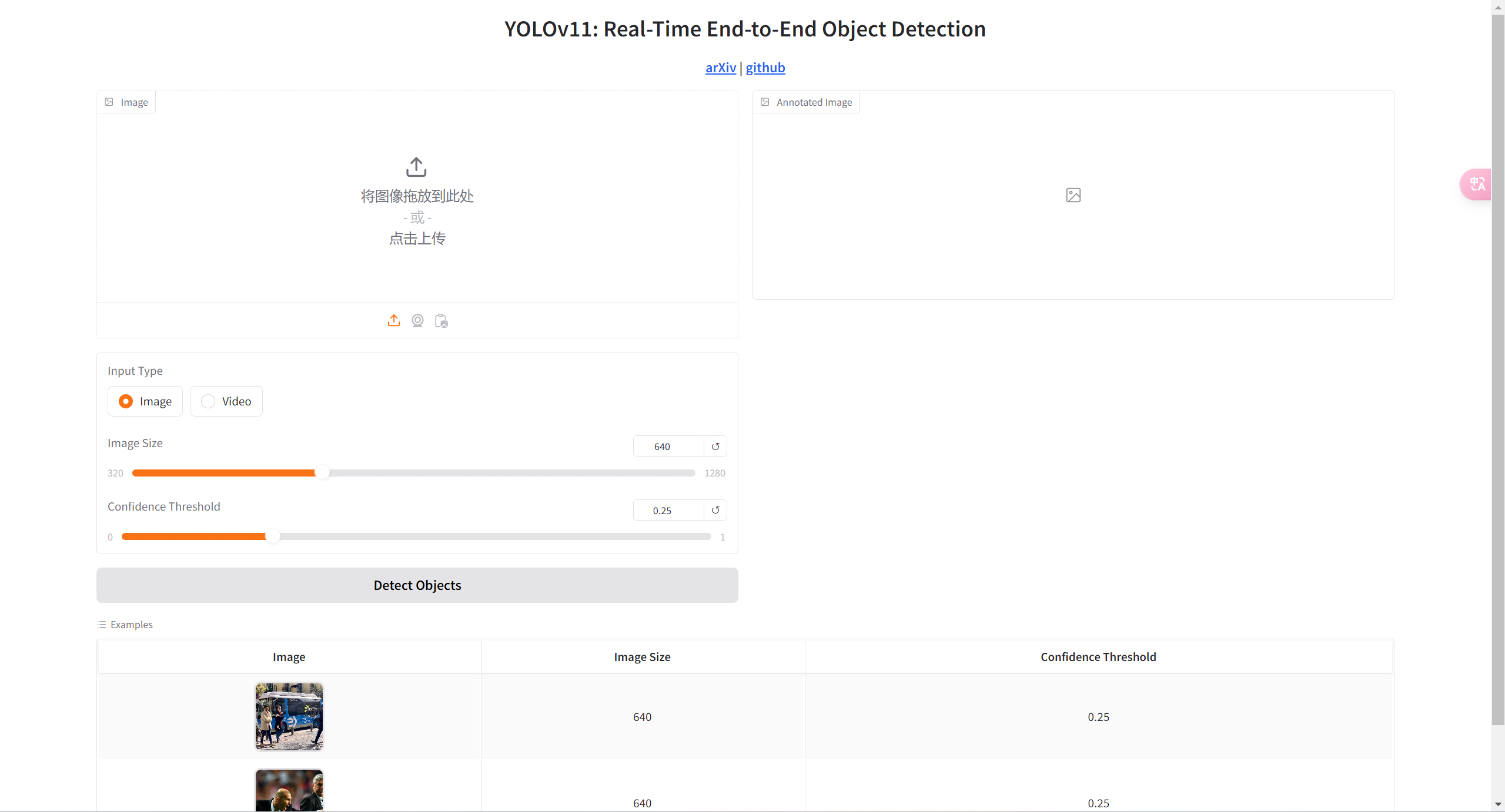

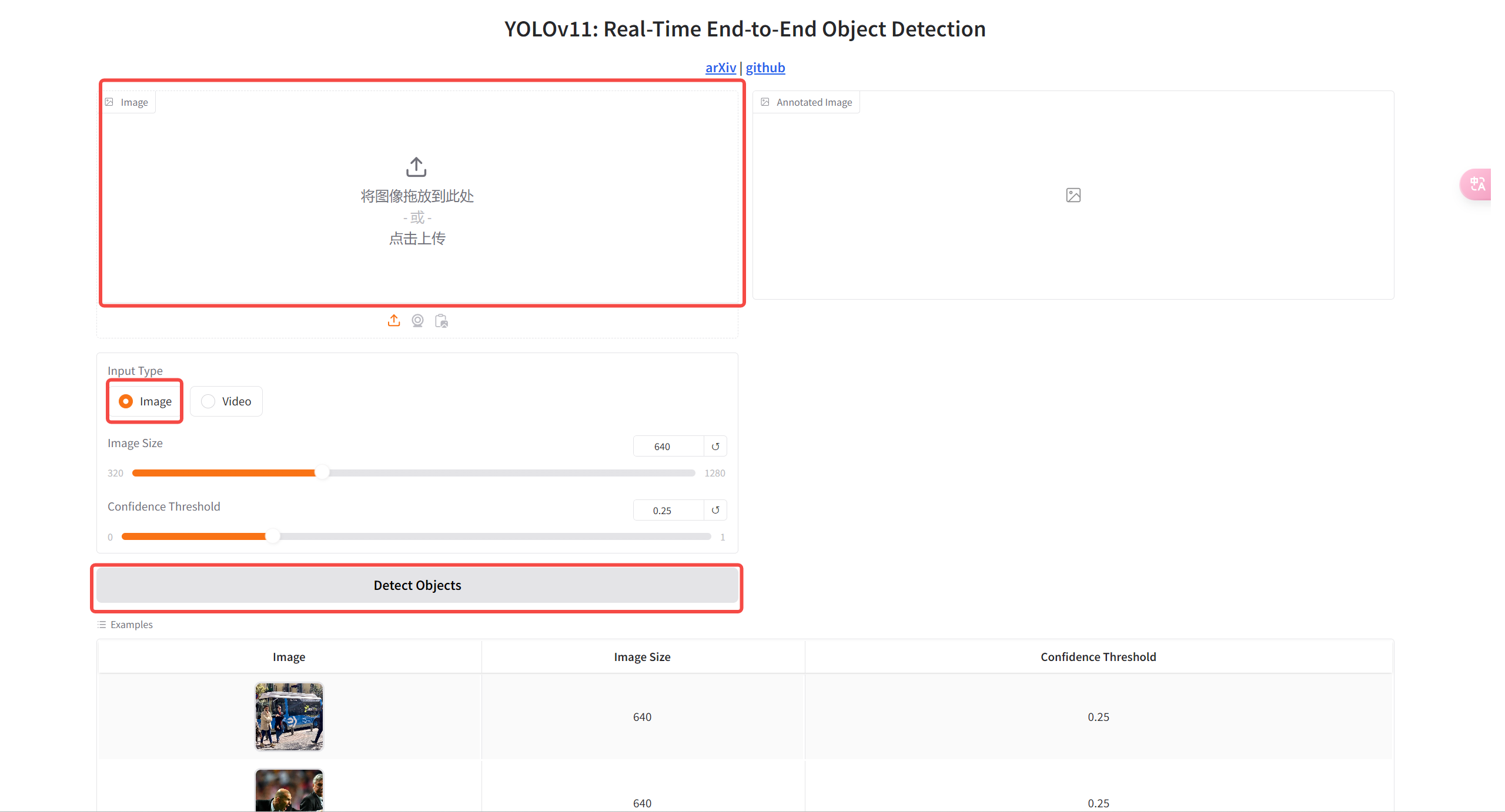

打开界面如图

选择照片或视频,并上传相关内容,调整参数,点击运行即可。

2、结果详情

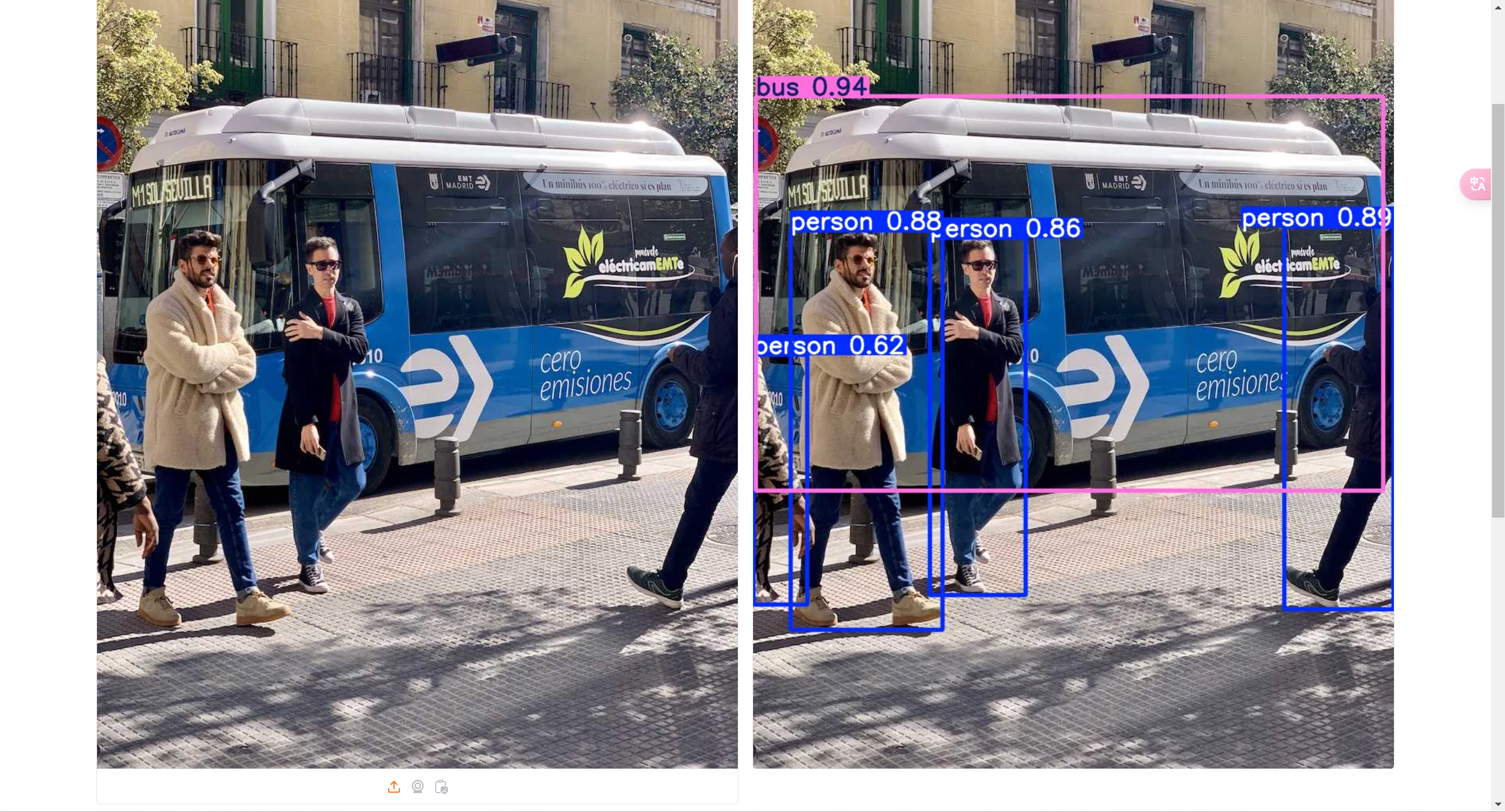

本次将使用下方示例进行演示

(三)模型训练

打开jupyterlab,修改并运行train_v11.py相关参数即可训练自己需要的模型,修改并运行test.py相关参数即可进行测试。

Pager

7957

7957

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?